Создание кластера Spark в HDInsight в AKS (предварительная версия)

Важно

Azure HDInsight в AKS больше не поддерживается с 31 января 2025 г. Узнайте больше с этим объявлением.

Необходимо перенести рабочие нагрузки в Microsoft Fabric или эквивалентный продукт Azure, чтобы избежать резкого завершения рабочих нагрузок.

Важный

Эта функция сейчас доступна в предварительной версии. Дополнительные условия использования для предварительных версий Microsoft Azure включают дополнительные юридические термины, применимые к функциям Azure, которые находятся в бета-версии, в предварительной версии или в противном случае еще не выпущены в общую доступность. Сведения об этой конкретной предварительной версии см. в Azure HDInsight в предварительной версии AKS. Для вопросов или предложений по функциям отправьте запрос на AskHDInsight с подробными сведениями и подписывайтесь на обновления в Azure HDInsight Community.

После выполнения требований подписки и требований ресурсов и развертывания пула кластеров, продолжайте использовать портал Azure для создания кластера Spark. Портал Azure можно использовать для создания кластера Apache Spark в пуле кластеров. Затем вы можете создать Jupyter Notebook и использовать его для запуска запросов Spark SQL к таблицам Apache Hive.

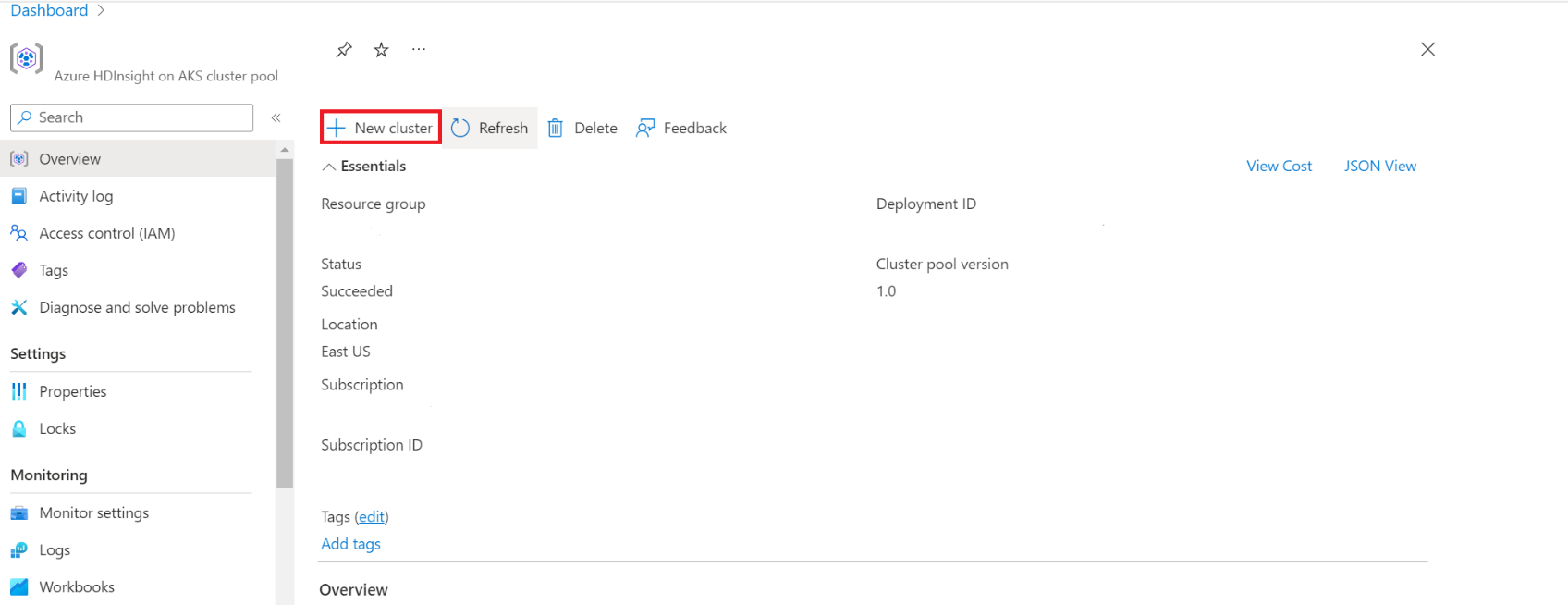

На портале Azure введите пулы кластеров и выберите пулы кластеров, чтобы перейти на страницу пулов кластера. На странице пулов кластеров выберите пул кластера, в котором можно добавить новый кластер Spark.

На странице определенного пула кластеров щелкните + Создать кластер.

На этом шаге откроется страница создания кластера.

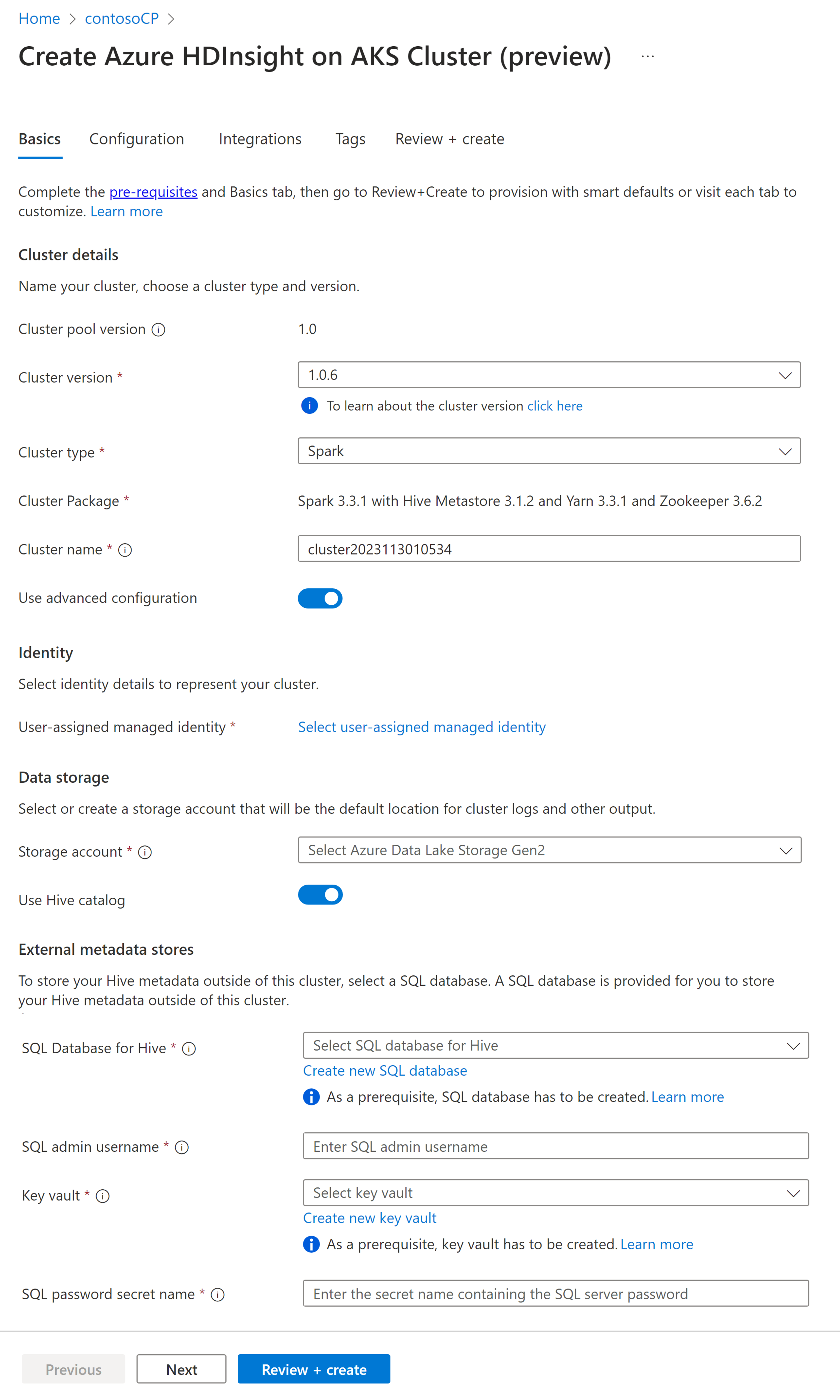

Свойство Описание Подписка Подписка Azure, зарегистрированная для использования с HDInsight на AKS, в разделе предварительных требований будет предзаполнена. Группа ресурсов Та же группа ресурсов, что и пул кластера, будет заполнена предварительно Область Тот же регион, что и пул кластера, и виртуальная структура будут заполнены заранее. Пул кластеров Имя пула кластера будет предварительно заполнено Версия пула HDInsight Версия пула кластера будет предварительно заполнена из выбора создания пула HDInsight в версии AKS Укажите HDI для версии AKS Тип кластера В раскрывающемся списке выберите Spark Версия кластера Выберите версию образа, используемую Имя кластера Введите имя нового кластера Выделенное пользователем управляемое удостоверение Выберите управляемую удостоверенность с пользовательским назначением, которая будет использоваться в качестве строки подключения к хранилищу. Учетная запись хранения Выберите предварительно созданную учетную запись хранения, которая будет использоваться в качестве основного хранилища для кластера. Имя контейнера Выберите имя контейнера (уникально) при предварительно созданном или создании нового контейнера Каталог Hive (необязательно) Выберите предварительно созданное хранилище метаданных Hive (база данных SQL Azure) База данных SQL для Hive В раскрывающемся списке выберите базу данных SQL для добавления таблиц из hive-метахранилища. Имя пользователя администратора SQL Введите имя администратора SQL Хранилище ключей В раскрывающемся списке выберите Key Vault, содержащий секрет с паролем для имени администратора SQL. Имя секрета пароля SQL Введите имя секрета из Key Vault, где хранится пароль базы данных SQL Заметка

- В настоящее время HDInsight поддерживает только базы данных MS SQL Server.

- Из-за ограничения Hive символ "-" (дефис) в имени базы данных хранилища метаданных не поддерживается.

Выберите Далее: Конфигурация и цены, чтобы продолжить.

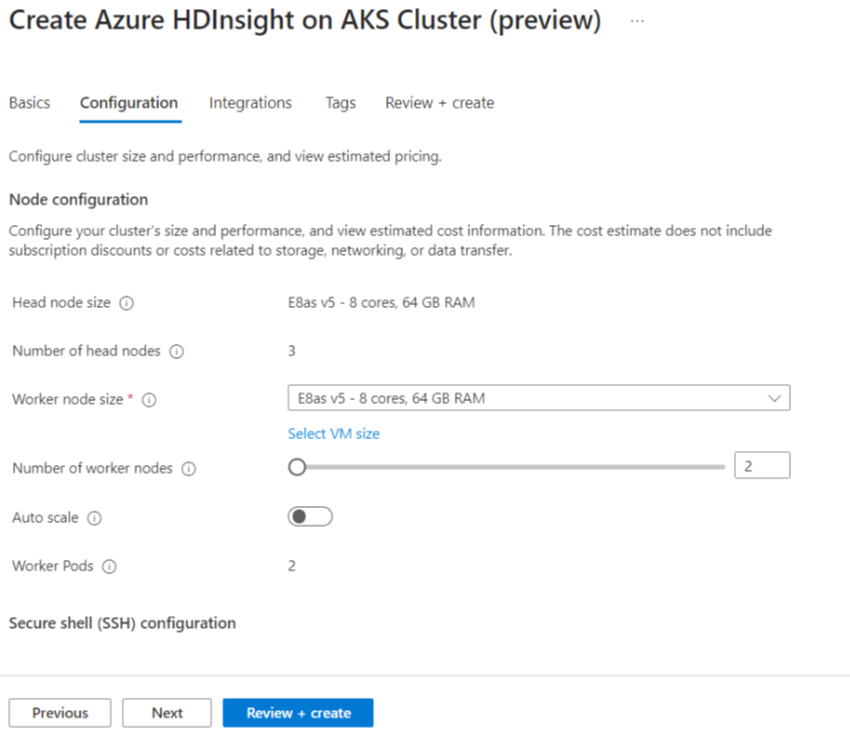

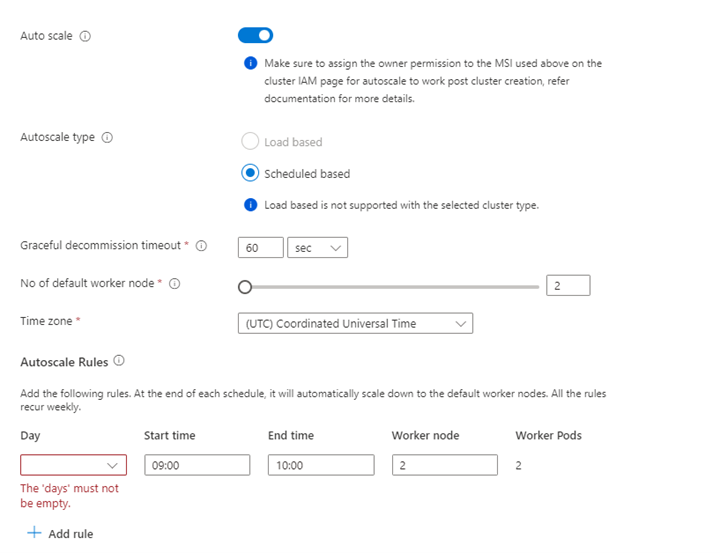

Имущество Описание Размер узла Выберите размер узла, который будет использоваться для узлов Spark Количество рабочих узлов Выберите количество узлов для кластера Spark. Из них три узла зарезервированы для координатора и системных служб, остальные узлы предназначены для рабочих Spark, по одному рабочему на узел. Например, в кластере с пятью узлами есть две рабочие роли. Автомасштабирование Нажмите кнопку переключателя, чтобы включить автомасштабирование Тип автомасштабирования Выберите автомасштабирование на основе нагрузки или расписания Время ожидания плавного вывода из эксплуатации Указание времени плавного завершения вывода из эксплуатации Количество рабочих узлов по умолчанию Выберите количество узлов для автомасштабирования Часовой пояс Выберите часовой пояс Правила автомасштабирования Выберите день, время начала, время окончания, количество рабочих узлов Включение SSH Если этот параметр включен, можно определить префикс и количество узлов SSH Нажмите Далее: Интеграции, чтобы включить и выбрать Log Analytics для журналирования.

Azure Prometheus для мониторинга и метрик можно включить после создания кластера.

Нажмите кнопку Далее: теги, чтобы продолжить переход на следующую страницу.

На странице теги введите все теги, которые вы хотите добавить в ресурс.

Свойство Описание Имя Необязательный. Введите имя, например HDInsight в программе закрытого предварительного доступа AKS, чтобы легко определить все ресурсы, связанные с вашими ресурсами. Ценность Оставьте это пустым Ресурс Выберите все выбранные ресурсы Нажмите кнопку Далее: обзор + создание.

На странице просмотр и создание страницынайдите сообщение об успешной проверке в верхней части страницы и нажмите кнопку Создать.

В процессе развертывания отображается страница, на которой создается кластер. Создание кластера занимает 5–10 минут. После создания кластера появляется сообщение Развертывание завершено. Если вы перейдете на другую страницу, вы можете проверить статус в Уведомлениях.

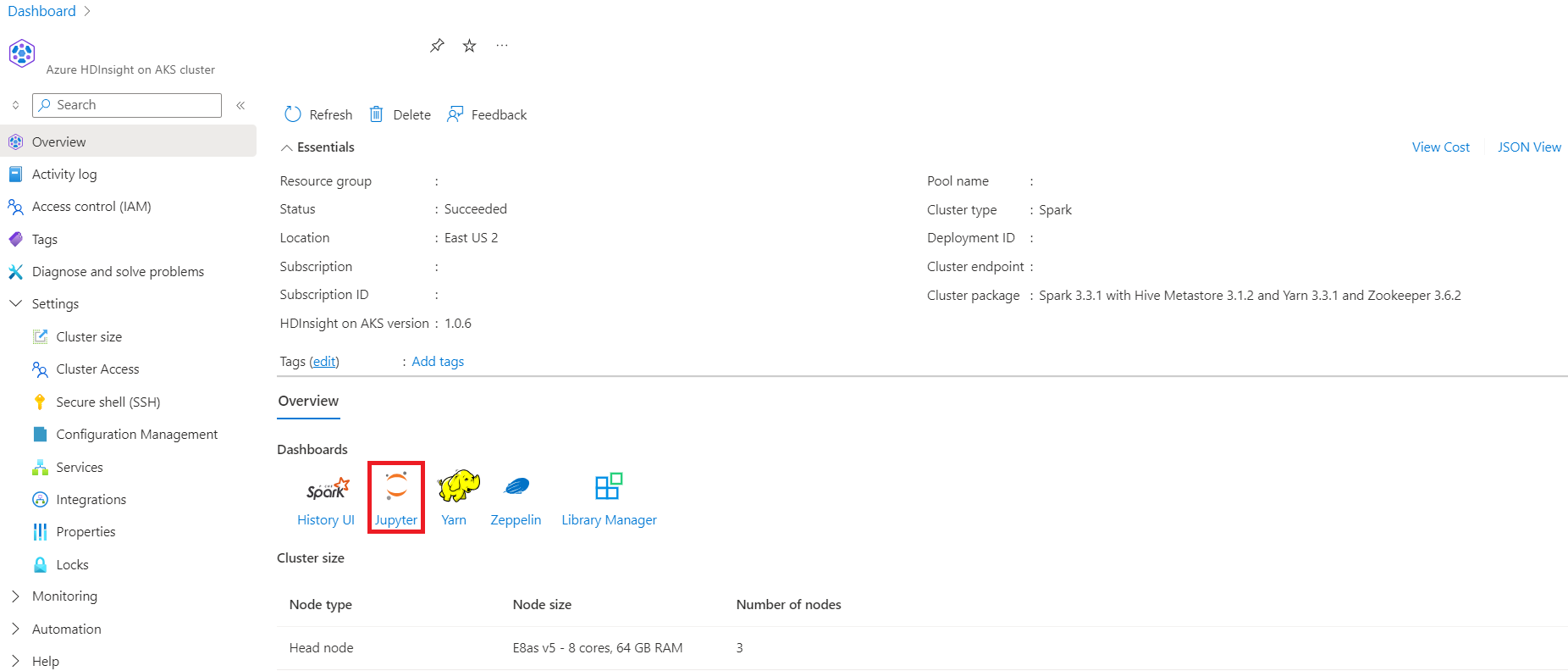

Перейдите на страницу обзора кластера , чтобы увидеть ссылки конечных точек.