Открытие средства LLM модели

Средство Open Model LLM позволяет использовать различные открытые модели и базовые модели, такие как Falcon и Llama 2, для обработки естественного языка в Машинное обучение Azure потоке запросов.

Внимание

Уведомление об отключении: средство Open Model LLM устарело в пользу средства LLM, которое обеспечивает поддержку всех моделей, поддерживаемых API вывода модели ИИ Azure, и, следовательно, она обеспечивает большую гибкость.

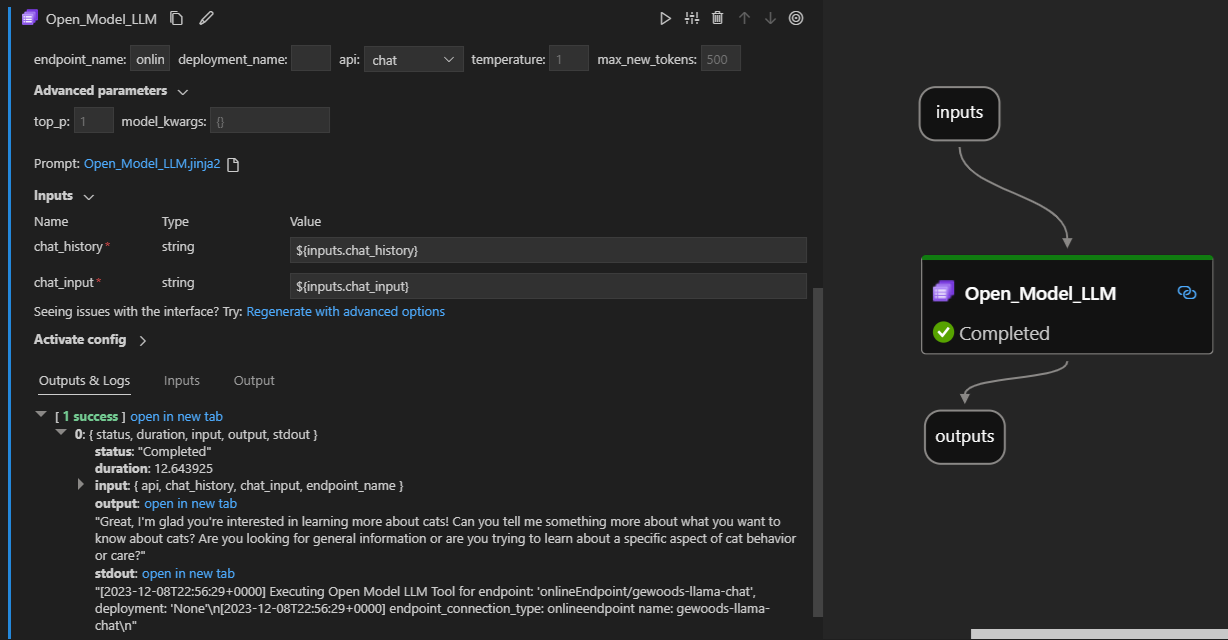

Вот как он выглядит в действии в расширении потока запроса Visual Studio Code. В этом примере средство используется для вызова конечной точки чата LlaMa-2 и запроса "Что такое CI?".

Это средство потока запросов поддерживает два разных типа API LLM:

- Чат: показан в предыдущем примере. Тип API чата упрощает интерактивные беседы с текстовыми входными и ответами.

- Завершение. Тип API завершения используется для создания завершения текста одного ответа на основе предоставленных входных данных запроса.

Краткий обзор: Разделы справки использовать средство Open Model LLM?

- Выберите модель из каталога моделей Машинное обучение Azure и получите ее развертывание.

- Подключитесь к развертыванию модели.

- Настройте параметры средства llm открытой модели.

- Подготовьте запрос.

- Запуск потока.

Предварительные требования: развертывание модели

- Выберите модель, соответствующую вашему сценарию, из каталога моделей Машинное обучение Azure.

- Нажмите кнопку "Развернуть", чтобы развернуть модель в Машинное обучение Azure конечной точке вывода через Интернет.

- Используйте один из вариантов развертывания с оплатой.

Дополнительные сведения см. в статье "Развертывание базовых моделей в конечных точках для вывода".

Предварительные требования. Подключение к модели

Чтобы поток запросов использовал развернутую модель, необходимо подключиться к ней. Существует два способа подключения.

Подключения конечной точки

Когда поток связан с рабочей областью Машинное обучение Azure или Azure AI Studio, средство Open Model LLM может использовать конечные точки в этой рабочей области.

Использование Машинное обучение Azure или рабочих областей Azure AI Studio: если вы используете поток запросов в одной из рабочих областей браузеров на основе веб-страниц, сетевые конечные точки, доступные в этой рабочей области автоматически.

Сначала используйте VS Code или код: если вы используете поток запросов в VS Code или одно из предложений Code First, необходимо подключиться к рабочей области. Средство Open Model LLM использует клиент azure.identity DefaultAzureCredential для авторизации. Одним из способов является установка значений учетных данных среды.

Пользовательские подключения

Средство Open Model LLM использует CustomConnection. Поток запросов поддерживает два типа подключений:

Подключения к рабочей области — подключения, хранящиеся в виде секретов в рабочей области Машинное обучение Azure. Хотя эти подключения можно использовать во многих местах, часто создаются и поддерживаются в пользовательском интерфейсе Studio. Сведения о создании настраиваемого подключения в пользовательском интерфейсе Studio см . в статье о создании настраиваемого подключения.

Локальные подключения — подключения , которые хранятся локально на компьютере. Эти подключения недоступны в пользовательском интерфейсе Studio, но можно использовать с расширением VS Code. Чтобы узнать, как создать локальное настраиваемое подключение, см . инструкции по созданию локального подключения.

Обязательные ключи для задания:

- endpoint_url

- Это значение можно найти в ранее созданной конечной точке вывода.

- endpoint_api_key

- Убедитесь, что он является секретным значением.

- Это значение можно найти в ранее созданной конечной точке вывода.

- model_family

- Поддерживаемые значения: LLAMA, DOLLY, GPT2 или FALCON

- Это значение зависит от типа целевого развертывания.

Запуск средства: входные данные

Средство Open Model LLM имеет множество параметров, некоторые из которых являются обязательными. Дополнительные сведения см. в следующей таблице. Эти параметры можно сопоставить с приведенным выше снимок экрана для наглядности.

| Имя. | Тип | Описание | Обязательное поле |

|---|---|---|---|

| api | строка | Режим API, который зависит от используемой модели и выбранного сценария. Поддерживаемые значения: (Завершение | Чат) | Да |

| endpoint_name | строка | Имя конечной точки вывода в Сети с поддерживаемой моделью, развернутой на ней. Принимает приоритет над подключением. | Да |

| Температура | с плавающей запятой | Случайность созданного текста. По умолчанию 1. | No |

| max_new_tokens | integer | Максимальное количество маркеров, которые необходимо создать в завершении. Значение по умолчанию — 500. | No |

| top_p | с плавающей запятой | Вероятность использования верхнего выбора из созданных токенов. По умолчанию 1. | No |

| model_kwargs | dictionary | Эти входные данные используются для предоставления конфигурации для используемой модели. Например, модель Llama-02 может использовать {"temperature":0.4}. По умолчанию: {} | No |

| deployment_name | строка | Имя развертывания для целевого объекта в конечной точке вывода в Сети. Если значение не передается, используются параметры трафика подсистемы балансировки нагрузки вывода. | No |

| prompt | строка | Текстовый запрос, который используется языковой моделью для создания ответа. | Да |

Выходные данные

| API | Тип возвращаемых данных | Description |

|---|---|---|

| Completion | строка | Текст одного прогнозируемого завершения |

| Чат | строка | Текст одного ответа в беседе |

Развертывание в сетевой конечной точке

При развертывании потока, содержащего средство Open Model LLM, в конечную точку в сети, есть дополнительный шаг для настройки разрешений. Во время развертывания на веб-страницах можно выбрать типы удостоверений, назначенных системой и назначаемых пользователем. В любом случае, используя портал Azure (или аналогичную функциональность), добавьте роль задания "Читатель" в удостоверение в рабочей области Машинное обучение Azure или проекте Ai Studio, где размещается конечная точка. Возможно, потребуется обновить развертывание потока запроса.