Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

В этой статье описывается, как с помощью редактора кода легко создать задание Stream Analytics, которое непрерывно считывает данные из экземпляра Центров событий (концентратора событий), преобразует данные и записывает результаты в базу данных SQL Azure.

Необходимые компоненты

Ресурсы Центры событий Azure и База данных SQL Azure должны быть общедоступными и не защищены брандмауэром или защищены в виртуальная сеть Azure. Данные в Центрах событий должны быть сериализованы в формате JSON, CSV или Avro.

Если вы хотите выполнить действия, описанные в этой статье, выполните следующие действия.

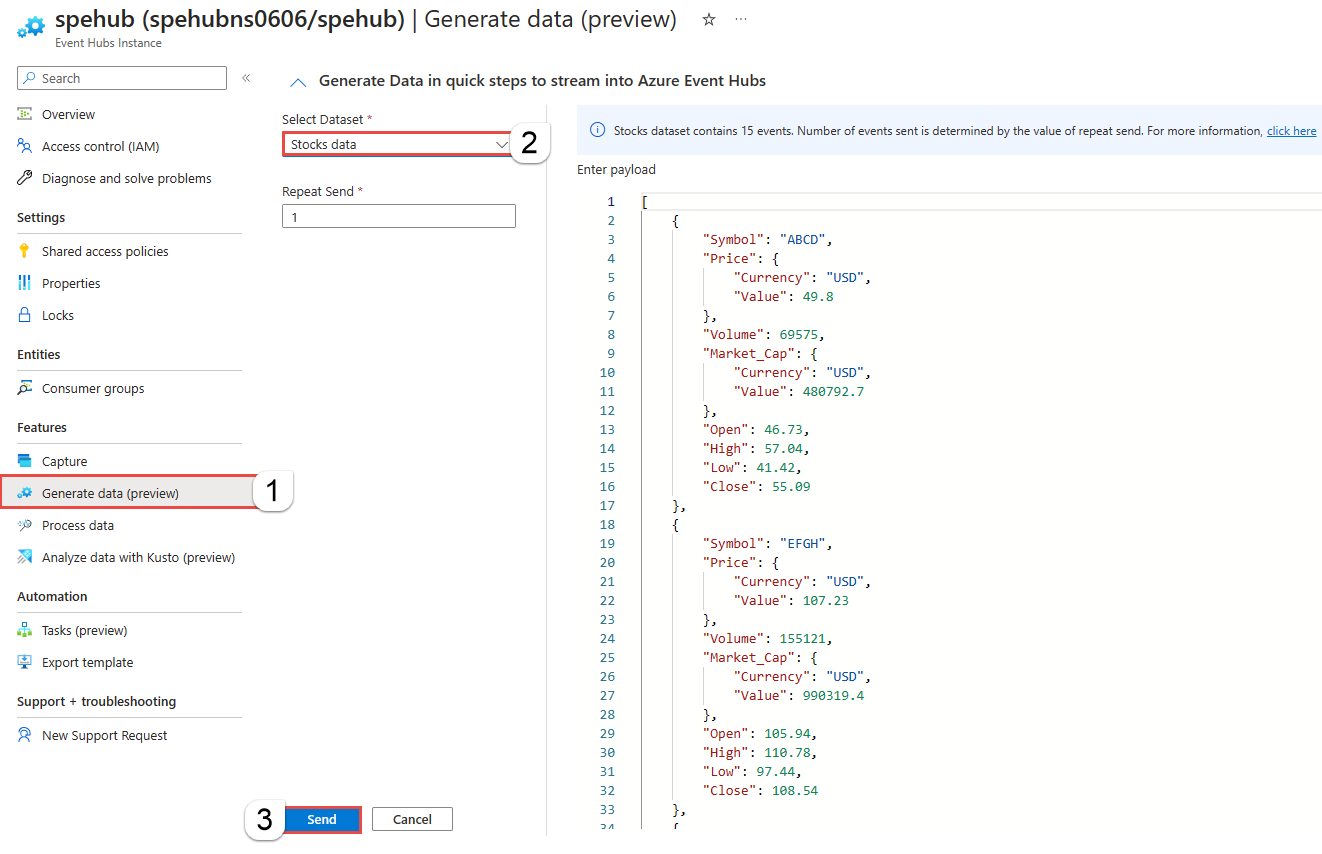

Создайте концентратор событий, если у вас еще нет. Создайте данные в концентраторе событий. На странице "Экземпляр центров событий" выберите "Создать данные (предварительная версия) в меню слева, выберите "Запас данных" для набора данных и нажмите кнопку "Отправить", чтобы отправить некоторые примеры данных в концентратор событий. Этот шаг необходим, если вы хотите протестировать шаги в этой статье.

Создайте базу данных SQL Azure. Ниже приведены несколько важных моментов, которые необходимо отметить при создании базы данных.

На странице "Основы" выберите "Создать" для сервера. Затем на странице "Создание База данных SQL сервера" выберите "Использовать проверку подлинности SQL" и укажите идентификатор пользователя и пароль администратора.

На странице "Сеть" выполните следующие действия.

- Включите общедоступную конечную точку.

- Выберите значение Да для параметра Разрешить доступ к серверу службам и ресурсам Azure.

- Выберите "Да " для добавления текущего IP-адреса клиента.

На странице "Дополнительные параметры" выберите "Нет" для использования существующих данных.

В статье пропустить шаги в разделе "Запрос базы данных " и "Очистка ресурсов ".

Если вы хотите протестировать шаги, создайте таблицу в базе данных SQL с помощью редактора запросов (предварительная версия).

create table stocks ( symbol varchar(4), price decimal )

Создание задания Stream Analytics с помощью редактора кода без кода

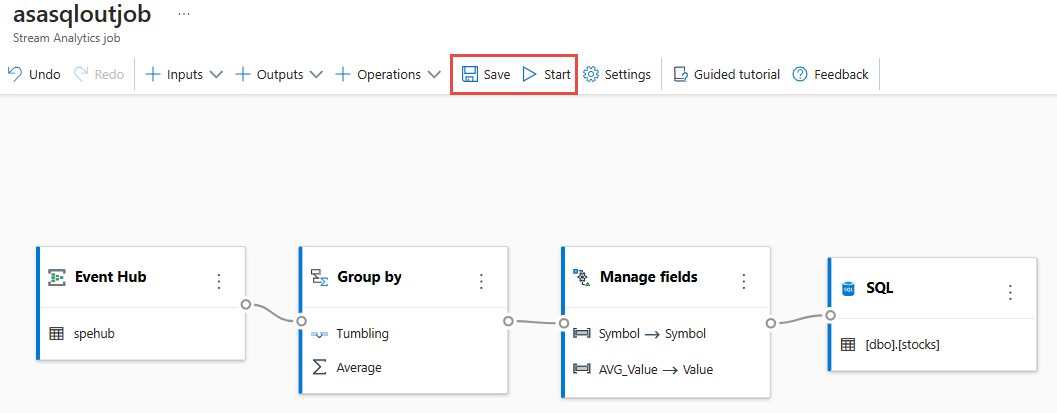

В этом разделе описано, как создать задание Azure Stream Analytics с помощью редактора без кода. Задание преобразует потоковую передачу данных из экземпляра Центров событий (концентратора событий) и сохраняет данные результатов в базе данных SQL Azure.

В портал Azure перейдите на страницу экземпляра Центров событий для концентратора событий.

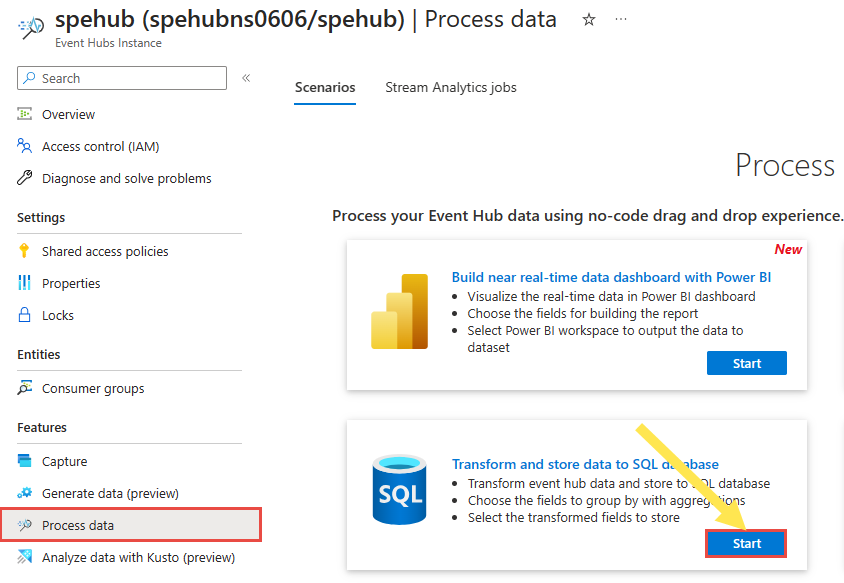

Выберите "Данные обработки компонентов>" в меню слева, а затем нажмите кнопку "Пуск" на карте "Преобразование" и хранение данных в карточке базы данных SQL.

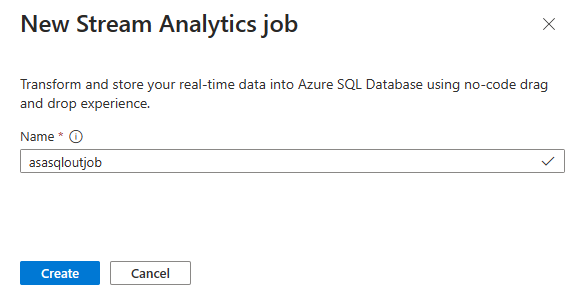

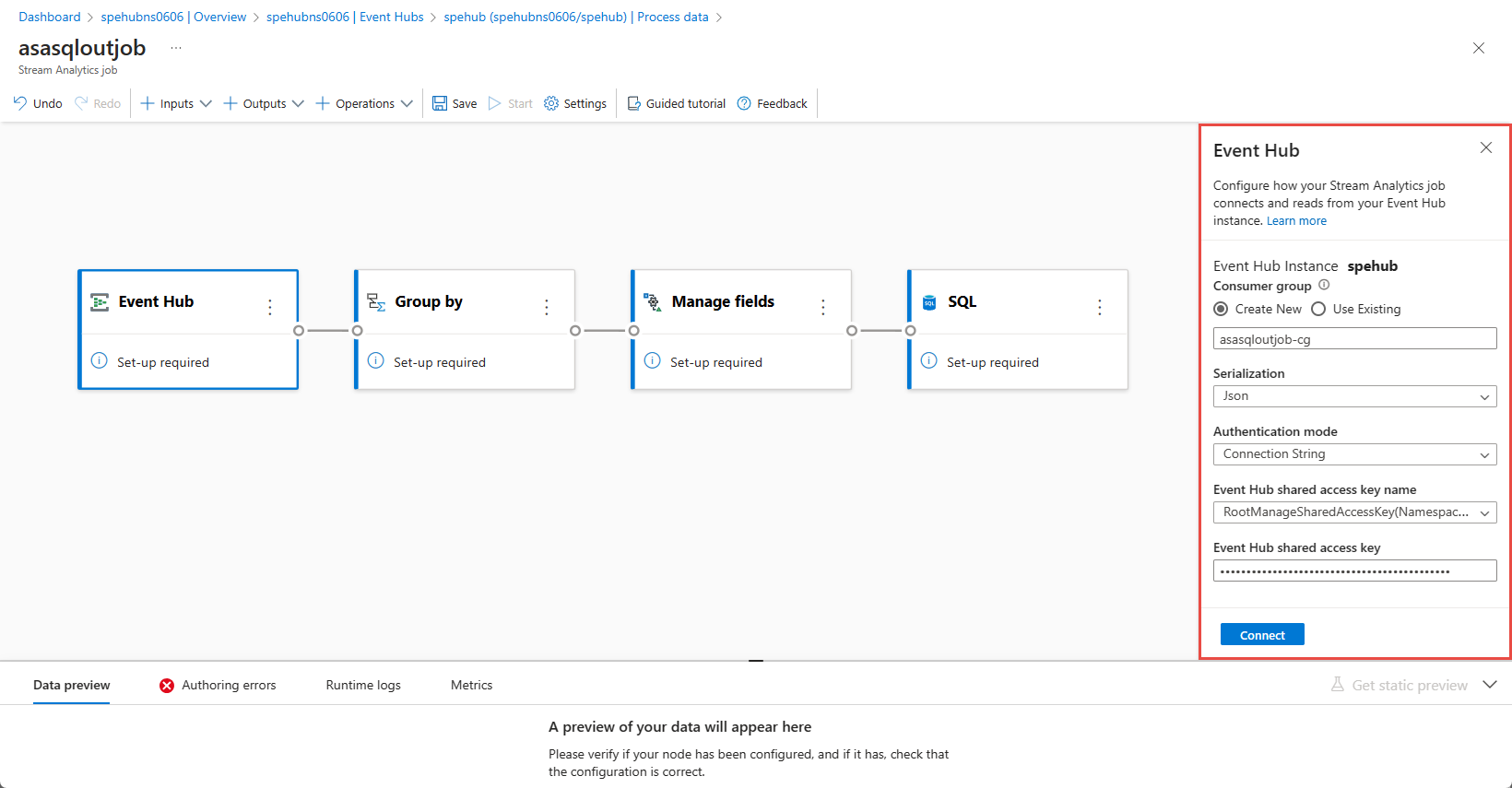

Введите имя задания Stream Analytics и нажмите кнопку Создать. Вы увидите схему заданий Stream Analytics с окном Центров событий справа.

В окне концентратора событий просмотрите параметры режима сериализации и проверки подлинности и выберите "Подключить".

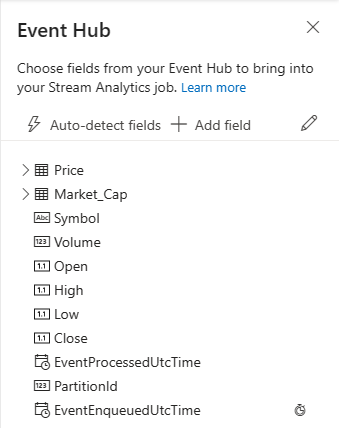

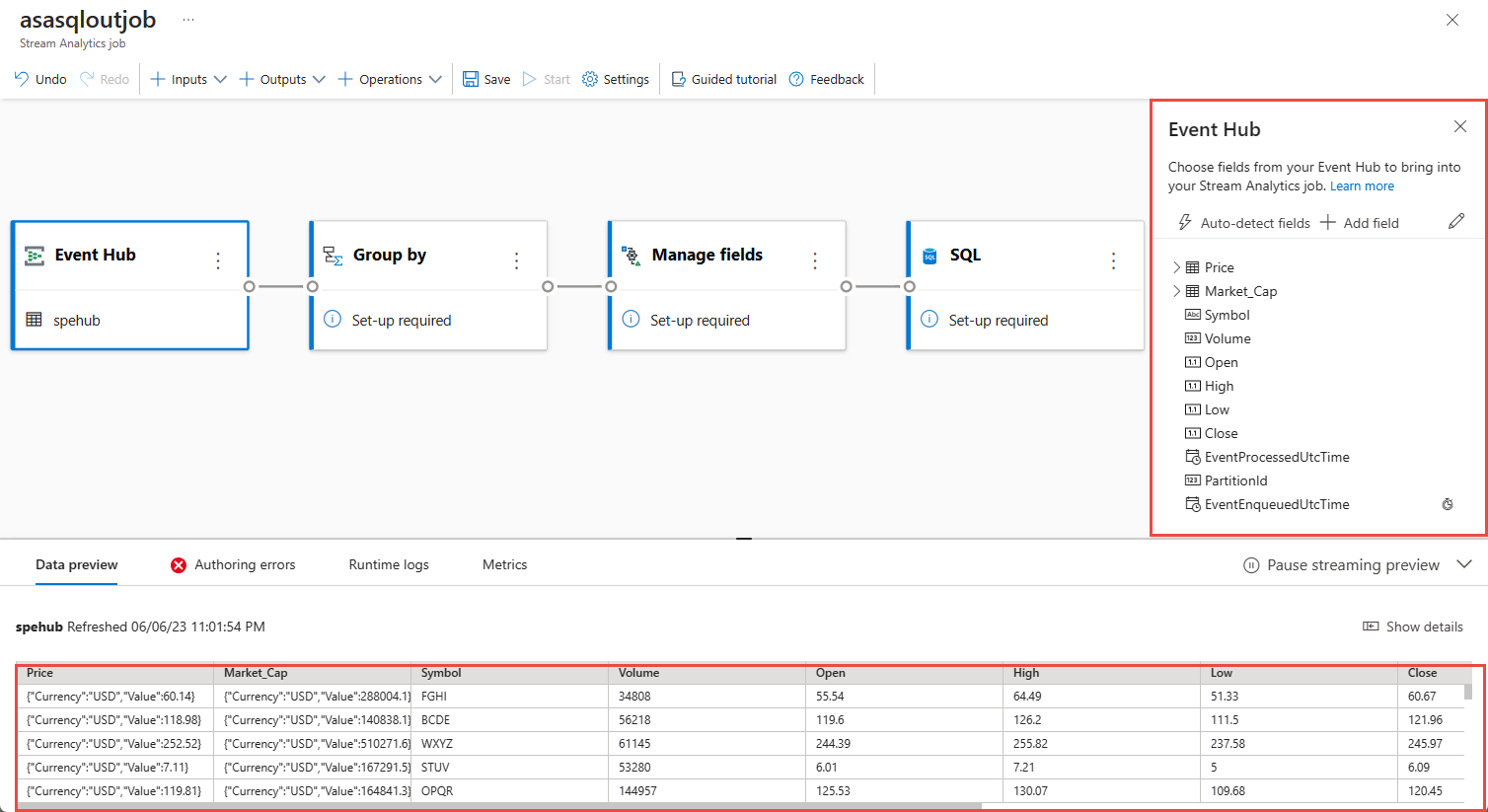

Когда подключение установлено успешно, и у вас есть данные в экземпляре Центров событий, вы увидите две вещи:

Наличие полей в входных данных. Вы можете нажать кнопку Добавить поле или выбрать символ с тремя точками рядом с каждым полем, чтобы удалить, переименовать его или изменить его тип.

Динамический пример входящих данных в таблице Предварительный просмотр данных в представлении диаграммы. Она автоматически периодически обновляется. Вы можете выбрать Приостановить предварительный просмотр потоковой передачи, чтобы просмотреть статическое представление примера входных данных.

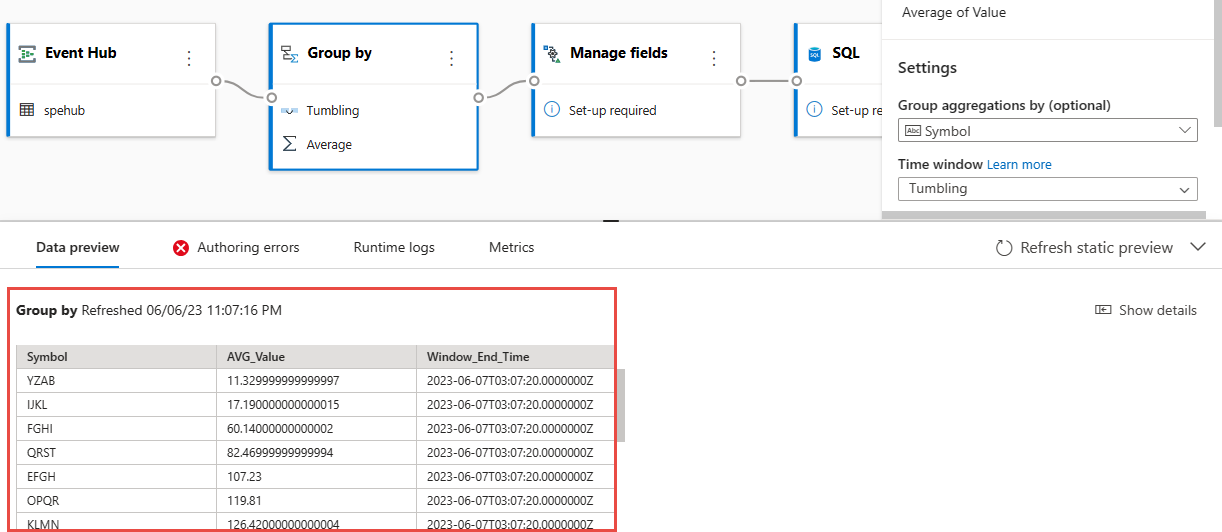

Выберите группу по плитке, чтобы агрегировать данные. На панели конфигурации "Группа по группе" можно указать поле, которое нужно сгруппировать по окну времени.

В следующем примере используется среднее значение цены и символа.

Результаты шага можно проверить в разделе предварительного просмотра данных.

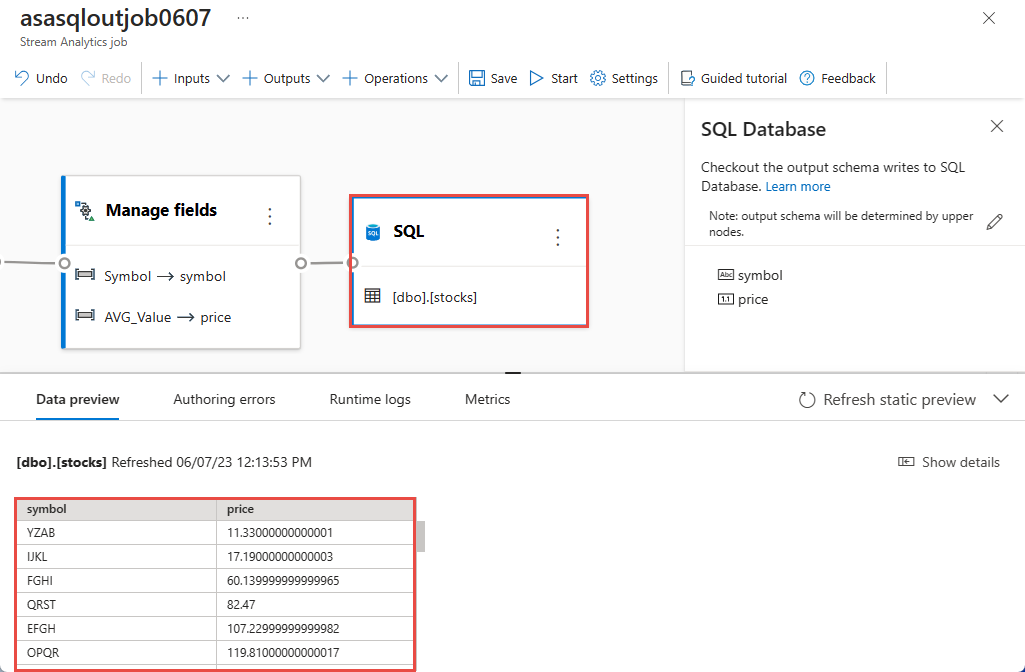

Выберите плитку "Управление полями ". На панели конфигурации "Управление полями" выберите поля, которые нужно вывести, выбрав "Добавить поле ->Импортированная схема" —> поле.

Если вы хотите добавить все поля, выберите "Добавить все поля". При добавлении поля можно указать другое имя выходных данных. Например,

AVG_ValueвValue. После сохранения выбранных элементов на панели предварительного просмотра данных отображаются данные.В следующем примере выбраны символы и AVG_Value . Символ сопоставляется с символом, и AVG_Value сопоставляется с ценой.

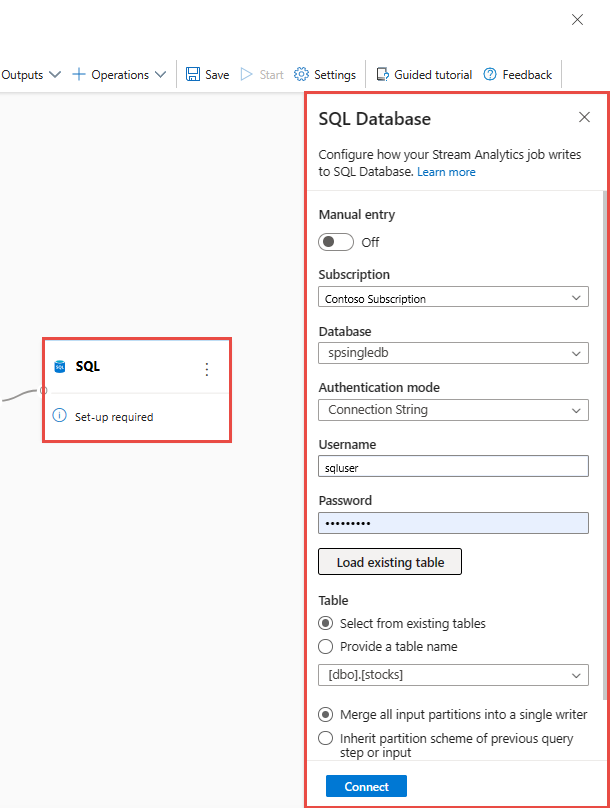

Выберите плитку SQL . На панели конфигурации База данных SQL заполните необходимые параметры и подключитесь. Выберите " Загрузить существующую таблицу" для автоматического выбора таблицы . В следующем примере

[dbo].[stocks]выбран вариант. Затем щелкните Connect (Подключиться).Примечание.

Схема таблицы, выбранной для записи, должна точно соответствовать количеству полей и их типам, создаваемым предварительным просмотром данных.

В области предварительного просмотра данных отображается предварительная версия данных, которая выполняется в базе данных SQL.

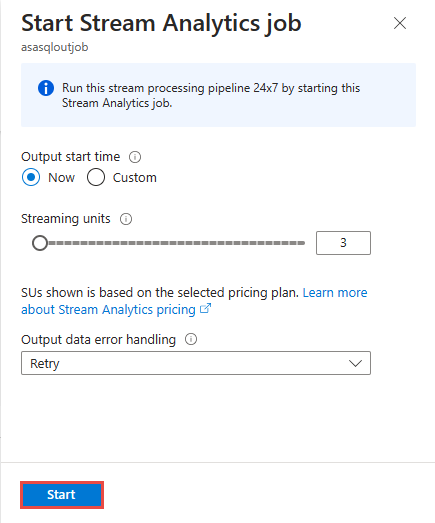

Нажмите кнопку Сохранить, а затем выберите Запустить для задания Stream Analytics.

Чтобы запустить задание, укажите следующее.

Число единиц потоковой передачи, с которыми выполняется задание. Единицы потоковой передачи представляют объем вычислительных ресурсов и памяти, выделенных для задания. Мы рекомендуем начать с трех единиц, а затем при необходимости изменить это значение.

Обработка ошибок выходных данных — позволяет указать нужное поведение, если вывод задания в место назначения завершатся сбоем из-за ошибок данных. По умолчанию задание повторяется до тех пор, пока операция записи не будет выполнена. Вы также можете удалять такие выходные события.

Задание запустится в течение двух минут после нажатия кнопки Запустить. Откроется панель метрик в нижней области. Для обновления этой панели требуется некоторое время. Нажмите кнопку "Обновить" в правом верхнем углу панели, чтобы обновить диаграмму. Перейдите к следующему шагу на отдельной вкладке или окне веб-браузера.

Вы также можете просмотреть задание в разделе "Данные процесса" на вкладке "Задания Stream Analytics". Выберите "Открыть метрики ", чтобы отслеживать или останавливать и перезапустить его по мере необходимости.

Перейдите к концентратору событий на портале в отдельном окне браузера или на вкладке, а затем снова отправьте образец данных акций (как и в предварительных требованиях). На странице "Экземпляр центров событий" выберите "Создать данные (предварительная версия) в меню слева, выберите "Запас данных" для набора данных и нажмите кнопку "Отправить", чтобы отправить некоторые примеры данных в концентратор событий. Это займет несколько минут, чтобы просмотреть обновленную панель метрик .

Записи, вставляемые в базу данных SQL Azure, должны отображаться.

Рекомендации при использовании функции георепликации Центров событий

Центры событий Azure недавно запустили Функция георепликации в общедоступной предварительной версии. Эта функция отличается от функции географического аварийного восстановления Центры событий Azure.

Если тип отработки отказа является принудительной и согласованность репликации является асинхронной, задание Stream Analytics не гарантирует точно один раз выходных данных в Центры событий Azure выходных данных.

Azure Stream Analytics в качестве производителя с выходными данными концентратора событий может наблюдать задержку водяного знака в задании во время отработки отказа и во время регулирования центрами событий в случае задержки репликации между основными и вторичными компонентами достигает максимально настроенной задержки.

Azure Stream Analytics, как потребитель с Центрами событий в качестве входных данных, может наблюдать задержку водяного знака в задании во время отработки отказа и может пропустить данные или найти дублирующиеся данные после завершения отработки отказа.

Из-за этих предостережения рекомендуется перезапустить задание Stream Analytics с соответствующим временем начала сразу после завершения отработки отказа Центров событий. Кроме того, так как функция георепликации Центров событий находится в общедоступной предварительной версии, мы не рекомендуем использовать этот шаблон для рабочих заданий Stream Analytics на данный момент. Текущее поведение Stream Analytics улучшится, прежде чем функция георепликации Центров событий общедоступна и может использоваться в рабочих заданиях Stream Analytics.

Следующие шаги

Узнайте больше об Azure Stream Analytics и о том, как выполнять мониторинг созданного задания.