Руководство. Создание приложений машинного обучения с помощью Машинного обучения Synapse

В этой статье показано, как использовать Машинное обучение Synapse (SynapseML) для создания приложений машинного обучения. SynapseML расширяет решение распределенного машинного обучения Apache Spark, добавляя множество средств глубокого обучения и обработки и анализа данных, таких как службы ИИ Azure, OpenCV, LightGBM и многое другое. SynapseML позволяет создавать мощные и масштабируемые прогнозные и аналитические модели на основе разных источников данных Spark. Synapse Spark предоставляет встроенные библиотеки SynapseML, в том числе:

- Vowpal Wabbit — службы библиотек для машинного обучения, которые позволяют использовать возможности Анализа текста, например анализ тональности в твитах.

- MMLSpark: объединение экосистем машинного обучения в массовых масштабах — объединение функций служб ИИ Azure в конвейерах SparkML для создания решений для служб моделирования когнитивных данных, таких как обнаружение аномалий.

- LightGBM — платформа градиентного усиления, которая использует три базовых алгоритма обучения. Она предназначена для распределения и повышения эффективности.

- Условные модели KNN — масштабируемые модели KNN с условными запросами.

- HTTP в Spark — оркестрация распределенных микрослужб при интеграции Spark и специальных возможностей на основе протокола HTTP.

В этом руководстве рассматриваются примеры использования служб ИИ Azure в SynapseML для

- Анализ текста — получение сведений о тональности (или настроении) набора предложений;

- Компьютерное зрение — получение тегов (описание с использованием одного слова), связанных с набором изображений;

- Поиск изображений Bing — поиск в Интернете изображений, соответствующих запросу на естественном языке;

- Детектор аномалий — обнаружение аномалий в данных временных рядов.

Если у вас еще нет подписки Azure, создайте бесплатную учетную запись, прежде чем начинать работу.

Предварительные требования

- Рабочая область Azure Synapse Analytics с учетной записью хранения Azure Data Lake Storage 2-го поколения, настроенной в качестве хранилища по умолчанию. При работе с файловой системой Data Lake Storage 2-го поколения вам нужно иметь права участника для получения данных Хранилища BLOB-объектов.

- Пул Spark в рабочей области Azure Synapse Analytics. Дополнительные сведения см. в статье Создание пула Spark в Azure Synapse.

- Действия по предварительной настройке, описанные в руководстве Настройка служб ИИ Azure в Azure Synapse.

Начало работы

Чтобы начать работу, импортируйте SynapseML и настройте ключи служб.

import synapse.ml

from synapse.ml.cognitive import *

from notebookutils import mssparkutils

# An Azure AI services multi-service resource key for Text Analytics and Computer Vision (or use separate keys that belong to each service)

ai_service_key = mssparkutils.credentials.getSecret("ADD_YOUR_KEY_VAULT_NAME", "ADD_YOUR_SERVICE_KEY","ADD_YOUR_KEY_VAULT_LINKED_SERVICE_NAME")

# A Bing Search v7 subscription key

bingsearch_service_key = mssparkutils.credentials.getSecret("ADD_YOUR_KEY_VAULT_NAME", "ADD_YOUR_BING_SEARCH_KEY","ADD_YOUR_KEY_VAULT_LINKED_SERVICE_NAME")

# An Anomaly Dectector subscription key

anomalydetector_key = mssparkutils.credentials.getSecret("ADD_YOUR_KEY_VAULT_NAME", "ADD_YOUR_ANOMALY_KEY","ADD_YOUR_KEY_VAULT_LINKED_SERVICE_NAME")

Пример для Анализа текста

Служба Анализ текста предоставляет несколько алгоритмов для извлечения интеллектуальной аналитики из текста. Например, можно определить тональность заданного входного текста. Служба вернет оценку между 0,0 и 1,0: низкий показатель указывает на отрицательную тональность, а высокий — на положительную. В этом примере используются три простых предложения. Для каждого из них возвращается тональность.

from pyspark.sql.functions import col

# Create a dataframe that's tied to it's column names

df_sentences = spark.createDataFrame([

("I am so happy today, its sunny!", "en-US"),

("this is a dog", "en-US"),

("I am frustrated by this rush hour traffic!", "en-US")

], ["text", "language"])

# Run the Text Analytics service with options

sentiment = (TextSentiment()

.setTextCol("text")

.setLocation("eastasia") # Set the location of your Azure AI services resource

.setSubscriptionKey(ai_service_key)

.setOutputCol("sentiment")

.setErrorCol("error")

.setLanguageCol("language"))

# Show the results of your text query in a table format

display(sentiment.transform(df_sentences).select("text", col("sentiment")[0].getItem("sentiment").alias("sentiment")))

Ожидаемые результаты

| text | Тональность |

|---|---|

| I am frustrated by this rush hour traffic! (Меня раздражает дорожное движение в час пик!) | негативная тональность |

| this is a dog (это собака) | нейтральная тональность |

| I am so happy today, its sunny! | позитивная тональность |

Пример для Компьютерного зрения

Служба Компьютерное зрение анализирует изображения для выявления таких структур, как лица, объекты и описания на естественном языке. В этом примере мы помечаем следующее изображение. Теги — это описания вещей, выраженные одним словом, например распознаваемых объектов, людей, пейзажей и действий.

# Create a dataframe with the image URL

df_images = spark.createDataFrame([

("https://raw.githubusercontent.com/Azure-Samples/cognitive-services-sample-data-files/master/ComputerVision/Images/objects.jpg", )

], ["image", ])

# Run the Computer Vision service. Analyze Image extracts information from/about the images.

analysis = (AnalyzeImage()

.setLocation("eastasia") # Set the location of your Azure AI services resource

.setSubscriptionKey(ai_service_key)

.setVisualFeatures(["Categories","Color","Description","Faces","Objects","Tags"])

.setOutputCol("analysis_results")

.setImageUrlCol("image")

.setErrorCol("error"))

# Show the results of what you wanted to pull out of the images.

display(analysis.transform(df_images).select("image", "analysis_results.description.tags"))

Ожидаемые результаты

| Изображение | tags |

|---|---|

https://raw.githubusercontent.com/Azure-Samples/cognitive-services-sample-data-files/master/ComputerVision/Images/objects.jpg |

[skating, person, man, outdoor, riding, sport, skateboard, young, board, shirt, air, park, boy, side, jumping, ramp, trick, doing, flying] |

Пример для Поиска изображений Bing

Поиск изображений Bing — поиск в Интернете изображений, соответствующих запросу пользователя на естественном языке. В этом примере мы используем текстовый запрос для поиска изображений с кавычками. Он возвращает список URL-адресов изображений, содержащих фотографии, связанные с нашим запросом.

from pyspark.ml import PipelineModel

# Number of images Bing will return per query

imgsPerBatch = 2

# A list of offsets, used to page into the search results

offsets = [(i*imgsPerBatch,) for i in range(10)]

# Since web content is our data, we create a dataframe with options on that data: offsets

bingParameters = spark.createDataFrame(offsets, ["offset"])

# Run the Bing Image Search service with our text query

bingSearch = (BingImageSearch()

.setSubscriptionKey(bingsearch_service_key)

.setOffsetCol("offset")

.setQuery("Martin Luther King Jr. quotes")

.setCount(imgsPerBatch)

.setOutputCol("images"))

# Transformer that extracts and flattens the richly structured output of Bing Image Search into a simple URL column

getUrls = BingImageSearch.getUrlTransformer("images", "url")

pipeline_bingsearch = PipelineModel(stages=[bingSearch, getUrls])

# Show the results of your search: image URLs

res_bingsearch = pipeline_bingsearch.transform(bingParameters)

display(res_bingsearch.dropDuplicates())

Ожидаемые результаты

| Изображение |

|---|

http://everydaypowerblog.com/wp-content/uploads/2014/01/Martin-Luther-King-Jr.-Quotes-16.jpg |

http://www.scrolldroll.com/wp-content/uploads/2017/06/6-25.png |

http://abettertodaymedia.com/wp-content/uploads/2017/01/86783bd7a92960aedd058c91a1d10253.jpg |

https://weneedfun.com/wp-content/uploads/2016/05/martin-luther-king-jr-quotes-11.jpg |

http://www.sofreshandsogreen.com/wp-content/uploads/2012/01/martin-luther-king-jr-quote-sofreshandsogreendotcom.jpg |

https://cdn.quotesgram.com/img/72/57/1104209728-martin_luther_king_jr_quotes_16.jpg |

http://comicbookandbeyond.com/wp-content/uploads/2019/05/Martin-Luther-King-Jr.-Quotes.jpg |

https://exposingthepain.files.wordpress.com/2015/01/martin-luther-king-jr-quotes-08.png |

https://topmemes.me/wp-content/uploads/2020/01/Top-10-Martin-Luther-King-jr.-Quotes2-1024x538.jpg |

http://img.picturequotes.com/2/581/580286/dr-martin-luther-king-jr-quote-1-picture-quote-1.jpg |

http://parryz.com/wp-content/uploads/2017/06/Amazing-Martin-Luther-King-Jr-Quotes.jpg |

http://everydaypowerblog.com/wp-content/uploads/2014/01/Martin-Luther-King-Jr.-Quotes1.jpg |

https://lessonslearnedinlife.net/wp-content/uploads/2020/05/Martin-Luther-King-Jr.-Quotes-2020.jpg |

https://quotesblog.net/wp-content/uploads/2015/10/Martin-Luther-King-Jr-Quotes-Wallpaper.jpg |

Пример для Детектора аномалий

Детектор аномалий — удобное средство для обнаружения несоответствующих данных во временных рядах. В этом примере мы используем службу для поиска аномалий во всех временных рядах.

from pyspark.sql.functions import lit

# Create a dataframe with the point data that Anomaly Detector requires

df_timeseriesdata = spark.createDataFrame([

("1972-01-01T00:00:00Z", 826.0),

("1972-02-01T00:00:00Z", 799.0),

("1972-03-01T00:00:00Z", 890.0),

("1972-04-01T00:00:00Z", 900.0),

("1972-05-01T00:00:00Z", 766.0),

("1972-06-01T00:00:00Z", 805.0),

("1972-07-01T00:00:00Z", 821.0),

("1972-08-01T00:00:00Z", 20000.0), # anomaly

("1972-09-01T00:00:00Z", 883.0),

("1972-10-01T00:00:00Z", 898.0),

("1972-11-01T00:00:00Z", 957.0),

("1972-12-01T00:00:00Z", 924.0),

("1973-01-01T00:00:00Z", 881.0),

("1973-02-01T00:00:00Z", 837.0),

("1973-03-01T00:00:00Z", 9000.0) # anomaly

], ["timestamp", "value"]).withColumn("group", lit("series1"))

# Run the Anomaly Detector service to look for irregular data

anamoly_detector = (SimpleDetectAnomalies()

.setSubscriptionKey(anomalydetector_key)

.setLocation("eastasia")

.setTimestampCol("timestamp")

.setValueCol("value")

.setOutputCol("anomalies")

.setGroupbyCol("group")

.setGranularity("monthly"))

# Show the full results of the analysis with the anomalies marked as "True"

display(anamoly_detector.transform(df_timeseriesdata).select("timestamp", "value", "anomalies.isAnomaly"))

Ожидаемые результаты

| TIMESTAMP | value | isAnomaly |

|---|---|---|

| 1972-01-01T00:00:00Z | 826.0 | false |

| 1972-02-01T00:00:00Z | 799.0 | false |

| 1972-03-01T00:00:00Z | 890.0 | false |

| 1972-04-01T00:00:00Z | 900.0 | false |

| 1972-05-01T00:00:00Z | 766.0 | false |

| 1972-06-01T00:00:00Z | 805.0 | false |

| 1972-07-01T00:00:00Z | 821.0 | false |

| 1972-08-01T00:00:00Z | 20000.0 | true |

| 1972-09-01T00:00:00Z | 883.0 | false |

| 1972-10-01T00:00:00Z | 898.0 | false |

| 1972-11-01T00:00:00Z | 957.0 | false |

| 1972-12-01T00:00:00Z | 924.0 | false |

| 1973-01-01T00:00:00Z | 881.0 | false |

| 1973-02-01T00:00:00Z | 837.0 | false |

| 1973-03-01T00:00:00Z | 9000.0 | true |

Пример преобразования речи в текст

Служба Преобразование речи в текст преобразует потоки или файлы с речью в текст. В этом примере мы выполним транскрибирование одного аудиофайла в текст.

# Create a dataframe with our audio URLs, tied to the column called "url"

df = spark.createDataFrame([("https://mmlspark.blob.core.windows.net/datasets/Speech/audio2.wav",)

], ["url"])

# Run the Speech-to-text service to translate the audio into text

speech_to_text = (SpeechToTextSDK()

.setSubscriptionKey(service_key)

.setLocation("northeurope") # Set the location of your Azure AI services resource

.setOutputCol("text")

.setAudioDataCol("url")

.setLanguage("en-US")

.setProfanity("Masked"))

# Show the results of the translation

display(speech_to_text.transform(df).select("url", "text.DisplayText"))

Ожидаемые результаты

| url | DisplayText |

|---|---|

https://mmlspark.blob.core.windows.net/datasets/Speech/audio2.wav |

Служба "Пользовательское распознавание речи" предоставляет инструменты, позволяющие визуально проверить качество распознавания модели путем сравнения аудиоданных с соответствующим результатом распознавания на портале Пользовательского распознавания речи. You can playback uploaded audio and determine if the provided recognition result is correct. This tool allows you to quickly inspect quality of Microsoft's baseline speech to text model or a trained custom model without having to transcribe any audio data. |

Очистка ресурсов

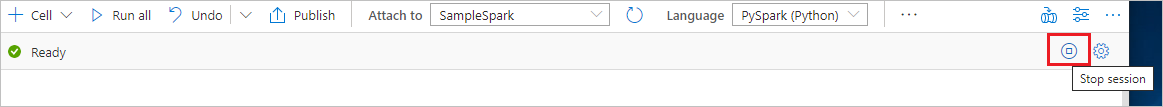

Чтобы правильно завершить работу экземпляра Spark, завершите все подключенные сеансы (записные книжки). Пул Apache Spark завершит работу автоматически, когда истечет указанное для него время простоя. Можно также выполнить команду остановки сеанса из строки состояния в верхней правой части записной книжки.