Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Применимо к: ✔️ виртуальные машины Linux ✔️ виртуальные машины Windows ✔️ гибкие наборы масштабирования ✔️ унифицированные наборы масштабирования

Сервер серии HX имеет 2 * 96-ядра EPYC 9V33X ЦП для всего 192 физических ядер "Zen4" с кэшем AMD 3D-V. Одновременная многопоточность (SMT) отключена на HX. Эти 192 ядра разделены на 24 раздела (12 на сокет), каждый раздел, содержащий 8 ядер процессора с универсальным доступом к кэшу L3 96 МБ. Серверы Azure HX также выполняют следующие параметры AMD BIOS:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

В результате сервер загружается с 4 доменов NUMA (2 на сокет) каждый 48 ядер в размере. Каждый NUMA имеет прямой доступ к 6 каналам физической DRAM.

Чтобы предоставить место для гипервизора Azure для работы без вмешательства в работу виртуальной машины, мы резервируем 16 физических ядер на сервер.

Топология виртуальной машины

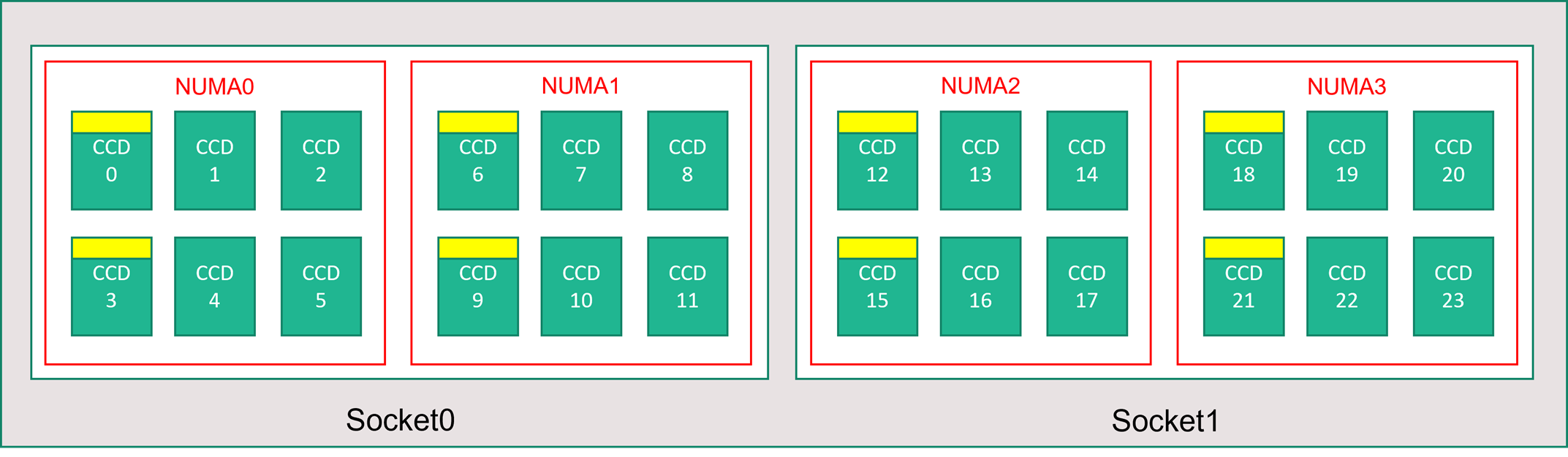

На следующей схеме показана топология сервера. Мы зарезервируем эти 16 ядер узла гипервизора (желтый) симметрично в обоих сокетах ЦП, принимая первые 2 ядра из определенных основных сложных dies (CCD) в каждом домене NUMA с оставшимися ядрами для виртуальной машины серии HX (зеленый).

Граница CCD отличается от границы NUMA. В HX группа из шести последовательных CCD настраивается как домен NUMA, как на уровне узла, так и в гостевой виртуальной машине. Таким образом, все размеры виртуальных машин HX предоставляют 4 универсальных домена NUMA, которые отображаются в ОС и приложении таким образом, каждый из которых имеет разное количество ядер в зависимости от конкретного размера виртуальной машины HX.

Размер каждой виртуальной машины HX аналогичен физическому макету, функциям и производительности другого ЦП серии AMD EPYC 9004, как показано ниже.

| Размер виртуальной машины серии HX | Домены NUMA | Количество ядер на домен NUMA | Сходство с AMD EPYC |

|---|---|---|---|

| Standard_HX176rs | 4 | 44 | EPYC 9V33X с двумя сокетами |

| Standard_HX176-144rs | 4 | 36 | EPYC 9V33X с двумя сокетами |

| Standard_HX176-96rs | 4 | двадцать четыре | EPYC 9V33X с двумя сокетами |

| Standard_HX176-48rs | 4 | 12 | EPYC 9V33X с двумя сокетами |

| Standard_HX176-24rs | 4 | 6 | EPYC 9V33X с двумя сокетами |

Замечание

Размеры виртуальных машин с ограниченным количеством ядер уменьшают только количество физических ядер, предоставленных виртуальной машине. Все глобальные общие ресурсы (ОЗУ, пропускная способность памяти, кэш третьего уровня, подключение GMI и xGMI, InfiniBand, сеть Ethernet Azure, локальный SSD) остаются постоянными. Он позволяет клиенту выбрать размер виртуальной машины, который лучше всего подходит для определенного набора рабочих нагрузок или требований к лицензированию программного обеспечения.

Сопоставление виртуальной виртуальной машины NUMA для каждого размера виртуальной машины HX сопоставляется с базовой физической топологией NUMA. Нет потенциальной вводящей в заблуждение абстракции аппаратной топологии.

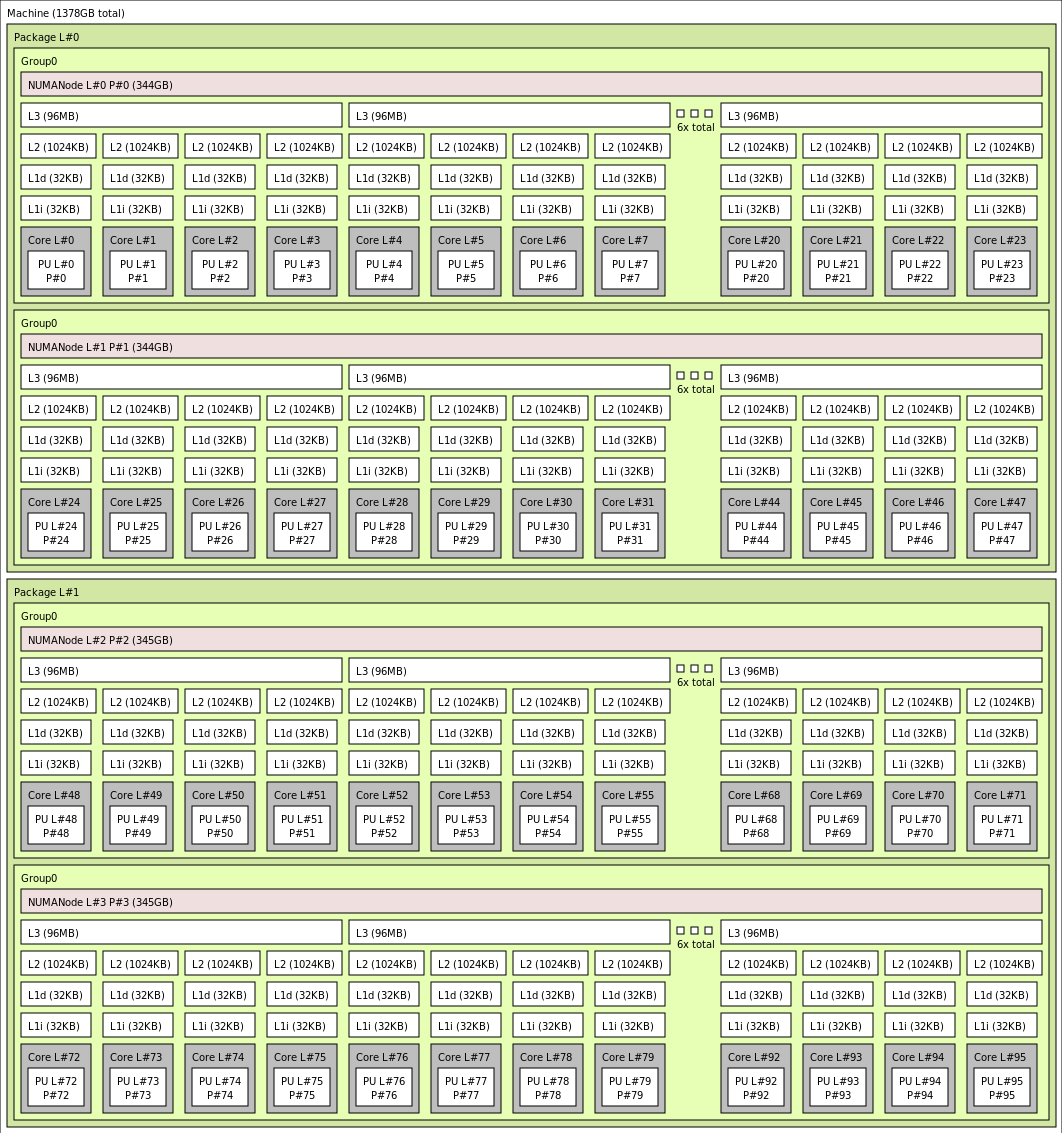

Точные топологии для различных размеров виртуальных машин HX отображаются следующим образом, используя выходные данные lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Щелкните, чтобы просмотреть выходные данные lstopo для Standard_HX176rs

Щелкните, чтобы просмотреть выходные данные lstopo для Standard_HX176-144rs

Щелкните, чтобы просмотреть выходные данные lstopo для Standard_HX176-96rs

Щелкните, чтобы просмотреть выходные данные lstopo для Standard_HX176-48rs

Щелкните, чтобы просмотреть выходные данные lstopo для Standard_HX176-24rs

Сеть InfiniBand

Виртуальные машины HX также имеют сетевые адаптеры NVIDIA Mellanox NDR InfiniBand (ConnectX-7), работающие до 400 Гигабит/с. Сетевой адаптер передается виртуальной машине через SRIOV, что позволяет сетевому трафику обойти гипервизор. В результате клиенты загружают стандартные драйверы Mellanox OFED на виртуальных машинах HX, так как они будут использовать среду без операционной системы.

Виртуальные машины HX поддерживают адаптивную маршрутизацию, динамический подключенный транспорт (DCT, в дополнение к стандартным транспортам RC и UD), а также аппаратные разгрузки коллективов MPI на процессор подключения адаптера ConnectX-7. Эти функции повышают производительность приложений, масштабируемость и согласованность и рекомендуется использовать их.

Временное хранилище

Виртуальные машины HX имеют 3 физически локальных SSD-устройства. Одно устройство предварительно отформатировано, чтобы служить файлом страницы, и он появился в виртуальной машине в качестве универсального устройства SSD.

Два других более крупных устройства SSD предоставляются в виде неформатированных блочных устройств NVMe через NVMeDirect. По мере того как устройство NVMe блока проходит гипервизор, он имеет более высокую пропускную способность, более высокую скорость ввода-вывода в секунду и более низкую задержку на IOP.

При паре в полосатый массив SSD NVMe предоставляет до 12 ГБ/с операций чтения и 7 ГБ/с, а также до 186 000 операций ввода-вывода в секунду (считывает) и 201 000 операций ввода-вывода в секунду (записывает) для глубины очереди.

Характеристики оборудования

| Характеристики оборудования | Виртуальные машины серии HX |

|---|---|

| Ядра | 176, 144, 96, 48 или 24 (SMT отключен) |

| ЦП | AMD EPYC 9V33X |

| Частота ЦП (без AVX) | Базовый уровень 2,55 ГГц, пиковый импульс 3,7 ГГц |

| Память | 1,4 ТБ (ОЗУ на ядро зависит от размера виртуальной машины) |

| Локальный диск | 2 * 1,8 ТБ NVMe (блок), 480 ГБ SSD (файл страницы) |

| InfiniBand | 400 Гб/с Mellanox ConnectX-7 NDR InfiniBand |

| Сеть | 80 ГБ/с Ethernet (40 ГБ/с, доступный для использования) Второй 2-го поколения SmartNIC |

Характеристики программного обеспечения

| Характеристики программного обеспечения | Виртуальные машины серии HX |

|---|---|

| Максимальный размер задания MPI | 52 800 ядер (300 виртуальных машин в одном масштабируемом наборе виртуальных машин с singlePlacementGroup=true) |

| Поддержка MPI | HPC-X (2.13 или более поздней версии), Intel MPI (2021.7.0 или более поздней версии), OpenMPI (4.1.3 или более поздней версии), MVAPICH2 (2.3.7 или более поздней версии), MPICH (4.1 или более поздней версии) |

| Другие платформы | UCX, libfabric, PGAS или другие среды выполнения на основе InfiniBand |

| Поддержка службы хранилища Microsoft Azure | Диски уровня "Стандартный" и "Премиум" (не более 32 дисков), Azure NetApp Files, Файлы Azure, Azure HPC Cache, Управляемой файловой системой Lustre Azure |

| Поддерживаемая и проверенная ОС | AlmaLinux 8.6, 8.7, Ubuntu 20.04+ |

| Рекомендуемая операционная система для повышения производительности | AlmaLinux HPC 8.7, Ubuntu-HPC 20.04+ |

| Поддержка Оркестратора | Azure CycleCloud, пакетная служба Azure, AKS; параметры конфигурации кластера |

Замечание

- Эти виртуальные машины поддерживают только поколение 2.

- Официальная поддержка уровня ядра от AMD начинается с RHEL 8.6 и AlmaLinux 8.6, которая является производным от RHEL.

- Windows Server 2012 R2 не поддерживается на HX и других виртуальных машинах с более чем 64 (виртуальными или физическими) ядрами. Дополнительные сведения см. в статье "Поддерживаемые гостевые операционные системы Windows" для Hyper-V в Windows Server. Windows Server 2022 требуется для 144 и 176 основных размеров, Windows Server 2016 также работает для 24, 48 и 96 основных размеров, Windows Server работает только для 24 и 48 основных размеров.

Это важно

Рекомендуемое изображение URN: almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101, чтобы развернуть этот образ в Azure CLI, убедитесь, что следующие параметры включены --plan 8_7-hpc-gen2 --product almalinux-hpc-hpc -publisher almalinux. Для масштабирования тестов используйте рекомендуемый URN вместе с новым HPC-X tarball.

Замечание

- Поддержка NDR добавляется в UCX 1.13 или более поздней версии. Старые версии UCX сообщают об ошибке среды выполнения. Ошибка UCX: недопустимая активная скорость

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128. - Ibstat показывает низкую скорость (SDR): старые версии Mellanox OFED (MOFED) не поддерживают NDR и могут сообщать о более медленных скоростях IB. Используйте MOFED версии 5.6-1.0.3.3 или более поздней.

Дальнейшие шаги

- Ознакомьтесь с последними объявлениями, примерами рабочей нагрузки HPC, а также результатами оценки производительности в блогах технического сообщества Вычислений Azure.

- Сведения о более высоком уровне архитектурного представления выполнения рабочих нагрузок HPC см. в статье Высокопроизводительные вычисления (HPC) в Azure.