Сценарий ценообразования с помощью конвейера данных для загрузки 1 ТБ данных Parquet в хранилище данных

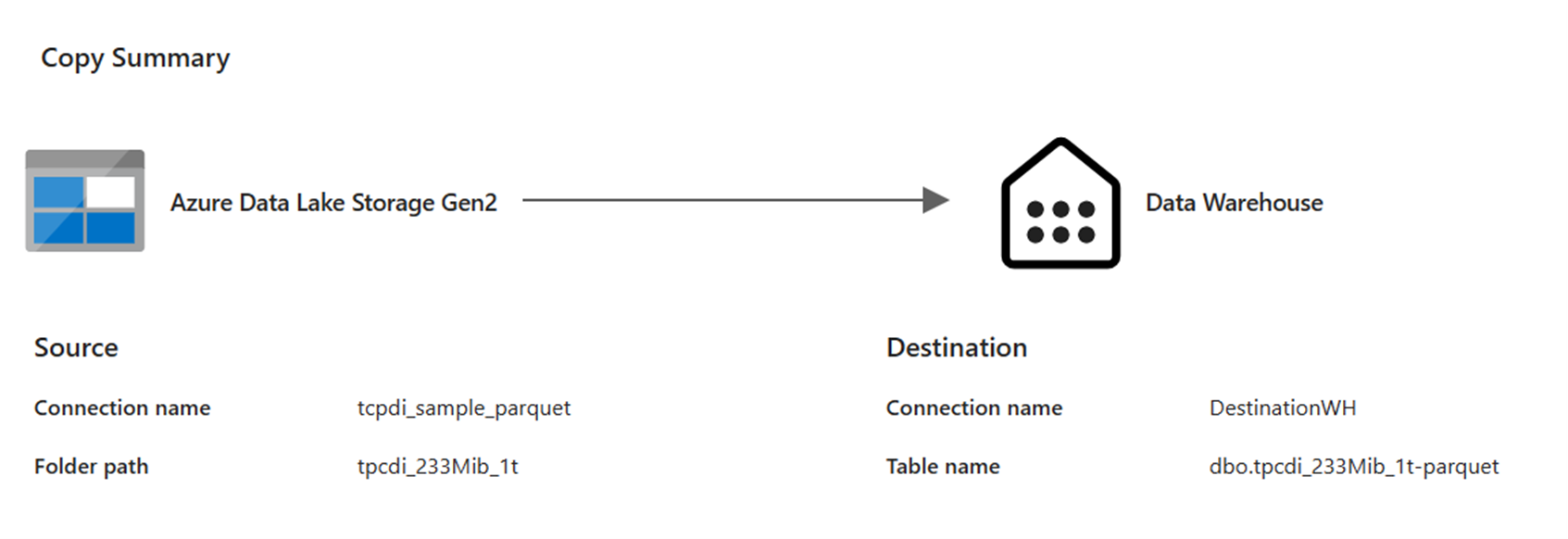

В этом сценарии действие Copy использовался в конвейере данных для загрузки 1 ТБ данных таблицы Parquet, хранящихся в Azure Data Lake служба хранилища(ADLS) 2-го поколения, в хранилище данных в Microsoft Fabric.

Цены, используемые в следующем примере, являются гипотетическими и не намерены подразумевать точные фактические цены. Это просто для демонстрации того, как можно оценить, спланировать и управлять затратами на проекты Фабрики данных в Microsoft Fabric. Кроме того, так как емкости Fabric имеют уникальную цену в разных регионах, мы используем цены на оплату по мере использования для емкости Fabric на западе США 2 (типичный регион Azure) на 0,18 долл. США в час. См. здесь сведения о ценах на Microsoft Fabric. Чтобы изучить другие варианты ценообразования емкости Fabric.

Настройка

Чтобы выполнить этот сценарий, необходимо создать конвейер со следующей конфигурацией:

Оценка затрат с помощью приложения метрик Fabric

Операция перемещения данных использовала 3960 секунд с накопительным пакетом обновления с длительностью 662,64 секунды во время выполнения действия null, так как в выполнении конвейера не было никаких действий без копирования.

Примечание.

Несмотря на то, что эта метрика отображается как метрика, фактическое время выполнения не имеет значения при вычислении эффективных часов CU с приложением метрик Структуры, так как метрика метрики CU, которая также сообщает уже о учетных записях в течение его длительности.

| Metric | Операция перемещения данных |

|---|---|

| Секунды cu | 3960 секунд cu |

| Эффективные часы CU | (3960) / (60*60) CU-hours = 1.1 CU-hours |

Общая стоимость выполнения на $0,18/CU час = (1,1 CU-час ) * ($0,18/CU час) ~= $0,20