Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Записные книжки Microsoft Fabric поддерживают простое взаимодействие с данными Lakehouse с помощью Pandas, самой популярной библиотеки Python для изучения и обработки данных. В записной книжке можно быстро считывать данные и записывать их обратно в ресурсы Lakehouse в различных форматах файлов. В этом руководстве приведены примеры кода, которые помогут вам приступить к работе с собственной записной книжкой.

Необходимые компоненты

Получение подписки Microsoft Fabric. Или зарегистрируйте бесплатную пробную версию Microsoft Fabric.

Войдите в Microsoft Fabric.

Используйте переключатель интерфейса в левой нижней части домашней страницы, чтобы перейти на Fabric.

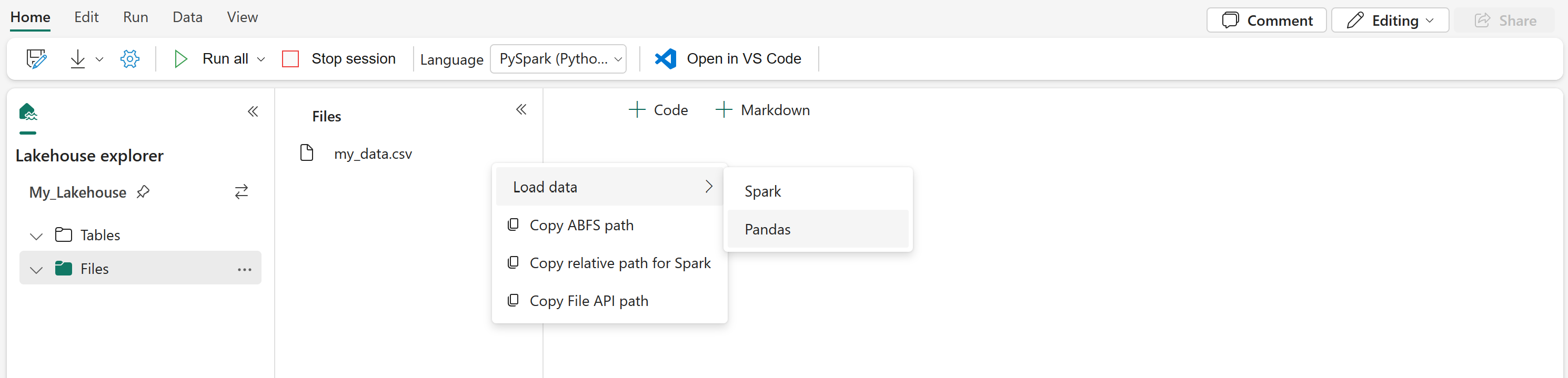

Загрузка данных Lakehouse в записную книжку

Подключив Lakehouse к записной книжке Microsoft Fabric, вы можете изучить сохраненные данные, не выходя из страницы, и прочитать его в записную книжку с помощью нескольких шагов. Выбор всех параметров поверхностей файлов Lakehouse для загрузки данных в Spark или Кадр данных Pandas. Вы также можете скопировать полный путь ABFS файла или понятный относительный путь.

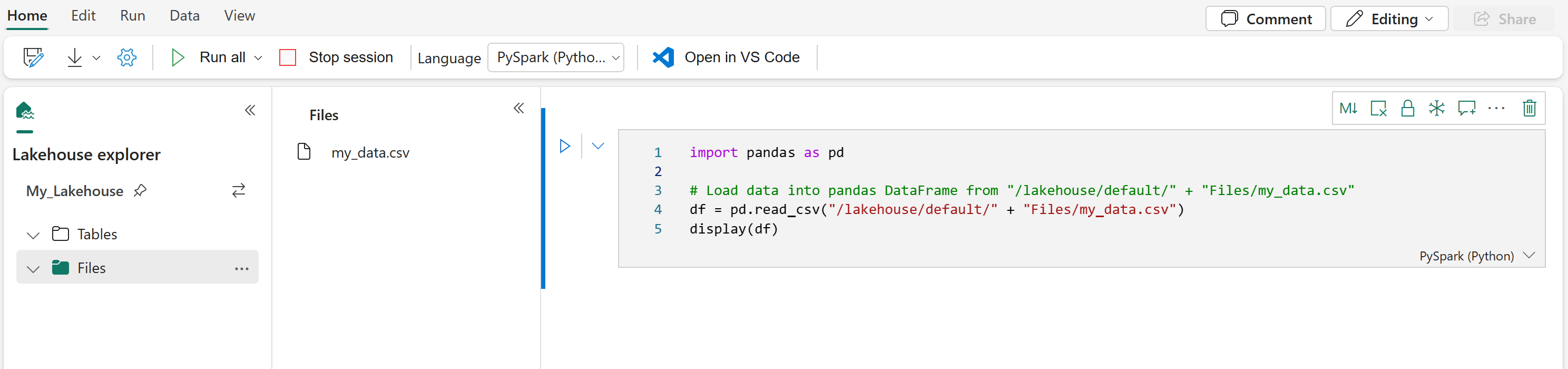

Выбор одного из запросов "Загрузка данных" создает ячейку кода для загрузки этого файла в кадр данных в записной книжке.

Преобразование кадра данных Spark в кадр данных Pandas

Для справки в этой команде показано, как преобразовать кадр данных Spark в кадр данных Pandas:

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

Чтение и запись различных форматов файлов

Примечание.

Изменение версии определенного пакета может потенциально нарушить другие пакеты, которые зависят от него. Например, понижение azure-storage-blob может привести к проблемам с Pandas и различными другими библиотеками, которые полагаются Pandasна , в том числе mssparkutils, fsspec_wrapperи notebookutils.

Вы можете просмотреть список предварительно установленных пакетов и их версий для каждой среды выполнения.

В этих примерах кода описаны операции Pandas для чтения и записи различных форматов файлов.

Примечание.

В этих примерах кода необходимо заменить пути к файлам. Pandas поддерживает как относительные пути, так и полные пути ABFS. Пути любого типа можно извлечь и скопировать из интерфейса в соответствии с предыдущим шагом.

Чтение данных из CSV-файла

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

Запись данных в ВИДЕ CSV-файла

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Чтение данных из файла Parquet

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

Запись данных в виде файла Parquet

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Чтение данных из файла Excel

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values. Also need to add correct filepath after Files/ if file is placed in different folders

# if using default lakehouse that attached to the notebook use the code to replace below: df = pandas.read_excel("/lakehouse/default/Files/FILENAME.xlsx")

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Запись данных в виде файла Excel

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

Чтение данных из JSON-файла

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

Запись данных в виде JSON-файла

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")