Создание решения компьютерного зрения в Azure Percept Studio без необходимости писать код

Важно!

Прекращение поддержки Azure Percept DK.

Обновление 22 февраля 2023 г. Обновление встроенного ПО для периферийных компонентов Percept DK Vision and Audio (также известное как Визуальное распознавание и звук SOM) теперь доступно здесь и позволит вспомогательным компонентам продолжать работу после даты прекращения использования.

Общедоступная предварительная версия Azure Percept будет развиваться для поддержки новых платформ пограничных устройств и возможностей разработчика. В рамках этой эволюции Azure Percept DK и аудио-аксессуаров и связанных служб Поддержки Azure для Percept DK будет прекращена 30 марта 2023 г.

Начиная с 30 марта 2023 г. Azure Percept DK и аудиосхозяйки больше не будут поддерживаться службами Azure, включая Azure Percept Studio, обновления ОС, обновления контейнеров, просмотр веб-потока и интеграцию Пользовательское визуальное распознавание. Корпорация Майкрософт больше не будет предоставлять поддержку по успешному выполнению клиентами и связанные с ней вспомогательные услуги. Дополнительные сведения см. в записи блога Уведомление о прекращении поддержки.

Azure Percept Studio позволяет создать и развернуть пользовательское решение компьютерного зрения без необходимости писать код. В этой статье мы затронем следующие вопросы.

- Создание проекта компьютерного зрения в Azure Percept Studio.

- Сбор обучающих изображений с помощью DevKit.

- Присвоение меток обучающим изображениям в Пользовательском визуальном распознавании.

- Обучение пользовательской модели обнаружения объектов или классификации.

- Развертывание модели в DevKit.

- Улучшение модели путем настройки повторного обучения

Это руководство предназначено для разработчиков с минимальным опытом работы с ИИ и тех, кто только начинает работу с Azure Percept.

Предварительные требования

- Azure Percept DK (DevKit).

- Подписка Azure.

- Выполненная настройка Azure Percept DK. Предполагается, что вы уже подключили DevKit к сети Wi-Fi, создали центр Интернета вещей и подключили к нему DevKit.

Создание прототипа компьютерного зрения

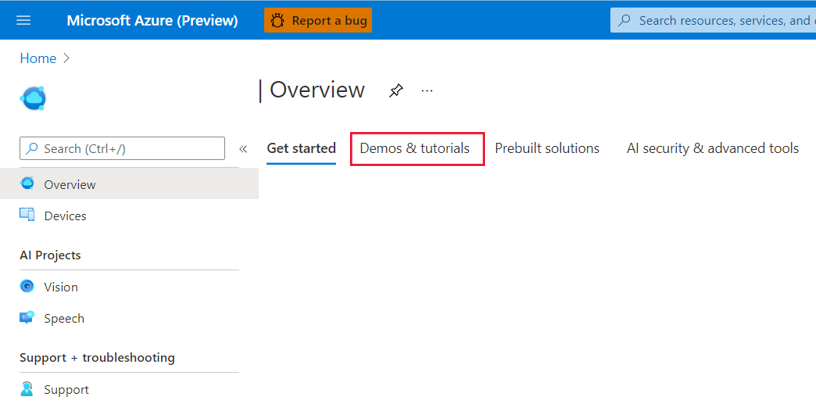

Запустите браузер и перейдите к Azure Percept Studio.

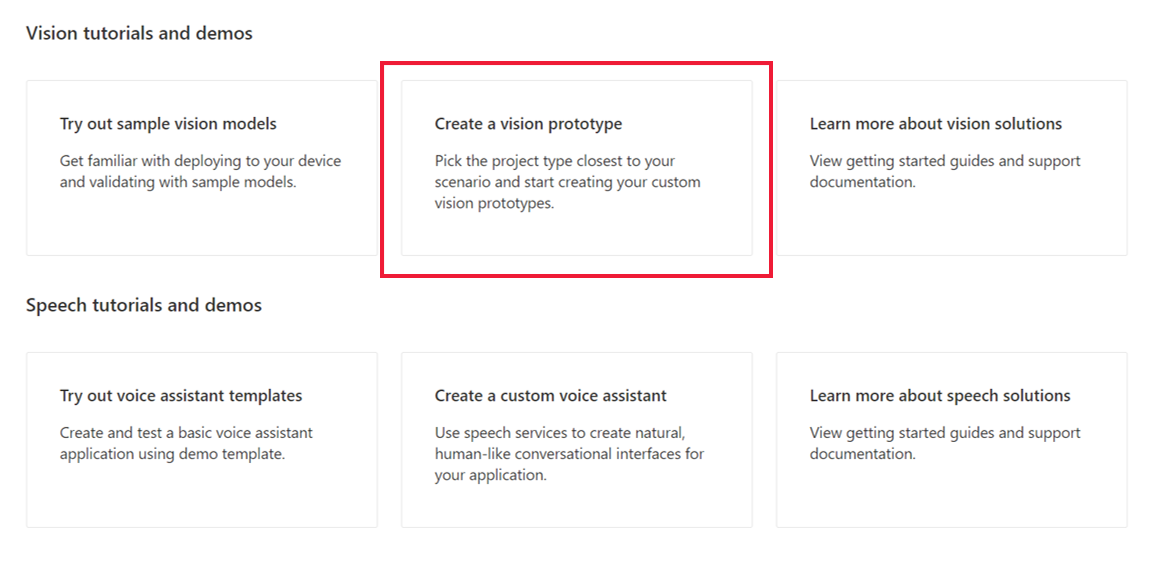

На странице обзора откройте вкладку Демонстрации & учебники.

В разделе Vision tutorials and demos (Руководства и демонстрации для компьютерного зрения) щелкните Create a vision prototype (Создать прототип компьютерного зрения).

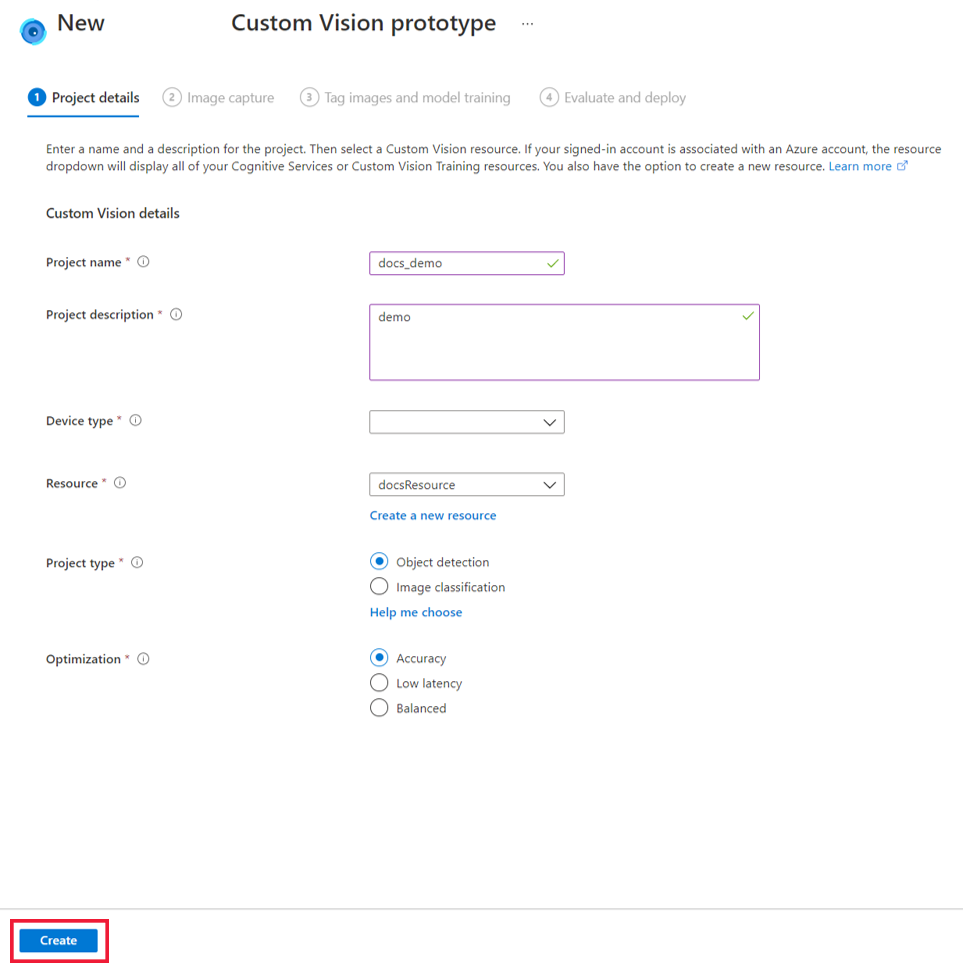

На странице New Azure Percept Custom Vision prototype (Новый прототип Пользовательского визуального распознавания в Azure Percept) сделайте следующее:

В поле Project name (Имя проекта) введите имя прототипа компьютерного зрения.

Введите описание для прототипа компьютерного зрения в поле Project description (Описание проекта).

Выберите Azure Percept DK (Azure Percept DevKit) в раскрывающемся меню Device type (Тип устройства).

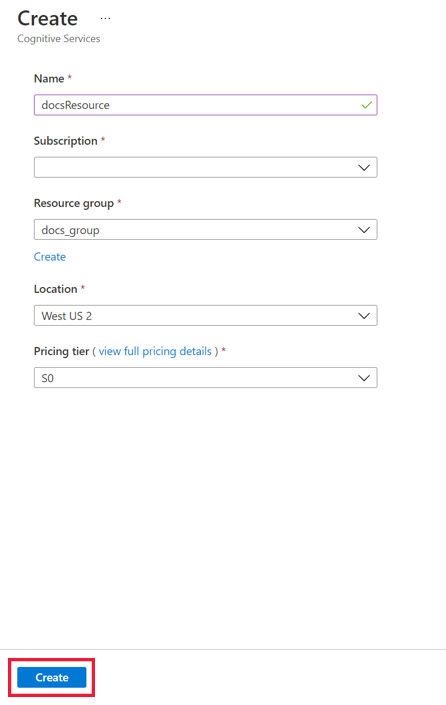

Выберите ресурс в раскрывающемся меню Resource (Ресурс) или щелкните Create a new resource (Создать ресурс). Если вы решите создать ресурс, в окне Create (Создание) сделайте следующее:

- Введите имя нового ресурса.

- Выберите подписку Azure.

- Выберите группу ресурсов или создайте новую.

- Выберите предпочитаемый регион.

- Выберите ценовую категорию (рекомендуется S0).

- Щелкните Create (Создать) в нижней части экрана.

Для параметра Project type (Тип проекта) выберите, будет ли ваш проект выполнять обнаружение объектов или классификацию изображений. Чтобы узнать больше о типах проектов, щелкните Help me choose (Нужна помощь с выбором).

Для параметра Optimization (Оптимизация) выберите, хотите ли вы оптимизировать проект для обеспечения точности, низкой сетевой задержки или сбалансированной конфигурации.

Нажмите кнопку Создать .

Подключение устройства к проекту и получение изображений

В созданное решение компьютерного зрения необходимо добавить ваш DevKit и соответствующий Центр Интернета вещей.

Включите свой DevKit.

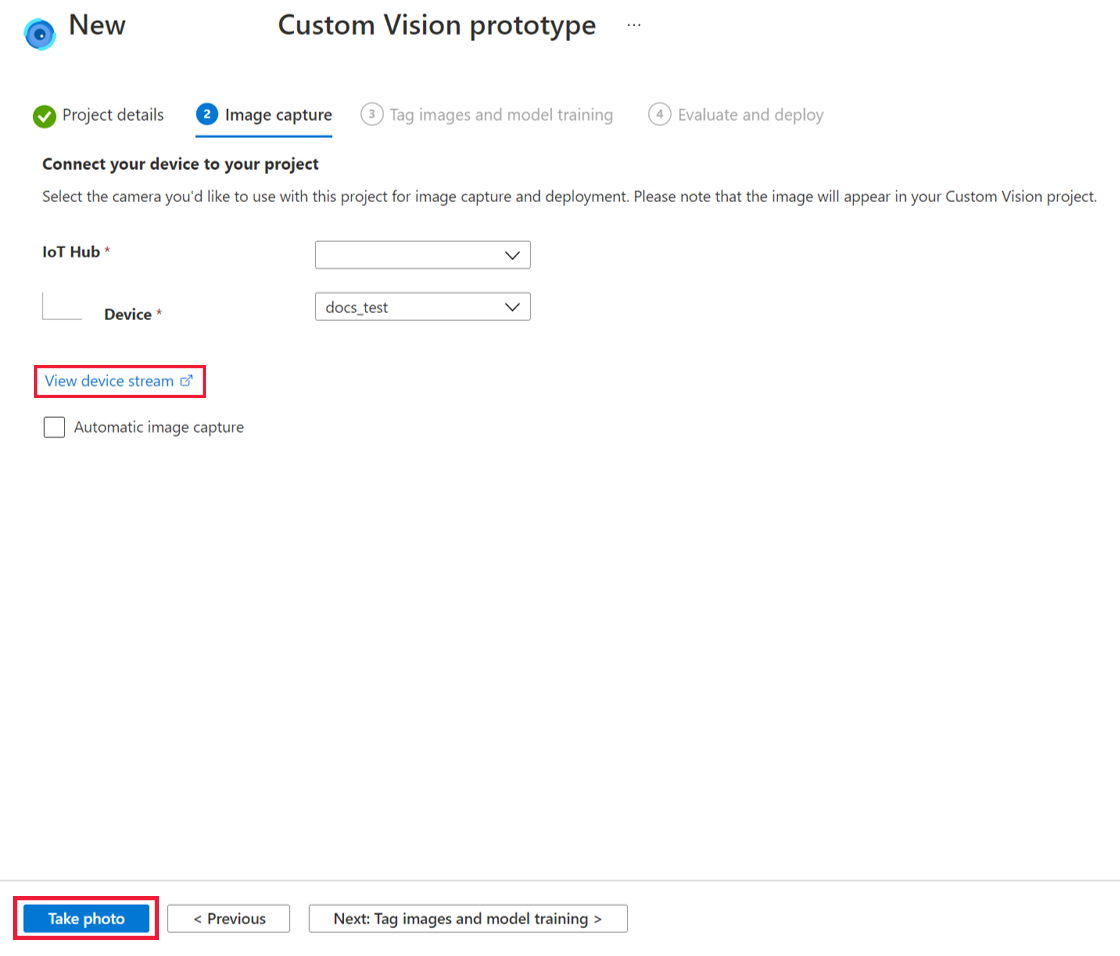

В раскрывающемся меню IoT Hub (Центр Интернета вещей) выберите центр Интернета вещей, к которому был подключен DevKit в ходе подготовки к первому использованию.

В раскрывающемся меню Devices (Устройства) выберите свой DevKit.

Далее загрузите или получите изображения для обучения модели ИИ. Мы рекомендуем загрузить по меньшей мере 30 изображений на каждый тип тегов. Например, если вы хотите создать определитель собак и котов, необходимо загрузить минимум 30 изображений с собаками и 30 изображений с котами. Чтобы получить изображения с помощью платы SOM вашего DevKit, сделайте следующее:

В окне Image capture (Захват изображений) выберите View device stream (Просмотреть поток устройства), чтобы просмотреть видеопоток с платы SOM.

Проверьте видеопоток и убедитесь, чтоб ваша камера SOM расположена правильно для получения обучающих изображений. При необходимости откорректируйте расположение.

В окне Image capture (Захват изображений) щелкните Take photo (Сделать фото).

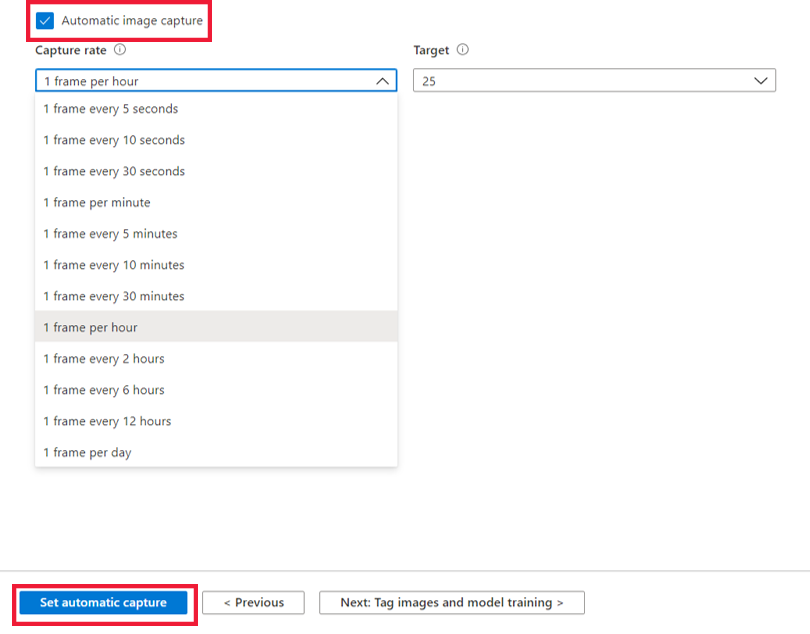

Или же настройте автоматический захват изображений для сбора большого количества изображений за раз. Для этого установите флажок Automatic image capture (Автоматический захват изображений). Выберите предпочтительную скорость захвата с помощью параметра Capture rate (Частота захвата) и общее число изображений с помощью параметра Target (Число). Щелкните Set automatic capture (Запустить автоматический захват), чтобы начать автоматический захват изображений.

Если у вас достаточно фотографий, щелкните Next: Tag images and model training (Далее: назначение тегов изображениям и обучение модели) в нижней части экрана. Все изображения будут сохранены в Пользовательском визуальном распознавании.

Примечание

Если вы решите отправить обучающие изображения непосредственно в Пользовательское визуальное распознавание, учтите, что размер файла изображения не может превышать 6 МБ.

Назначение тегов изображениям и обучение модели

Перед обучением модели добавьте метки к изображениям.

На странице Tag images and model training (Назначение тегов изображениям и обучение модели) щелкните Open project in Custom Vision (Открыть проект в Пользовательском визуальном распознавании).

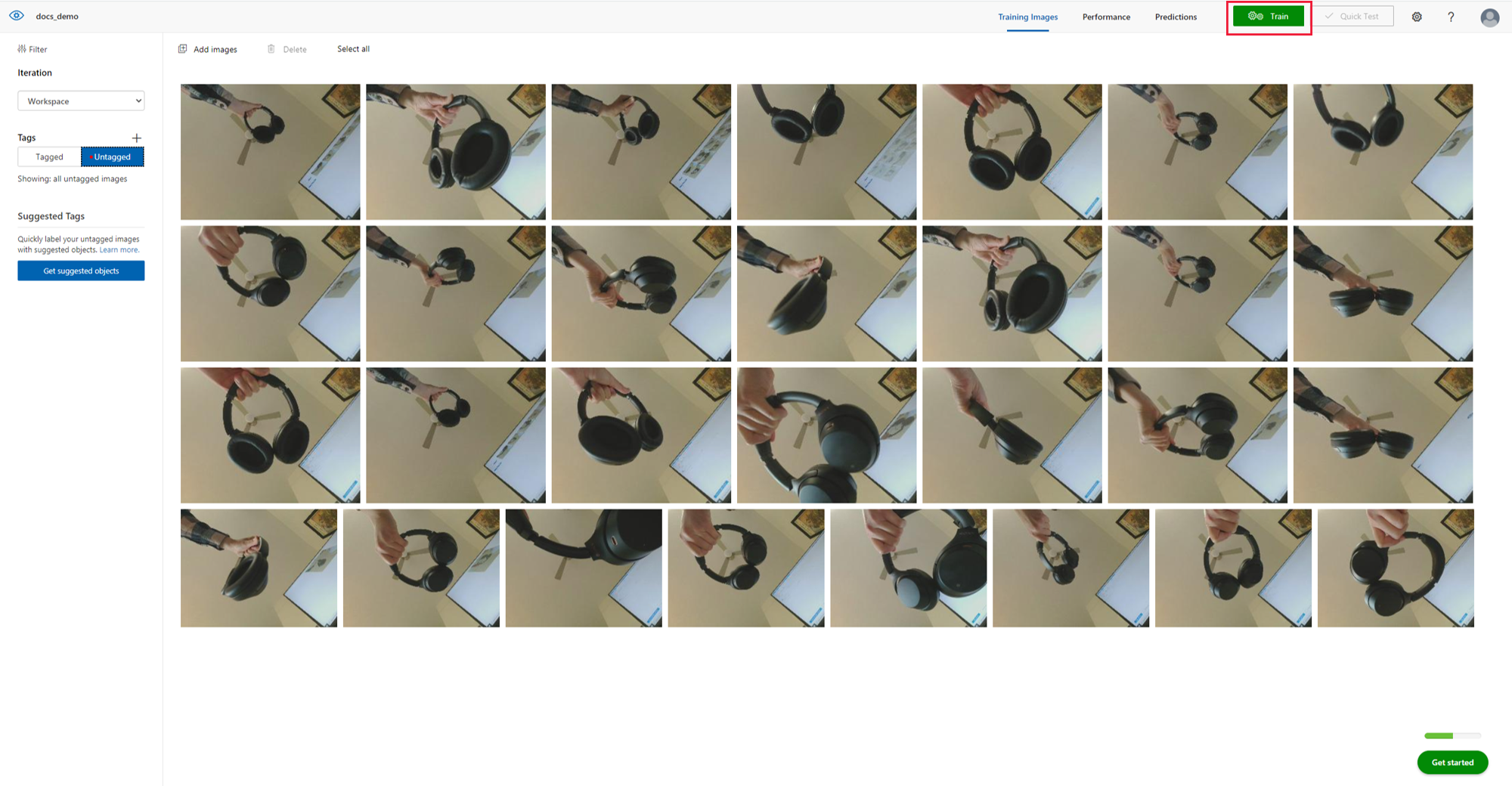

В левой части страницы Custom Vision (Пользовательское визуальное распознавание) щелкните Untagged (Без тегов) в разделе Tags (Теги), чтобы просмотреть полученные на предыдущем шаге изображения. Выберите одно или несколько изображений без тегов.

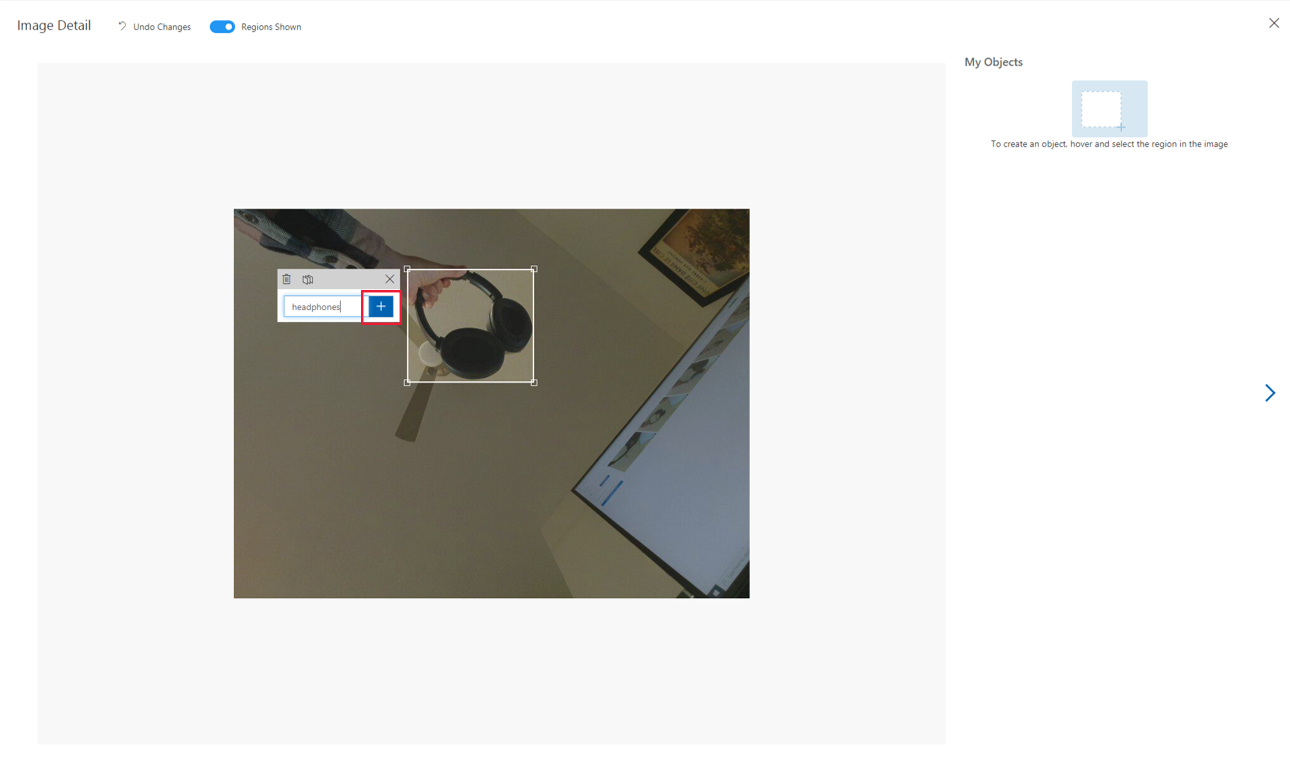

В окне Image Detail (Сведения об изображении) щелкните изображение, чтобы начать назначение тегов. Если в качестве типа проекта вы выбрали обнаружение объектов, вам нужно будет выделить объекты, которые вы хотите пометить, с помощью ограничивающего прямоугольника. При необходимости скорректируйте размеры ограничивающего прямоугольника. Введите тег объекта и щелкните + , чтобы применить тег. Например, если вы создаете решение компьютерного зрения, которое должно оповещать о необходимости заполнить полки в магазине, добавьте тег "Пустая полка"к изображениям пустых полок и тег "Полная полка" к изображениям заполненных полок. Повторите эти действия для всех изображений без тегов.

После добавления тегов к изображениям щелкните значок X в правом верхнем углу окна. Щелкните Tagged (С тегами) в разделе Tags (Теги), чтобы просмотреть все изображения с тегами.

После присвоения меток изображениям можно приступить к обучению модели ИИ. Для этого щелкните Train (Обучить) в верхней части страницы. Для обучения модели необходимо иметь минимум 15 изображений на каждый тип тегов (рекомендуется использовать не менее 30). Обучение обычно занимает около 30 минут, но если набор изображений очень большой, может потребоваться больше времени.

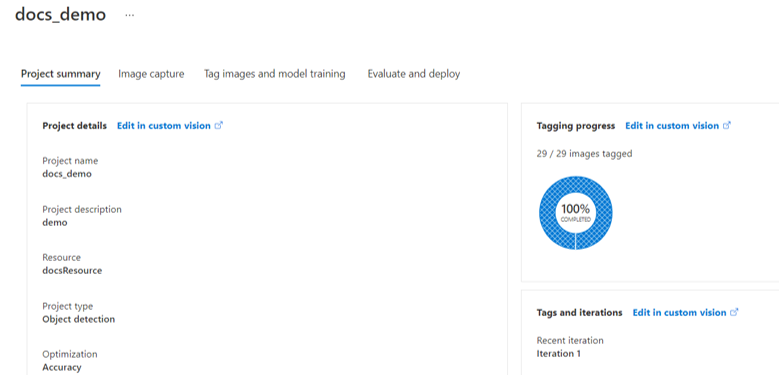

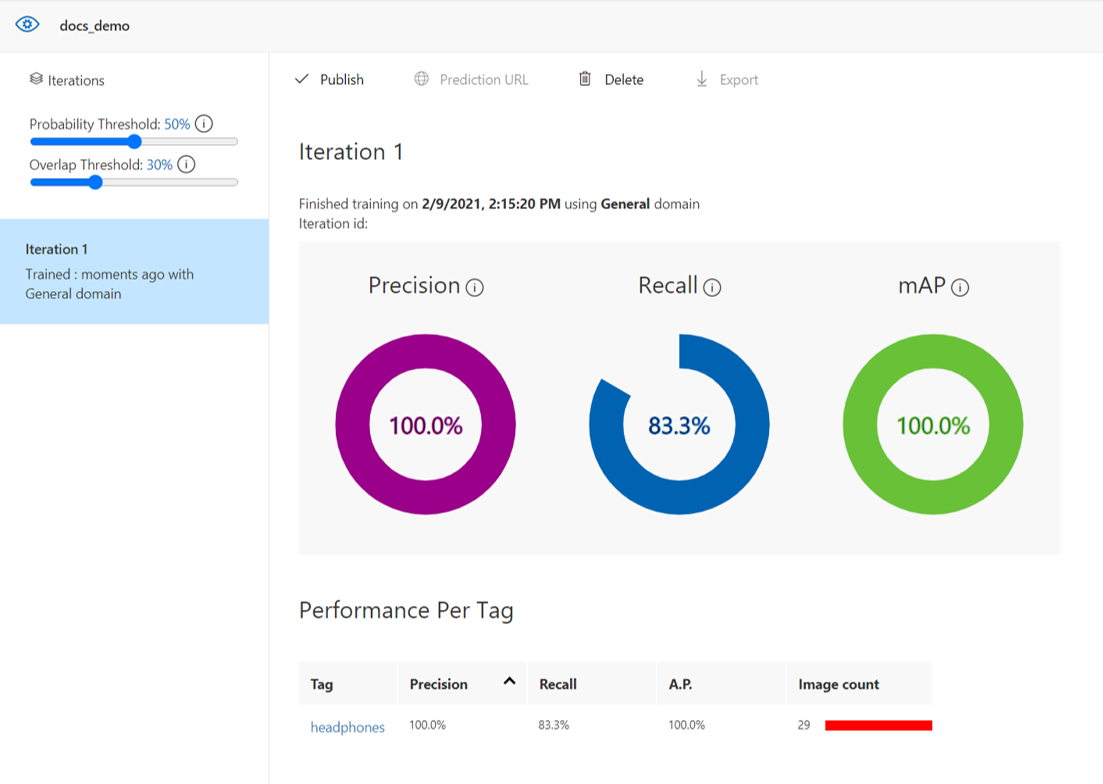

По завершении обучения на экране отобразятся сведения об эффективности модели. Дополнительные сведения об оценке этих результатов см. в документации по оценке модели. После обучения можно также протестировать модель на дополнительных изображениях и при необходимости запустить повторное обучение. При каждом обучении модель сохраняется как новая итерация. Дополнительные сведения о том, как повысить эффективность модели, см. в документации по Пользовательскому визуальному распознаванию.

Примечание

Если вы решите протестировать модель на дополнительных изображениях в Пользовательском визуальном распознавании, учтите, что размер файла тестового изображения не может превышать 4 МБ.

Если вас устраивает эффективность модели, завершите работу с Пользовательским визуальным распознаванием, закрыв вкладку браузера.

Развертывание модели ИИ

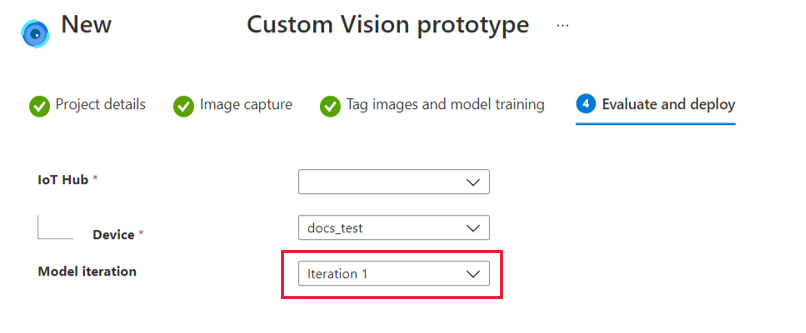

Вернитесь на вкладку Azure Percept Studio и щелкните Next: Evaluate and deploy (Далее: оценить и развернуть) в нижней части экрана.

В окне Evaluate and deploy (Оценка и развертывание) отобразится эффективность выбранной итерации модели. Выберите итерацию, которую вы хотите развернуть в DevKit, в раскрывающемся меню Model iteration (Итерация модели) и щелкните Deploy model (Развернуть модель) в нижней части экрана.

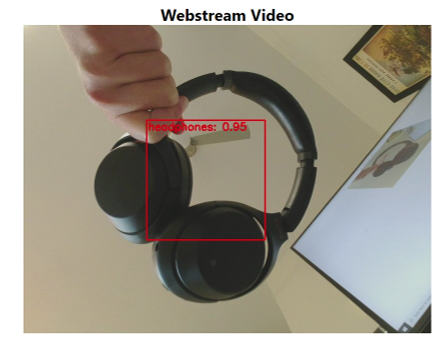

После развертывания модели просмотрите видеопоток устройства, чтобы оценить вывод модели в действии.

После закрытия этого окна вы можете в любое время вернуться к проекту компьютерного зрения и изменить его, щелкнув Vision (Компьютерное зрение) в разделе AI Projects (Проекты ИИ) на домашней странице Azure Percept Studio и выбрав имя проекта.

Улучшение модели путем настройки повторного обучения

После обучения модели и ее развертывания на устройстве можно повысить производительность модели, настроив параметры повторного обучения, чтобы захватывать больше данных для обучения. Эта функция используется для повышения производительности обученной модели путем предоставления возможности захвата изображений на основе диапазона вероятности. Например, устройство можно настроить на захват обучающих изображений только при низкой вероятности. Ниже приведено несколько дополнительных рекомендаций по добавлению изображений и балансировке данных для обучения.

Чтобы настроить повторное обучение, вернитесь на страницу Project (Проект), а затем — на вкладку Project Summary (Сводка по проекту).

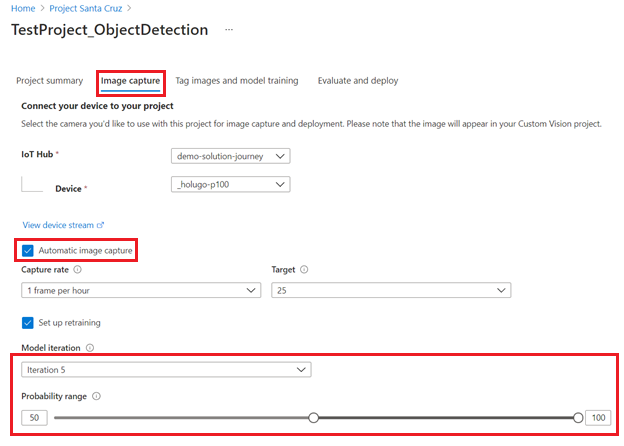

На вкладке Image capture (Захват изображений) выберите Automatic image capture (Автоматический захват изображений) и Set up retraining (Настройка повторного обучения).

Настройте автоматический захват изображений для сбора большого количества изображений за раз. Для этого установите флажок Automatic image capture (Автоматический захват изображений).

Выберите предпочтительную скорость захвата с помощью параметра Capture rate (Частота захвата) и общее число изображений с помощью параметра Target (Число).

В разделе Set up retraining (Настройка повторного обучения) выберите итерацию, для которой необходимо захватить дополнительные данные для обучения, а затем выберите диапазон вероятности. В проект будут отправлены только изображения, соответствующие коэффициенту вероятности.

Очистка ресурсов

Если для работы с этим руководством вы создали ресурс Azure, но больше не хотите разрабатывать или использовать решение компьютерного зрения, сделайте следующее, чтобы удалить ресурс:

- Перейдите на портал Microsoft Azure.

- Выберите Все ресурсы.

- Установите флажок рядом с ресурсом, созданным для этого руководства. Для ресурса будет указан тип Cognitive Services.

- Щелкните значок Удалить в верхней части экрана.

Видеоруководство

Визуальные пошаговые инструкции по описанным выше действиям см. в следующем видео:

Next Steps

Далее ознакомьтесь с руководствами по компьютерному зрению, чтобы узнать больше о дополнительных функциях решения компьютерного зрения в Azure Percept Studio.