Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Önemli

Bu özellik Beta sürümündedir. Hesap yöneticileri Bu özelliğe erişimi Önizlemeler sayfasından denetleyebilir.

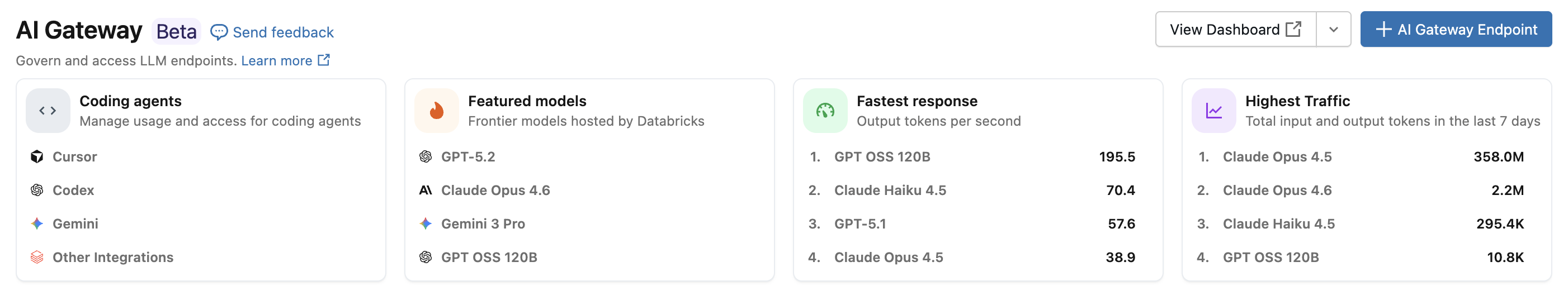

Azure Databricks kodlama aracısı tümleştirmesi ile İmleç, Gemini CLI, Codex CLI ve Claude Code gibi kodlama aracıları için erişimi ve kullanımı yönetebilirsiniz. AI Gateway'de oluşturulan bu ağ geçidi, kodlama araçlarınız için hız sınırlama, kullanım izleme ve çıkarım tabloları sağlar.

Özellikler

- Erişim: Tek bir fatura altında çeşitli kodlama araçlarına ve modellerine doğrudan erişim.

- Gözlemlenebilirlik: Tüm kodlama araçlarınızda kullanımı, harcamaları ve ölçümleri izlemek için tek bir birleşik pano.

- Birleşik idare: Yöneticiler model izinlerini ve hız sınırlarını doğrudan AI Gateway üzerinden yönetebilir.

Gereksinimler

- AI Gateway (Beta) önizlemesi hesabınız için etkinleştirildi.

- AI Gateway (Beta) tarafından desteklenen bir bölgede Azure Databricks çalışma alanı.

- Çalışma alanınız için Unity Kataloğu etkinleştirildi. Bkz. Unity Kataloğu için bir çalışma alanını etkinleştirme.

Desteklenen ajanlar

Aşağıdaki kodlama aracıları desteklenir:

Kurulum

Cursor

İmleci yapay zeka ağ geçidi uç noktalarını kullanacak şekilde yapılandırmak için:

1. Adım: Temel URL'yi ve API anahtarını yapılandırma

İmleç'i açın ve Ayarlar>İmleç Ayarları>Modelleri>API Anahtarları'na gidin.

OpenAI Temel URL'sini Aşma'yı etkinleştir ve URL'yi gir:

https://<ai-gateway-url>/cursor/v1AI Gateway uç nokta URL'nizi

<ai-gateway-url>ile değiştirin.Azure Databricks kişisel erişim belirtecinizi OpenAI API Anahtarı alanına yapıştırın.

2. Adım: Özel modeller ekleme

- İmleç Ayarları'nda + Özel Model Ekle'ye tıklayın.

- AI Gateway uç adınızı ekleyin ve anahtarı etkinleştirin.

Uyarı

Şu anda yalnızca Azure Databricks tarafından oluşturulan temel model uç noktaları desteklenmektedir.

3. Adım: Tümleştirmeyi test edin

- (macOS) veya

Cmd+L(Windows/Linux) ileCtrl+LAsk modunu açın ve modelinizi seçin. - bir ileti gönderin. Tüm istekler artık Azure Databricks üzerinden yönlendirilir.

Codex CLI

1. Adım: DATABRICKS_TOKEN ortam değişkenini ayarlama

export DATABRICKS_TOKEN=<databricks_pat_token>

2. Adım: Codex istemcisini yapılandırma

Codex yapılandırma dosyasını ~/.codex/config.tomladresinde oluşturun veya düzenleyin:

profile = "default"

[profiles.default]

model_provider = "proxy"

model = "databricks-gpt-5-2"

[model_providers.proxy]

name = "Databricks Proxy"

base_url = "https://<ai-gateway-url>/openai/v1"

env_key = "DATABRICKS_TOKEN"

wire_api = "responses"

AI Gateway uç nokta URL'nizle <ai-gateway-url> değiştirin.

Gemini CLI

1. Adım: Gemini CLI'nin en son sürümünü yükleme

npm install -g @google/gemini-cli@nightly

2. Adım: Ortam değişkenlerini yapılandırma

Bir dosya ~/.gemini/.env oluşturun ve aşağıdaki yapılandırmayı ekleyin. Daha fazla ayrıntı için gemini CLI kimlik doğrulama belgelerine bakın.

GEMINI_MODEL=databricks-gemini-2-5-flash

GOOGLE_GEMINI_BASE_URL=https://<ai-gateway-url>/gemini

GEMINI_API_KEY_AUTH_MECHANISM="bearer"

GEMINI_API_KEY=<databricks_pat_token>

<ai-gateway-url> ile AI Gateway uç nokta URL'nizi ve <databricks_pat_token> ile kişisel erişim belirtecinizi değiştirin.

Claude Code

1. Adım: Claude Code istemcisini yapılandırma

aşağıdaki yapılandırmayı öğesine ~/.claude/settings.jsonekleyin. Daha fazla ayrıntı için Claude Code ayarları belgelerine bakın.

{

"env": {

"ANTHROPIC_MODEL": "databricks-claude-opus-4-6",

"ANTHROPIC_BASE_URL": "https://<ai-gateway-url>/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<databricks_pat_token>",

"ANTHROPIC_CUSTOM_HEADERS": "x-databricks-use-coding-agent-mode: true",

"CLAUDE_CODE_DISABLE_EXPERIMENTAL_BETAS": "1"

}

}

<ai-gateway-url> değerini AI Gateway uç nokta URL'nizle ve <databricks_pat_token> kişisel erişim belirtecinizle değiştirin.

2. Adım (isteğe bağlı): OpenTelemetry ölçüm koleksiyonunu ayarlama

Ölçümleri ve günlükleri Claude Code'dan Unity Kataloğu yönetilen Delta tablolarına aktarma hakkında ayrıntılı bilgi için bkz. OpenTelemetry veri toplamayı ayarlama .

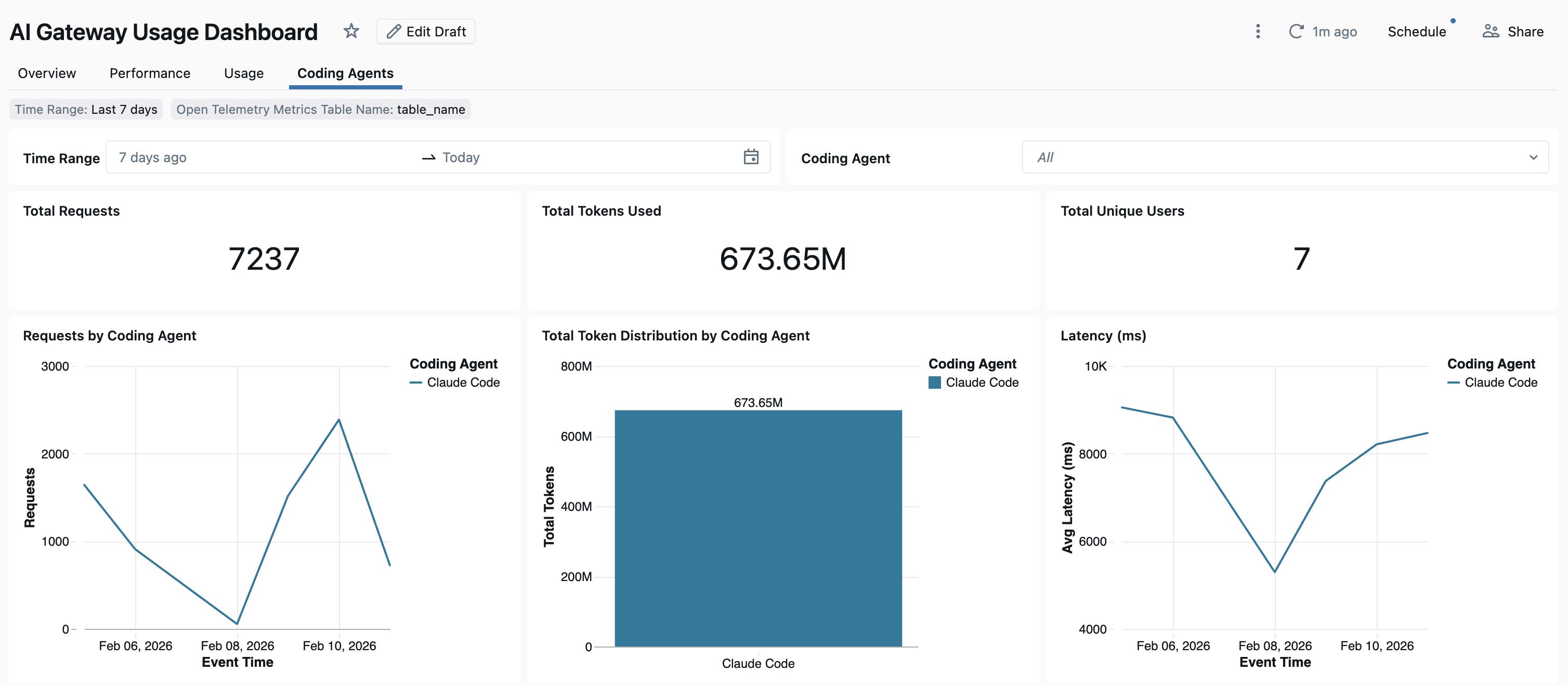

Dashboard

Kodlama aracısı kullanımı AI Gateway aracılığıyla izlendikten sonra, ölçümlerinizi kullanıma hazır panoda görüntüleyebilir ve izleyebilirsiniz.

Panoya erişmek için AI Gateway sayfasında Panoyu görüntüle'yi seçin. Bu, kodlama aracı kullanımı için grafikler içeren önceden yapılandırılmış bir pano oluşturur.

OpenTelemetry veri toplama sürecini ayarlama

Azure Databricks, OpenTelemetry ölçümlerini ve günlüklerini Claude Code'dan Unity Kataloğu yönetilen Delta tablolarına aktarmayı destekler. Tüm ölçümler OpenTelemetry standart ölçüm protokolü kullanılarak dışarı aktarılan zaman serisi verileridir ve günlükler OpenTelemetry günlükleri protokolü kullanılarak dışarı aktarılır. Kullanılabilir ölçümler ve olaylar için Claude Code kullanımını izleme bölümüne bakın.

Gereksinimler

- Azure Databricks önizlemesinde OpenTelemetry etkinleştirildi. Bkz. Azure Databricks önizlemelerini yönetme.

1. Adım: Unity Kataloğu'nda OpenTelemetry tabloları oluşturma

OpenTelemetry ölçümleri ve günlük şemaları ile önceden yapılandırılmış Unity Catalog tarafından yönetilen tablolar oluşturun.

Ölçümler tablosu

CREATE TABLE <catalog>.<schema>.<table_prefix>_otel_metrics (

name STRING,

description STRING,

unit STRING,

metric_type STRING,

gauge STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

value: DOUBLE,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT

>,

sum STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

value: DOUBLE,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT,

aggregation_temporality: STRING,

is_monotonic: BOOLEAN

>,

histogram STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

bucket_counts: ARRAY<LONG>,

explicit_bounds: ARRAY<DOUBLE>,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT,

min: DOUBLE,

max: DOUBLE,

aggregation_temporality: STRING

>,

exponential_histogram STRUCT<

attributes: MAP<STRING, STRING>,

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

scale: INT,

zero_count: LONG,

positive_bucket: STRUCT<

offset: INT,

bucket_counts: ARRAY<LONG>

>,

negative_bucket: STRUCT<

offset: INT,

bucket_counts: ARRAY<LONG>

>,

flags: INT,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

min: DOUBLE,

max: DOUBLE,

zero_threshold: DOUBLE,

aggregation_temporality: STRING

>,

summary STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

quantile_values: ARRAY<STRUCT<

quantile: DOUBLE,

value: DOUBLE

>>,

attributes: MAP<STRING, STRING>,

flags: INT

>,

metadata MAP<STRING, STRING>,

resource STRUCT<

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

resource_schema_url STRING,

instrumentation_scope STRUCT<

name: STRING,

version: STRING,

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

metric_schema_url STRING

) USING DELTA

TBLPROPERTIES (

'otel.schemaVersion' = 'v1'

)

Günlükler tablosu

CREATE TABLE <catalog>.<schema>.<table_prefix>_otel_logs (

event_name STRING,

trace_id STRING,

span_id STRING,

time_unix_nano LONG,

observed_time_unix_nano LONG,

severity_number STRING,

severity_text STRING,

body STRING,

attributes MAP<STRING, STRING>,

dropped_attributes_count INT,

flags INT,

resource STRUCT<

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

resource_schema_url STRING,

instrumentation_scope STRUCT<

name: STRING,

version: STRING,

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

log_schema_url STRING

) USING DELTA

TBLPROPERTIES (

'otel.schemaVersion' = 'v1'

)

2. Adım: Claude Code ayarlar dosyasını güncelleştirme

Ölçümleri ve günlükleri dışarı aktarmayı env etkinleştirmek için dosyanızdaki ~/.claude/settings.json bloğuna aşağıdaki ortam değişkenlerini ekleyin:

{

"env": {

"CLAUDE_CODE_ENABLE_TELEMETRY": "1",

"OTEL_METRICS_EXPORTER": "otlp",

"OTEL_EXPORTER_OTLP_METRICS_PROTOCOL": "http/protobuf",

"OTEL_EXPORTER_OTLP_METRICS_ENDPOINT": "https://<workspace-url>/api/2.0/otel/v1/metrics",

"OTEL_EXPORTER_OTLP_METRICS_HEADERS": "content-type=application/x-protobuf,Authorization=Bearer <databricks_pat_token>,X-Databricks-UC-Table-Name=<catalog>.<schema>.<table_prefix>_otel_metrics",

"OTEL_METRIC_EXPORT_INTERVAL": "10000",

"OTEL_LOGS_EXPORTER": "otlp",

"OTEL_EXPORTER_OTLP_LOGS_PROTOCOL": "http/protobuf",

"OTEL_EXPORTER_OTLP_LOGS_ENDPOINT": "https://<workspace-url>/api/2.0/otel/v1/logs",

"OTEL_EXPORTER_OTLP_LOGS_HEADERS": "content-type=application/x-protobuf,Authorization=Bearer <databricks_pat_token>,X-Databricks-UC-Table-Name=<catalog>.<schema>.<table_prefix>_otel_logs",

"OTEL_LOGS_EXPORT_INTERVAL": "5000"

}

}

Aşağıdakileri değiştirin:

-

<workspace-url>azure Databricks çalışma alanı URL'nizle birlikte. -

<databricks_pat_token>kişisel erişim belirtecinizle. -

<catalog>.<schema>.<table_prefix>OpenTelemetry tablolarını oluştururken kullanılan katalog, şema ve tablo ön eki ile.

Uyarı

Varsayılan OTEL_METRIC_EXPORT_INTERVAL değer 60000 ms (60 saniye) olarak ayarlanır. Yukarıdaki örnekte 10000 ms (10 saniye) olarak ayarlanır. Varsayılan OTEL_LOGS_EXPORT_INTERVAL değer 5000 ms (5 saniye) olarak ayarlanır.

3. Adım: Claude Code'u çalıştırma

claude

Verileriniz 5 dakika içinde Unity Kataloğu tablolarına yayılmalıdır.