Kümeleri yönetme

Bu makalede, Azure Databricks kümelerini görüntüleme, düzenleme, başlatma, sonlandırma, silme, erişimi denetleme ve performans ile günlükleri izleme gibi işlemlerin nasıl yönetileceğini açıklanmaktadır.

Kümeleri görüntüleme

Çalışma alanınızdaki kümeleri görüntülemek için kenar çubuğunda İşlem'e tıklayın![]() .

.

Sol tarafta kümenin sabitlenip sabitlenmediğini ve kümenin durumunu gösteren iki sütun bulunur. Daha fazla bilgi edinmek için durumun üzerine gelin.

Kümeyi sabitleme

Küme sonlandırıldıktan 30 gün sonra kalıcı olarak silinir. Bir küme 30 günden uzun süre sonlandırıldıktan sonra tüm amaçlı küme yapılandırmasını korumak için, yönetici kümeyi sabitleyebilir. En fazla 100 küme sabitlenebilir.

Yönetici, sabitle simgesine tıklayarak küme listesinden veya küme ayrıntı sayfasından bir kümeyi sabitleyebilir.

Kümeyi program aracılığıyla sabitlemek için Kümeler API'sinin uç noktasını da çağırabilirsiniz.

Küme yapılandırmasını JSON dosyası olarak görüntüleme

Bazen küme yapılandırmanızı JSON olarak görüntülemek yararlı olabilir. Bu özellikle Kümeler API'sini kullanarak benzer kümeler oluşturmak istediğinizde kullanışlıdır. Mevcut bir kümeyi görüntülediğinizde Yapılandırma sekmesine gidin, sekmenin sağ üst kısmındaki JSON'a tıklayın, JSON'u kopyalayın ve API çağrınıza yapıştırın. JSON görünümü salt okunurdur.

Kümeyi düzenleme

Küme ayrıntılarının kullanıcı arabiriminden bir küme yapılandırmasını düzenleyebilirsiniz. Kümeyi program aracılığıyla düzenlemek için Kümeler API'sinin uç noktasını da çağırabilirsiniz.

Dekont

- Kümeye eklenen not defterleri ve işler, düzenlemeden sonra bağlı kalır.

- Kümede yüklü kitaplıklar düzenlemeden sonra da yüklü kalır.

- Çalışan bir kümenin herhangi bir özniteliğini düzenlerseniz (küme boyutu ve izinleri dışında), kümeyi yeniden başlatmanız gerekir. Bu, şu anda kümeyi kullanan kullanıcıları kesintiye uğratabilir.

- Yalnızca çalışan veya sonlandırılan kümeleri düzenleyebilirsiniz. Bununla birlikte, küme ayrıntıları sayfasında, bu durumlarda olmayan kümeler için izinleri güncelleştirebilirsiniz.

Küme kopyalama

Var olan bir kümeyi kopyalamak için kümenin kebap menüsünden Kopyala'yı seçin (üç noktalı menü olarak da bilinir).

seçin (üç noktalı menü olarak da bilinir).

Kopyalama'yı seçtikten sonra, küme oluşturma kullanıcı arabirimi küme yapılandırmasıyla önceden doldurulmuş olarak açılır. Aşağıdaki öznitelikler kopyaya dahil değildir:

- Küme izinleri

- Yüklü kitaplıklar

- Ekli not defterleri

Kümelere erişimi denetleme

Yönetici ayarları sayfasındaki küme erişimi denetimi, çalışma alanı yöneticilerinin diğer kullanıcılara ayrıntılı küme erişimi vermesini sağlar. İki tür küme erişim denetimi vardır:

- Küme oluşturma izni: Çalışma alanı yöneticileri hangi kullanıcıların küme oluşturmasına izin verileceğini seçebilir.

- Küme düzeyinde izinler: Küme için Yönetebilir iznine sahip bir kullanıcı, diğer kullanıcıların bu kümeye ekleyip ekleyemeyeceğini, kümeyi yeniden başlatıp yeniden boyutlandıramayacağını, yeniden boyutlandırıp yönetemeyeceğini yapılandırabilir.

Bir kümenin izinlerini düzenlemek için o kümenin kebap menüsünden İzinleri Düzenle'yi seçin.

seçin.

Küme erişim denetimi ve küme düzeyi izinleri hakkında daha fazla bilgi için bkz . Küme erişim denetimi.

Kümeyi sonlandırma

Küme kaynaklarını kaydetmek için bir kümeyi sonlandırabilirsiniz. Sonlandırılan kümenin yapılandırması, daha sonra yeniden kullanılabilmesi (veya işler söz konusu olduğunda otomatik olarak başlatılabilmesi) için depolanır. Bir kümeyi el ile sonlandırabilir veya kümeyi belirli bir süre etkinlik dışı kalma süresinden sonra otomatik olarak sonlandıracak şekilde yapılandırabilirsiniz. Sonlandırılan küme sayısı 150'yi aştığında, en eski kümeler silinir.

Küme sabitlenmediği veya yeniden başlatılmadığı sürece, sonlandırmadan 30 gün sonra otomatik ve kalıcı olarak silinir.

Sonlandırılan kümeler küme listesinde, küme adının solunda gri bir daireyle gösterilir.

Dekont

Yeni İş Kümesinde bir iş çalıştırdığınızda (genellikle önerilir), iş tamamlandığında küme sonlandırılır ve yeniden başlatılamaz. Öte yandan, sonlandırılan mevcut bir Tüm Amaçlı Kümede çalışacak bir iş zamanlarsanız, bu küme otomatik olarak başlayacaktır.

Önemli

Deneme Premium çalışma alanı kullanıyorsanız, çalışan tüm kümeler sonlandırılır:

- Bir çalışma alanını tam Premium'a yükselttiğiniz zaman.

- Çalışma alanı yükseltilmediyse ve deneme süresinin dolması durumunda.

El ile sonlandırma

Küme listesinden (kümenin satırındaki kareye tıklayarak) veya küme ayrıntı sayfasından (Sonlandır'a tıklayarak) bir kümeyi el ile sonlandırabilirsiniz.

Otomatik sonlandırma

Küme için otomatik sonlandırma da ayarlayabilirsiniz. Küme oluşturma sırasında, kümenin sonlandırılmasını istediğiniz etkinlik dışı süreyi dakikalar içinde belirtebilirsiniz.

Geçerli saat ile kümedeki son komut çalıştırması arasındaki fark belirtilen etkinlik dışı süreden fazlaysa, Azure Databricks bu kümeyi otomatik olarak sonlandırır.

Spark işleri, Yapılandırılmış Akış ve JDBC çağrıları dahil olmak üzere kümedeki tüm komutlar yürütmeyi bitirdiğinde kümenin etkin olmadığı kabul edilir.

Uyarı

- Kümeler D Akışlar kullanımından kaynaklanan etkinliği raporlamaz. Bu, otomatik sonlandırıcı bir kümenin D Akışlar çalıştırırken sonlandırılabileceği anlamına gelir. D Akışlar çalıştıran kümeler için otomatik sonlandırmayı kapatın veya Yapılandırılmış Akış kullanmayı göz önünde bulundurun.

- Otomatik sonlandırma özelliği yalnızca Spark işlerini izler, kullanıcı tanımlı yerel işlemleri izlemez. Bu nedenle, tüm Spark işleri tamamlandıysa, yerel işlemler çalışıyor olsa bile bir küme sonlandırılabilir.

- Boştaki kümeler, sonlandırmadan önceki işlem yapılmadığı süre boyunca DBU ve bulut örneği ücretlerini biriktirmeye devam eder.

Otomatik sonlandırmayı yapılandırma

Küme oluşturma kullanıcı arabiriminde otomatik sonlandırmayı yapılandırabilirsiniz. Kutunun işaretli olduğundan emin olun ve işlem yapılmadan geçen dakika ___'den sonra sonlandır ayarına dakika sayısını girin.

Otomatik Sonlandırma onay kutusunu temizleyerek veya etkinlik dışı bir süre 0belirterek otomatik sonlandırmayı geri çevirebilirsiniz.

Dekont

Otomatik sonlandırma en son Spark sürümlerinde en iyi şekilde desteklenir. Eski Spark sürümleri, küme etkinliğinin yanlış raporlanmasıyla sonuçlanabilecek bilinen sınırlamalara sahiptir. Örneğin, JDBC, R veya akış komutlarını çalıştıran kümeler, kümenin erken sonlandırılmasına yol açan eski bir etkinlik süresi bildirebilir. Hata düzeltmeleri ve otomatik sonlandırma iyileştirmelerinden yararlanmak için lütfen en son Spark sürümüne yükseltin.

Beklenmeyen sonlandırma

Bazen bir küme el ile sonlandırma veya yapılandırılmış otomatik sonlandırma nedeniyle değil beklenmedik şekilde sonlandırılır.

Sonlandırma nedenlerinin ve düzeltme adımlarının listesi için bkz . Bilgi Bankası.

Küme silme

Kümenin silinmesi, kümeyi sonlandırır ve yapılandırmasını kaldırır. Bir kümeyi silmek için kümenin menüsünde Sil'i seçin.

seçin.

Uyarı

Bu eylemi geri alamazsınız.

Sabitlenmiş bir kümeyi silmek için önce bir yönetici tarafından kaldırılmalıdır.

Kümeyi program aracılığıyla silmek için Kümeler API'sinin uç noktasını da çağırabilirsiniz.

Kümeyi yeniden başlatma

Daha önce sonlandırılan bir kümeyi küme listesinden, küme ayrıntı sayfasından veya not defterinden yeniden başlatabilirsiniz. Kümeyi program aracılığıyla başlatmak için Kümeler API'sinin uç noktasını da çağırabilirsiniz.

Azure Databricks, bir kümeyi benzersiz küme kimliğini kullanarak tanımlar. Sonlandırılan bir kümeyi başlattığınızda Databricks kümeyi aynı kimlikle yeniden oluşturur, tüm kitaplıkları otomatik olarak yükler ve not defterlerini yeniden ekler.

Dekont

Deneme çalışma alanı kullanıyorsanız ve deneme süresinin dolması durumunda küme başlatamazsınız.

Kümeyi en son görüntülerle güncelleştirmek için yeniden başlatın

Bir kümeyi yeniden başlattığınızda işlem kaynağı kapsayıcıları ve VM konakları için en son görüntüleri alır. Akış verilerini işlemek için kullanılan kümeler gibi uzun süre çalışan kümeler için düzenli yeniden başlatmalar zamanlamak önemlidir.

Görüntüyü en son görüntü sürümüyle güncel tutmak için tüm işlem kaynaklarını düzenli olarak yeniden başlatmak sizin sorumluluğunuzdadır.

Önemli

Hesabınız veya çalışma alanınız için uyumluluk güvenlik profilini etkinleştirirseniz, uzun süre çalışan kümeler 25 gün sonra otomatik olarak yeniden başlatılır. Databricks, çalışma alanı yöneticilerinin zamanlanmış bir bakım penceresi sırasında kümeleri el ile yeniden başlatmalarını önerir. Bu, otomatik yeniden başlatmanın zamanlanmış işi kesintiye uğratma riskini azaltır.

Not defteri örneği: Uzun süre çalışan kümeleri bulma

Çalışma alanı yöneticisiyseniz, kümelerinizin her birinin ne kadar süreyle çalıştığını belirleyen bir betik çalıştırabilir ve isteğe bağlı olarak, belirtilen gün sayısından daha eskiyse bunları yeniden başlatabilirsiniz. Azure Databricks bu betiği not defteri olarak sağlar.

Betiğin ilk satırları yapılandırma parametrelerini tanımlar:

min_age_output: Kümenin çalıştırabileceği en fazla gün sayısı. Varsayılan değer 1'dir.perform_restart: iseTrue, betik tarafından belirtilenmin_age_outputgün sayısından büyük yaşlara sahip kümeleri yeniden başlatır. Varsayılan değer, uzun süre çalışan kümeleri tanımlayan ancak yeniden başlatmayan şeklindedirFalse.secret_configuration: veREPLACE_WITH_KEYdeğerini bir gizli kapsam ve anahtar adıyla değiştirinREPLACE_WITH_SCOPE. Gizli dizileri ayarlama hakkında daha fazla bilgi için not defterine bakın.

Uyarı

olarak Trueayarlarsanızperform_restart, betik uygun kümeleri otomatik olarak yeniden başlatır ve bu da etkin işlerin başarısız olmasına ve açık not defterlerini sıfırlamasına neden olabilir. Çalışma alanınızın iş açısından kritik işlerini kesintiye uğratma riskini azaltmak için zamanlanmış bir bakım penceresi planlayın ve çalışma alanı kullanıcılarına bildirmeyi unutmayın.

Uzun süre çalışan kümeler not defterini tanımlama ve isteğe bağlı olarak yeniden başlatma

İşler ve JDBC/ODBC sorguları için küme otomatik başlangıcı

Sonlandırılan kümeye atanan bir işin çalışması zamanlandığında veya JDBC/ODBC arabiriminden sonlandırılan bir kümeye bağlandığınızda, küme otomatik olarak yeniden başlatılır. Bkz. İş oluşturma ve JDBC bağlantısı.

Küme otomatik başlangıcı, zamanlanmış işler için kümeleri yeniden başlatmak için el ile müdahaleye gerek kalmadan kümeleri otomatik olarak sonlandıracak şekilde yapılandırmanıza olanak tanır. Ayrıca, sonlandırılan bir kümede çalışmak üzere bir iş zamanlayarak küme başlatma zamanlayabilirsiniz.

Küme otomatik olarak yeniden başlatılmadan önce küme ve iş erişim denetimi izinleri denetleniyor.

Dekont

Kümeniz Azure Databricks platform sürüm 2.70 veya önceki bir sürümde oluşturulduysa, otomatik başlangıç yoktur: sonlandırılan kümelerde çalışmak üzere zamanlanan işler başarısız olur.

Apache Spark kullanıcı arabiriminde küme bilgilerini görüntüleme

Küme ayrıntıları sayfasında Spark kullanıcı arabirimi sekmesini seçerek Spark işleri hakkındaki ayrıntılı bilgileri görüntüleyebilirsiniz.

Sonlandırılmış bir kümeyi yeniden başlatırsanız, Spark kullanıcı arabirimi sonlandırılmış kümenin geçmiş bilgilerini değil yeniden başlatılan küme hakkındaki bilgileri görüntüler.

Küme günlüklerini görüntüleme

Azure Databricks, kümeyle ilgili etkinliğin üç tür günlüğe kaydedilmesini sağlar:

- Oluşturma, sonlandırma ve yapılandırma düzenlemeleri gibi küme yaşam döngüsü olaylarını yakalayan küme olay günlükleri.

- Hata ayıklama için kullanabileceğiniz Apache Spark sürücüsü ve çalışan günlüğü.

- Init betiklerinde hata ayıklamak için değerli olan küme başlatma betiği günlükleri.

Bu bölümde küme olay günlükleri, sürücü ve çalışan günlükleri ele alınmaktadır. Init-script günlükleri hakkında ayrıntılı bilgi için bkz . Init betik günlüğü.

Küme olay günlükleri

Küme olay günlüğü, kullanıcı eylemleri tarafından el ile veya Azure Databricks tarafından otomatik olarak tetiklenen önemli küme yaşam döngüsü olaylarını görüntüler. Bu gibi olaylar bir bütün olarak küme işlemlerini ve kümede çalıştırılan işleri etkiler.

Desteklenen olay türleri için bkz. Kümeler API'sinin veri yapısı.

Olaylar 60 gün boyunca depolanır ve bu süre Azure Databricks'teki diğer veri saklama süreleriyle karşılaştırılabilir.

Küme olay günlüğünü görüntüleme

Kümenin olay günlüğünü görüntülemek için küme ayrıntıları sayfalarında Olay günlüğü sekmesini seçin.

Bir olay hakkında daha fazla bilgi için günlükteki satırına tıklayın ve ardından ayrıntılar için JSON sekmesine tıklayın.

Küme sürücüsü ve çalışan günlükleri

Not defterlerinizden, işlerinizden ve kitaplıklarınızdan doğrudan yazdırma ve günlük deyimleri Spark sürücü günlüklerine gider. Bu günlük dosyalarına küme ayrıntıları sayfasındaki Sürücü günlükleri sekmesinden erişebilirsiniz. İndirmek için günlük dosyasının adına tıklayın.

Bu günlüklerin üç çıkışı vardır:

- Standart çıktı

- Standart hata

- Log4j günlükleri

Spark çalışan günlüklerini görüntülemek için Spark kullanıcı arabirimi sekmesini kullanın. Küme için günlük teslim konumunu da yapılandırabilirsiniz. Hem çalışan hem de küme günlükleri belirttiğiniz konuma teslim edilir.

Performansı izleme

Azure Databricks kümelerinin performansını izlemenize yardımcı olmak için Azure Databricks, küme ayrıntıları sayfasından ölçümlere erişim sağlar. Databricks Runtime 12.2 ve altı için Azure Databricks, Ganglia ölçümlerine erişim sağlar. Databricks Runtime 13.0 ve üzeri için küme ölçümleri Azure Databricks tarafından sağlanır.

Ayrıca, Azure için izleme platformu olan Azure İzleyici’deki bir Log Analytics çalışma alanına ölçümler göndermek için bir Azure Databricks kümesi yapılandırabilirsiniz.

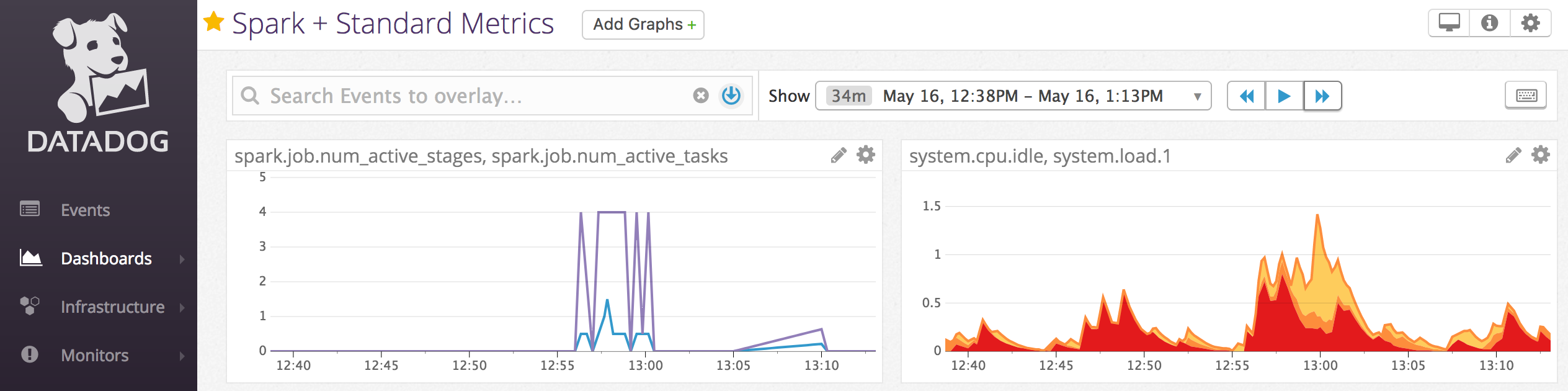

Datadog ölçümlerini Datadog hesabınıza göndermek için küme düğümlerine Datadog aracıları da yükleyebilirsiniz.

Küme ölçümleri

Küme ölçümleri Databricks Runtime 13.0 ve üzeri için varsayılan izleme aracıdır. Küme ölçümleri kullanıcı arabirimine erişmek için küme ayrıntıları sayfasındaki Ölçümler sekmesine gidin.

Tarih seçici filtresini kullanarak bir zaman aralığı seçerek geçmiş ölçümleri görüntüleyebilirsiniz. Ölçümler dakikada bir toplanır. Yenile düğmesine tıklayarak da en son ölçümleri alabilirsiniz. Daha fazla bilgi için bkz. Canlı ve geçmiş küme ölçümlerini görüntüleme.

Ganglia ölçümleri

Dekont

Ganglia ölçümleri yalnızca Databricks Runtime 12.2 ve altında kullanılabilir.

Ganglia kullanıcı arabirimine erişmek için küme ayrıntıları sayfasındaki Ölçümler sekmesine gidin. CPU ölçümleri tüm Databricks çalışma zamanları için Ganglia kullanıcı arabiriminde kullanılabilir. GPU ölçümleri GPU özellikli kümeler için kullanılabilir.

Canlı ölçümleri görüntülemek için Ganglia Kullanıcı Arabirimi bağlantısına tıklayın.

Geçmiş ölçümleri görüntülemek için bir anlık görüntü dosyasına tıklayın. Anlık görüntü, seçilen saatten önceki saatin toplam ölçümlerini içerir.

Dekont

Ganglia, Docker kapsayıcıları ile desteklenmez. Kümenizle bir Docker kapsayıcısı kullanırsanız Ganglia ölçümleri kullanılamaz.

Ganglia ölçüm koleksiyonunu yapılandırma

Azure Databricks, Ganglia ölçümlerini varsayılan olarak 15 dakikada bir toplar. Koleksiyon dönemini yapılandırmak için ortam değişkenini DATABRICKS_GANGLIA_SNAPSHOT_PERIOD_MINUTES bir init betiği kullanarak veya Yeni küme oluşturma API'sindeki spark_env_varsalanda ayarlayın.

Azure İzleyici

Azure Databricks kümesini, Azure'ın izleme platformu olan Azure İzleyici'deki Log Analytics çalışma alanına ölçüm gönderecek şekilde yapılandırabilirsiniz. Tam yönergeler için, bkz. Azure Databricks İzleme.

Dekont

Azure Databricks çalışma alanını kendi sanal ağınıza dağıttıysanız ve Azure Databricks tarafından gerekli olmayan tüm giden trafiği reddedecek şekilde ağ güvenlik gruplarını (NSG) yapılandırdıysanız, "AzureMonitor" hizmet etiketi için ek bir giden kuralı yapılandırmanız gerekir.

Not defteri örneği: Datadog ölçümleri

Datadog ölçümlerini Datadog hesabınıza göndermek için küme düğümlerine Datadog aracıları yükleyebilirsiniz. Aşağıdaki not defteri, küme kapsamlı bir init betiği kullanarak bir kümeye Datadog aracısının nasıl yükleneceğini gösterir.

Datadog aracısını tüm kümelere yüklemek için küme ilkesi kullanarak küme kapsamlı init betiğini yönetin.

Datadog aracısı init betik not defterini yükleme

Spot örneklerinin yetkisini alma

Spot örnekler maliyetleri düşürebileceğinden, isteğe bağlı örnekler yerine spot örnekleri kullanarak küme oluşturmak, işleri çalıştırmanın yaygın bir yoludur. Ancak spot örnekler bulut sağlayıcısı zamanlama mekanizmaları tarafından önlenebilir. Spot örneklerin önalımı, çalışan işlerle ilgili sorunlara neden olabilir, örneğin:

- Karıştırma getirme hataları

- Veri kaybını karıştırma

- RDD veri kaybı

- İş hataları

Bu sorunların giderilmesine yardımcı olmak için yetkiyi alma özelliğini etkinleştirebilirsiniz. Yetkisini alma, bulut sağlayıcısının genellikle spot örneğinin yetkisi olmadan önce gönderdiği bildirimden yararlanır. Yürütücü içeren bir spot örneği bir ön kullanım bildirimi aldığında, yetkisini alma işlemi karıştırma ve RDD verilerini iyi durumdaki yürütücülere geçirmeye çalışır. Bulut sağlayıcısına bağlı olarak, son ön koşuldan önceki süre genellikle 30 saniye ile 2 dakika arasındadır.

Databricks, yetkiyi alma özelliği de etkinleştirildiğinde veri geçişinin etkinleştirilmesini önerir. Genellikle karıştırma getirme hataları, karışık veri kaybı ve RDD veri kaybı gibi daha fazla veri geçirildikçe hata olasılığı azalır. Veri geçişi, daha az yeniden hesaplama ve tasarruf maliyetlerine de yol açabilir.

Dekont

Yetkisini almak en iyi çabadır ve tüm verilerin son ön kullanımdan önce geçirilebileceğini garanti etmez. Görev çalıştırıldığında yürütücüden karıştırma verileri getirilirken, yetkisini alma işlemi karıştırma getirme hatalarına karşı garanti veremez.

Yetkiyi alma etkinleştirildiğinde, spot örnek önalımından kaynaklanan görev hataları toplam başarısız deneme sayısına eklenmez. Önkoşulun neden olduğu görev hataları başarısız denemeler olarak sayılmaz çünkü hatanın nedeni görevin dışındadır ve iş hatasına neden olmaz.

Yetkiyi alma özelliğini etkinleştirme

Bir kümede yetkiyi alma özelliğini etkinleştirmek için, küme yapılandırma kullanıcı arabirimindeki Gelişmiş Seçenekler'in altındaki Spark sekmesine aşağıdaki özellikleri girin. Bu özellikler hakkında bilgi için bkz . Spark yapılandırması.

Uygulamaların yetkisini alma özelliğini etkinleştirmek için Spark yapılandırma alanına şu özelliği girin:

spark.decommission.enabled trueKullanımdan çıkarma sırasında karıştırılan veri geçişini etkinleştirmek için Spark yapılandırma alanına şu özelliği girin:

spark.storage.decommission.enabled true spark.storage.decommission.shuffleBlocks.enabled trueYetkisini alma sırasında RDD önbellek veri geçişini etkinleştirmek için Spark yapılandırma alanına şu özelliği girin:

spark.storage.decommission.enabled true spark.storage.decommission.rddBlocks.enabled trueDekont

RDD Depolama Geliştirme çoğaltması 1'den fazla olarak ayarlandığında, çoğaltmalar RDD'lerin veri kaybetmemesini sağladığından Databricks RDD veri geçişini etkinleştirmenizi önermez.

Çalışanların yetkisini alma işlemini etkinleştirmek için Ortam Değişkenleri alanına şu özelliği girin:

SPARK_WORKER_OPTS="-Dspark.decommission.enabled=true"

Kullanıcı arabiriminde yetki alma durumunu ve kayıp nedenini görüntüleme

Kullanıcı arabiriminden bir çalışanın yetkisini alma durumuna erişmek için Spark Kümesi Kullanıcı Arabirimi - Ana sekmesine gidin.

Yetki alma işlemi tamamlandığında, yürütücüsü kayıp nedenini küme ayrıntıları sayfasındaki Spark UI > Yürütücüleri sekmesinde görüntüleyebilirsiniz.