Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Bu makale, LLMOps iş akışlarına özgü bilgiler ekleyerek Databricks'te MLOps iş akışlarını tamamlar. Daha fazla ayrıntı için Büyük MLOps Kitabı’na bakın.

LLM'ler için MLOps iş akışı nasıl değişir?

LLM'ler açık uçlu soru yanıtlama, özetleme ve yönergeleri yürütme gibi çeşitli görevlerde boyut ve performans açısından öncüllerini önemli ölçüde aşan bir doğal dil işleme (NLP) modeli sınıfıdır.

LLM'lerin geliştirilmesi ve değerlendirilmesi, geleneksel ML modellerinden bazı önemli yollarla farklılık gösterir. Bu bölümde LLM'lerin bazı temel özellikleri ve MLOps üzerindeki etkileri kısaca özetlenebilir.

| LLM'lerin temel özellikleri | MLOps için olası sonuçları |

|---|---|

LLM'ler birçok biçimde kullanılabilir.

|

Geliştirme süreci: Projeler genellikle mevcut, üçüncü taraf veya açık kaynak modellerinden başlayıp özel ince ayarlı modellerle biten artımlı olarak gelişir. |

| Birçok LLM, giriş olarak genel doğal dil sorgularını ve yönergelerini alır. Bu sorgular, istenen yanıtları elde etmek için dikkatle tasarlanmış istemler içerebilir. |

Geliştirme süreci: LLM'leri sorgulamak için metin şablonları tasarlamak genellikle yeni LLM işlem hatları geliştirmenin önemli bir parçasıdır. ML yapıtlarını paketleme: Birçok LLM işlem hattı mevcut LLM'leri veya LLM hizmet uç noktalarını kullanır. Bu işlem hatları için geliştirilen ML mantığı, modelin kendisi yerine istem şablonlarına, aracılara veya zincirlere odaklanabilir. Paketlenen ve üretime aktarılan ML yapıtları, modeller yerine bu işlem hatları olabilir. |

| Birçok LLM'ye, sorguyu yanıtlamaya yardımcı olmak için örnekler, bağlam veya diğer bilgiler içeren istemler verilebilir. | Altyapı sunma: LLM sorgularını bağlamla genişletirken, ilgili bağlamı aramak için vektör dizinleri gibi ek araçlar kullanabilirsiniz. |

| Üçüncü taraf API'ler özel ve açık kaynak modeller sağlar. | API idaresi: Merkezi API idaresini kullanmak, API sağlayıcıları arasında kolayca geçiş yapma olanağı sağlar. |

| LLM'ler genellikle gigabaytlardan yüzlerce gigabayt'a kadar değişen çok büyük derin öğrenme modelleridir. |

Altyapı sunma: LLM'ler gerçek zamanlı model sunma için GPU'lar ve dinamik olarak yüklenmesi gereken modeller için hızlı depolama gerektirebilir. Maliyet/performans dengelemeleri: Daha büyük modeller daha fazla hesaplama gerektirdiğinden ve daha pahalı olduğundan, model boyutunu ve hesaplamayı azaltma teknikleri gerekebilir. |

| Genellikle tek bir "doğru" yanıt olmadığından LLM'lerin geleneksel ML ölçümlerini kullanarak değerlendirilmesi zordur. | İnsan geri bildirimi: llM'lerin değerlendirilmesi ve test edilmesi için insan geri bildirimi gereklidir. Test, izleme ve gelecekteki ince ayarlamalar dahil olmak üzere kullanıcı geri bildirimlerini doğrudan MLOps işlemine dahil etmelisiniz. |

MLOps ve LLMOps arasındaki benzerlikler

MLOps işlemlerinin birçok yönü LLM'ler için değişmez. Örneğin, aşağıdaki yönergeler LLM'ler için de geçerlidir:

- Geliştirme, hazırlama ve üretim için ayrı ortamlar kullanın.

- Sürüm denetimi için Git'i kullanın.

- MLflow ile model geliştirmeyi yönetin ve model yaşam döngüsünü yönetmek için Unity Kataloğu

Modelleri kullanın. - Delta tablolarını kullanarak verileri göl evi mimarisinde depolayın.

- Mevcut CI/CD altyapınız herhangi bir değişiklik gerektirmemelidir.

- MLOps'un modüler yapısı, özellik geliştirme, model eğitimi, model çıkarımı vb. için işlem hatları ile aynı kalır.

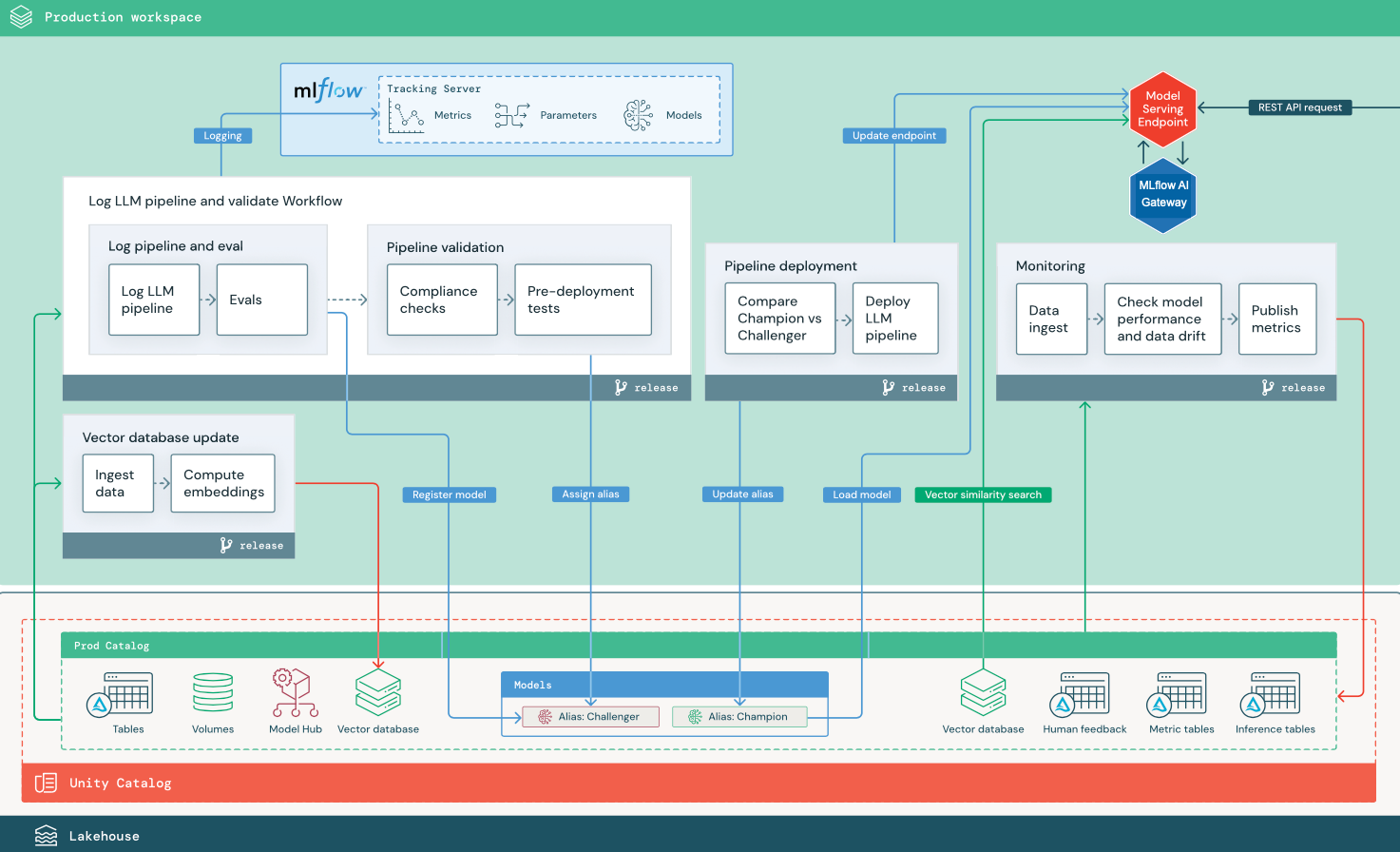

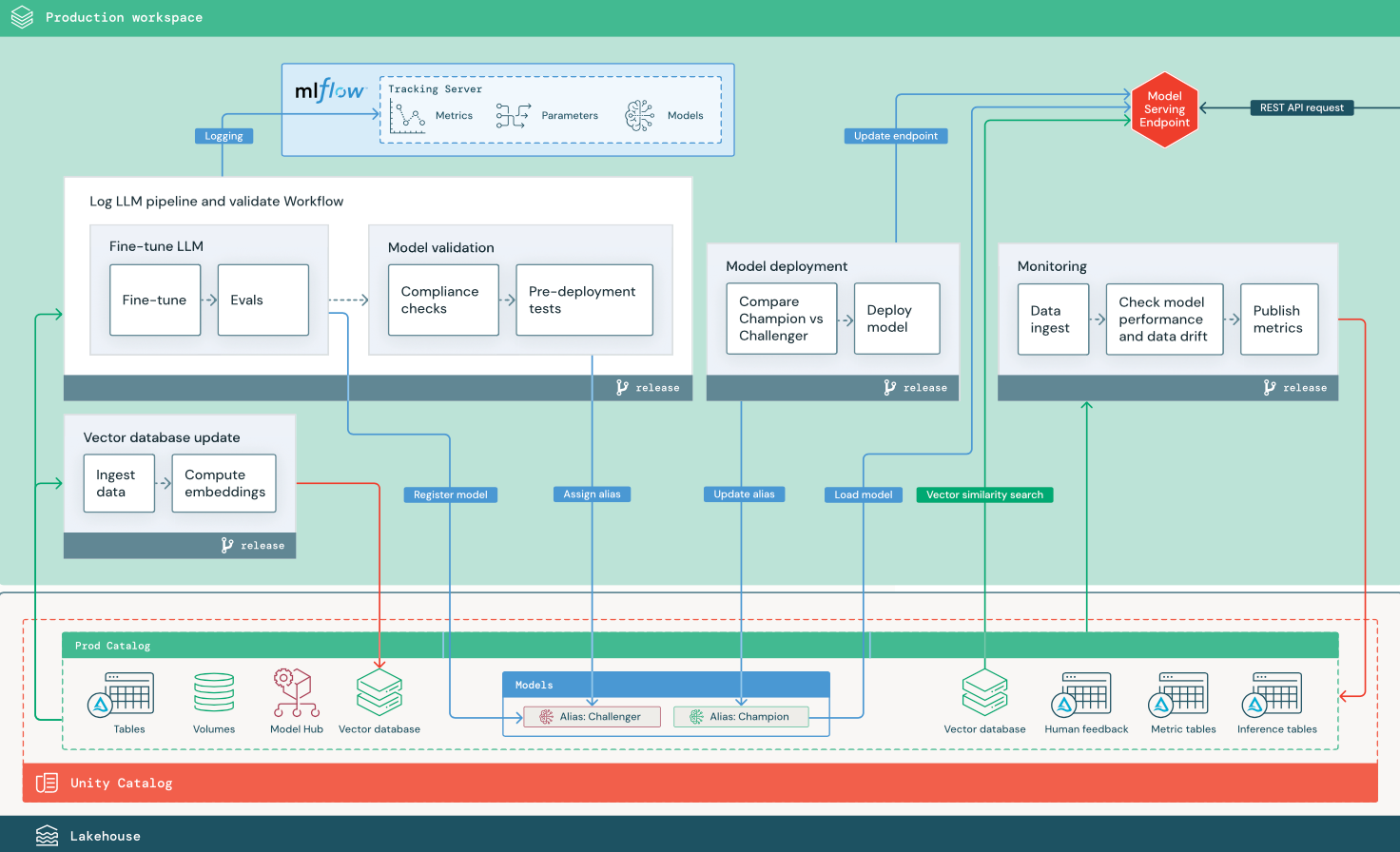

Referans mimarisi diyagramları

Bu bölümde, geleneksel MLOps'un başvuru mimarisinde yapılan bazı ayarlamaları göstermek için iki LLM tabanlı uygulama kullanılır. Diyagramlar, 1) üçüncü taraf API kullanan bir bilgi erişimi artırılmış üretim (RAG) uygulaması ve 2) kendinden barındırılan özel ayarlanmış model kullanan bir RAG uygulaması için üretim mimarisini gösterir. Her iki diyagramda da isteğe bağlı bir vektör veritabanı gösterilir. Bu öğe, Doğrudan Model Sunma uç noktası aracılığıyla LLM sorgulanarak değiştirilebilir.

Üçüncü taraf LLM API'siyle RAG

Diyagramda, Databricks Dış Modelleri kullanarak üçüncü taraf LLM API'sine bağlanan bir RAG uygulaması için üretim mimarisi gösterilmektedir.

İnce ayarlı açık kaynak modeline sahip RAG

Diyagramda, açık kaynak modeline ince ayar sağlayan bir RAG uygulaması için üretim mimarisi gösterilmektedir.

LLMOps, MLOps üretim mimarisinde değişiklik yapar.

Bu bölümde, LLMOps uygulamaları için MLOps başvuru mimarisinde yapılan önemli değişiklikler vurgulanır.

Model merkezi

LLM uygulamaları genellikle bir iç veya dış model hub'ından seçilen mevcut, önceden eğitilmiş modelleri kullanır. Model olduğu gibi veya ince ayarlı olarak kullanılabilir.

Databricks, Unity Kataloğu'nda ve Databricks Market'te yüksek kaliteli, önceden eğitilmiş temel modellerden oluşan bir seçim içerir. Bu önceden eğitilmiş modelleri kullanarak en yeni yapay zeka özelliklerine erişebilir ve kendi özel modellerinizi oluşturmanın zamandan ve masraflarından tasarruf edebilirsiniz. Ayrıntılar için bkz. Unity Kataloğu'ndan üretken yapay zeka ve LLM modellerine erişme.

Vektör dizini

Bazı LLM uygulamaları, hızlı benzerlik aramaları için, örneğin LLM sorgularında bağlam veya etki alanı bilgisi sağlamak için vektör dizinlerini kullanır. Databricks, Unity Kataloğu'ndaki herhangi bir Delta tablosunu vektör dizini olarak kullanmanıza olanak tanıyan tümleşik bir vektör arama işlevi sağlar. Vektör arama dizini Delta tablosuyla otomatik olarak eşitlenir. Ayrıntılar için bkz . Vektör Arama.

Vektör dizininden bilgi almak için mantığı kapsülleyen ve döndürülen verileri LLM bağlamı olarak sağlayan bir model yapıtı oluşturabilirsiniz. Ardından MLflow LangChain veya PyFunc model özelliğini kullanarak modeli günlüğe kaydedebilirsiniz.

LLM'de ince ayar yapma

LLM modelleri sıfırdan oluşturmak pahalı ve zaman alıcı olduğundan, LLM uygulamaları genellikle belirli bir senaryoda performansını artırmak için mevcut modeli ince ayarlar. Başvuru mimarisinde ince ayar ve model dağıtımı ayrı Lakeflow İşleri olarak temsil edilir. Dağıtmadan önce ince ayarlanmış bir modeli doğrulamak genellikle el ile gerçekleştirilen bir işlemdir.

Databricks, sizin verilerinizi kullanarak mevcut bir LLM'yi özelleştirip özel uygulamanızın performansını optimize etmeniz için Temel Model İnce Ayarı sağlar. Ayrıntılar için bkz . Temel Modelde İnce Ayarlama.

Model sunumu

Üçüncü taraf API kullanan RAG senaryosunda önemli bir mimari değişiklik, LLM işlem hattının Model Sunma uç noktasından iç veya üçüncü taraf LLM API'lerine dış API çağrıları yapmasıdır. Bu, karmaşıklık, olası gecikme süresi ve ek kimlik bilgisi yönetimi ekler.

Databricks, yapay zeka modellerini dağıtmak, idare etmek ve sorgulamak için birleşik bir arabirim sağlayan Mozaik Yapay Zeka Modeli Sunma sunar. Ayrıntılar için bkz . Mozaik Yapay Zeka Modeli Sunma.

İzleme ve değerlendirmede insan geri bildirimi

çoğu LLM uygulamasında insan geri bildirim döngüleri gereklidir. İnsan geri bildirimleri, diğer veriler gibi yönetilmeli ve ideal olarak neredeyse gerçek zamanlı akışa dayalı izlemeyle entegre edilmelidir.

MLflow gözden geçirme uygulaması, insan gözden geçirenlerden geri bildirim toplamanıza yardımcı olur. Ayrıntılar için bkz. İnsan geri bildirimi.