HBv2 serisi sanal makine boyutları

Şunlar için geçerlidir: ✔️ Linux VM'leri ✔️ Windows VM'leri ✔️ Esnek ölçek kümeleri ✔️ Tekdüzen ölçek kümeleri

HBv2 serisi boyutundaki VM'lerde çeşitli performans testleri çalıştırılmıştır. Bu performans testinin sonuçlarından bazıları aşağıdadır.

| İş Yükü | HBv2 |

|---|---|

| STREAM Triad | 350 GB/sn (CCX başına 21-23 GB/sn) |

| Yüksek Performanslı Linpack (HPL) | 4 TeraFLOPS (Rpeak, FP64), 8 TeraFLOPS (Rmax, FP32) |

| RDMA gecikme süresi ve bant genişliği | 1,2 mikrosaniye, 190 Gb/sn |

| Yerel NVMe SSD üzerinde FIO | 2,7 GB/sn okuma, 1,1 GB/sn yazma; 102k IOPS okuma, 115 IOPS yazma |

| IOR on 8 * Azure Premium SSD (P40 Yönetilen Diskler, RAID0)** | 1,3 GB/sn okuma, 2,5 GB/yazma; 101k IOPS okuma, 105k IOPS yazma |

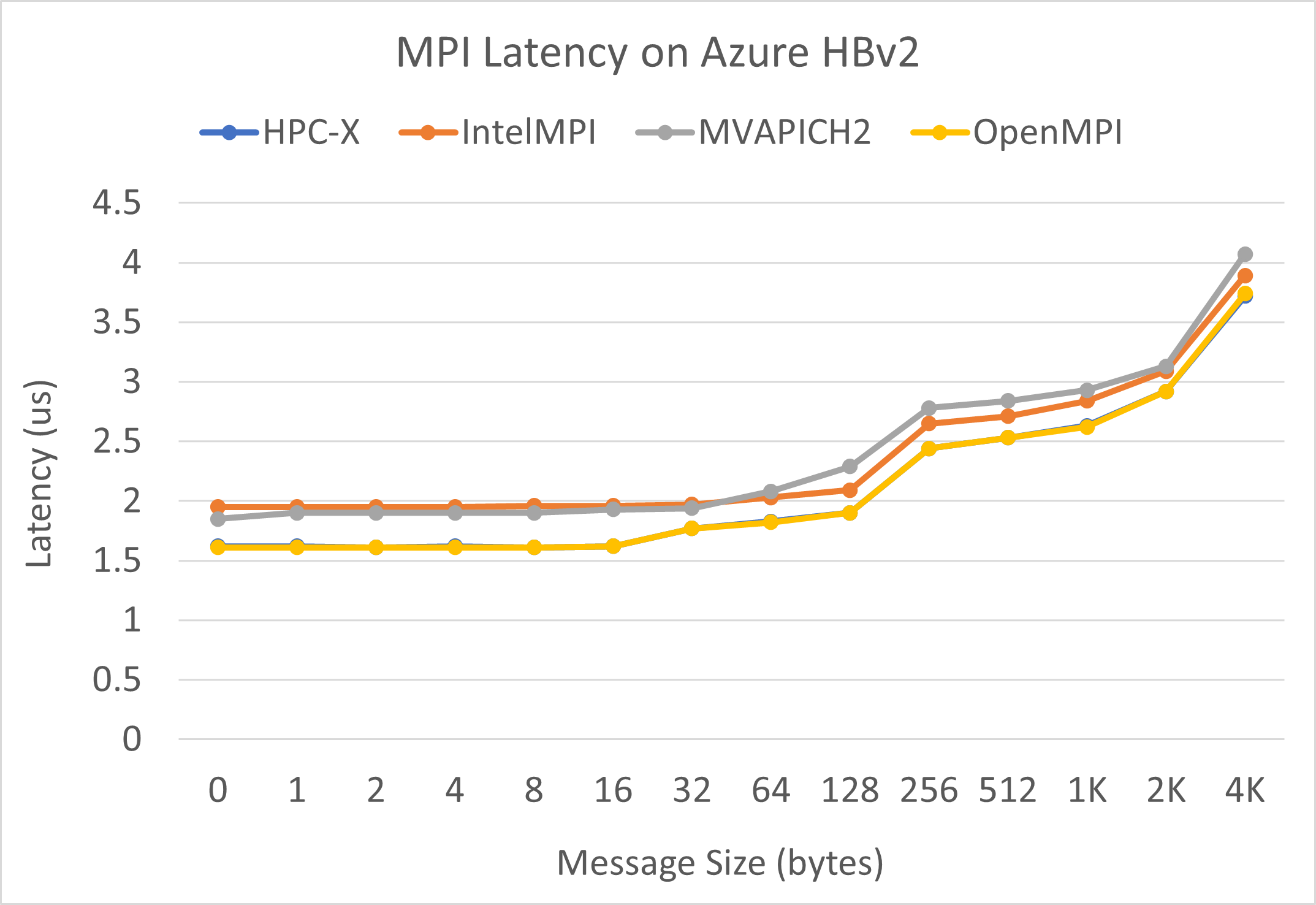

MPI gecikme süresi

OSU microbenchmark paketinden MPI gecikme süresi testi çalıştırılır. Örnek betikler GitHub'da bulunur.

./bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./osu_latency

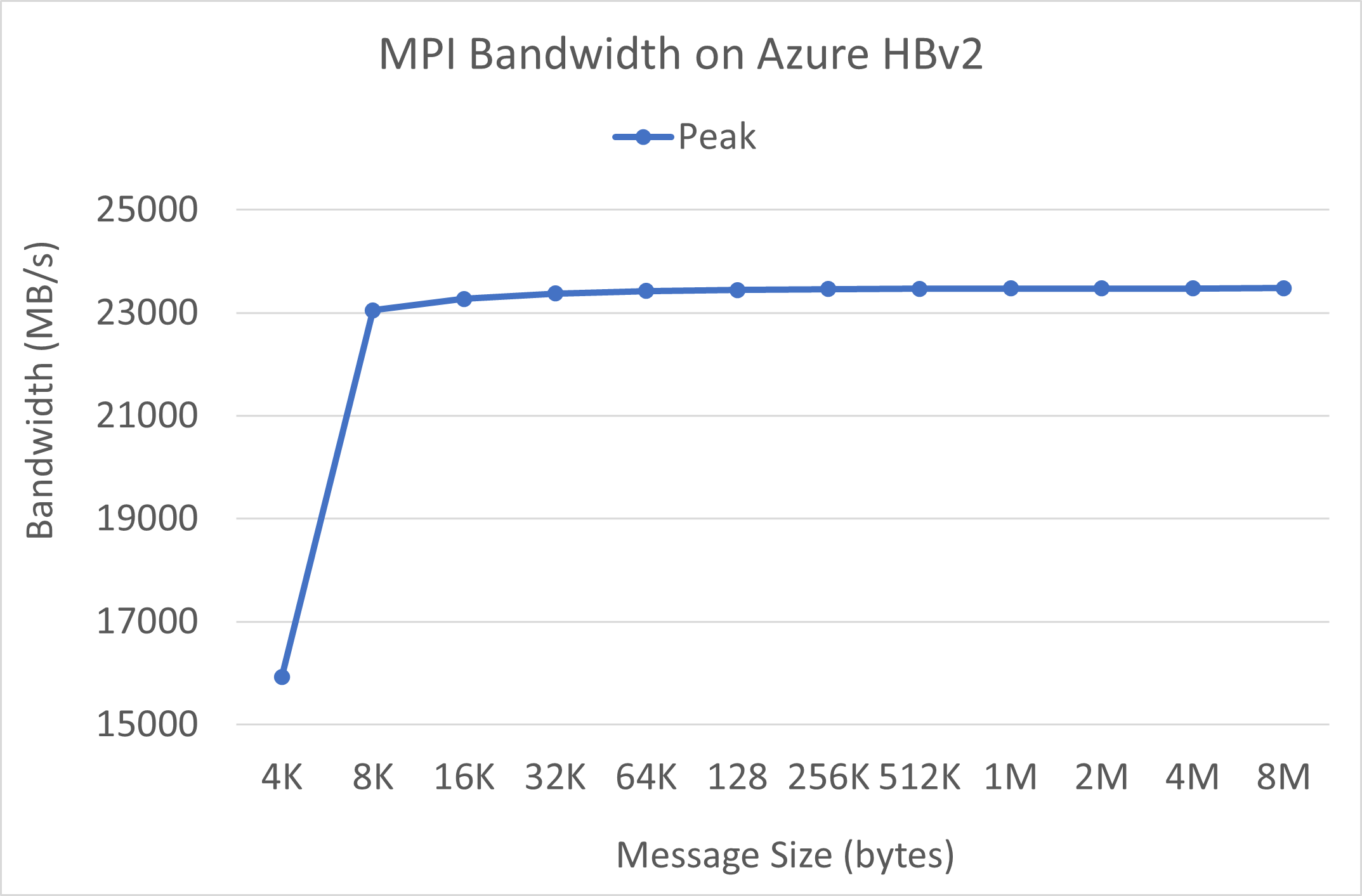

MPI bant genişliği

OSU mikrobenchmark paketinden MPI bant genişliği testi çalıştırılır. Örnek betikler GitHub'da bulunur.

./mvapich2-2.3.install/bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./mvapich2-2.3/osu_benchmarks/mpi/pt2pt/osu_bw

Mellanox Perftest

Mellanox Perftest paketinde gecikme süresi (ib_send_lat) ve bant genişliği (ib_send_bw) gibi birçok InfiniBand testi vardır. Aşağıda örnek bir komut verilmiştir.

numactl --physcpubind=[INSERT CORE #] ib_send_lat -a

Sonraki adımlar

- Azure compute Tech Community Bloglarında en son duyurular, HPC iş yükü örnekleri ve performans sonuçları hakkında bilgi edinin.

- Çalışan HPC iş yüklerinin daha üst düzey mimari görünümü için bkz . Azure'da Yüksek Performanslı Bilgi İşlem (HPC).