Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

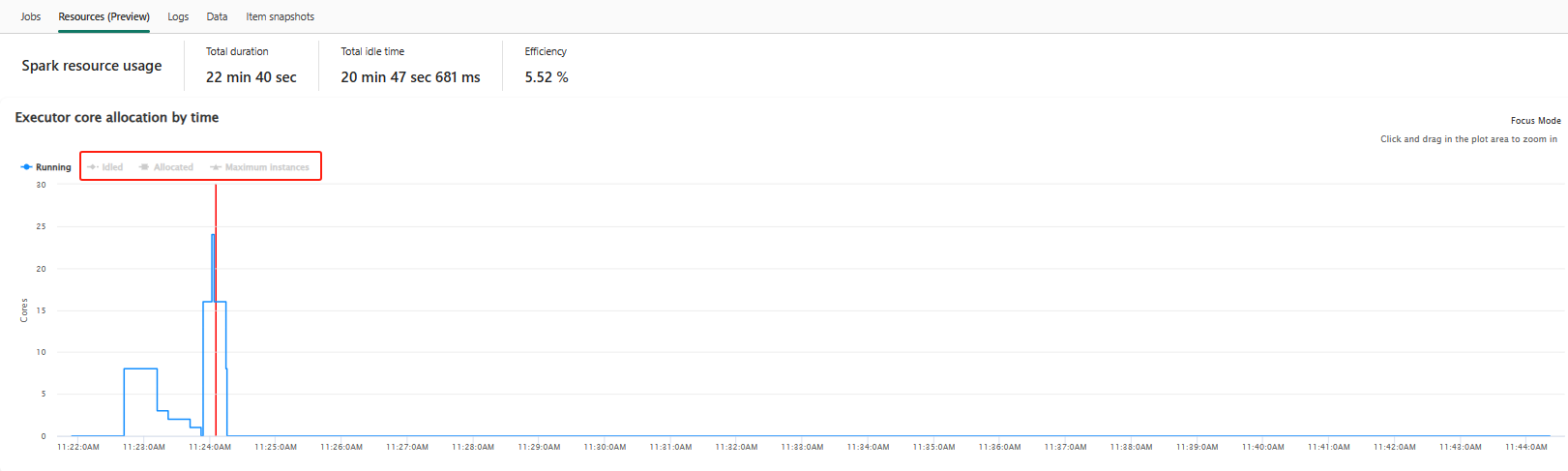

Kaynaklar sekmesinin altındaki yürütücü kullanım grafiği, Spark yürütmesi sırasında geçerli Spark uygulaması için Spark yürütücülerinin neredeyse gerçek zamanlı olarak ayrılmasını ve kullanımını görselleştirir. Grafik ayrıca etkileşimli bir deneyim sunarak belirli bir anda çalışan yürütücülere tıklayarak Spark işlerini ve görevlerini görüntülemenizi sağlar. Şu anda yalnızca Spark çalışma zamanı sürüm 3.4 ve üzeri bu özelliği destekler.

Kaynaklar sekmesi

Kaynaklar sekmesine tıklayarak her biri farklı bir yürütücü durumunu gösteren dört ayrı çizgi grafik içeren bir grafiğe erişin: Çalışıyor, Boşta, Ayrılmışve En fazla örnek.

Çalışan: Bu, Spark uygulamasının Spark işlerini ve görevlerini çalıştırmak için kullandığı gerçek çekirdek sayısını gösterir.

Boşta: Bu, Spark uygulaması çalışırken kullanılabilir ancak kullanılmayan çekirdek sayısını temsil eder.

Ayrılmış: Bu, Spark uygulamasının işlemi sırasında ayrılan çekirdekleri ifade eder.

En Fazla Örnek: Bu, Spark uygulamasına ayrılabilecek en fazla çekirdek sayısını gösterir.

Kaynak kullanım grafiğinde ilgili grafiği seçmek veya seçimini kaldırmak için renk göstergesini değiştirin.

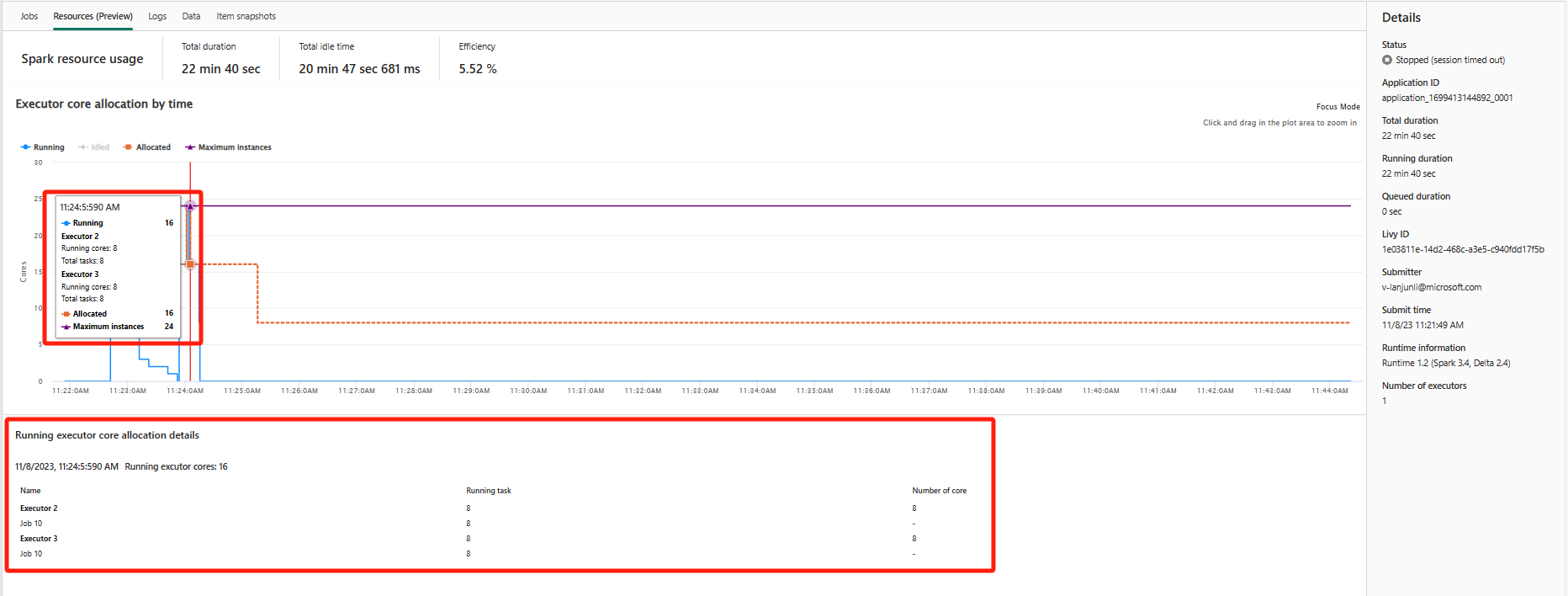

Kaynak kullanım grafiği etkileşimlidir. Farenizi çalışan yürütücü çekirdekleri grafiğinin üzerine getirdiğinizde, çekirdeklerin özeti ve ilgili yürütücü bilgileri görüntülenir. Yürütücü çekirdek satırının çalışan bir noktasına tıkladığınızda, grafiğin en altında ilgili yürütücü ve iş hakkında o belirli an için ayrıntılı bilgi görüntülenir.

Not

Bazı durumlarda, belirli zaman noktalarında görev sayısı yürütücü çekirdeklerinin kapasitesini aşabilir (örneğin, görev numaraları toplam yürütücü çekirdekleri / spark.task.cpus >). Bir görevin çalışan olarak işaretlenmesi ile yürütücü çekirdeğinde gerçek yürütülmesi arasında bir zaman aralığı olabileceğinden, bu beklenen bir durumdur. Bu nedenle, bazı görevler çalışıyor olarak görünebilir, ancak herhangi bir çekirdekte etkin olarak çalışmıyorlar.

İlgili içerik

Fabric Spark izleme, Spark uygulama izleme ve Defter bağlamsal izlemesine genel bakış için bkz:

- Apache Spark izleme ve değerlendirmeye genel bakış

- Apache Spark uygulama ayrıntılarını izleme

- Notebook bağlamsal izleme ve hata ayıklama