Lakehouse tablosuna 2 GB Parquet verisi yüklemek için Dataflow 2. Nesil kullanan fiyatlandırma senaryosu

Bu senaryoda Dataflow 2. Nesil, Azure Data Lake Depolama (ADLS) 2. Nesil'de depolanan 2 GB Parquet verilerini Microsoft Fabric'teki bir Lakehouse tablosuna yüklemek için kullanılmıştır. Parquet verileri için NYC Taxi-green örnek verilerini kullandık.

Aşağıdaki örnekte kullanılan fiyatlar varsayımsaldır ve tam olarak gerçek fiyatlandırmayı ima etmeyi amaçlamamektedir. Bunlar yalnızca Microsoft Fabric'teki Data Factory projelerinin maliyetini nasıl tahmin edip planlayabileceğinizi ve yönetebileceğinizi göstermek içindir. Ayrıca Doku kapasiteleri bölgeler arasında benzersiz olarak fiyatlandırıldığından, ABD Batı 2 'deki (tipik bir Azure bölgesi) saat başına 0,18 ABD doları olan Doku kapasitesi için kullandıkça öde fiyatlandırmasını kullanırız. Diğer Doku kapasitesi fiyatlandırma seçeneklerini keşfetmek için buraya Microsoft Fabric - Fiyatlandırma bölümüne bakın.

Yapılandırma

Bu senaryoyu gerçekleştirmek için aşağıdaki adımlarla bir veri akışı oluşturmanız gerekir:

- Veri Akışını Başlat: ADLS 2. Nesil depolama hesabından 2 GB Parquet dosyaları verisi alın.

- Power Query'yi yapılandırma:

- Power Query'ye gidin.

- Sorguyu hazırlama seçeneğinin etkinleştirildiğinden emin olun.

- Parquet dosyalarını birleştirmeye devam edin.

- Veri Dönüştürme:

- Netlik için üst bilgileri yükseltin.

- Gereksiz sütunları kaldırın.

- Sütun veri türlerini gerektiği gibi ayarlayın.

- Çıktı Veri Hedefi Tanımla:

- Lakehouse'ı veri çıkış hedefi olarak yapılandırın.

- Bu örnekte, Fabric içinde bir Lakehouse oluşturuldu ve kullanıldı.

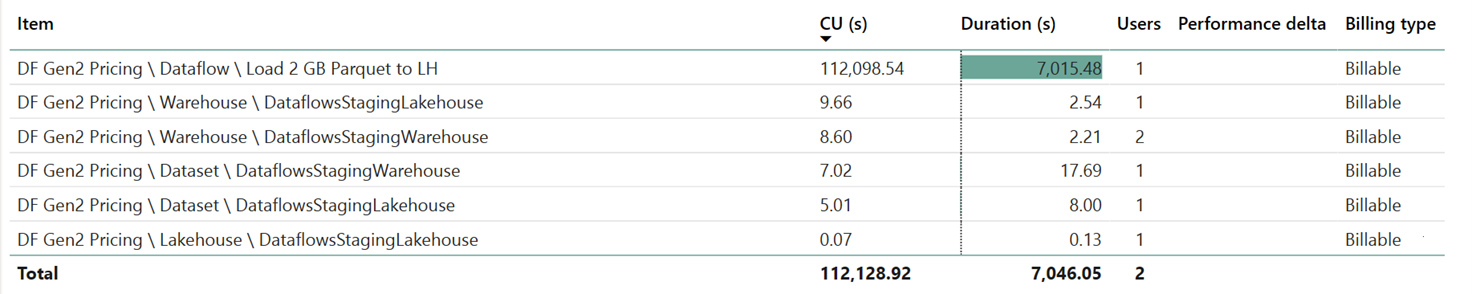

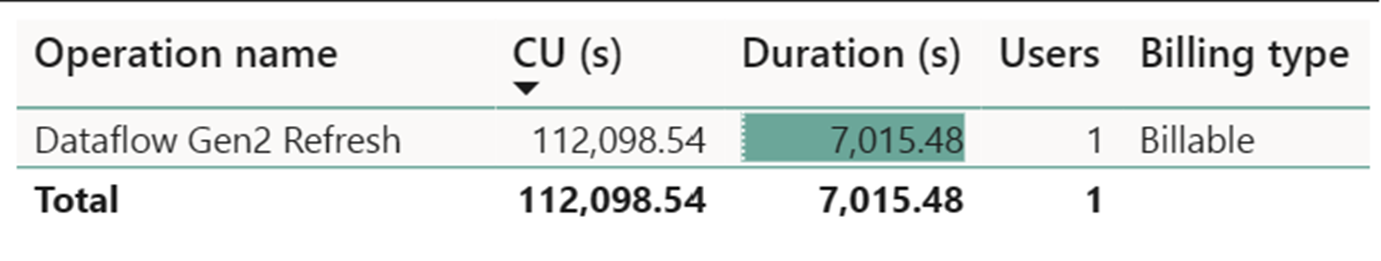

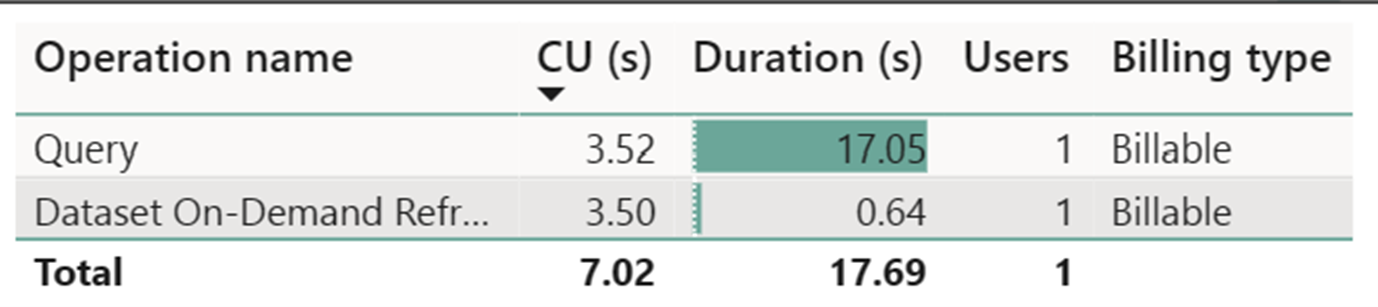

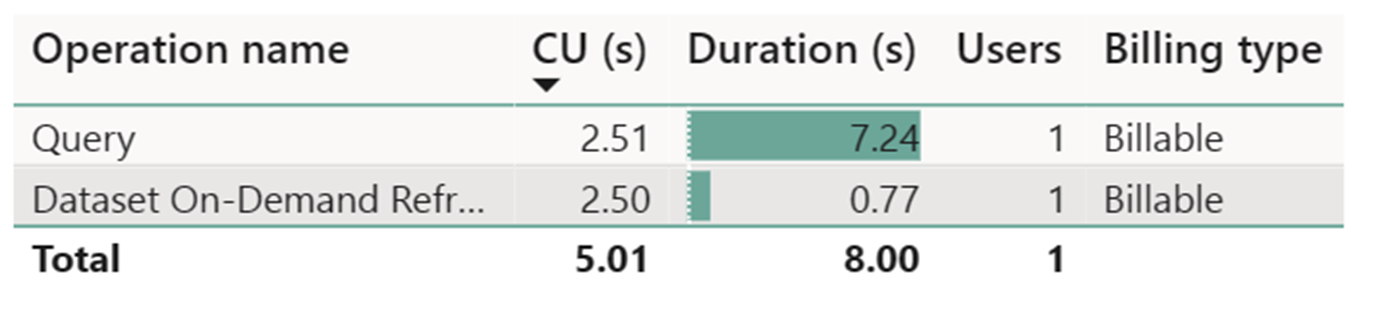

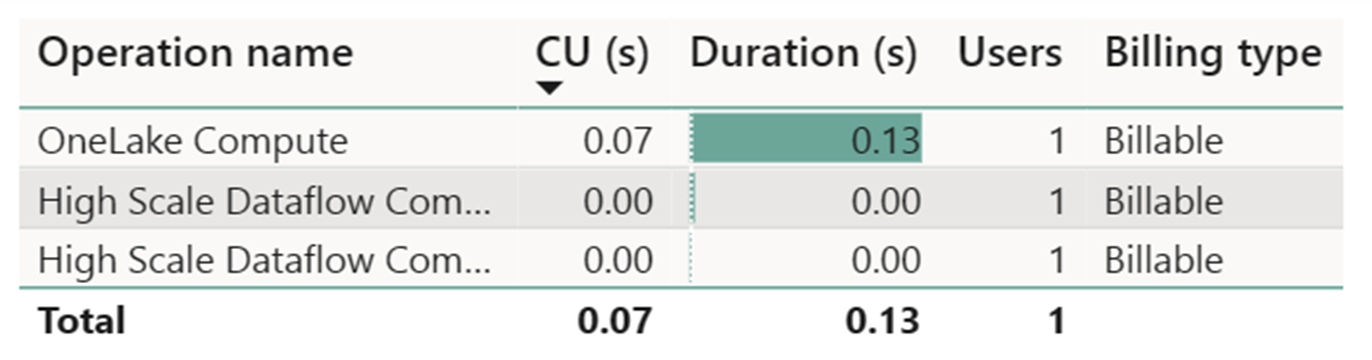

Doku Ölçümleri Uygulamasını kullanarak maliyet tahmini

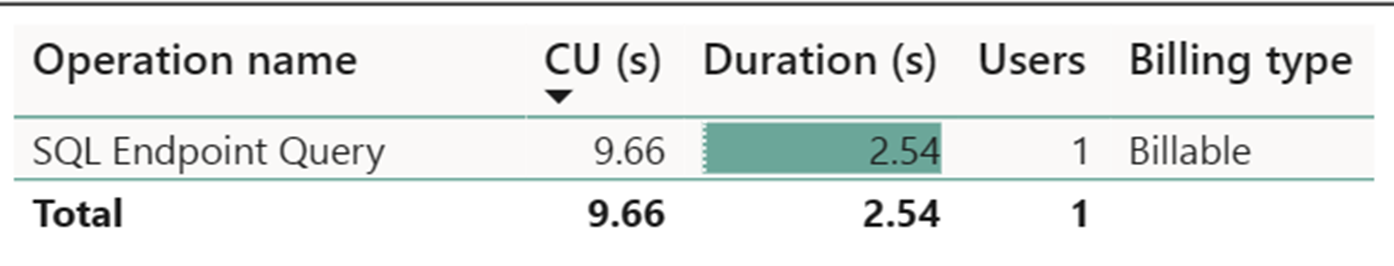

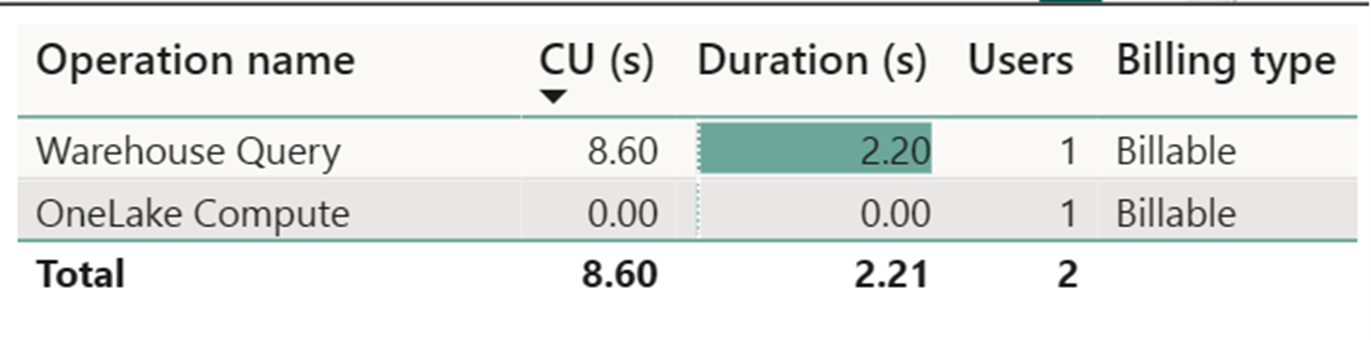

Yüksek Ölçekli Veri Akışı İşlem Ölçümü göz ardı edilebilir etkinlik kaydetti. Veri Akışı 2. Nesil yenileme işlemleri için standart İşlem ölçümü 112.098.540 İşlem Birimi (CU) tüketir. Ambar Sorgusu, SQL Uç Nokta Sorgusu ve İsteğe Bağlı Veri Kümesi Yenilemesi gibi diğer işlemlerin, Veri Akışı 2. Nesil uygulamasının şu anda saydam olan ve ilgili işlemleri için gerekli olan ayrıntılı yönlerini oluşturduğunu göz önünde bulundurmanız önemlidir. Ancak, bu işlemler gelecekteki güncelleştirmelerde gizlenecek ve Veri Akışı 2. Nesil maliyetleri tahmin edilirken göz ardı edilmelidir.

Not

Ölçüm olarak bildirilmiş olsa da, çalıştırmanın gerçek süresi Doku Ölçümleri Uygulaması ile etkili CU saatlerini hesaplarken geçerli değildir çünkü bildirdiği CU saniye ölçümü de zaten süresine göre hesaplanır.

| Metric | Standart İşlem | Yüksek Ölçekli İşlem |

|---|---|---|

| Toplam CU saniyesi | 112.098.54 CU saniye | 0 CU saniye |

| Geçerli CU saatleri faturalandırıldı | 112.098,54 / (60*60) = 31,14 CU saati | 0 / (60*60) = 0 CU saati |

Toplam çalıştırma maliyeti 0,18 ABD doları/CU saati = (31,14 CU saati) * (0,18 ABD doları/CU saati) ~= 5,60 USD