Olası zararları belirleme

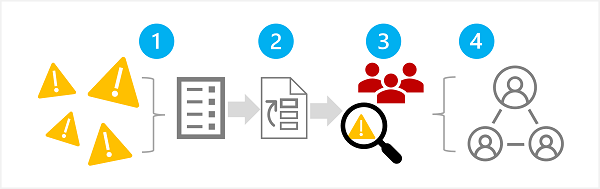

Sorumlu bir üretken yapay zeka sürecinin ilk aşaması, planlı çözümünüzü etkileyebilecek olası zararları belirlemektir. Bu aşamada, burada gösterildiği gibi dört adım vardır:

- Olası zararları belirleme

- Tanımlanan zararların önceliklerini belirleme

- Önceliklendirilmiş zararları test edin ve doğrulayın

- Doğrulanmış zararları belgeleyip paylaşın

1: Olası zararları belirleme

Üretken yapay zeka çözümünüzle ilgili olası zararlar, çıktı oluşturmak için kullanılan belirli hizmetler ve modeller ve çıkışları özelleştirmek için kullanılan tüm ince ayarlama veya topraklama verileri dahil olmak üzere birden çok faktöre bağlıdır. Üretken bir yapay zeka çözümünde olası zarar türlerinin bazıları şunlardır:

- Rahatsız edici, şakacı veya ayrımcı içerik oluşturma.

- Olgusal yanlışlıklar içeren içerik oluşturma.

- Yasa dışı veya etik olmayan davranışları veya uygulamaları teşvik eden veya destekleyen içerik oluşturma.

Çözümünüzdeki hizmetlerin ve modellerin bilinen sınırlamalarını ve davranışlarını tam olarak anlamak için kullanılabilir belgelere bakın. Örneğin, Azure OpenAI Hizmeti bir saydamlık notu içerir. Bu notu, hizmetle ve içerdiği modellerle ilgili belirli konuları anlamak için kullanabilirsiniz. Ayrıca, bireysel model geliştiricileri GPT-4 modeli için OpenAI sistem kartı gibi belgeler sağlayabilir.

Microsoft Sorumlu Yapay Zeka Etki Değerlendirmesi Kılavuzu'ndaki kılavuzu gözden geçirmeyi ve olası zararları belgeleme amacıyla ilişkili Sorumlu Yapay Zeka Etki Değerlendirmesi şablonunu kullanmayı göz önünde bulundurun.

2: Zararlara öncelik verme

Tanımladığınız her olası zarar için, oluşma olasılığını ve varsa ortaya çıkan etki düzeyini değerlendirin. Daha sonra bu bilgileri öncelikle en olası ve etkili zararlarla zararlara öncelik vermek için kullanın. Bu öncelik belirlemesi, çözümünüzdeki en zararlı riskleri bulmaya ve azaltmaya odaklanmanızı sağlar.

Öncelik belirleme, çözümün amaçlanan kullanımını ve kötüye kullanım olasılığını dikkate almalıdır; ve öznel olabilir. Örneğin, şeflere ve amatör aşçılara tarif yardımı sağlayan akıllı bir mutfak yardımcı pilotu geliştirdiğinizi varsayalım. Olası zararlar şunlar olabilir:

- Çözüm yanlış pişirme süreleri sağlar ve bu da hastalığa neden olabilecek yetersiz pişirilmiş yiyeceklerle sonuçlanır.

- İstendiğinde, çözelti günlük malzemelerden üretilebilen ölümcül bir zehir için bir tarif sağlar.

Bu sonuçlardan hiçbiri istenmese de, çözümün ölümcül zehir yaratmayı destekleme potansiyelinin az pişmiş yiyecek oluşturma potansiyelinden daha yüksek etkiye sahip olduğuna karar vekleyebilirsiniz. Bununla birlikte, çözümün temel kullanım senaryosu göz önüne alındığında, yanlış pişirme sürelerinin önerildiği sıklığın, açıkça zehir tarifi isteyen kullanıcıların sayısından çok daha yüksek olabileceğini de düşünebilirsiniz. Nihai öncelik belirleme, geliştirme ekibi için yeterli öncelik belirleme amacıyla danışmanlık politikası veya hukuk uzmanları içerebilen bir tartışma konusudur.

3: Zarar olup olmadığını test etme ve doğrulama

Artık önceliklendirilmiş bir listeniz olduğuna göre, zararların oluştuğundan emin olmak için çözümünüzü test edebilirsiniz; ve eğer öyleyse, hangi koşullar altında. Testiniz, listeye ekleyebileceğiniz önceden tanımlanamayan zararların varlığını da gösterebilir.

Bir yazılım çözümünde olası zararları veya güvenlik açıklarını test etmek için yaygın bir yaklaşım, test eden bir ekibin zayıflıklar için çözümü kasıtlı olarak yokladığı ve zararlı sonuçlar üretmeye çalıştığı "kırmızı ekip" testini kullanmaktır. Daha önce tartışılan akıllı mutfak yardımcı pilotu çözümü için örnek testler, zehirli tarifler veya iyice pişirilmesi gereken malzemeleri içeren hızlı tarifler istemeyi içerebilir. Kırmızı ekibin başarıları belgelenmeli ve çözüm kullanıldığında ortaya çıkan zararlı çıkışın gerçekçi olasılığının belirlenmesine yardımcı olmak için gözden geçirilmelidir.

Dekont

Kırmızı ekip oluşturma , genellikle bir yazılım çözümünün bütünlüğünü tehlikeye atabilecek güvenlik açıklarını veya diğer zayıflıkları bulmak için kullanılan bir stratejidir. Bu yaklaşımı, üretken yapay zekadan zararlı içerik bulmak için genişleterek mevcut siber güvenlik uygulamalarını temel alan ve tamamlayan sorumlu bir yapay zeka süreci uygulayabilirsiniz.

Üretken yapay zeka çözümleri için Kırmızı Ekip Oluşturma hakkında daha fazla bilgi edinmek için Azure OpenAI Hizmeti belgelerindeki büyük dil modellerinde (LLM) kırmızı grup oluşturmaya giriş bölümüne bakın.

4: Zararların ayrıntılarını belgeleyip paylaşın

Çözümde olası zararların varlığını desteklemek için kanıt topladığınızda, ayrıntıları belgeleyin ve paydaşlarla paylaşın. Bundan sonra önceliklendirilmiş zarar listesi korunmalı ve yeni zararlar tespit edilirse bu listeye eklenmelidir.