使用适用于 Visual Studio Code 的 Databricks 扩展将 Python 笔记本作为作业运行

本文介绍如何使用适用于 Visual Studio Code 的 Databricks 扩展将 Python 笔记本作为 Azure Databricks 作业运行。 请参阅什么是适用于 Visual Studio Code 的 Databricks 扩展?。

若要将 Python 文件作为 Azure Databricks 作业运行,请参阅使用适用于 Visual Studio Code 的 Databricks 扩展将 Python 文件作为作业运行。 若要将 R、Scala 或 SQL 笔记本作为 Azure Databricks 作业运行,请参阅使用适用于 Visual Studio Code 的 Databricks 扩展将 R、Scala 或 SQL 笔记本作为作业运行。

此信息假定你已安装并设置适用于 Visual Studio Code 的 Databricks 扩展。 请参阅安装适用于 Visual Studio Code 的 Databricks 扩展。

打开扩展和代码项目后,执行以下操作:

在代码项目中,打开要作为作业运行的 Python 笔记本。

提示

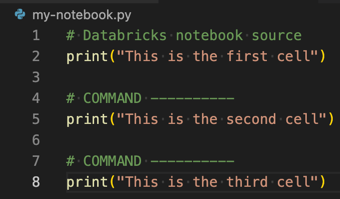

若要在 Visual Studio Code 中创建 Python 笔记本文件,首先请单击“文件”>“新建文件”,选择“Python 文件”,然后使用

.py文件扩展名保存新文件。若要将

.py文件转换为 Azure Databricks 笔记本,请将特殊注释# Databricks notebook source添加到该文件的开头,并在每个单元之前添加特殊注释# COMMAND ----------。 有关详细信息,请参阅导入文件并将其转换为笔记本。

执行下列操作之一:

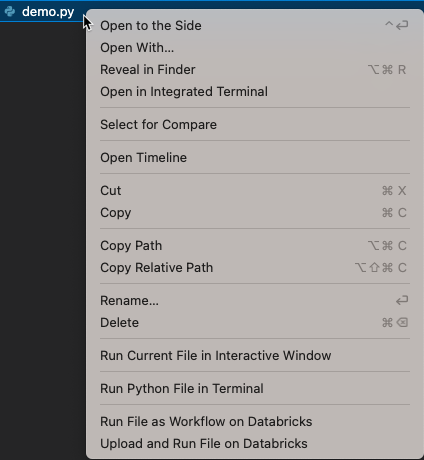

在“资源管理器”视图(“视图”>“资源管理器”)中,右键单击笔记本文件,然后从上下文菜单中选择“在 Databricks 上将文件作为工作流运行”。

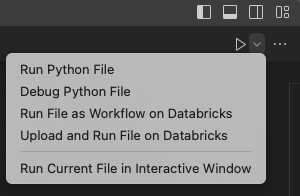

在笔记本文件编辑器的标题栏中,单击播放(“运行或调试”)图标旁边的下拉箭头。 然后在下拉列表中,单击“在 Databricks 上将文件作为工作流运行”。

此时会显示一个新的编辑器选项卡,其标题为“Databricks 作业运行”。 该笔记本将作为作业在工作区中运行,该笔记本及其输出显示在新编辑器选项卡的“输出”区域中。

若要查看有关作业运行的信息,请单击“Databricks 作业运行”编辑器选项卡中的“任务运行 ID”链接。工作区随即会打开,作业运行详细信息显示在工作区中。