你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

CNTK v2.7 发行说明

亲爱的社区,

随着我们对 ONNX 和 ONNX 运行时的持续贡献,我们使 AI 框架生态系统中的互操作变得更容易,并访问传统 ML 模型和深度神经网络的高性能跨平台推理功能。 在过去的几年里,我们有权开发此类关键的开源机器学习项目,包括Microsoft Cognitive Toolkit,这使其用户能够大规模利用行业范围内的深度学习进步。

今天的 2.7 版本将是 CNTK 的最后一个主要版本。 对于 bug 修复,我们可能有一些后续次要版本,但这些版本会逐个评估。 此版本后没有新功能开发计划。

CNTK 2.7 版本完全支持 ONNX 1.4.1,我们鼓励那些寻求操作其 CNTK 模型的人利用 ONNX 和 ONNX 运行时。 今后,用户可以通过支持 ONNX 的框架数量继续利用不断发展的 ONNX 创新。 例如,用户可以本机从 PyTorch 导出 ONNX 模型,或者使用 TensorFlow-ONNX 转换器将 TensorFlow 模型转换为 ONNX。

自 CNTK 最初开放源代码发布以来,我们非常感激多年来从参与者和用户那里获得的所有支持。 CNTK 使 Microsoft 团队和外部用户能够以各种深度学习应用程序(例如 Microsoft 语音研究人员(该框架的发起方)实现的语音识别历史突破等方式执行复杂和大规模工作负荷。

由于 ONNX 越来越多地用于在必应和 Office 等 Microsoft 产品中使用的模型,我们致力于将创新与生产要求的严格要求合成,以推动生态系统向前发展。

最重要的是,我们的目标是尽可能开放和可访问跨软件和硬件堆栈进行深度学习创新。 我们将努力将CNNTK的现有优势和新最先进的研究引入其他开源项目,以真正扩大此类技术的影响力。

感激之情,

-- CNTK 团队

此版本的亮点

- 已移动到适用于 Windows 和 Linux 的 CUDA 10。

- 支持 ONNX 导出中的高级 RNN 循环。

- 导出大于 2GB 的 ONNX 格式模型。

- 在大脑脚本训练操作中支持 FP16。

CUDA 10 的 CNTK 支持

CNTK 现在支持 CUDA 10。 这需要更新才能将环境生成到 Visual Studio 2017 v15.9 for Windows。

若要在 Windows 上设置生成和运行时环境,请执行以下操作:

- 安装 Visual Studio 2017。 注意:对于 CUDA 10 及更高版本,不再需要使用特定的 VC 工具版本 14.11 安装和运行。

- 安装 Nvidia CUDA 10

- 在 PowerShell 中运行: DevInstall.ps1

- 启动 Visual Studio 2017 并打开 CNTK.sln。

若要使用 docker 在 Linux 上设置生成和运行时环境,请使用 Dockerfiles 在此处生成 Unbuntu 16.04 docker 映像。 对于其他 Linux 系统,请参阅 Dockerfiles,为 CNTK 设置依赖库。

支持 ONNX 导出中的高级 RNN 循环

具有递归循环的 CNTK 模型可以导出到具有扫描操作的 ONNX 模型。

导出大于 2GB 的 ONNX 格式的模型

若要以 ONNX 格式导出大于 2GB 的模型,请使用 cntk。函数 API:保存 (self、filename、format=ModelFormat.CNTKv2、use_external_files_to_store_parameters=False) ,并将“format”设置为 ModelFormat.ONNX 并将use_external_files_to_store_parameters设置为 True。 在这种情况下,模型参数保存在外部文件中。 使用 onnxruntime 执行模型评估时,导出的模型应与外部参数文件一起使用。

2018-11-26.

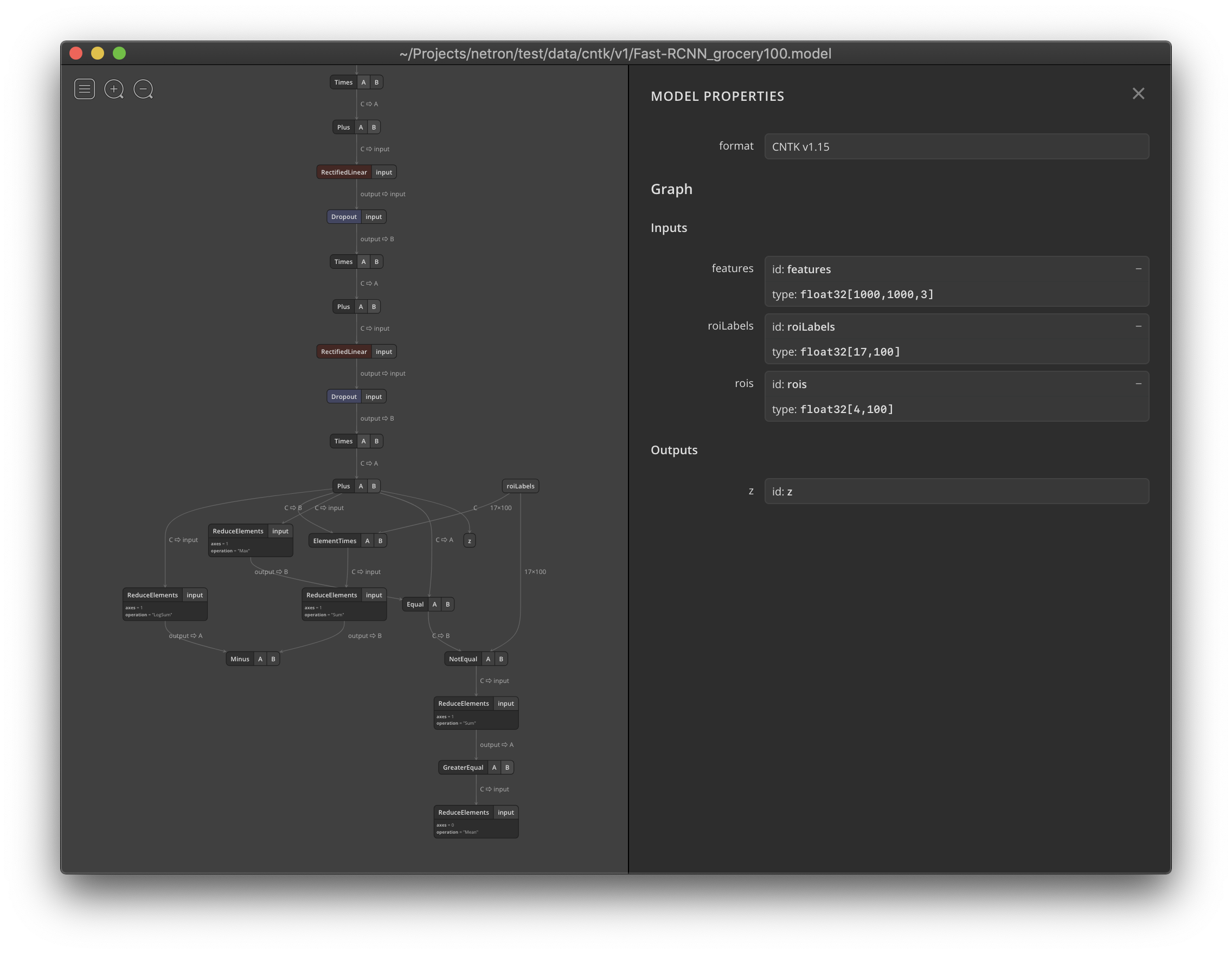

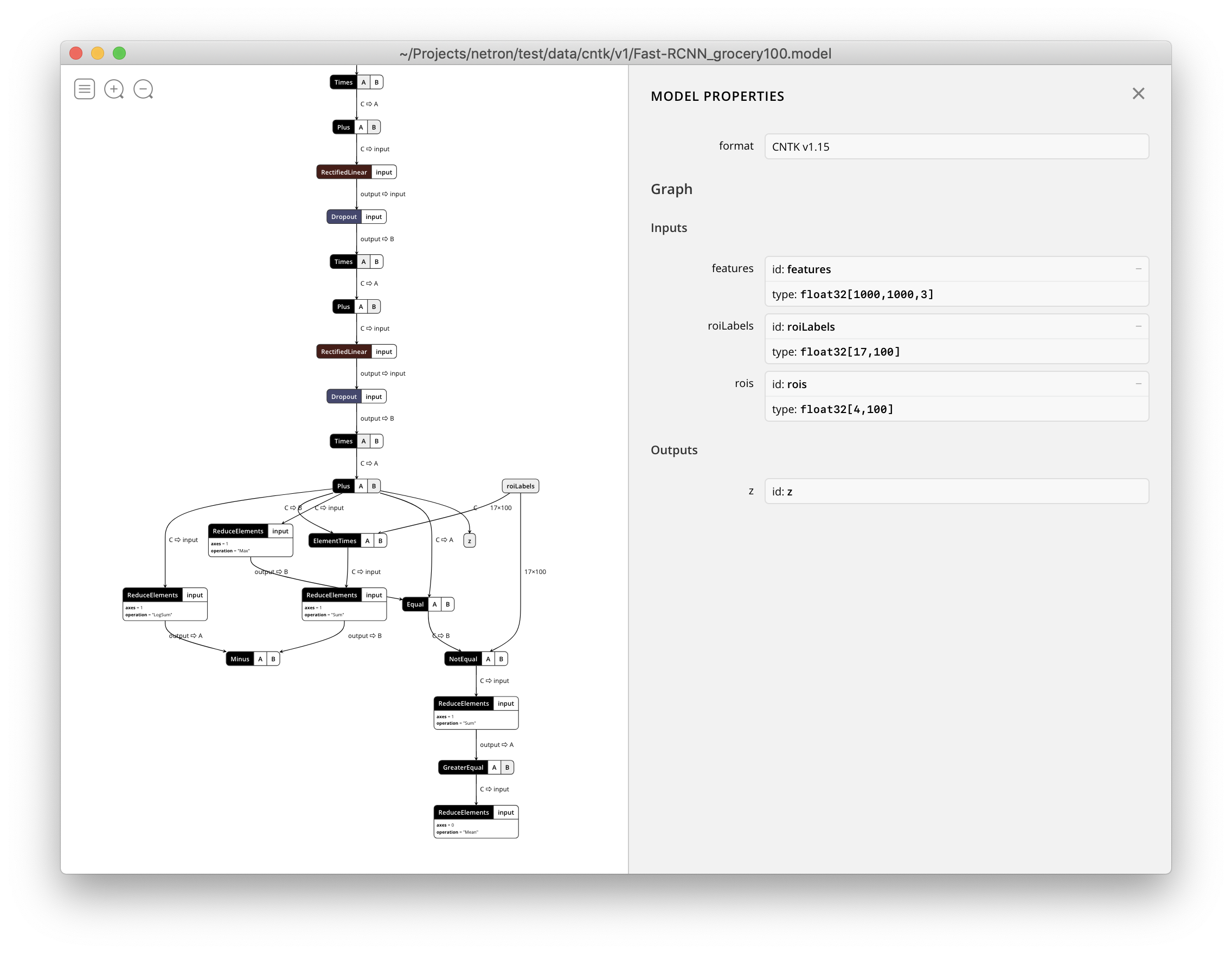

Netron 现在支持可视化 CNTK v1 和 CNTK v2 .model 文件。