将工作区库和 Spark 属性迁移到默认环境

Microsoft Fabric 环境提供了用于运行 Spark 作业的灵活配置。 在一个环境中,可以选择不同的 Spark 运行时、配置计算资源,以及从公共存储库安装库或上传本地定制的库。 你可以轻松地将环境附加到笔记本和 Spark 作业定义。

数据工程和数据科学工作区设置已升级为包含 Fabric 环境。 作为此升级的一部分,Fabric 不再支持在工作区设置中添加新库和 Spark 属性。 解决方法是创建一个 Fabric 环境,在其中配置库和属性,然后将其附加为工作区默认环境。 创建一个环境并将其设置为默认环境后,可以将现有库和 Spark 属性迁移到该默认环境。

本教程介绍如何将现有工作区的库和 Spark 属性迁移到某个环境。

重要

- 工作区设置只能由管理员配置。

- 对于笔记本或 Spark 作业定义,如果未为其附加任何环境,则现有工作区设置仍然有效。 但是,你无法对这些设置进行进一步更改。 我们强烈建议将现有设置迁移到某个环境。

- 迁移过程包括一个会永久移除所有现有配置的步骤。 请仔细按照这些说明操作。 如果意外删除了文件,将无法恢复。

准备要迁移的文件

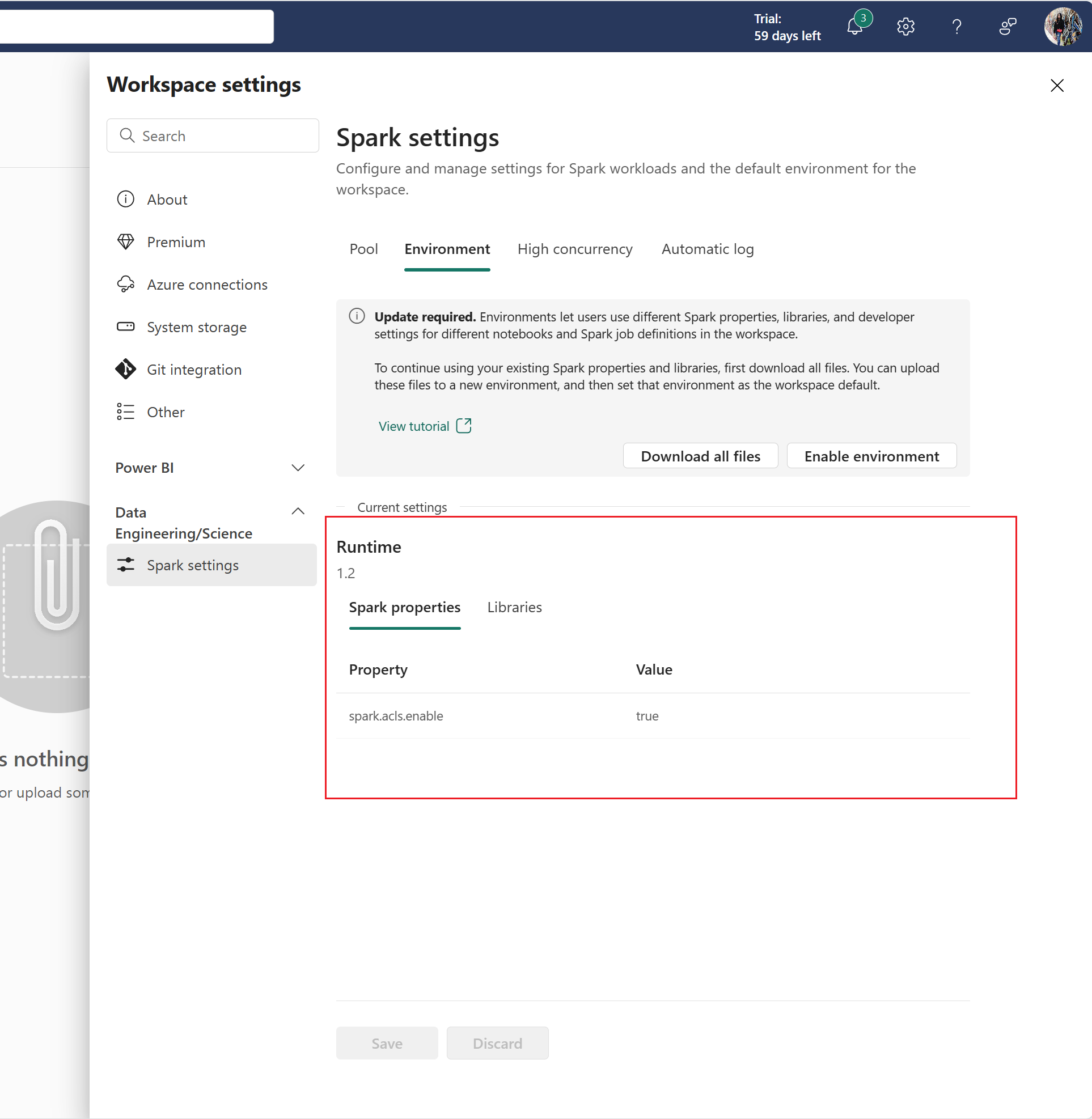

在“工作区设置”中,查看现有配置。

记下当前的“运行时”版本。

选择“下载所有文件”来下载现有配置。

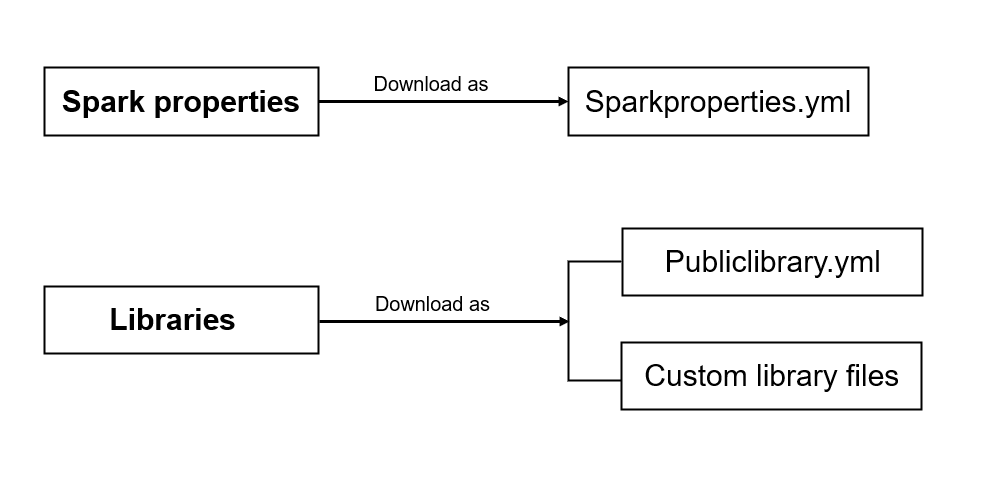

内容将作为不同的文件下载。 Sparkproperties.yml 包含所有 Spark 属性键值对。 Publiclibrary.yml 文件包含所有公共库定义。 你或组织上传的所有自定义包都将作为文件逐个下载。

下载文件后,可以进行迁移。

创建并配置环境

在工作区列表/创建中心内创建环境。 创建新环境后,将显示“环境”页面。

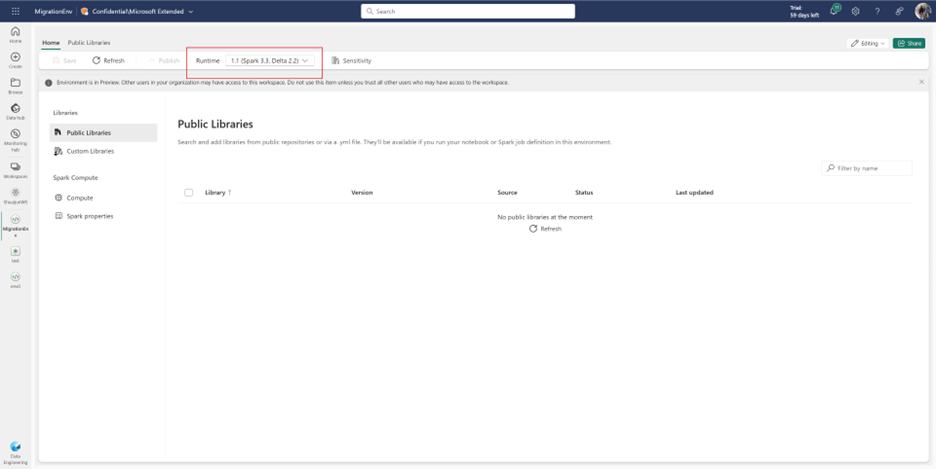

在环境的“主页”选项卡中,确保“运行时”的版本与现有工作区运行时相同。

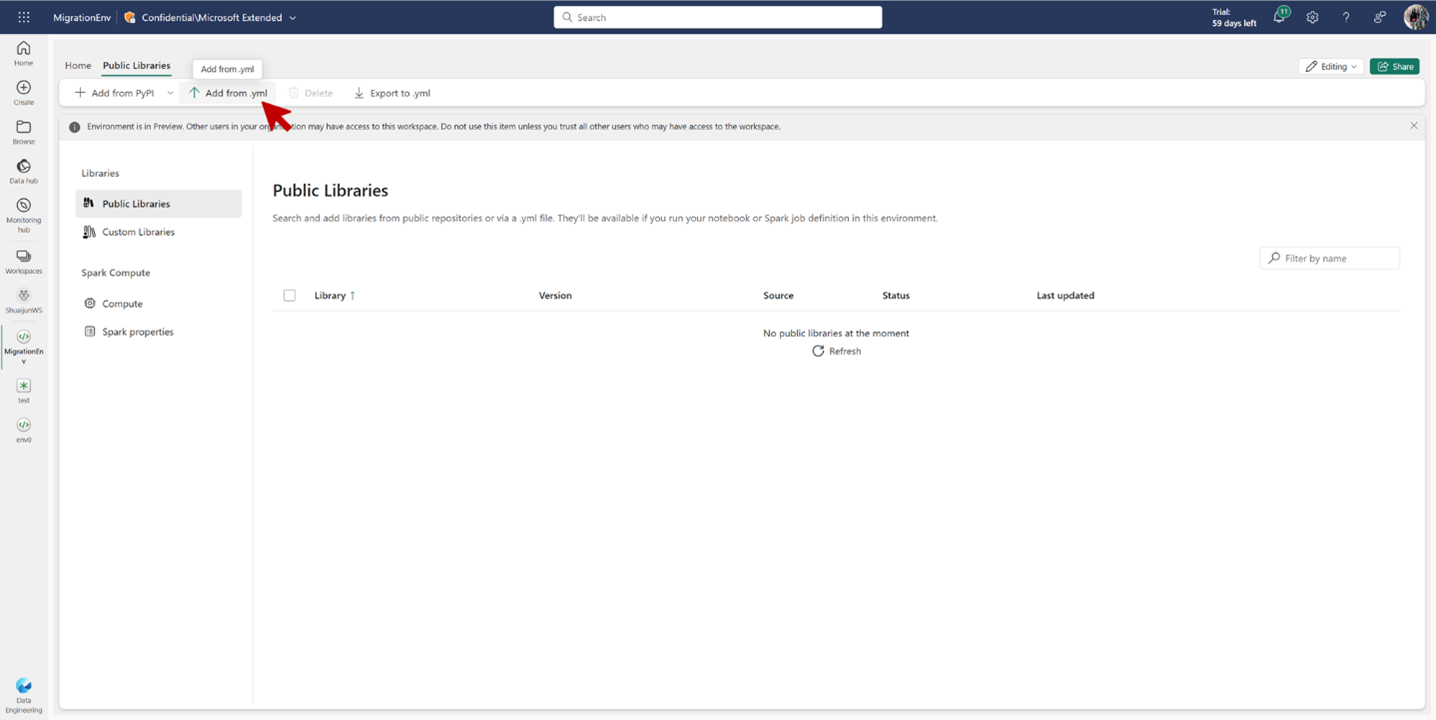

如果工作区设置中没有任何公共库,请跳过此步骤。 导航到“公共库”部分,然后选择功能区上的“从 .yml 添加”。 上传从现有工作区设置下载的 Publiclibrary.yml。

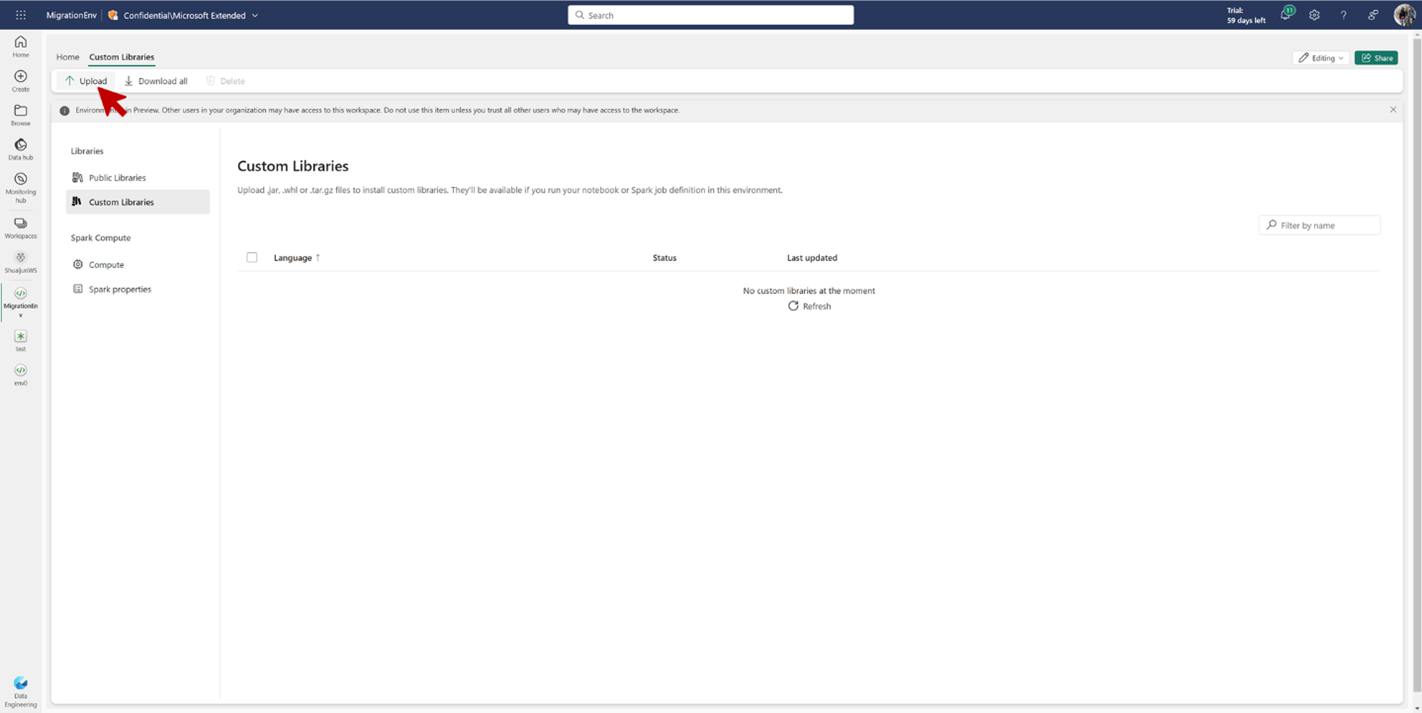

如果工作区设置中没有任何自定义库,请跳过此步骤。 导航到“自定义库”部分,然后选择功能区上的“上传”。 上传从现有工作区设置下载的自定义库文件。

如果工作区设置中没有任何 Spark 属性,请跳过此步骤。 导航到“Spark 属性”部分,然后选择功能区上的“上传”。 上传从现有工作区设置下载的 Sparkproperties.yml 文件。

选择“发布”,然后再次仔细检查所做更改。 如果一切正确,请发布更改。 发布过程需要几分钟才能完成。

发布完成后,便已成功配置环境。

在工作区设置中启用并选择默认环境

重要

选择“启用环境”后,所有现有配置都将被丢弃。 在继续操作之前,请确保已下载所有现有配置并将其成功安装到环境中。

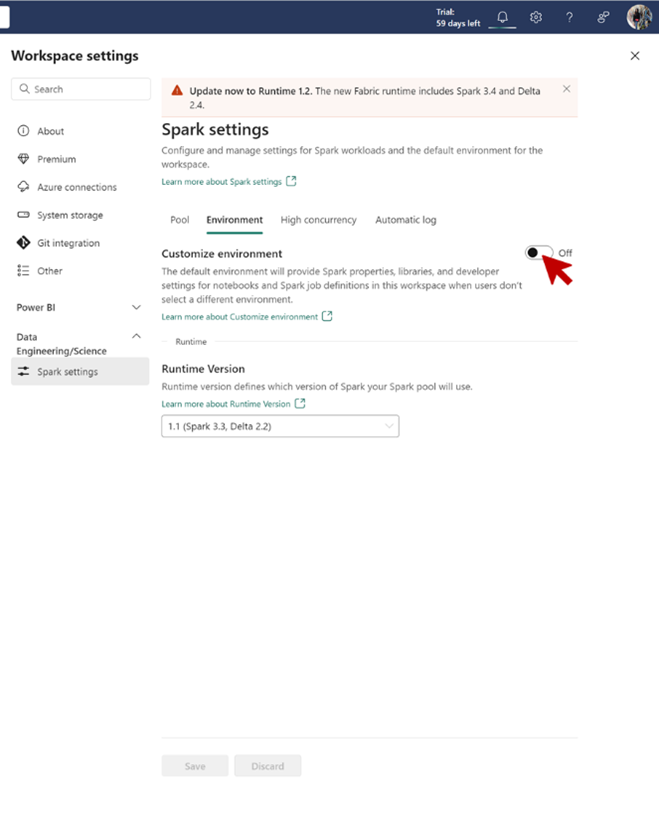

导航到“工作区设置”->“数据工程/科学”->“环境”,然后选择“启用环境”。 此操作将移除现有配置,并开启工作区级环境体验。

成功删除现有配置后,将显示以下屏幕。

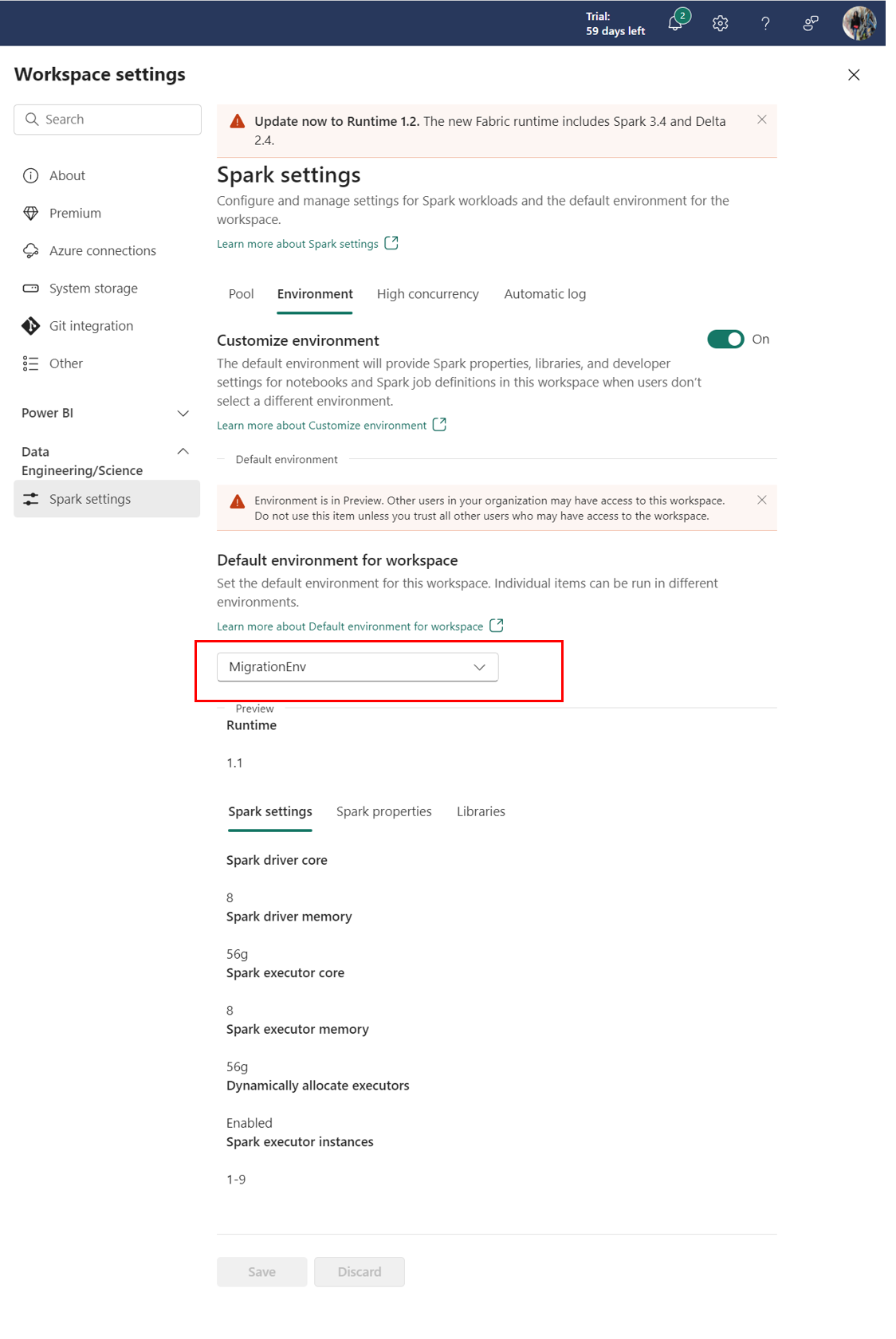

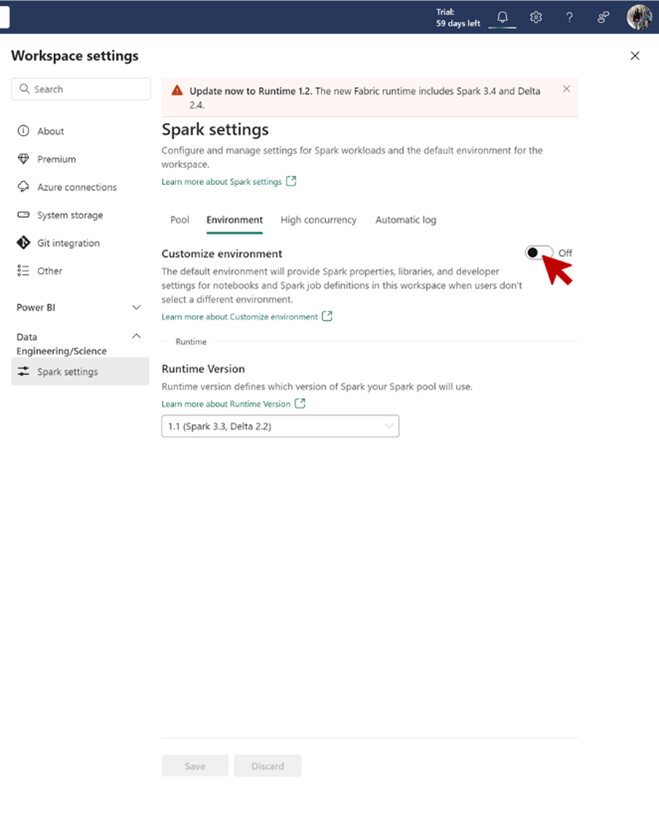

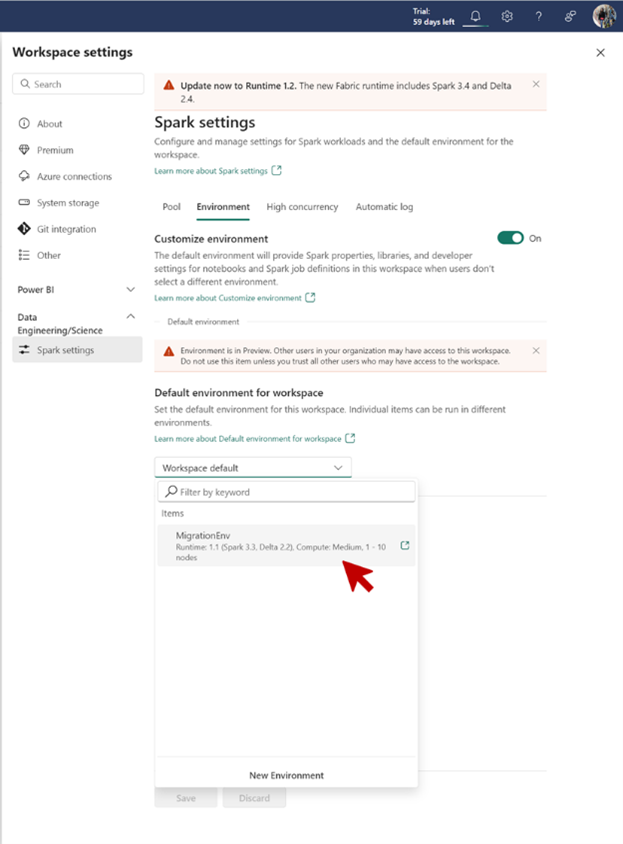

将“自定义环境”切换到“开”位置。 通过此选项,可将环境附加为工作区默认环境。

选择在前面的步骤中配置的环境作为工作区默认环境,然后选择“保存”。

确认新环境现在显示在“Spark 设置”页面的“工作区默认环境”下。