排程並執行 Apache Spark 作業定義

瞭解如何執行 Microsoft Fabric Apache Spark 作業定義,並尋找作業定義狀態和詳細資料。

必要條件

在開始之前,您必須:

- 藉由啟用中訂用帳戶建立 Microsoft Fabric 租用帳戶。 免費建立帳戶。

- 瞭解 Spark 作業定義:請參閱 什麼是 Apache Spark 作業定義?。

- 建立 Spark 作業定義:請參閱 如何在 Fabric 中建立 Apache Spark 作業定義。

如何執行 Spark 作業定義

有兩種方式可以執行 Spark 作業定義:

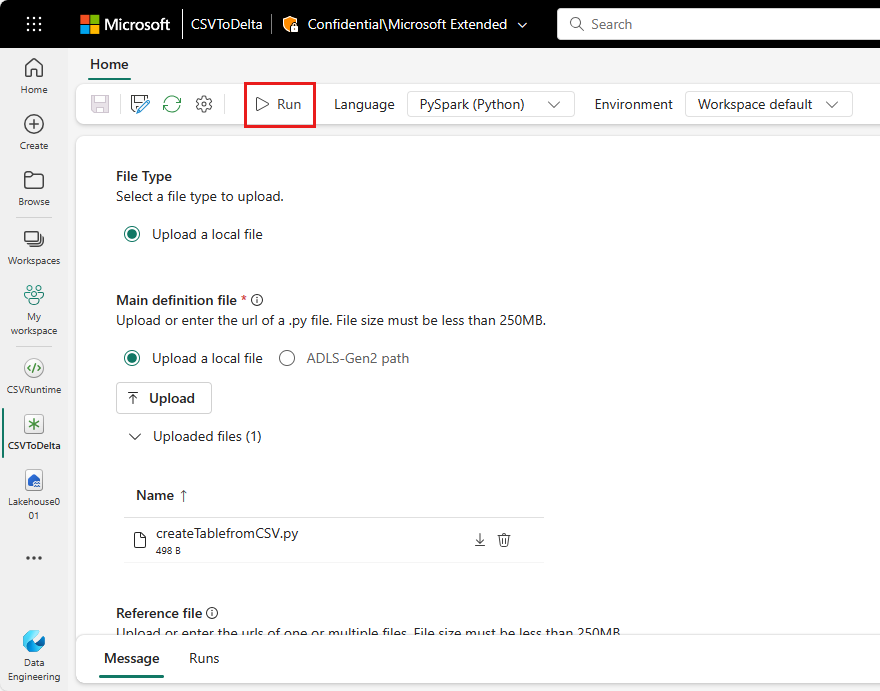

從作業清單中的Spark作業定義項目選取執行 ,手動執行Spark作業定義。

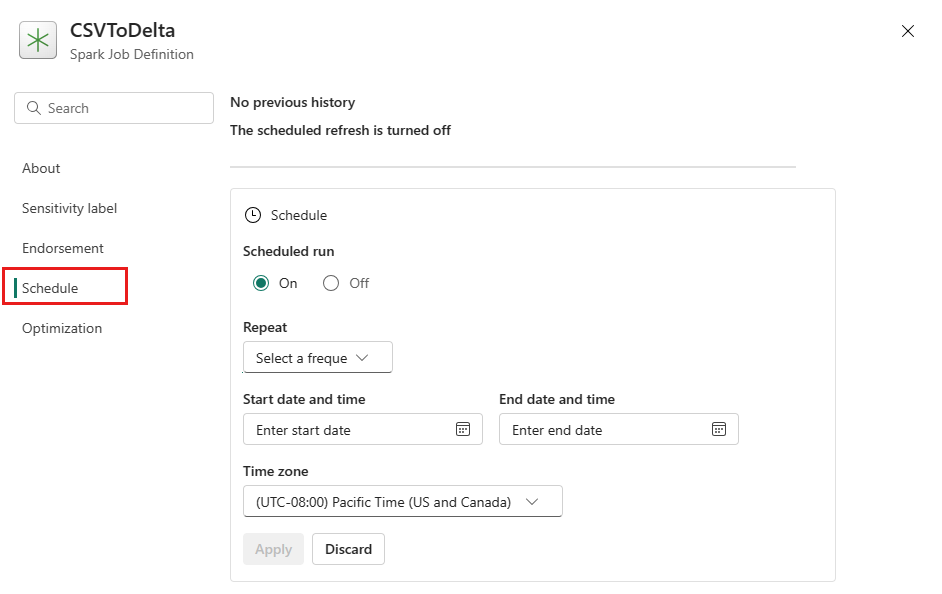

在設定 索引標籤上設定排程計劃來排程 Spark 作業定義。選取工具列上的設定,然後選取排程。

重要

若要執行,Spark 作業定義必須有主要定義檔案和預設 Lakehouse 內容。

提示

針對手動執行,目前登入使用者的帳戶會用來提交作業。 針對排程所觸發的執行,建立排程計劃之使用者的帳戶會用來提交作業。

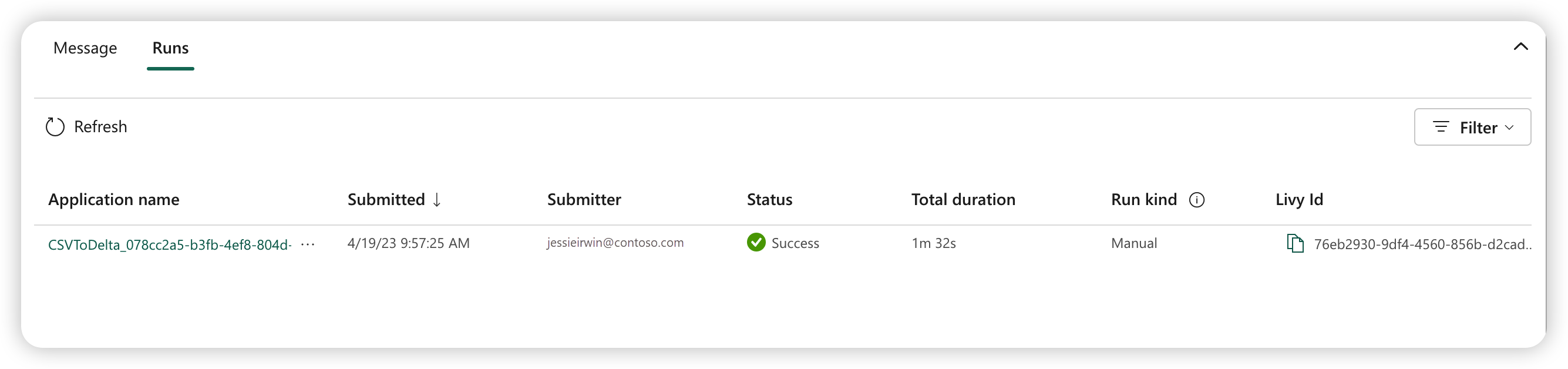

提交執行後的三到五秒,新的資料列會出現在 執行索引標籤底下。此資料列會顯示新執行的詳細資料。 狀態資料行會顯示作業的近乎即時狀態,而執行類型資料行會顯示作業是否為手動或排程。

如需如何監視作業的詳細資訊,請參閱 監視 Apache Spark 作業定義。

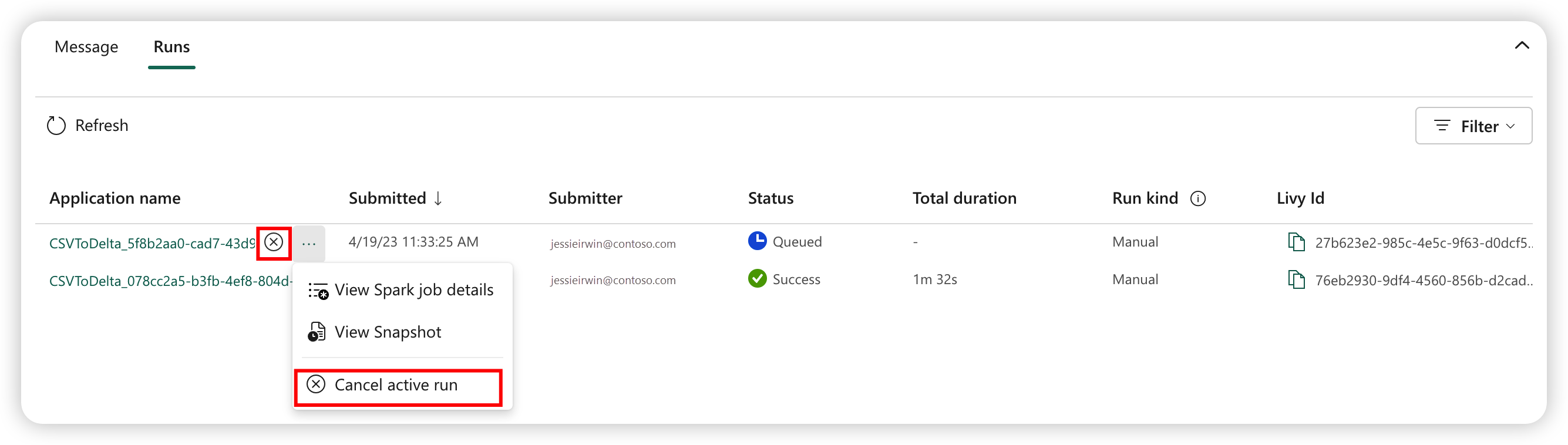

如何取消執行中的作業

提交作業之後,您可以從作業清單中的Spark作業定義項目選取取消作用中執行來取消作業。

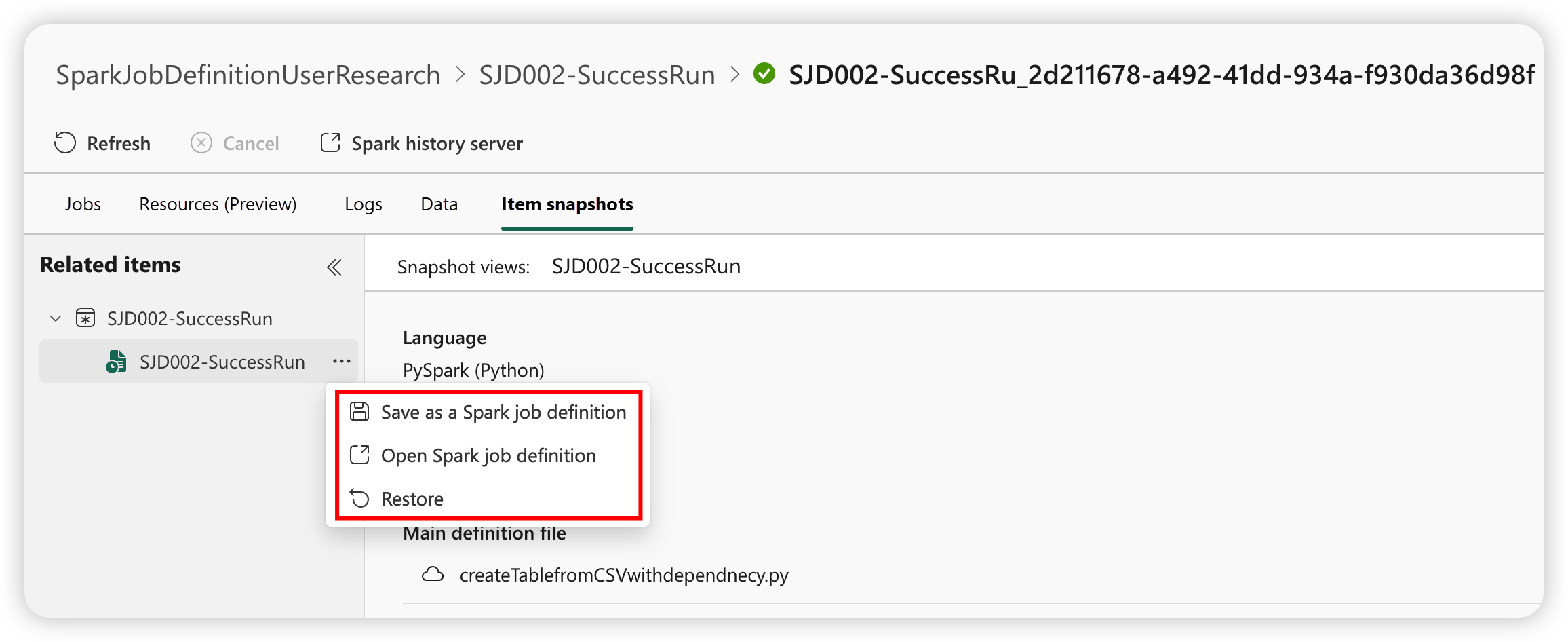

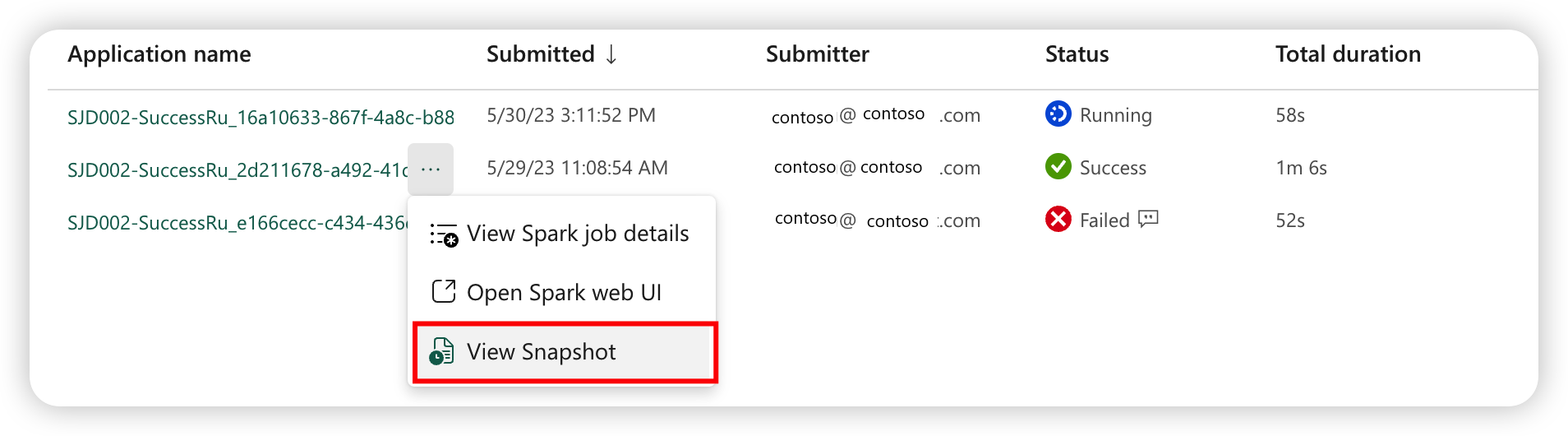

Spark 作業定義快照

Spark 作業定義會儲存其最新狀態。 若要檢視歷程記錄執行的快照集,請從作業清單中的Spark作業定義項目選取檢視快照 集。 快照集會顯示提交作業時的工作定義狀態,包括主要定義檔、參考檔案、命令行自變數、參考的 Lakehouse 和 Spark 屬性。

您可以從快照集採取三個動作:

- 另存成 Spark 作業定義:將快照集儲存為新的 Spark 作業定義。

- 開啟 Spark 作業定義:開啟目前的 Spark 作業定義。

- 還原:使用快照集還原作業定義。 作業定義會在提交作業時還原至狀態。