OneLake,適用於數據的 OneDrive

OneLake 是整個組織的單一、統一、邏輯數據湖。 Data Lake 會處理來自各種來源的大量數據。 如同 OneDrive,OneLake 會自動隨附每個Microsoft Fabric 租使用者,並設計成所有分析數據的單一位置。 OneLake 為客戶提供:

- 整個組織的一個 Data Lake

- 一份數據 復本,用於多個分析引擎

整個組織的一個 Data Lake

在 OneLake 之前,客戶更容易為不同的商業群組建立多個湖泊,而不是在單一湖上共同作業,即使管理多個資源的額外負荷也一樣。 OneLake 著重於藉由改善共同作業來消除這些挑戰。 每個客戶租使用者都有一個 OneLake。 永遠不能有一個以上,如果您有 Fabric,永遠不能有零。 每個 Fabric 租用戶都會自動布建 OneLake,不需要額外的資源來設定或管理。

根據預設,共同作業具有分散式擁有權

租使用者的概念是 SaaS 服務的獨特優點。 瞭解客戶的組織開始和結束位置,可提供自然治理和合規性界限,這是在租用戶系統管理員的控制下。在 OneLake 中登陸的任何數據預設會受到控管。 雖然所有數據都位於租用戶系統管理員所設定的界限內,但重要的是,此系統管理員不會成為防止組織其他部分參與 OneLake 的中央守門員。

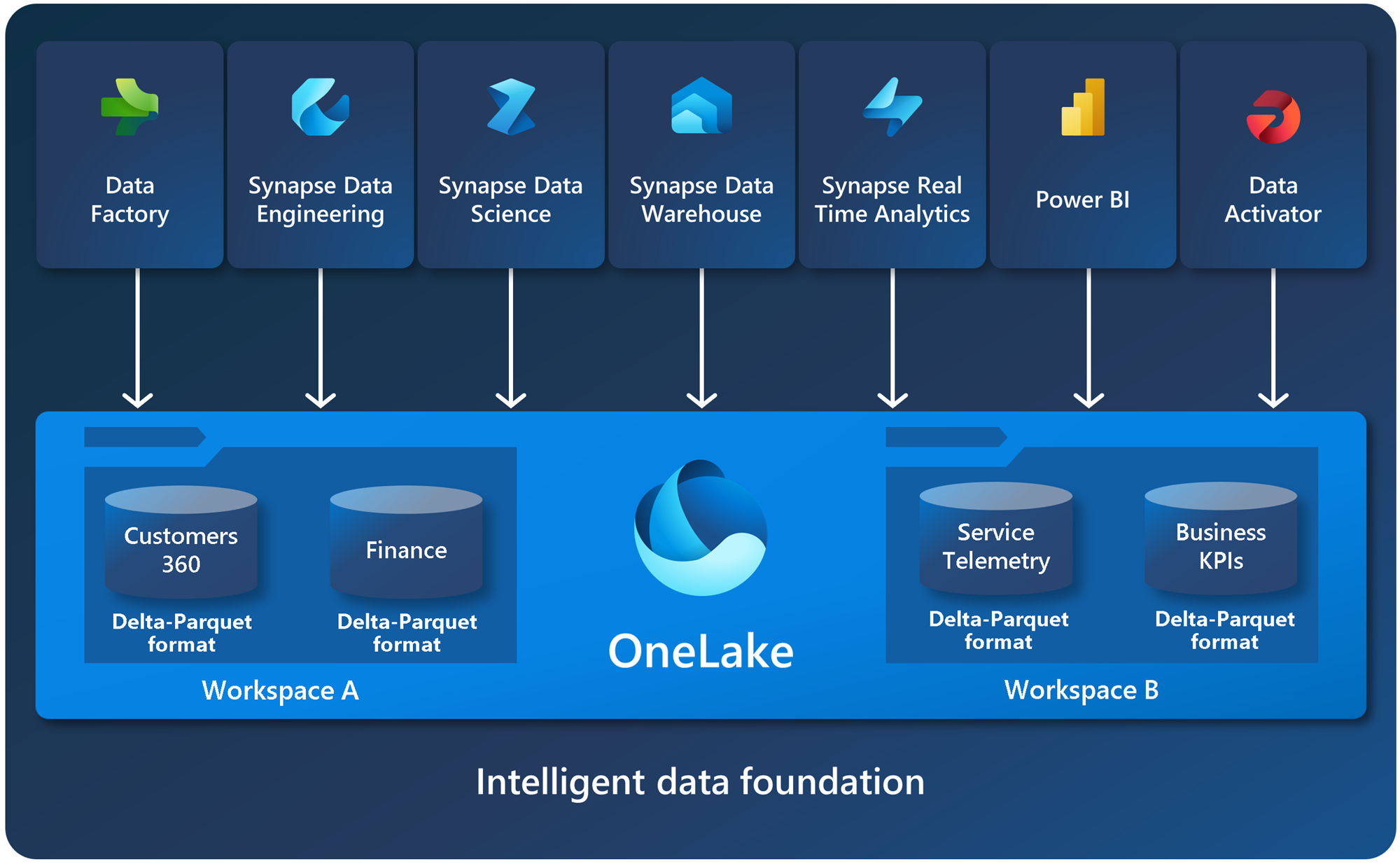

在租使用者中,您可以建立任意數目的工作區。 工作區可讓組織的不同部分散發擁有權和存取原則。 每個工作區都是系結至特定區域的容量的一部分,且會個別計費。

在工作區中,您可以建立資料項,並透過資料項存取 OneLake 中的所有數據。 類似於 Office 如何將 Word、Excel 和 PowerPoint 檔案儲存在 OneDrive、Fabric 會將 lakehouses、warehouses 和其他項目儲存在 OneLake 中。 專案可以為每個角色提供量身打造的體驗,例如 Lakehouse 中的 Apache Spark 開發人員體驗。

如需如何開始使用 OneLake 的詳細資訊,請參閱 使用 OneLake 建立 Lakehouse。

在每個層級開啟

OneLake 在每個層級都開放。 OneLake 建置在 Azure Data Lake Storage (ADLS) Gen2 之上,可支援任何類型的檔案、結構化或非結構化檔案。 數據倉儲和 Lakehouse 等所有 Fabric 數據項都會以 Delta Parquet 格式自動以 OneLake 儲存其數據。 如果數據工程師使用 Apache Spark 將數據載入 Lakehouse,然後 SQL 開發人員會使用 T-SQL 在完全事務數據倉儲中載入數據,這兩者都會參與相同的數據湖。 OneLake 會以 Delta Parquet 格式儲存所有表格式數據。

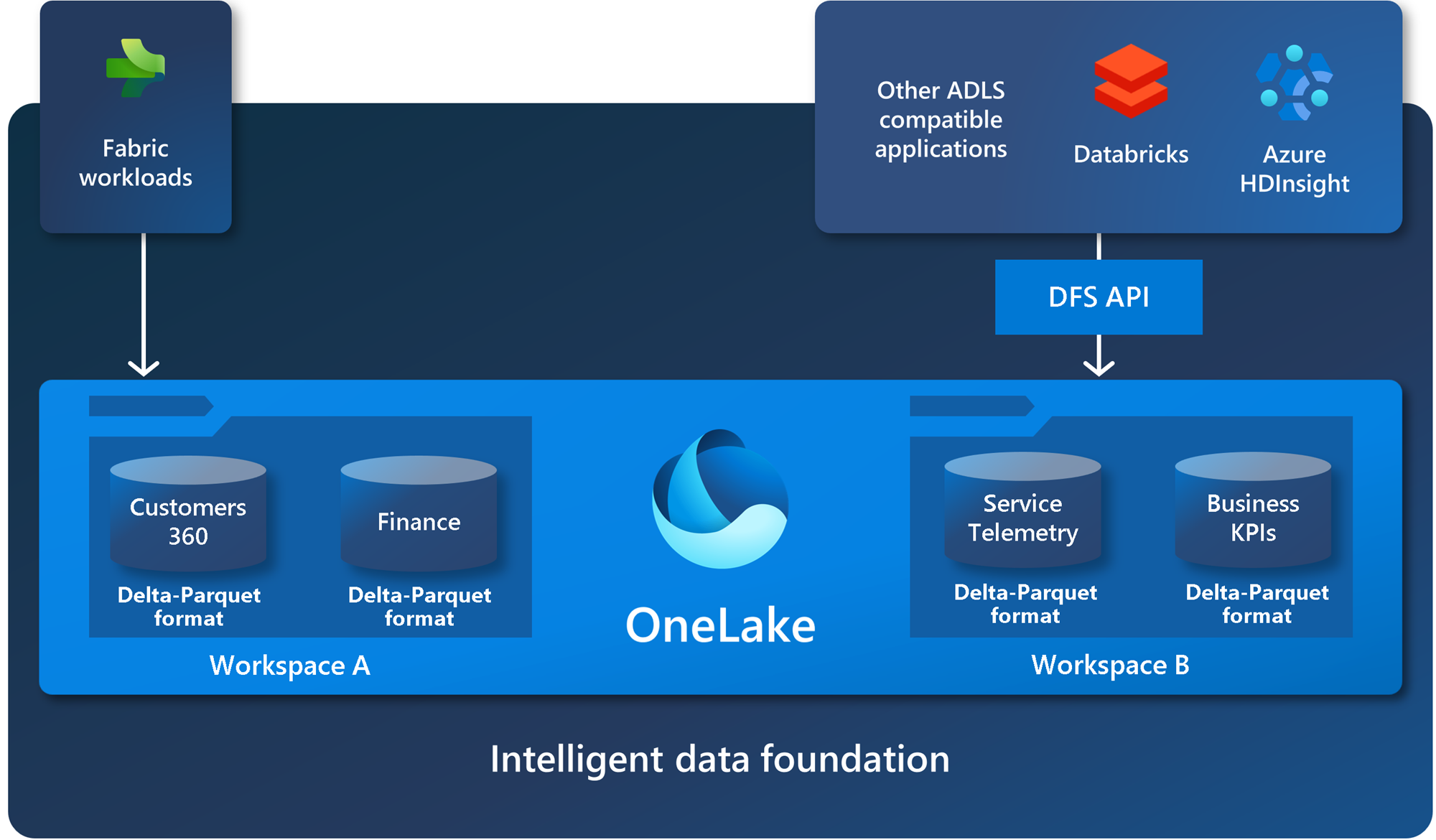

OneLake 支援與現有 ADLS Gen2 應用程式相容的相同 ADLS Gen2 API 和 SDK,包括 Azure Databricks。 您可以在 OneLake 中處理數據,就好像它是整個組織的一個大型 ADLS 記憶體帳戶一樣。 每個工作區都會顯示為該儲存體帳戶內的容器,而不同的數據項會顯示為這些容器中的資料夾。

如需 API 和端點的詳細資訊,請參閱 OneLake 存取和 API。 如需 OneLake 與 Azure 整合的範例,請參閱 Azure Synapse Analytics、 Azure 記憶體總管、 Azure Databricks 和 Azure HDInsight 文章。

適用於 Windows 的 OneLake 檔案總管

OneLake 是適用於數據的 OneDrive。 就像 OneDrive 一樣,您可以使用適用於 Windows 的 OneLake 檔案 總管,輕鬆地從 Windows 探索 OneLake 數據。 您可以流覽所有工作區和數據項,輕鬆地上傳、下載或修改檔案,就像您在 Office 中所做的一樣。 OneLake 檔案總管可簡化 Data Lake 的使用,甚至允許非技術商務使用者使用它們。

如需詳細資訊,請參閱 OneLake 檔案總管。

一份數據

OneLake 的目標是讓您在單一數據複本中提供最大的價值,而不需要數據移動或重複。 您不再需要將數據複製到另一個引擎,或是分解尋址接收器,以便使用來自其他來源的數據來分析數據。

快捷鍵會跨網域連接數據,而不需要移動數據

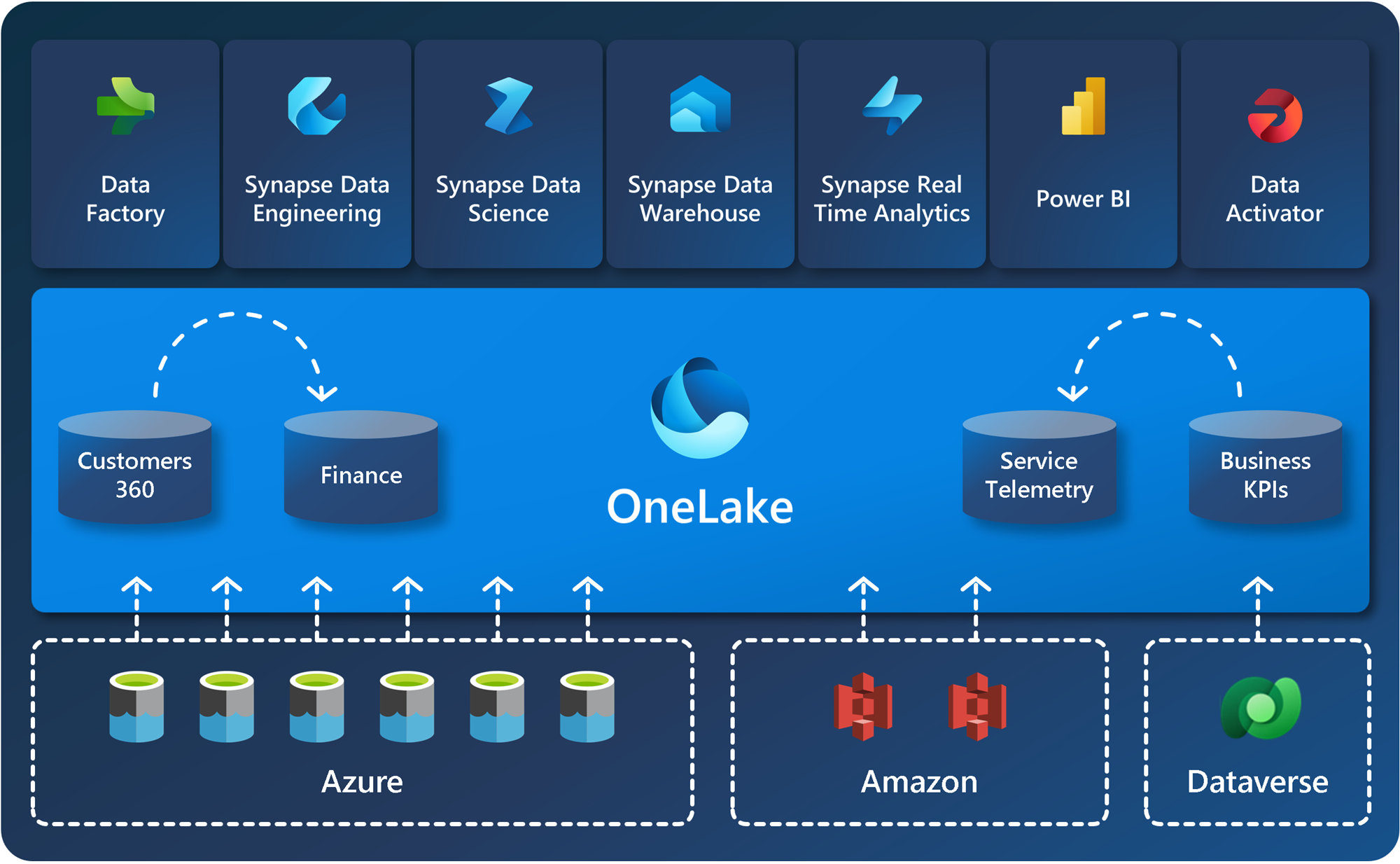

快捷方式可讓您的組織輕鬆地在使用者與應用程式之間共享數據,而不需要不必要地移動和複製資訊。 當小組在不同的工作區中獨立工作時,快捷方式可讓您將不同商務群組和網域的數據合併成虛擬數據產品,以符合使用者的特定需求。

快捷方式是儲存在其他檔案位置的數據參考。 這些檔案位置可以位於相同工作區內或跨不同工作區、OneLake 或 ADLS、S3 或 Dataverse 外部的 OneLake 內,且即將推出更多目標位置。 不論位置為何,快捷方式會讓檔案和資料夾看起來就像儲存在本機一樣。

如需如何使用快捷方式的詳細資訊,請參閱 OneLake 快捷方式。

具有多個分析引擎的一份數據

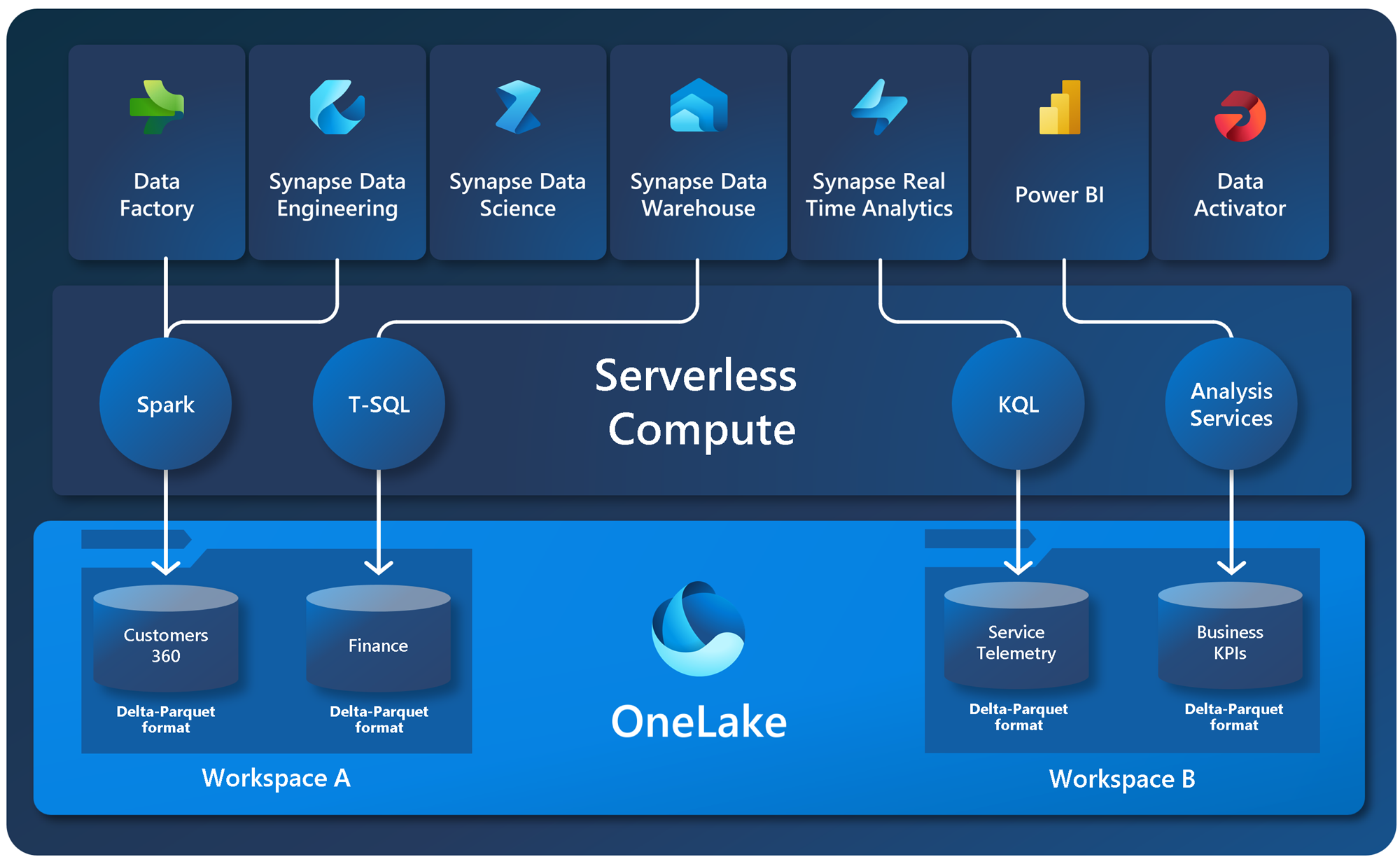

雖然應用程式可能會區隔記憶體和運算,但數據通常會針對單一引擎進行優化,因此難以針對多個應用程式重複使用相同的數據。 使用 Fabric 時,不同的分析引擎(T-SQL、Apache Spark、Analysis Services 等)會以開放式 Delta Parquet 格式儲存數據,讓您跨多個引擎使用相同的數據。

不再需要複製數據,只需將它與另一個引擎搭配使用。 您一律能夠針對您嘗試執行的作業選擇最佳引擎。 例如,假設您有一個 SQL 工程師小組建置完全事務數據倉儲。 他們可以使用 T-SQL 引擎和 T-SQL 的所有功能來建立資料表、轉換數據,以及將數據載入數據表。 如果數據科學家想要使用此數據,則不再需要經歷特殊的 Spark/SQL 驅動程式。 OneLake 會以 Delta Parquet 格式儲存所有數據。 數據科學家可以直接在數據上使用 Spark 引擎及其開放原始碼連結庫的完整功能。

商務用戶可以在 Analysis Services 引擎中使用新的 Direct Lake 模式,直接在 OneLake 之上建置 Power BI 報表。 Analysis Services 引擎是 Power BI 語意模型的強大功能,而且一律提供兩種存取數據的模式:匯入和直接查詢。 Direct Lake 模式可為使用者提供所有匯入速度,而不需要複製數據,結合最佳的匯入和直接查詢。 如需詳細資訊,請參閱 Direct Lake。

顯示使用 Spark 載入資料的範例圖表、使用 T-SQL 查詢,以及檢視 Power BI 報表中的數據。

相關內容

意見反映

即將推出:我們會在 2024 年淘汰 GitHub 問題,並以全新的意見反應系統取代並作為內容意見反應的渠道。 如需更多資訊,請參閱:https://aka.ms/ContentUserFeedback。

提交及檢視以下的意見反映: