HBv3 系列虛擬機器概觀

適用於: ✔️ Linux VM ✔️ Windows VM ✔️ 彈性擴展集 ✔️ 統一擴展集

HBv3 系列伺服器具有 2 * 64 核心 EPYC 7V73X CPU,總共有 128 個實體「Zen3」核心和 AMD 3D V-Cache。 HBv3 上的同步多執行緒 (SMT) 已停用。 這些 128 核心分割為 16 個區段 (每個通訊端 8 個區段),每個區段包含 8 個處理器核心,並且能統一存取 96 MB L3 快取。 Azure HBv3 伺服器也會執行下列 AMD BIOS 設定:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

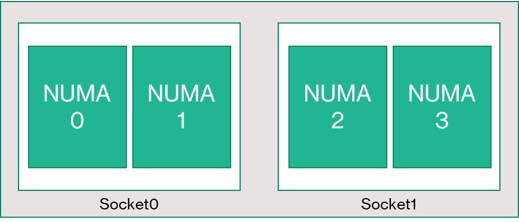

如此一來,伺服器就會以 4 個 NUMA 網域啟動 (每個通訊端 2 個)。 每個網域大小為 32 核心。 每個 NUMA 都能直接存取 4 個以 3200 MT/秒運作的實體 DRAM 通道。

為了讓 Azure Hypervisor 擁有足夠空間,在不干擾 VM 的情況下運作,我們會為每個伺服器保留 8 個實體核心。

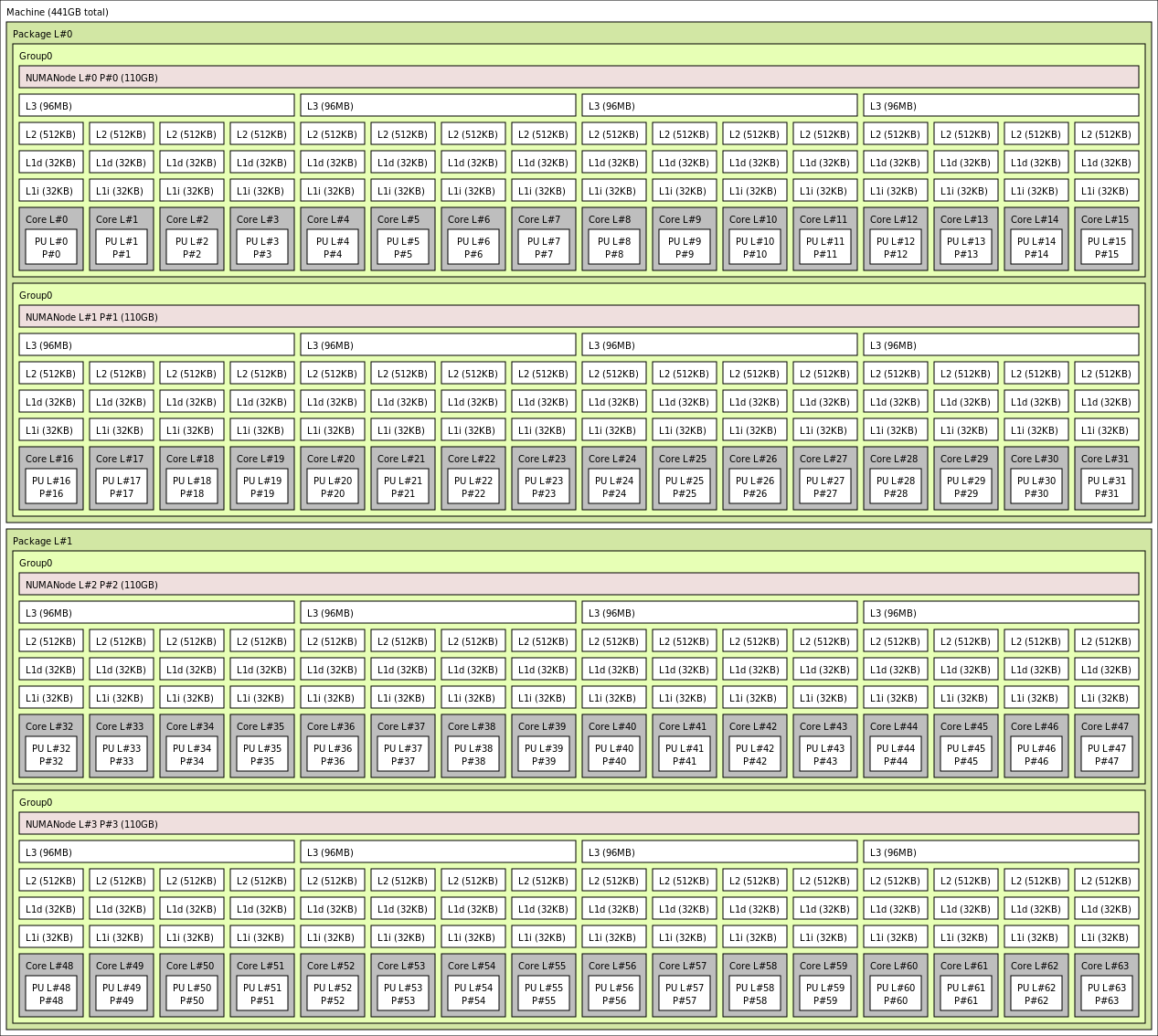

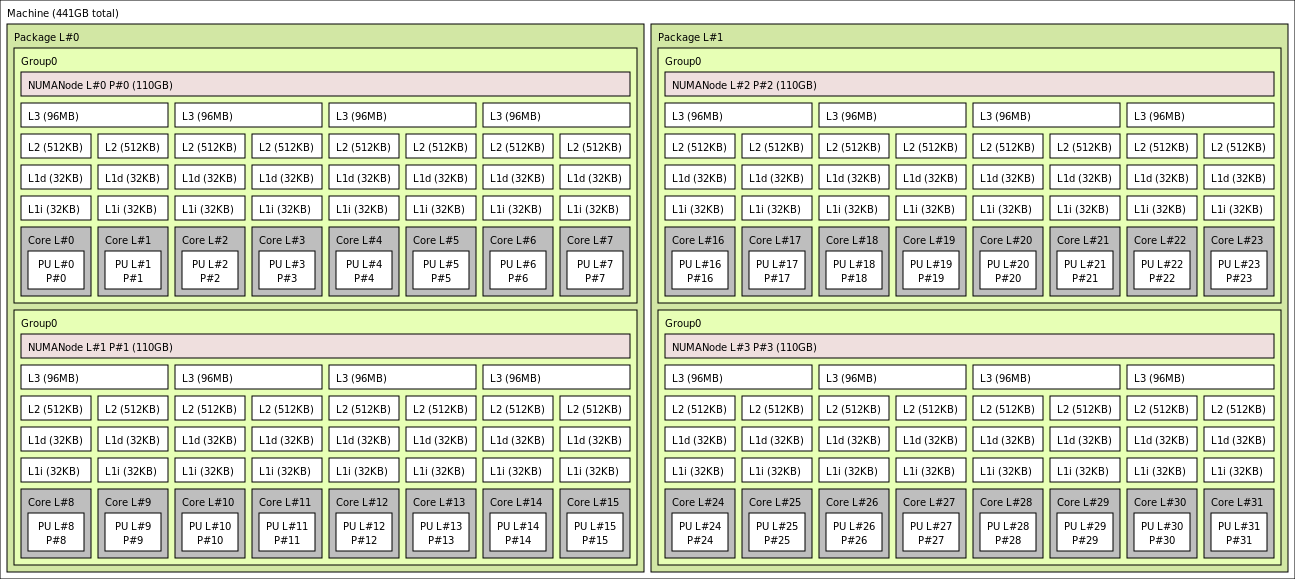

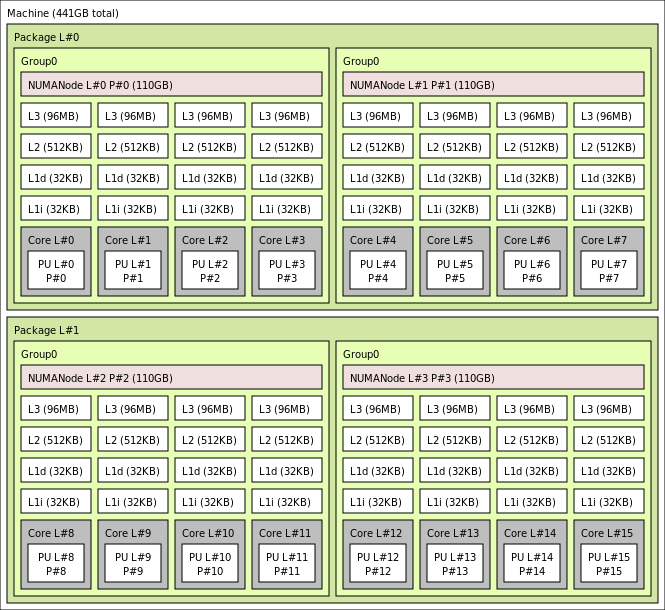

VM 拓撲

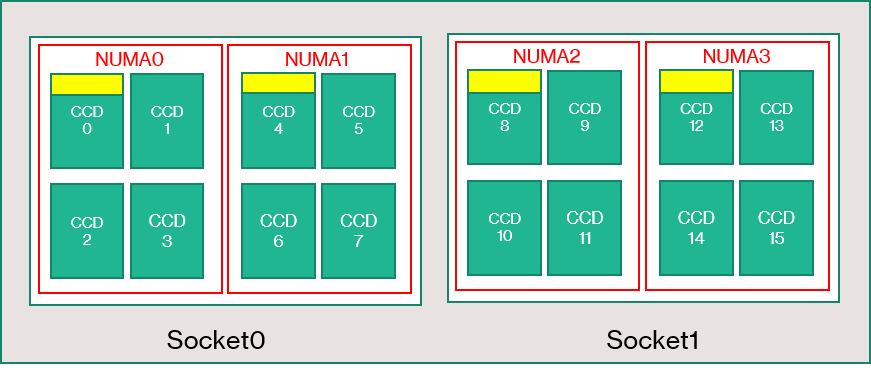

下圖說明伺服器的拓撲。 我們會在兩個 CPU 通訊端上以對稱方式保留這 8 個 Hypervisor 主機核心 (黃色),從每個 NUMA 網域上的特定 Core Complex Dies (CCD) 中取用前 2 個核心,其餘核心用於 HBv3 系列 VM (綠色)。

CCD 界限與 NUMA 界限並不相等。 在 HBv3 上,四個連續 (4) CCD 的群組會設為 NUMA 網域,主機伺服器層級和客體 VM 內皆有。 因此,所有 HBv3 VM 大小都會公開向 OS 和應用程式顯示的 4 個 NUMA 網域,如下所示。 4 個統一的 NUMA 網域,視特定 HBv3 VM 大小,每個網域有不同的核心數目。

每個 HBv3 VM 大小在實體配置、功能和效能上,與 AMD EPYC 7003 系列中不同的 CPU 相似,如下所示:

| HBv3 系列 VM 大小 | NUMA 網域 | 每個 NUMA 網域的核心 | 與 AMD EPYC 的相似性 |

|---|---|---|---|

| Standard_HB120rs_v3 | 4 | 30 | 雙通訊端 EPYC 7773X |

| Standard_HB120-96rs_v3 | 4 | 24 | 雙通訊端 EPYC 7643 |

| Standard_HB120-64rs_v3 | 4 | 16 | 雙通訊端 EPYC 7573X |

| Standard_HB120-32rs_v3 | 4 | 8 | 雙通訊端 EPYC 7373X |

| Standard_HB120-16rs_v3 | 4 | 4 | 雙通訊端 EPYC 72F3 |

注意

受限核心的 VM 大小只會減少向 VM 公開的實體核心數目。 所有全域共用資產 (RAM、記憶體頻寬、L3 快取、GMI 和 xGMI 連線能力、InfiniBand、Azure 乙太網路、本地 SSD) 均保持不變。 因此,客戶能根據特定的工作負載或軟體授權需求,挑選最適合的 VM 大小。

每個 HBv3 VM 大小的虛擬 NUMA 對應會對應至基礎實體 NUMA 拓撲。 對硬體拓撲沒有潛在的誤導性抽象概念。

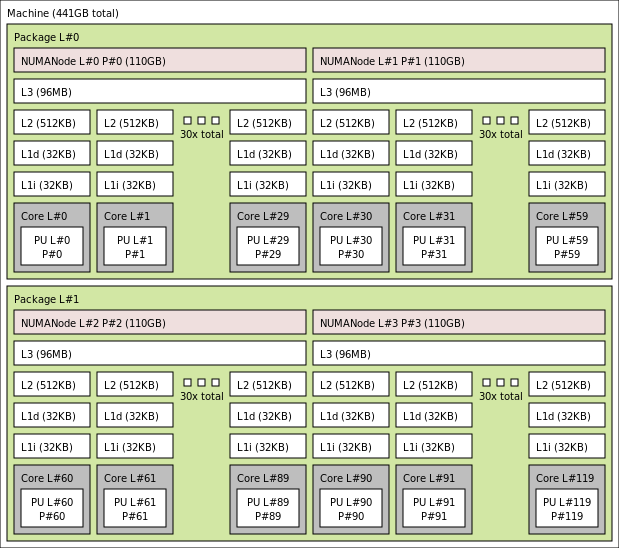

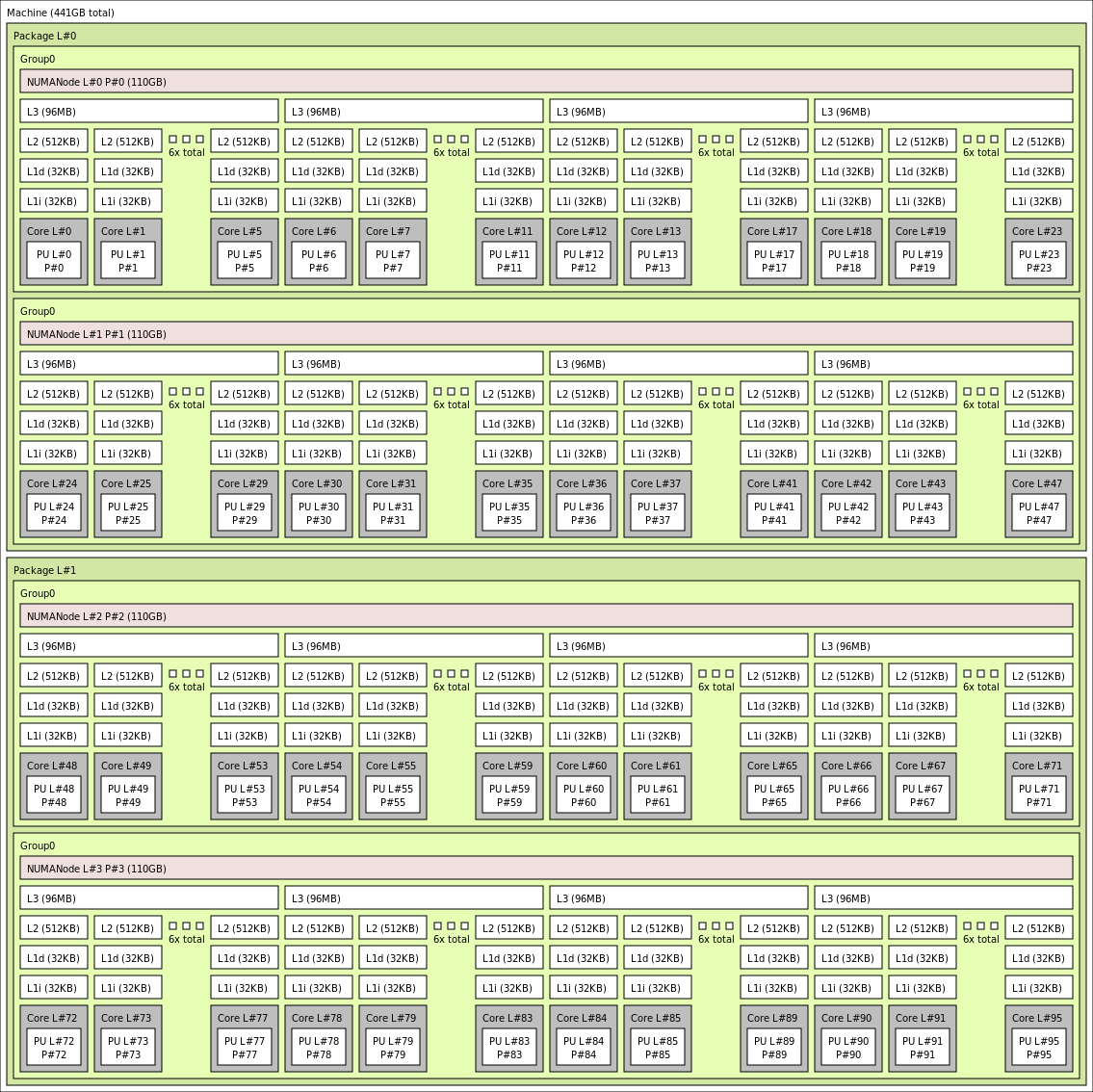

使用 lstopo 的輸出,各 HBv3 VM 大小 的確切拓撲如下所示:

lstopo-no-graphics --no-io --no-legend --of txt

按一下即可檢視 Standard_HB120rs_v3 的 lstopo 輸出

按一下即可檢視 Standard_HB120rs-96_v3 的 lstopo 輸出

按一下即可檢視 Standard_HB120rs-64_v3 的 lstopo 輸出

按一下即可檢視 Standard_HB120rs-32_v3 的 lstopo 輸出

按一下即可檢視 Standard_HB120rs-16_v3 的 lstopo 輸出

Infiniband 網路功能

HBv3 VM 也提供 Nvidia Mellanox HDR InfiniBand 網路介面卡 (ConnectX-6),最高能以 200 Gb/秒運作。NIC 會透過 SRIOV 傳遞至 VM,讓網路流量略過 Hypervisor。 因此,客戶能如同在裸機環境中一般,在 HBv3 VM 上載入標準的 Mellanox OFED 驅動程式。

HBv3 VM 支援適性路由、動態連線傳輸 (DCT,搭配標準 RC 和 UD 傳輸),以及 MPI 集合的硬體型卸載至 ConnectX-6 介面卡的機載處理器。 這些功能會增強應用程式效能、可擴縮性和一致性,我們建議使用這些功能。

暫存位置

HBv3 VM 具有 3 個實體的本地 SSD 裝置。 系統會將裝置預先格式化作為分頁檔,在您的 VM 中顯示為一般 "SSD" 裝置。

另外兩個較大的 SSD,會透過 NVMeDirect 提供為未格式化的區塊 NVMe 裝置。 當區塊 NVMe 裝置略過 Hypervisor 時,會有更高的頻寬與 IOPS,以及較低的每 IOP 延遲。

在等量陣列中配對時,NVMe SSD 最多能提供 7 GB/秒的讀取和 3 GB/秒的寫入,以及最高 186,000 IOPS (讀取) 和 201,000 IOPS (寫入),可取得較深的佇列深度。

硬體規格

| 硬體規格 | HBv3 系列 VM |

|---|---|

| 核心 | 120、96、64、32 或 16 (停用 SMT) |

| CPU | AMD EPYC 7V73X |

| CPU 頻率 (非 AVX) | 3.0 GHz (所有核心)、3.5 GHz (最多 10 核心) |

| 記憶體 | 448 GB (每個核心的 RAM 取決於 VM 大小) |

| 本機磁碟 | 2 * 960 GB NVMe (區塊)、480 GB SSD (頁面檔) |

| Infiniband | 200 Gb/秒 Mellanox ConnectX-6 HDR InfiniBand |

| 網路 | 50 Gb/秒 乙太網路 (40 Gb/秒 可用) Azure 第二代 SmartNIC |

軟體規格

| 軟體規格 | HBv3 系列 VM |

|---|---|

| MPI 作業大小上限 | 36,000 核心 (單一虛擬機器擴展集中的 300 個 VM 且 singlePlacementGroup=true) |

| MPI 支援 | HPC-X、Intel MPI、OpenMPI、MVAPICH2、MPICH |

| 其他架構 | UCX、libfabric、PGAS |

| Azure 儲存體支援 | 標準和進階磁碟 (最多 32 個磁碟) |

| SRIOV RDMA 的 OS 支援 | RHEL 7.9+、Ubuntu 18.04+、SLES 15.4、WinServer 2016+ |

| 效能建議作業系統 | Windows Server 2019+ |

| 協調器支援 | Azure CycleCloud、Azure Batch、AKS;叢集設定選項 |

注意

HBv3 和其他具有超過 64 個 (虛擬或實體) 核心的 VM 均不支援 Windows Server 2012 R2。 如需詳細資訊,請參閱 Windows Server 上 Hyper-V 支援的 Windows 客體作業系統。

重要

本文件參考即將或已處於生命週期結束 (EOL) 狀態的 Linux 版本。 請考慮更新為較新的版本。

下一步

- 請參閱 Azure 計算技術社群部落格的最新公告、HPC 工作負載範例和效能結果。

- 如需執行中 HPC 工作負載較高階的架構檢視,請參閱 Azure 上的高效能運算 (HPC)。