適用於:所有 API 管理層級

本文說明如何匯入與 OpenAI 相容的 Google Gemini API,以存取例如 的 gemini-2.0-flash模型。 針對這些模型,Azure API 管理可以管理 OpenAI 相容的聊天完成端點。

深入瞭解在 API 管理中管理 AI API:

先決條件

- 現有的 API 管理執行個體。 若您還沒有執行個體,請加以建立。

- Gemini API 的 API 金鑰。 如果您沒有帳戶,請在 Google AI Studio 建立它,並將其儲存在安全的位置。

使用入口網站匯入與 OpenAI 相容的 Gemini API

在 Azure 入口網站中,流覽至您的 API 管理實例。

在左側功能表 的 [API] 底下,選取 [API]>[+ 新增 API]。

在 [定義新的 API] 下,選取 [ 語言模型 API]。

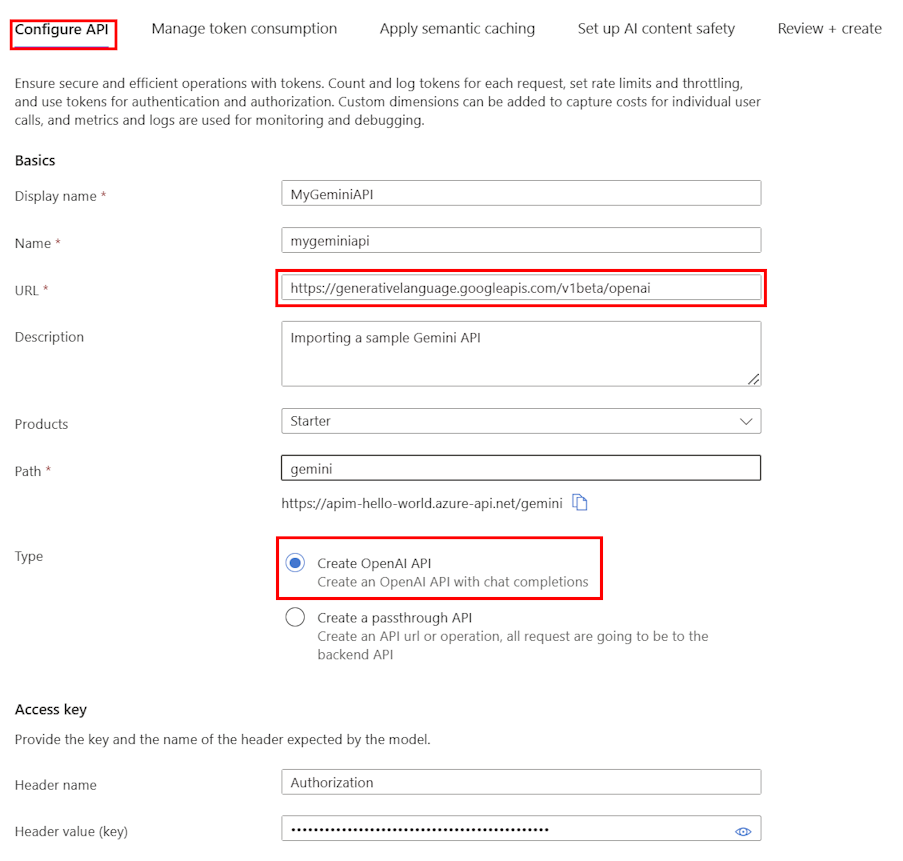

在 [設定 API] 索引標籤上:

輸入 API 的 [顯示名稱] 和選擇性 [描述]。

在 [URL] 中,輸入 Gemini OpenAI 兼容性文件中的下列基底 URL:

https://generativelanguage.googleapis.com/v1beta/openai在 路徑 中,新增 API 管理實例用於將請求路由到 Gemini API 端點的路徑。

在 [類型] 中,選取 [建立 OpenAI API]。

在 存取金鑰 中,輸入以下內容:

- 標頭名稱: 授權。

- 標頭值 (key):

Bearer後面接著您的 Gemini API 金鑰。

在其餘索引標籤上,選擇性地設定原則來管理權杖取用、語意快取和 AI 內容安全性。 如需詳細資訊,請參閱 匯入語言模型 API。

選取 檢閱。

驗證設定之後,請選取 [建立]。

API 管理會建立 API 並設定以下項目:

- 將 API 要求導至 Google Gemini 端點的 後端 資源和 set-backend-service 策略。

- 使用您提供的 Gemini API 金鑰存取 LLM 後端。 在 API 管理中,金鑰被保護為秘密的 具名值。

- (選擇性)可協助您監視和管理 API 的原則。

測試雙子座模型

匯入 API 之後,您可以測試 API 的聊天完成端點。

選取您在上一個步驟中建立的 API。

選取 [測試] 索引標籤。

選取

POST Creates a model response for the given chat conversation作業,這是對/chat/completions端點的POST要求。在 請求主體 區段中,輸入下列 JSON 來指定模型和範例提示。 在此範例中,使用了

gemini-2.0-flash模型。{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }測試成功時,後端會以成功的 HTTP 回應碼和某些資料進行回應。 附加至回應是令牌使用方式數據,可協助您監視和管理語言模型令牌耗用量。