負責任且受信任的 AI

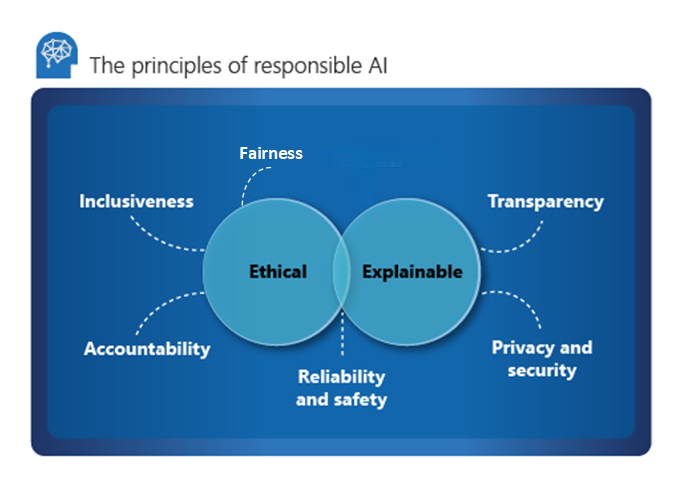

Microsoft概述負責 AI 的六個主要原則:責任、包容性、可靠性和安全性、公平性、透明度和安全性。 這些原則對於在進入主流產品和服務時建立負責任且值得信任的 AI 至關重要。 他們受到兩個觀點的指導:道德和可解釋。

倫理

從道德觀點來看,AI 應該:

- 在斷言中公平和包容。

- 對其決定負責。

- 不歧視或妨礙不同的種族、殘疾或背景。

2017年,Microsoft建立了一個 AI、道德和工程與研究效果的諮詢委員會。 委員會的核心責任是針對負責任 AI 的問題、技術、流程和最佳做法提供建議。

當責

責任是負責任 AI 的基本要素。 設計和部署 AI 系統的人員必須對其動作和決策負責,特別是隨著我們朝著更自主系統邁進。

組織應考慮建立內部檢閱機構,以提供開發和部署 AI 系統的監督、見解和指引。 此指引可能會因公司與區域而異,且應該反映組織的 AI 旅程。

包容性

包容性規定 AI 應該考慮所有人類和體驗。 包容性設計做法可協助開發人員瞭解並解決可能無意中排除人員的潛在障礙。 可能的話,組織應該使用語音轉換文字、文字到語音轉換和視覺辨識技術,讓聽力、視覺和其他障礙的人能夠使用。

公平性

公平性是所有人旨在理解和應用的核心道德原則。 開發 AI 系統時,此原則更為重要。 關鍵檢查和平衡需要確保系統的決定不會歧視或表達基於性別、種族、性取向或宗教的群體或個人偏見。

Microsoft提供 AI 公平性檢查清單 ,可提供 AI 系統的指引和解決方案。 這些解決方案會鬆散地分類為五個階段:構想、原型、建置、啟動和演進。 每個階段都會列出建議的盡職活動,以協助將系統不公平的影響降到最低。

Fairlearn 與 Azure 機器學習 整合,並支援數據科學家和開發人員評估及改善其 AI 系統的公平性。 它提供不公平風險降低演算法和互動式儀錶板,以可視化方式呈現模型的公平性。 組織應該使用工具組,並在建立模型時密切評估模型的公平性。 此活動應該是數據科學程式不可或缺的一部分。

瞭解如何 降低機器學習模型中的不公平性。

可靠性和安全性

若要讓 AI 系統受到信任,它們必須可靠且安全。 系統必須執行,因為它最初是設計,並安全地回應新的情況。 其固有的復原能力應該抵制預定或非預期的操作。

組織應針對作業條件建立嚴格的測試和驗證,以確保系統安全地回應邊緣案例。 它應該將 A/B 測試和冠軍/挑戰者方法整合到評估程式中。

AI 系統的效能可能會隨著時間而降低。 組織必須建立健全的監視和模型追蹤程式,以回應並主動測量模型的效能(並視需要重新定型其現代化)。

解釋

可解釋性可協助數據科學家、稽核員和商務決策者確保 AI 系統可以證明其決策的合理性,以及它們如何得出結論。 可解釋性也有助於確保符合公司原則、業界標準和政府法規。

數據科學家應該能夠向專案關係人說明他們如何達到特定程度的精確度,以及影響結果的內容。 同樣地,為了符合公司的原則,稽核員需要驗證模型的工具。 商務決策者需要藉由提供透明模型來獲得信任。

說明性工具

Microsoft已開發 InterpretML,這是一個開放原始碼工具組,可協助組織達成模型可解釋性。 它支援玻璃盒和黑箱模型:

玻璃盒模型因其結構而可解譯。 針對這些模型,可解釋的提升機器 (EBM) 會根據判定樹或線性模型提供演算法的狀態。 EBM 提供無損失的說明,並由領域專家編輯。

黑箱模型因複雜的內部結構類神經網路而更具挑戰性。 解釋器,例如本機可解譯模型無關的說明(LIME)或 SHapley Additive exPlanations(SHAP),藉由分析輸入和輸出之間的關聯性來解譯這些模型。

Fairlearn 是 Azure 機器學習 整合,以及 SDK 和 AutoML 圖形使用者介面的開放原始碼工具組。 它會使用解釋器來瞭解主要影響模型的內容,並使用領域專家來驗證這些影響。

若要深入瞭解可解釋性,請探索 Azure 機器學習 中的模型可解譯性。

透明

達成透明度可協助小組瞭解:

- 用來定型模型的數據和演算法。

- 套用至數據的轉換邏輯。

- 產生的最終模型。

- 模型的相關聯資產。

此資訊提供模型建立方式的深入解析,讓小組能以透明的方式重現模型。 Azure 機器學習 工作區內的快照集會記錄或重新定型實驗中涉及的所有訓練相關資產和計量,以支持透明度。

隱私權與安全性

數據持有者有義務保護 AI 系統中的數據。 隱私權和安全性是這個系統不可或缺的一部分。

個人資料必須受到保護,而且存取個人資料不應危害個人的隱私權。 Azure 差異隱私權 可藉由隨機化數據及新增雜訊來隱藏數據科學家的個人資訊,協助保護及保留隱私權。

人類 AI 指導方針

人類 AI 設計指導方針包含 18 個原則,這些原則會在四個期間發生:一開始,在互動期間、發生錯誤時,以及經過一段時間。 這些原則可協助組織產生更具包容性且以人為本的 AI 系統。

最初

釐清系統可以執行的動作。 如果 AI 系統使用或產生計量,請務必顯示它們及其追蹤方式。

釐清系統如何執行其作業。 協助用戶瞭解 AI 不完全正確。 設定 AI 系統何時可能會犯錯的預期。

在互動期間

顯示內容相關的資訊。 提供與使用者目前內容和環境相關的視覺資訊,例如附近的旅館。 傳回接近目標目的地和日期的詳細數據。

減輕社會偏見。 請確定語言和行為不會引入非預期的刻板印象或偏見。 例如,自動完成功能必須包含性別認同。

發生錯誤時

- 支援有效率的關閉。 提供簡單的機制來忽略或關閉不想要的功能或服務。

- 支援有效率的更正。 提供直覺的方式,讓您更輕鬆地編輯、精簡或復原。

- 明確為什麼系統做了它所做的。 將可解釋的 AI 優化,以提供 AI 系統判斷提示的相關深入解析。

經過一段時間

- 請記住最近的互動。 保留互動的歷程記錄以供日後參考。

- 從用戶行為中學習。 根據用戶的行為個人化互動。

- 謹慎更新並調整。 限制干擾性變更,並根據使用者的配置檔進行更新。

- 鼓勵細微的意見反應。 從使用者與 AI 系統的互動中收集用戶意見反應。

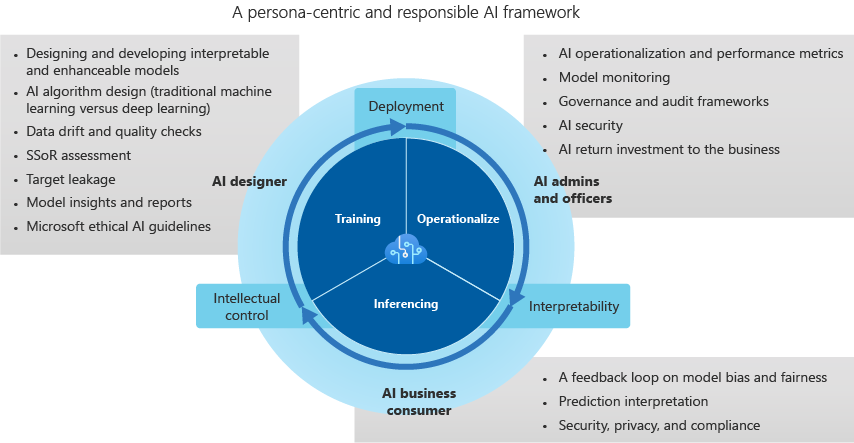

受信任的 AI 架構

AI 設計工具

AI 設計工具會建置模型,並負責:

數據漂移和質量檢查。 設計工具會偵測極端值,並執行數據品質檢查來識別遺漏值。 設計工具也會標準化散發、仔細審查數據,併產生使用案例和項目報告。

評估系統來源中的數據,以找出潛在的偏差。

設計 AI 演算法以將數據偏差降到最低。 這些工作包括探索量化、分組和正規化(特別是在以樹狀結構為基礎的傳統機器學習模型)如何消除少數群體的數據。 類別 AI 設計會藉由將依賴受保護健康資訊 (PHI) 和個人資料的產業垂直中的社交、種族和性別類別分組,來重申數據偏差。

優化監視和警示,以識別目標外泄,並強化模型的開發。

建立報告和深入解析的最佳做法,以提供對模型的細微瞭解。 設計工具會避免使用特徵或向量重要性、統一 Manifold 近似值和投影 (UMAP) 群集、弗裡德曼的 H 統計數據、特徵效果和相關技術等黑箱方法。 識別計量有助於定義複雜與新式數據集中相互關聯之間的預測影響、關聯性和相依性。

AI 系統管理員和官員

AI 系統管理員和官員會監督 AI、治理和稽核架構作業和效能計量。 他們也會監督 AI 安全性的實作方式,以及企業的投資報酬率。 其工作包括:

監視可協助模型監視的追蹤儀錶板,並結合生產模型的模型計量。 儀錶板著重於推斷速度/錯誤的正確性、模型降低、數據漂移、偏差和變更。

實作彈性部署和重新部署(最好是透過 REST API),讓模型實作成開放、無從知的架構。 此架構會將模型與商務程式整合,併產生意見反應循環的價值。

致力於建置模型治理和存取權,以設定界限並減輕負面業務和營運影響。 角色型訪問控制 (RBAC) 標準會決定安全性控制,以保留受限制的生產環境和IP。

使用 AI 稽核和合規性架構來追蹤模型如何開發和變更,以維護業界特定標準。 可解譯且負責任的 AI 建立在可解釋性量值、簡潔的功能、模型視覺效果和產業垂直語言上。

AI 商務取用者

AI 商務消費者(商務專家)會關閉意見反應迴圈,並為 AI 設計工具提供輸入。 預測性決策和潛在偏差影響,例如公平性和道德措施、隱私權和合規性,以及商務效率有助於評估 AI 系統。 以下是商務取用者的一些考慮:

意見反應迴圈屬於企業的生態系統。 顯示模型偏差、錯誤、預測速度和公平性的數據,可建立 AI 設計工具、系統管理員和官員之間的信任和平衡。 以人為本的評估應該隨著時間逐漸改善 AI。

將來自多維度、複雜數據的 AI 學習降至最低,有助於防止有偏差的學習。 這項技術稱為「小於一次性」(LO-shot)學習。

使用可解釋性設計和工具可讓 AI 系統負責潛在偏差。 模型偏差和公平性問題應標幟並饋送至警示和異常偵測系統,以學習此行為並自動解決偏差。

每個預測值都應該依重要性或影響細分成個別特徵或向量。 它應該提供完整的預測說明,可匯出至商務報告,以進行稽核和合規性檢閱、客戶透明度和商務整備。

由於全球安全性和隱私權風險增加,在推斷期間解決數據違規的最佳做法需要遵守個別產業的垂直法規。 範例包括與 PHI 和個人資料不相容的警示,或違反國家/地區安全法的警示。

下一步

探索 人類 AI 指導方針 ,以深入瞭解負責任的 AI。

意見反應

即將登場:在 2024 年,我們將逐步淘汰 GitHub 問題作為內容的意見反應機制,並將它取代為新的意見反應系統。 如需詳細資訊,請參閱:https://aka.ms/ContentUserFeedback。

提交並檢視相關的意見反應