使用 AKS 上的 Azure HDInsight 處理 Apache Flink® 上的即時 IoT 數據

Azure IoT 中樞是託管於雲端中的受控服務,可做為 IoT 應用程式及其附加裝置之間進行通訊的中央訊息中樞。 您可以可靠且安全地將數百萬個裝置與其後端解決方案連線。 幾乎任何裝置都可以連線到IoT中樞。

在此範例中,程式代碼會使用 AKS 上的 Azure HDInsight 處理 Apache Flink® 上的即時 IoT 數據,並接收至 ADLS gen2 記憶體。

必要條件

- 建立 Azure IoTHub

- 在 AKS 上的 HDInsight 上建立 Flink 叢集 1.17.0

- 使用 MSI 存取 ADLS Gen2

- 用於開發的 IntelliJ

注意

在此示範中,我們會使用 Window VM 作為 maven 專案,在 AKS 上與 HDInsight 相同的 VNET 中開發 env。

AKS 上的 HDInsight 上的 Flink 叢集 1.17.0

Azure 入口網站 上的 Azure IOT 中樞

在 連接字串 內,您可以找到服務總線 URL(基礎事件中樞命名空間的 URL),您必須在 Kafka 來源中新增為啟動程式伺服器。 在此範例中為 iothub-ns-contosoiot-55642726-4642a54853.servicebus.windows.net:9093。

準備訊息到 Azure IOT 裝置

每個IoT中樞都隨附內建系統端點,以處理系統和裝置訊息。

如需詳細資訊,請參閱如何使用 VS Code 作為裝置模擬器 IoT 中樞。

Flink 中的程序代碼

IOTdemo.java

KafkaSource:IoTHub 建置在事件中樞之上,因此支持類似 kafka 的 API。 因此,在我們的 Flink 作業中,我們可以使用適當的參數來定義 KafkaSource,以取用來自 IoTHub 的訊息。

FileSink:定義 ABFS 接收。

package contoso.example

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.api.common.serialization.SimpleStringEncoder;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.client.program.StreamContextEnvironment;

import org.apache.flink.configuration.MemorySize;

import org.apache.flink.connector.file.sink.FileSink;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.sink.filesystem.rollingpolicies.DefaultRollingPolicy;

import org.apache.kafka.clients.consumer.OffsetResetStrategy;

import java.time.Duration;

public class IOTdemo {

public static void main(String[] args) throws Exception {

// create execution environment

StreamExecutionEnvironment env = StreamContextEnvironment.getExecutionEnvironment();

String connectionString = "<your iot hub connection string>";

KafkaSource<String> source = KafkaSource.<String>builder()

.setBootstrapServers("<your iot hub's service bus url>:9093")

.setTopics("<name of your iot hub>")

.setGroupId("$Default")

.setProperty("partition.discovery.interval.ms", "10000")

.setProperty("security.protocol", "SASL_SSL")

.setProperty("sasl.mechanism", "PLAIN")

.setProperty("sasl.jaas.config", String.format("org.apache.kafka.common.security.plain.PlainLoginModule required username=\"$ConnectionString\" password=\"%s\";", connectionString))

.setStartingOffsets(OffsetsInitializer.committedOffsets(OffsetResetStrategy.EARLIEST))

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

DataStream<String> kafka = env.fromSource(source, WatermarkStrategy.noWatermarks(), "Kafka Source");

String outputPath = "abfs://<container>@<account_name>.dfs.core.windows.net/flink/data/azureiothubmessage/";

final FileSink<String> sink = FileSink

.forRowFormat(new Path(outputPath), new SimpleStringEncoder<String>("UTF-8"))

.withRollingPolicy(

DefaultRollingPolicy.builder()

.withRolloverInterval(Duration.ofMinutes(2))

.withInactivityInterval(Duration.ofMinutes(3))

.withMaxPartSize(MemorySize.ofMebiBytes(5))

.build())

.build();

kafka.sinkTo(sink);

env.execute("Sink Azure IOT hub to ADLS gen2");

}

}

Maven pom.xml

<groupId>contoso.example</groupId>

<artifactId>FlinkIOTDemo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<flink.version>1.17.0</flink.version>

<java.version>1.8</java.version>

<scala.binary.version>2.12</scala.binary.version>

</properties>

<dependencies>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-java -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-clients -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-connector-files -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-files</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka</artifactId>

<version>${flink.version}</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<version>3.0.0</version>

<configuration>

<appendAssemblyId>false</appendAssemblyId>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

封裝 jar 並在 Flink 叢集中提交作業

將 jar 上傳至 webssh Pod 並提交 jar。

user@sshnode-0 [ ~ ]$ bin/flink run -c IOTdemo -j FlinkIOTDemo-1.0-SNAPSHOT.jar

SLF4J: Failed to load class "org.slf4j.impl.StaticLoggerBinder".

SLF4J: Defaulting to no-operation (NOP) logger implementation

SLF4J: See http://www.slf4j.org/codes.html#StaticLoggerBinder for further details.

Job has been submitted with JobID de1931b1c1179e7530510b07b7ced858

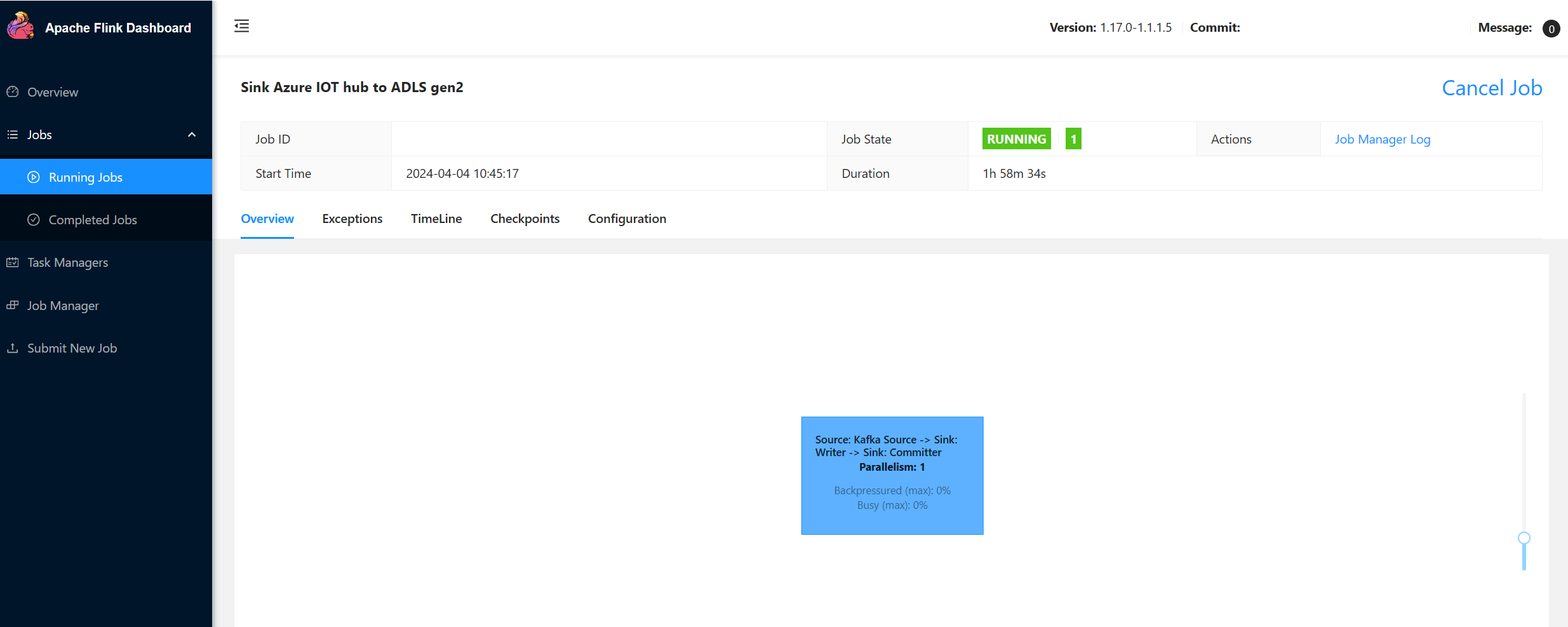

檢查 Flink 儀錶板 UI 上的作業

在 Azure 入口網站 上檢查 ADLS gen2 的結果

參考

- Apache Flink 網站

- Apache、Apache Kafka、Kafka、Apache Flink、Flink 和相關聯的 開放原始碼 項目名稱是 Apache Software Foundation (ASF) 的商標。