適用於 Azure 的 WANdisco LiveData Platform 會將數 PB 的內部部署 Hadoop 數據遷移至 Azure Data Lake Storage 檔系統,而不會中斷數據作業或需要停機。 平臺的連續檢查會防止資料遺失,並在指的兩端保持一致,即使是在修改時也一樣。

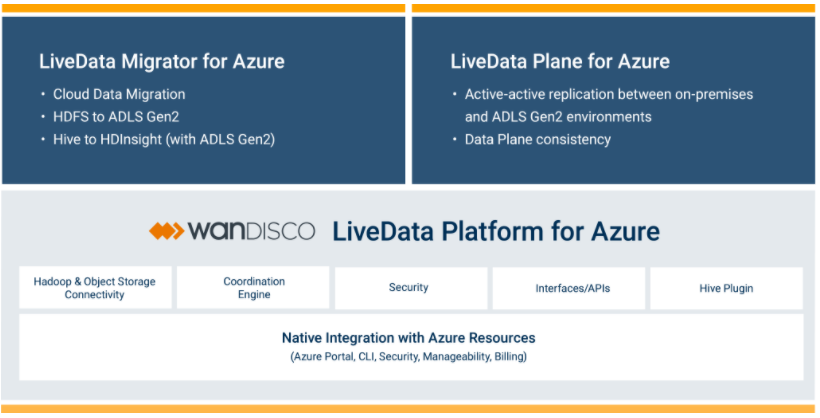

此平台是由兩個服務所組成。 LiveData Migrator for Azure 會將使用中的資料從內部部署環境遷移至 Azure 儲存體,而 LiveData Plane for Azure 可確保所有修改或內嵌的資料都能以一致的方式複寫。

使用 Azure 入口網站和 Azure CLI 來管理這兩項服務。 每項服務皆適用於和所有其他 Azure 服務相同的計量付費、隨用隨付計費模型:適用於 Azure 之即時資料平台中的資料耗用量將會出現在每月的 Azure 帳單上,並提供使用計量。

不同於將靜態資訊複製到 Azure 資料箱,或使用DistCp之類的 Hadoop 工具來將資料離線遷移,您可以在使用 WANdisco 即時資料活頁 for Azure 進行線上遷移期間,維護商務系統的完整運作。 即使在將資料移至 Azure 時,仍可讓您的大型資料環境保持運作。

WANdisco LiveData Platform for Azure 主要優點

WANdisco LiveData Platform for Azure 的廣域網路可達成資料一致性,並大規模進行即時資料複寫。 如需詳細資訊,請參閱下列影片:

平臺的主要優點包括下列各項:

資料精確度:端對端驗證資料可防止資料遺失,並確保傳輸的資料適合使用。

資料一致性:即使環境持續變更,仍會讓資料磁碟區在環境之間保持一致。

資料效率:持續傳輸大型資料磁碟區,並完全掌控頻寬耗用量。

停機時間刪除:在遷移期間,在其他應用程式中自由建立、修改、讀取和刪除資料,而不需要在資料指至 Azure 期間中斷商務作業。 繼續操作應用程式、分析基礎結構、內嵌作業和其他處理。

簡單使用:使用平台 Azure 整合來建立、設定、排程和追蹤自動化遷移的進度。 此外,請視需要設定選擇性的資料複寫、Hive 中繼資料、資料安全性和機密性。

WANdisco LiveData Platform for Azure 主要功能

平台的主要功能包括下列各項:

中繼資料移轉:除了 HDFS 資料以外,還可以使用 LiveData Migrator for Azure 移轉來自 Hive 和其他儲存體的中繼資料。

排程的傳輸:使用 LiveData Migrator for Azure 來控制及自動化資料傳輸將在何時起始,而不需要手動將變更遷移至資料。

Kerberos:LiveData Migrator for Azure 支援 Kerberized 叢集。

排除範本:在 LiveData Migrator for Azure 中建立規則,以防止特定檔案大小或檔案名 (使用 Glob 模式定義),無法遷移至目標儲存體。 在 Azure 入口網站中或使用 CLI 建立排除範本,並將它們套用至任意數目的遷移。

路徑對應:定義特定目的檔案系統的替代目標路徑,以自動將傳送的資料移至您指定的目錄。

頻寬管理:設定 LiveData Migrator for Azure 的最大網路頻寬量,以防止頻寬過度耗用量。

排除專案:定義範本查詢以防止遷移符合準則的任何檔案和目錄,讓您可以選擇性地從來源系統移轉資料。

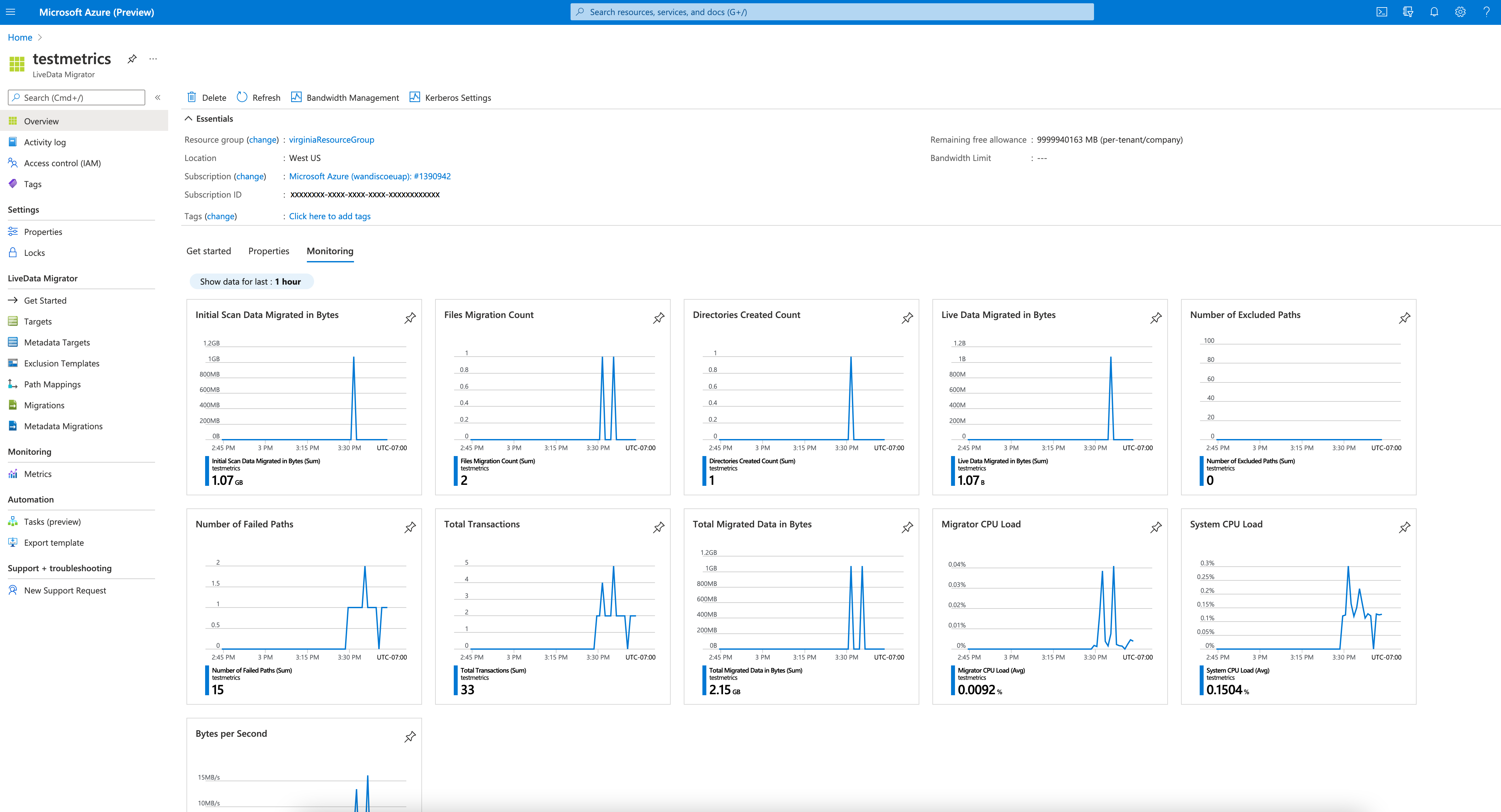

計量:在 LiveData Migrator for Azure 中查看資料傳輸的詳細資料,例如隨時間傳輸的檔案、排除的路徑、無法傳送的專案等等。

更快速地遷移大型資料,而不會有風險

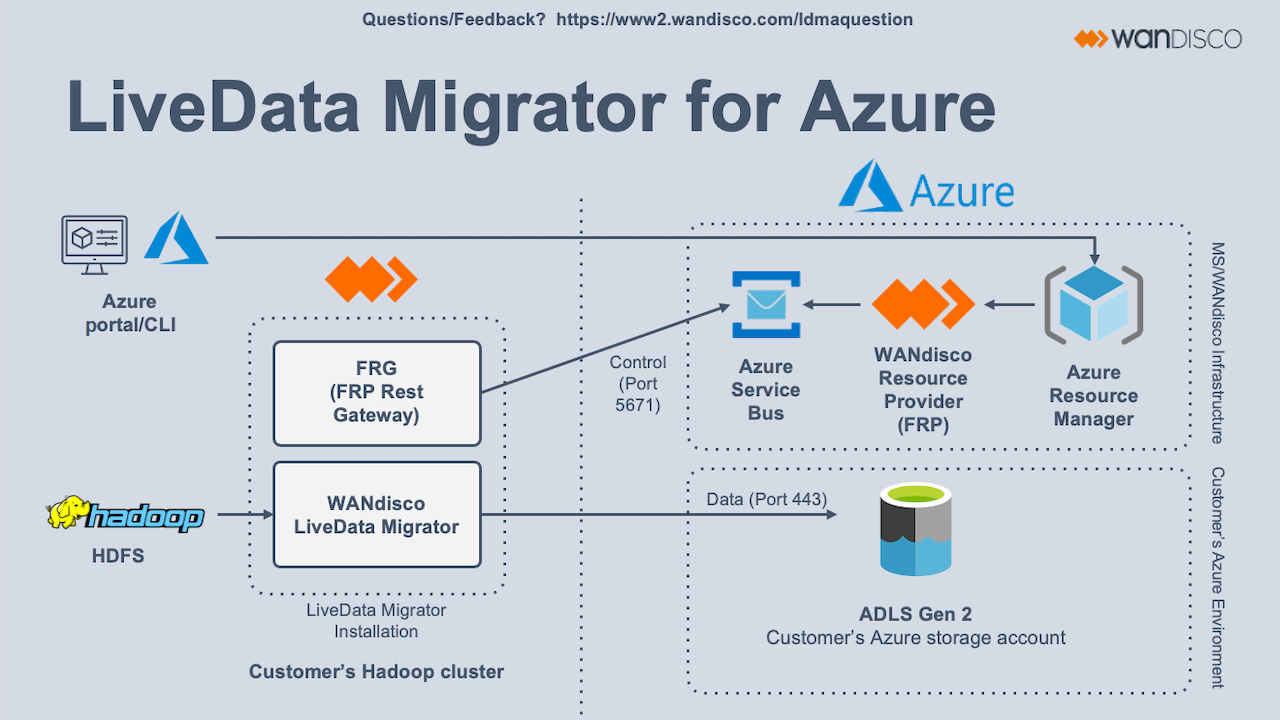

WANdisco LiveData Platform for Azure 中包含的第一個服務是 LiveData Migrator for Azure,可將資料從內部部署環境遷移至 Azure 儲存體。 當您將 LiveData Migrator 部署到內部部署 Hadoop 叢集之後,它會自動為您的檔案系統建立最佳設定。 請從該處提供系統的 Kerberos 詳細資料。 接著,LiveData Migrator for Azure 將會準備好將資料移轉至 Azure 儲存體。

開始使用 LiveData Migrator for Azure 之前,請先檢查這些必要條件。

若要執行遷移:

在 Azure CLI:

- 藉由

az provider register --namespace Wandisco.Fusion --consent-to-permissions執行,在 Azure CLI 中註冊 WANdisco 資源提供者。 - 藉由

az vm image terms accept --offer ldma --plan metered-v1 --publisher Wandisco --subscription <subscriptionID>執行,接受即時資料活頁平臺的計量計費期限。

- 藉由

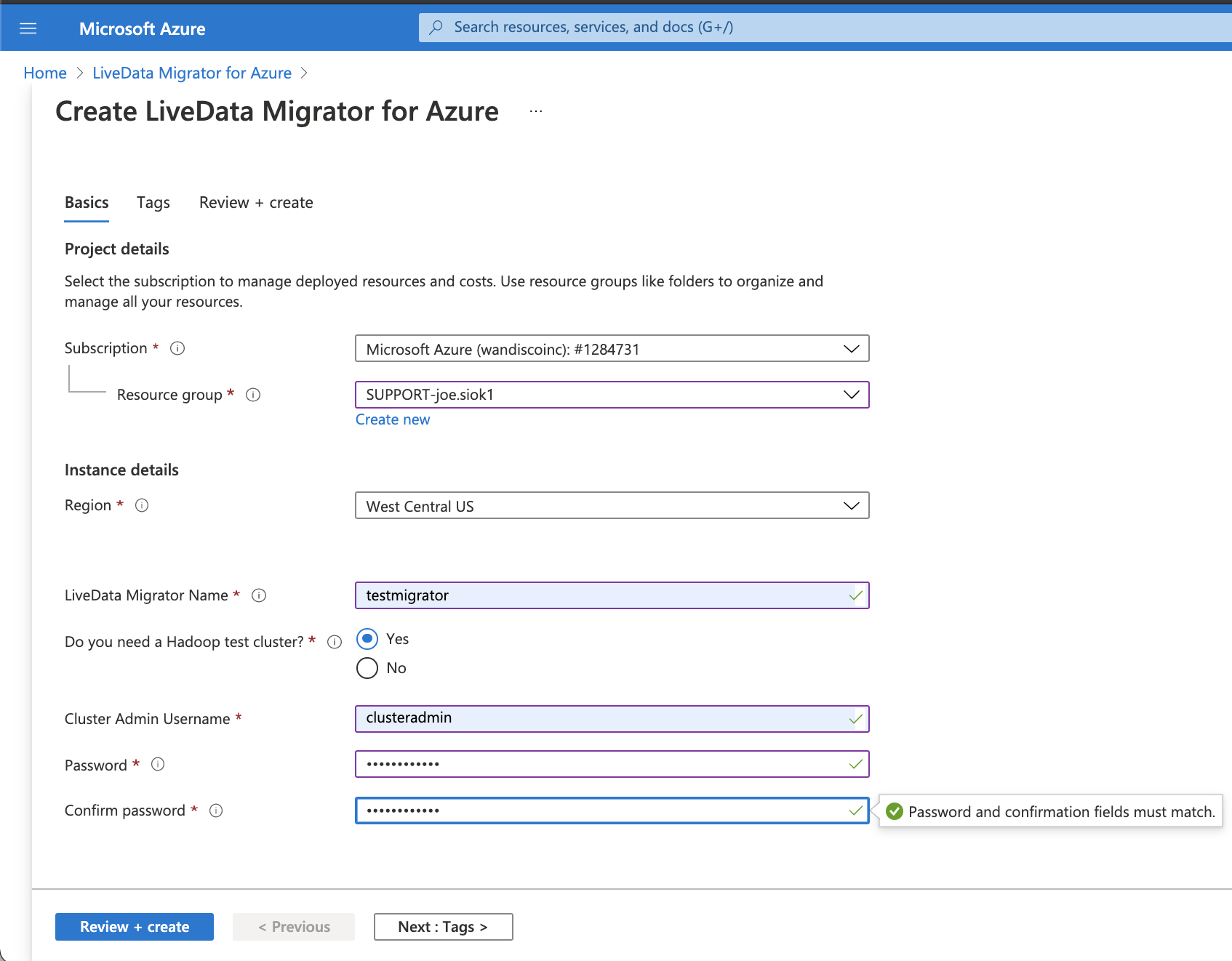

從 Azure 入口網站將LiveData Migrator 執行個體部署至您的內部部署 Hadoop 叢集。 (您不需要變更或重新啟動叢集。)

注意

WANdisco LiveData Migrator for Azure 會提供建立 Hadoop 測試叢集的選項。

設定 Kerberos 詳細資料 (如果適用)。

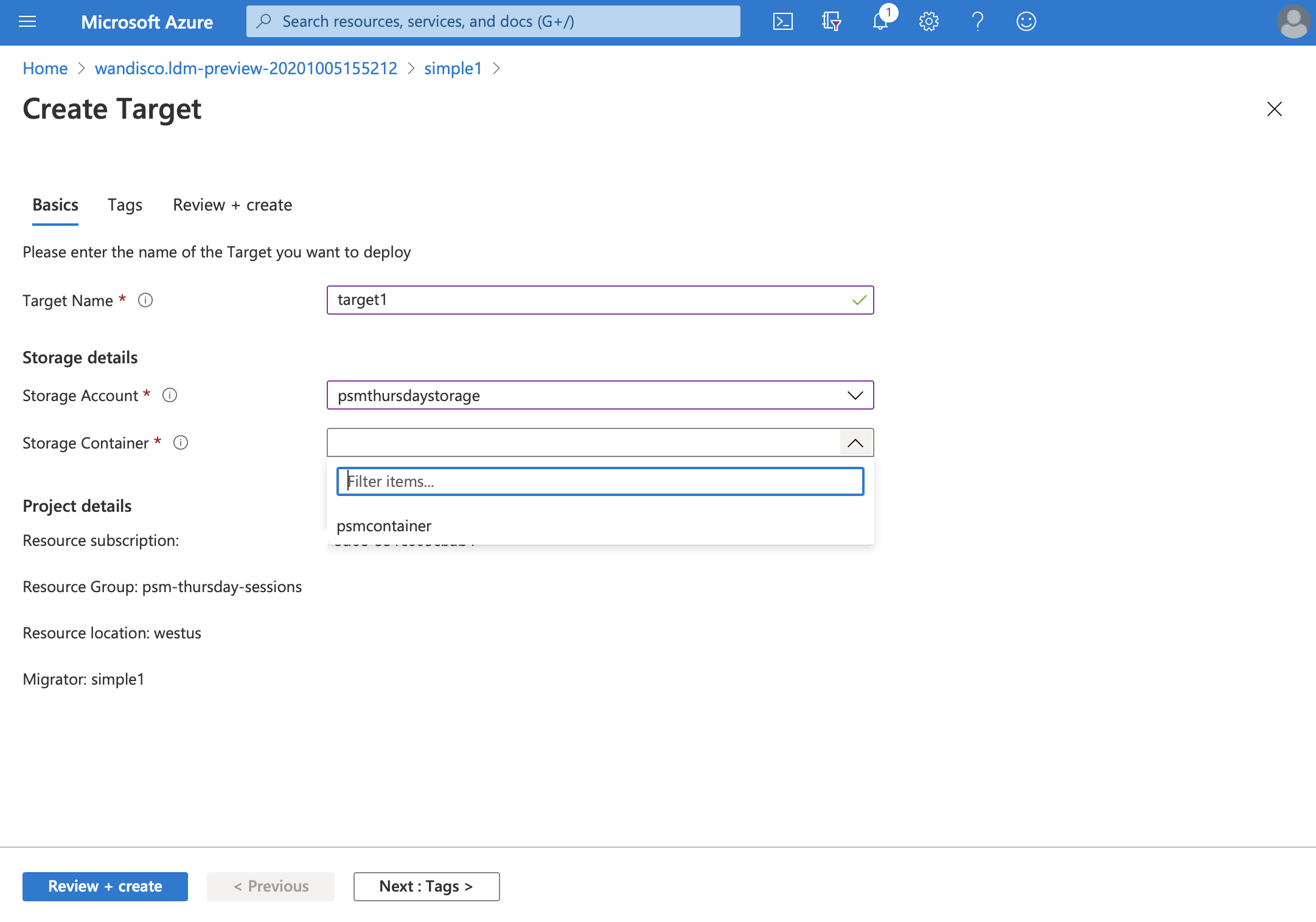

定義已啟用 Azure Data Lake Storage 的目標記憶體帳戶。

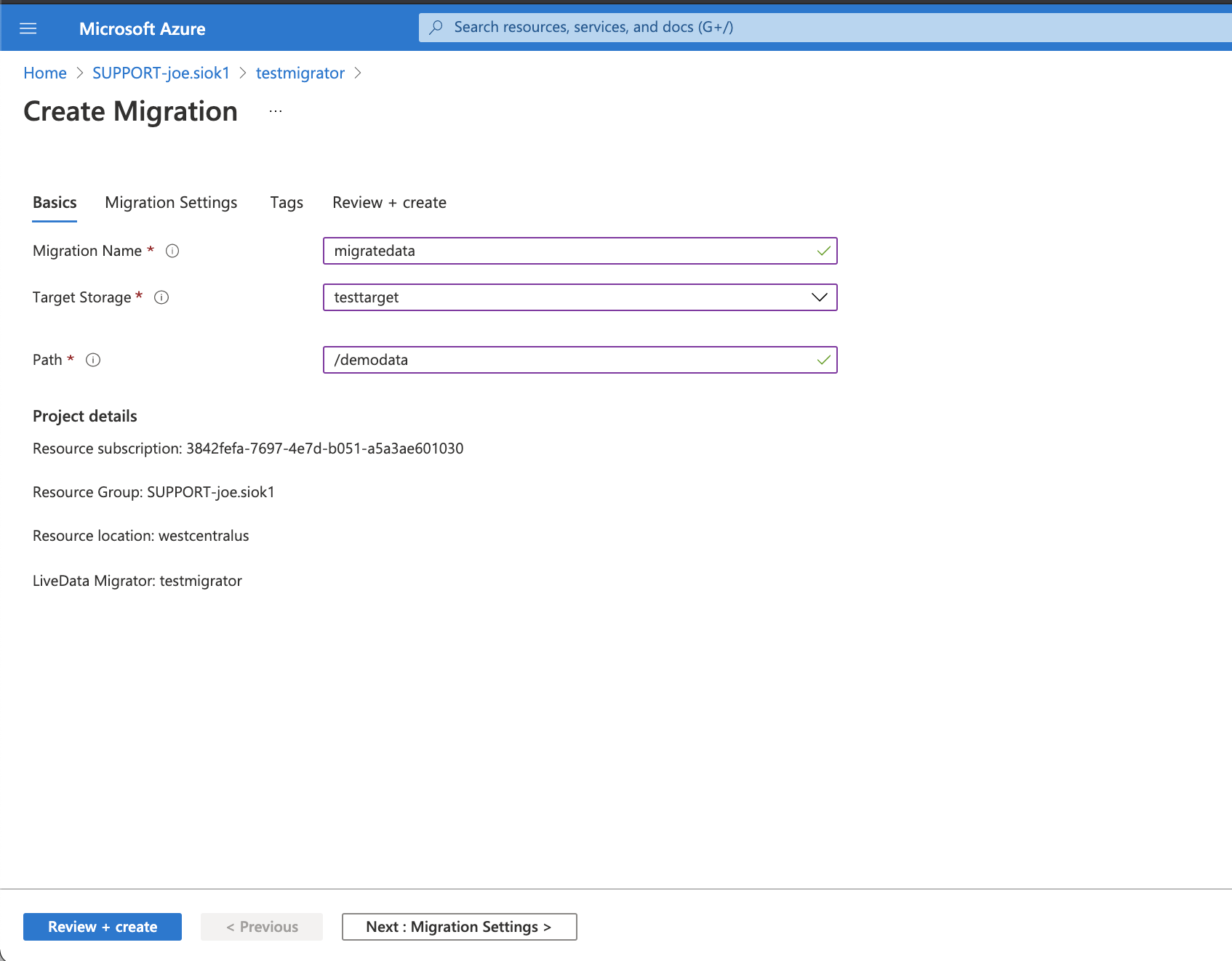

定義您想要遷移之資料的位置,例如:

/user/hive/warehouse。

開始移轉。

透過標準 Azure 工具(包括 Azure CLI 和 Azure 入口網站)來監視您的遷移進度。

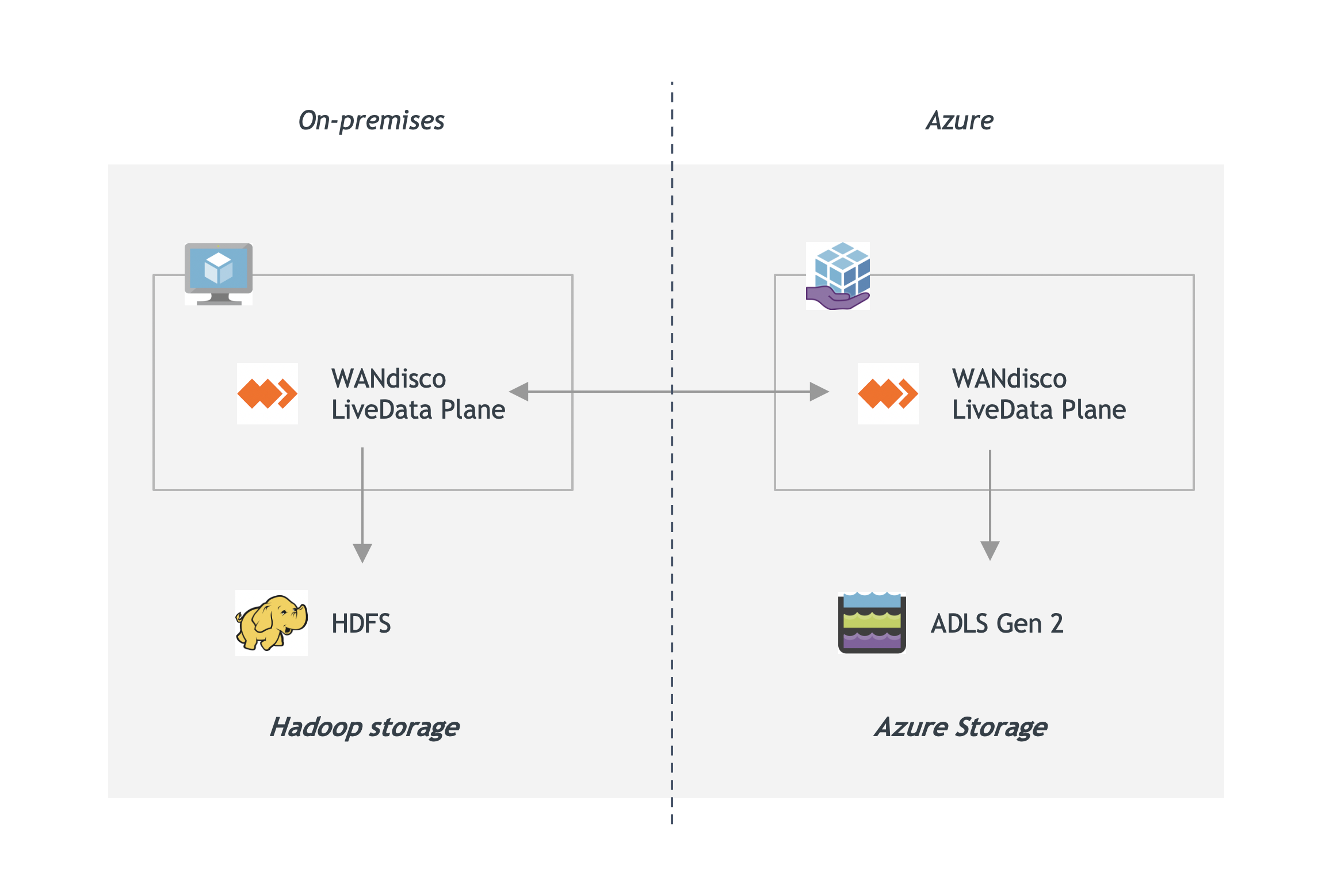

雙向使用 LiveData Plane for Azure,在作用中變更時複寫資料

即時資料活頁平臺中包含的第二個服務是 LiveData Plane for Azure。 即時資料活頁平面使用 WANdisco 的協調引擎,讓資料在許多內部部署 Hadoop 叢集和 Azure 儲存體之間保持一致,方法是以智慧方式將變更套用到所有系統上的資料,以移除不同使用點的資料衝突風險。

初始遷移之後,請讓您的資料與 LiveData Plane for Azure 保持一致:

從 Azure 入口網站開始,在內部部署和 Azure 中部署 LiveData Plane for Azure。 不需要變更任何應用程式。

設定複寫規則,以涵蓋您想要保持一致的資料位置,例如:

/user/contoso/sales/region/WA。執行應用程式,以在您需要的任一位置存取和修改資料。

LiveData Plane for Azure 會一致地跨所有環境複寫資料變更,而不會對叢集作業或應用程式效能造成重大影響。

試用產品或試用版

從 即時資料活頁 Platform For Azure 的 Marketplace 頁面,您有兩個選項:

[立即取得] 按鈕會啟動訂用帳戶中的服務。 從該處,您可以使用自己的 Hadoop 叢集或 WANdisco 的試用叢集。

選取 [測試磁碟機],即可在為您預先設定的已託管環境中測試 LiveData Migrator for Azure。 這可讓您在將其新增至訂用帳戶之前,先試用 LiveData Migrator for Azure,而不會對您的資料產生任何成本或風險。