Apache Spark 應用程式詳細資料監視

透過 Microsoft Fabric,您可以使用 Apache Spark 在工作區中執行筆記本、作業和其他類型的應用程式。 本文介紹如何監控 Apache Spark 應用程式,讓您可以專注於作業的最新執行狀態、問題和進度。

檢視 Apache Spark 應用程式

您可以從 Spark 作業定義檢視所有 Apache Spark 應用程式,或筆記本項目操作功能表會顯示最近的執行選項 ->最近執行。

您可以在應用程式清單中選取您想要檢視的應用程式名稱,在應用程式詳細資料頁面中,您可以檢視應用程式詳細資料。

監視 Apache Spark 應用程式狀態

開啟筆記本或 Spark 作業定義的最近執行 頁面,您可以檢視 Apache 應用程式的狀態。

- 成功

- 佇列

- 已停止

- 已取消

- 失敗

工作

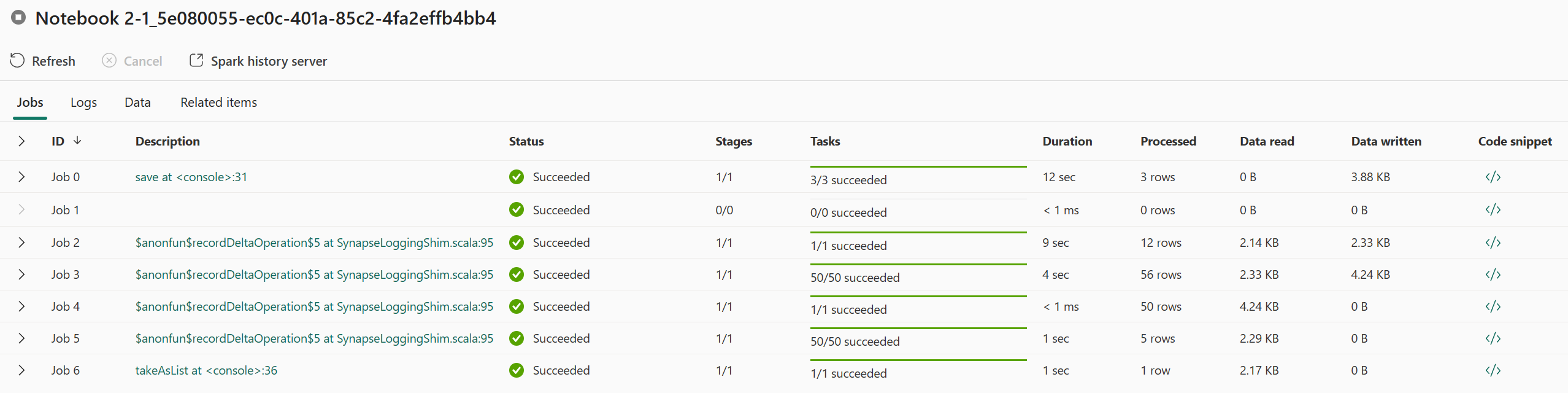

從 Spark 作業定義或筆記本項目操作功能表開啟 Apache Spark 應用程式作業,會顯示最近執行選項 ->最近執行 -> 在最近的執行頁面中選取作業。

在 Apache Spark 應用程式監視詳細資料頁面中,作業執行清單會顯示在作業 索引標籤中,您可以在這裡檢視每個作業的詳細資料,包括作業標識碼、描述、狀態、階段、工作、持續時間、處理、資料讀取、寫入的資料和代碼段。

- 按兩下作業標識符 即可展開/折迭作業。

- 按兩下作業描述,即可跳至Spark UI中的作業或階段頁面。

- 按兩下作業代碼段,您可以檢查並複製與此作業相關的程式碼。

資源(預覽)

執行程式使用狀況圖表會以可視化方式顯示 Spark 作業執行程式和資源使用量的配置。 目前,只有Spark 3.4和更新版本的執行階段資訊才會顯示這項功能。 選取資源(預覽),然後起草執行程式使用方式的四種類型曲線,包括執行中、閒置、已配置、最大執行個體。

針對已配置,是指在Spark應用程式執行期間配置的核心情況。

針對最大執行個體,是指配置給 Spark 應用程式的核心數目上限。

針對執行,是指Spark 應用程式在執行時所使用的實際核心數目。 按兩下 Spark 應用程式執行時的時間點。 您可以在圖形底部看到執行中的執行程式核心設定詳細資料。

針對Idled,它是Spark應用程式執行時未使用的核心數目。

在某些情況下,在某些情況下,工作數目可能會超過執行程式核心的容量(亦即工作編號 > 總計執行程式核心/spark.task.cpus)。 這是如預期般,因為標示為正在執行的工作之間有時間差距,而且它實際上是在執行程式核心上執行。 因此,某些工作可能會顯示為執行中,但不會在任何核心上執行。

選取色彩圖示,以選取或取消選取所有圖表中的對應內容。

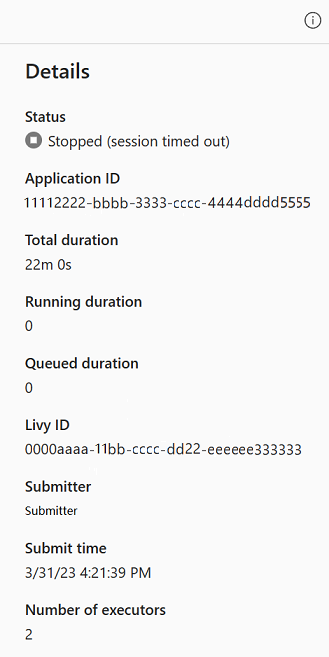

摘要面板

在Apache Spark 應用程式監視 頁面中,按兩下 屬性按鈕以開啟/折疊摘要面板。 您可以在詳細資料 中檢視此應用程式的詳細資料。

- 此 Spark 應用程式的狀態。

- 此 Spark 應用程式的識別碼。

- 總期間

- 此 Spark 應用程式的執行持續時間。

- 此 Spark 應用程式的佇列持續時間。

- Livy ID

- 此 Spark 應用程式的提交者。

- 提交此 Spark 應用程式的時間。

- 執行程式數目。

記錄

針對記錄 索引標籤,您可以檢視 Livy、Prelaunch、Driver 記錄的完整記錄,並在左面板中選取不同的選項。 並且可以透過搜尋關鍵字直接擷取所需的日誌資訊,並透過過濾日誌狀態查看日誌。 按兩下下載記錄檔 將記錄資訊下載到本機。

有時候沒有可用的記錄,例如作業的狀態已排入佇列,叢集建立失敗。

只有在應用程式提交失敗時,才能使用即時記錄,而且也會提供驅動程序記錄。

資料

針對 資料 索引標籤,您可以在剪貼簿上複製資料清單、下載資料清單和單一資料,以及檢查每個資料的屬性。

- 左面板可以展開或折疊。

- 輸入和輸出檔案的名稱、讀取格式、大小、來源和路徑將會在此清單中顯示。

- 輸入和輸出中的檔案可以下載、複製路徑和檢視屬性。

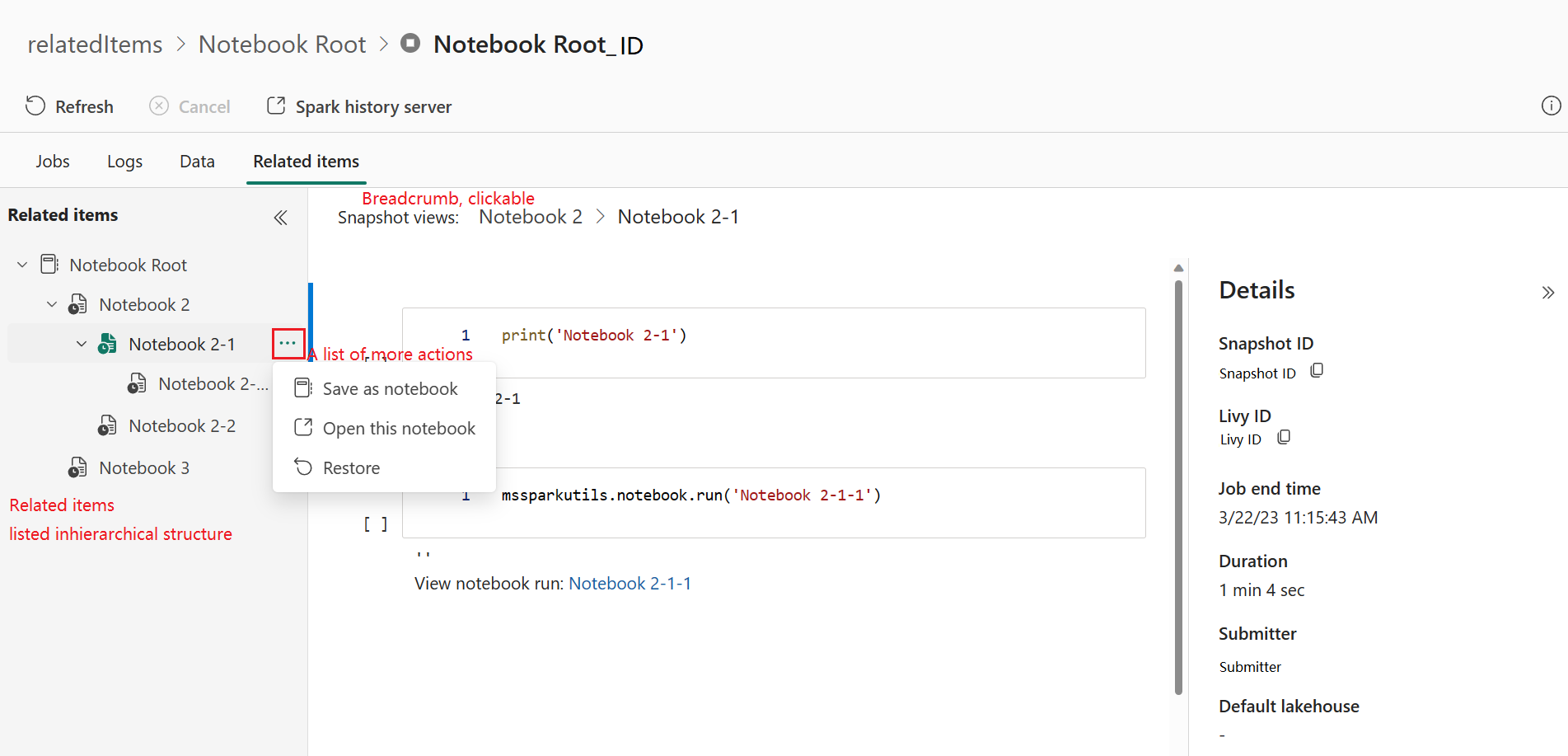

相關項目

相關項目索引標籤可讓您瀏覽和檢視與 Apache Spark 應用程式相關聯的項目,包括 Notebook、Spark 作業定義和/或管線。 相關項目頁面會在 Notebooks 執行時顯示程式碼和參數值的快照集。 它也會在提交 Spark 作業定義時顯示所有設定和參數的快照集。 如果 Apache Spark 應用程式與管線相關聯,相關項目頁面也會顯示對應的管線和 Spark 活動。

在「相關項目」畫面中,您可以:

- 流覽並流覽階層式樹狀結構中的相關項目。

- 按兩下每個項目的更多動作清單 省略號圖示,以採取不同的動作。

- 按兩下快照集項目以檢視其內容。

- 檢視階層連結,以查看從選取的項目到根目錄的路徑。

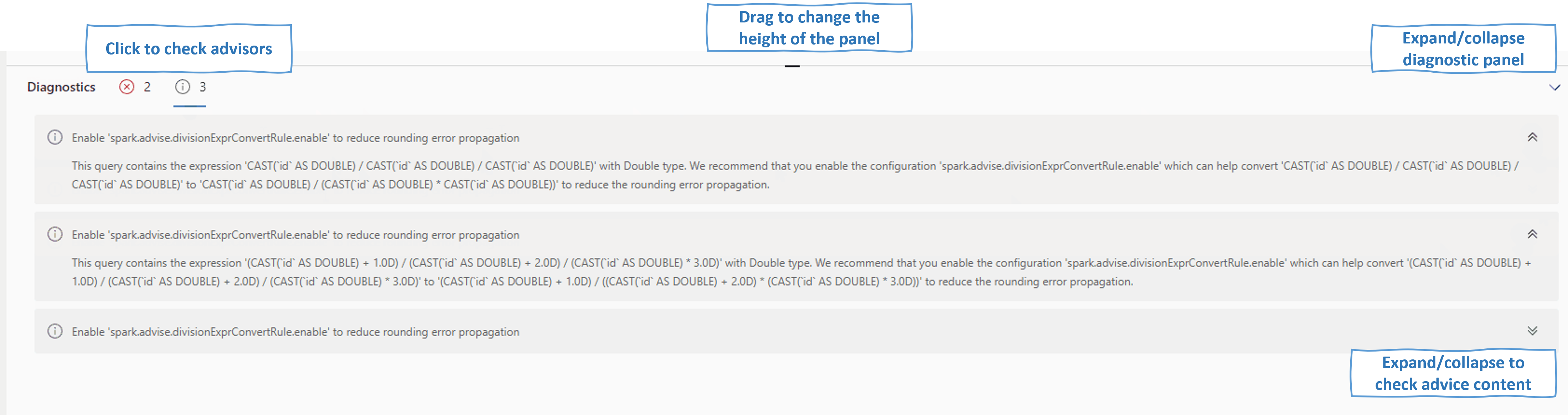

診斷

診斷面板為使用者提供即時建議和錯誤分析,這些建議是由 Spark Advisor 透過使用者程式碼的分析所產生。 使用內建模式時,Apache Spark Advisor 可協助使用者避免常見的錯誤,並分析失敗以找出其根本原因。

相關內容

檢視 Apache Spark 應用程式詳細資料之後的下一個步驟是檢視 Notebook 儲存格下方的 Spark 作業進度。 您可以參考: