使用數據管線將 1 TB CSV 數據載入 Lakehouse 數據表的定價案例

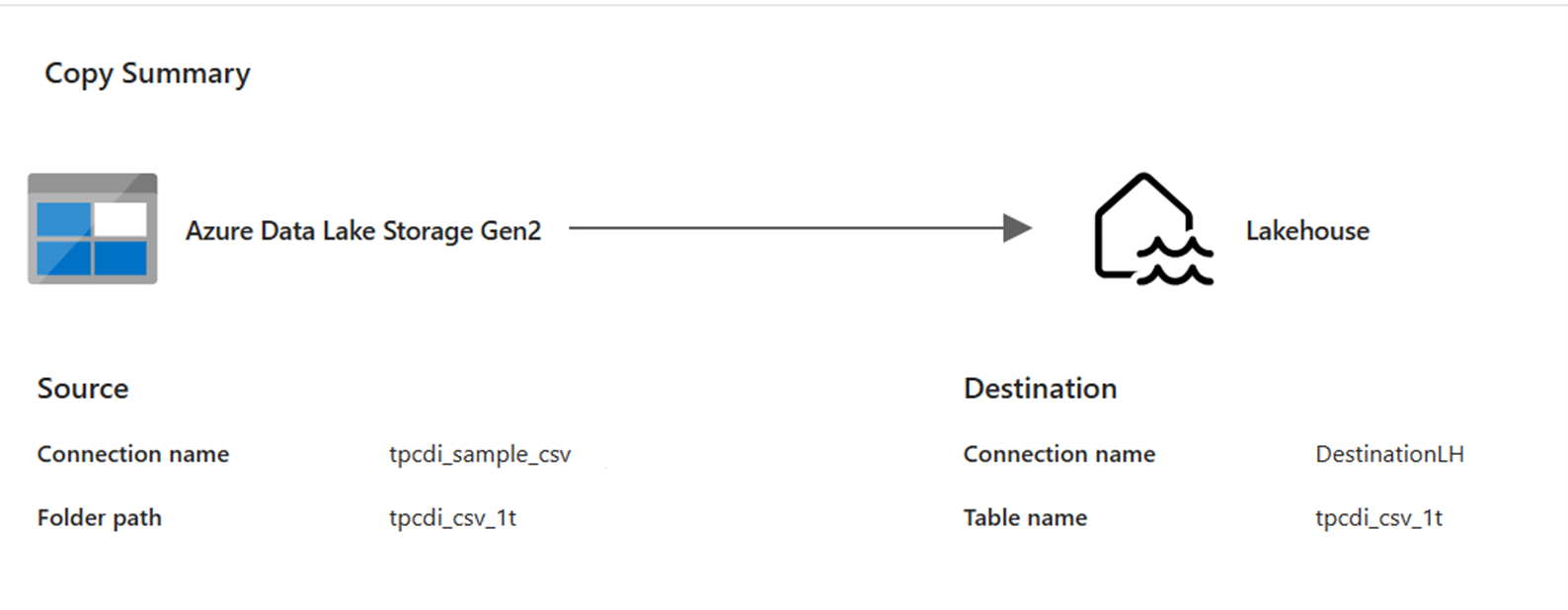

在此案例中,數據管線中使用 複製活動,將儲存在 Azure Data Lake 儲存體 (ADLS) Gen2 中的 1 TB CSV 數據載入 Microsoft Fabric 中的 Lakehouse 數據表。

下列範例中使用的價格是假設的,並不打算暗示確切的實際價格。 這些只是為了示範如何在 Microsoft Fabric 中預估、規劃和管理 Data Factory 專案的成本。 此外,由於網狀架構容量在各個區域的價格是獨一無二的,因此我們會針對位於美國西部 2 的網狀架構容量使用隨用隨付定價(一般 Azure 區域),每小時 0.18 美元。 請參閱 Microsoft Fabric - 定價 以探索其他 Fabric 容量定價選項。

組態

若要完成此案例,您需要使用下列組態建立管線:

使用網狀架構計量應用程式的成本估計

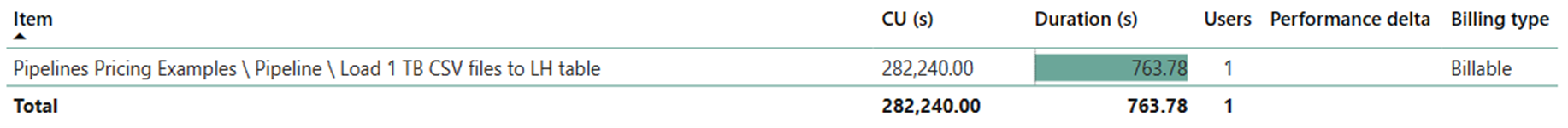

數據移動作業使用 282,240 CU 秒,而活動執行作業期間為 Null,因為管線執行中沒有任何非複製活動。

注意

雖然回報為計量,但在使用網狀架構計量應用程式計算有效 CU 時,執行的實際持續時間並不相關,因為它也會報告其持續時間的 CU 秒計量。

| 計量 | 數據移動作業 |

|---|---|

| CU 秒 | 282,240 CU 秒 |

| 有效的 CU 時數 | (282,240) / (60*60) CU-hours = 78.4 CU-hours |

總運行成本 $0.18/CU 小時 = (78.4 CU-hours) * ($0.18/CU 小時) ~= $14.11

相關內容

意見反應

即將登場:在 2024 年,我們將逐步淘汰 GitHub 問題作為內容的意見反應機制,並將它取代為新的意見反應系統。 如需詳細資訊,請參閱:https://aka.ms/ContentUserFeedback。

提交並檢視相關的意見反應