將 Lakehouse 目的地新增至 eventstream

本文說明如何將 Lakehouse 新增為 Microsoft Fabric 事件串流中 eventstream 的目的地。

注意

如果您想要使用處於預覽狀態的增強功能,請選取 頂端的 [增強功能 ]。 否則,請選取 [ 標準功能]。 如需預覽中增強功能的相關信息,請參閱 Fabric 事件串流簡介。

重要

有架構 強制 將數據寫入 Lakehouse 目的地數據表。 所有新寫入數據表都必須在寫入時與目標數據表的架構相容,以確保數據品質。

將輸出寫入新的差異數據表時,會根據第一筆記錄來建立數據表架構。 輸出數據的所有記錄都會投影到現有數據表的架構上。

如果傳入數據的數據行不在現有數據表架構中,則寫入數據表的數據中不會包含額外的數據行。 同樣地,如果傳入的數據遺漏現有數據表架構中的數據行,則遺漏的數據行會寫入數據表,並將值設定為 null。

必要條件

- 存取事件串流所在的網狀架構 進階工作區 ,並具有 參與者 或更高許可權。

- 使用參與者或更高許可權存取 Lakehouse 所在的進階工作區。

注意

一個事件數據流的來源和目的地數目上限為 11。

將 Lakehouse 新增為目的地

若要將 Lakehouse 目的地新增至預設或衍生的事件串流,請遵循下列步驟。

在 事件數據流的 [編輯模式 ] 中,選取 功能區上的 [新增目的地 ],然後從下拉式清單中選取 [Lakehouse ]。

連線 lakehouse 節點到您的數據流節點或運算符。

在 Lakehouse 組態畫面上,完成下列資訊:

- 輸入目的地名稱。

- 選取包含 Lakehouse 的工作區。

- 從您指定的工作區中選取現有的 Lakehouse 。

- 選取現有的 Delta 數據表,或建立新的數據表來接收數據。

- 選取傳送至 Lakehouse 的輸入數據格式。 支持的數據格式為 JSON、Avro 和 CSV(含標頭)。

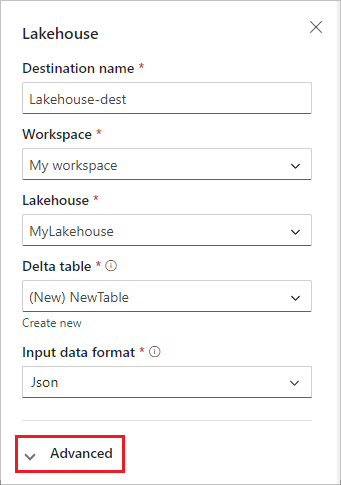

選取進階。

湖屋目的地有兩種擷取模式。 根據您的案例,設定這些模式,以將 Fabric 事件串流寫入 Lakehouse 的方式優化。

最小數據列 是 Lakehouse 內嵌在單一檔案中的最小數據列數目。 最小值為 1 個數據列,每個檔案的最大值為 2 百萬個數據列。 湖屋在擷取期間建立的檔案數目越小,數據列數目越小。

持續時間上限是湖屋內嵌單一檔案所花費的最大持續時間。 最小值為 1 分鐘,最大值為 2 小時。 持續時間越長,檔案中會擷取的數據列越多。

![Lakehouse 組態畫面 [進階] 區段的螢幕快照。](media/add-destination-lakehouse/advanced-screen.png)

選取 [儲存]。

若要實作新增的 Lakehouse 目的地,請選取 [ 發佈]。

完成這些步驟之後,Lakehouse 目的地即可在 [即時檢視] 中取得視覺效果。 在 [ 詳細數據 ] 窗格中,您可以選取 筆記本快捷方式中的 [優化] 數據表,以在 Notebook 內啟動 Apache Spark 作業,以合併目標 Lakehouse 數據表內的小型串流檔案。

相關內容

若要瞭解如何將其他目的地新增至事件數據流,請參閱下列文章:

必要條件

開始之前,您必須完成下列必要條件:

- 取得具有事件串流所在之參與者或更高許可權的進階工作區的存取權。

- 取得具有您 Lakehouse 所在位置之參與者或更高許可權的進階工作區的存取權。

注意

一個事件數據流的來源和目的地數目上限為 11。

將 Lakehouse 新增為目的地

如果您的工作區中已建立 Lakehouse,請遵循下列步驟,將 Lakehouse 新增至事件串流作為目的地:

在主編輯器畫布中,選取 功能區上的 [新增目的地 ] 或 [“]+,然後選取 [Lakehouse]。 Lakehouse 目的地設定畫面隨即出現。

輸入 eventstream 目的地的名稱,並完成 Lakehouse 的相關信息。

Lakehouse:從您指定的工作區中選取現有的 Lakehouse。

差異數據表:選取現有的差異數據表,或建立新的差異數據表來接收數據。

注意

將數據寫入 Lakehouse 數據表時,會 強制執行架構。 這表示對數據表的所有新寫入都必須與目標數據表的架構在寫入時相容,以確保數據品質。

輸出數據的所有記錄都會投影到現有數據表的架構上。 將輸出寫入新的差異數據表時,會根據第一筆記錄建立數據表架構。 如果連入數據與現有的數據表架構相比有額外的數據行,它會寫入數據表,而不包含額外的數據行。 相反地,如果連入數據遺漏了與現有數據表架構比較的數據行,它會寫入數據表,並將數據行的值設定為 null。

輸入數據格式:選取傳送至 Lakehouse 的數據 (輸入資料) 格式。

注意

支援的輸入事件數據格式為 JSON、Avro 和 CSV(含標頭)。

事件處理:您可以使用事件處理編輯器來指定數據在傳送至 Lakehouse 之前應如何處理數據。 選取 [ 開啟事件處理器 ] 以開啟事件處理編輯器。 若要深入瞭解使用事件處理器進行實時處理,請參閱 使用事件處理器編輯器處理事件數據。 當您使用編輯器完成時,請選取 [完成 ] 以返回 Lakehouse 目的地設定畫面。

湖屋目的地有兩種擷取模式。 選取下列其中一種模式,根據您的案例,將 Fabric 事件串流功能寫入 Lakehouse 的方式優化。

選取 [新增 ] 以新增 Lakehouse 目的地。

Lakehouse 目的地內可用的數據表優化快捷方式。 此解決方案可藉由在 Notebook 內啟動 Spark 作業,以合併目標 Lakehouse 資料表內的這些小型串流檔案,協助您。

湖屋目的地會出現在畫布上,並顯示旋轉狀態指示器。 系統需要幾分鐘的時間,才能將狀態變更為 [作用中]。

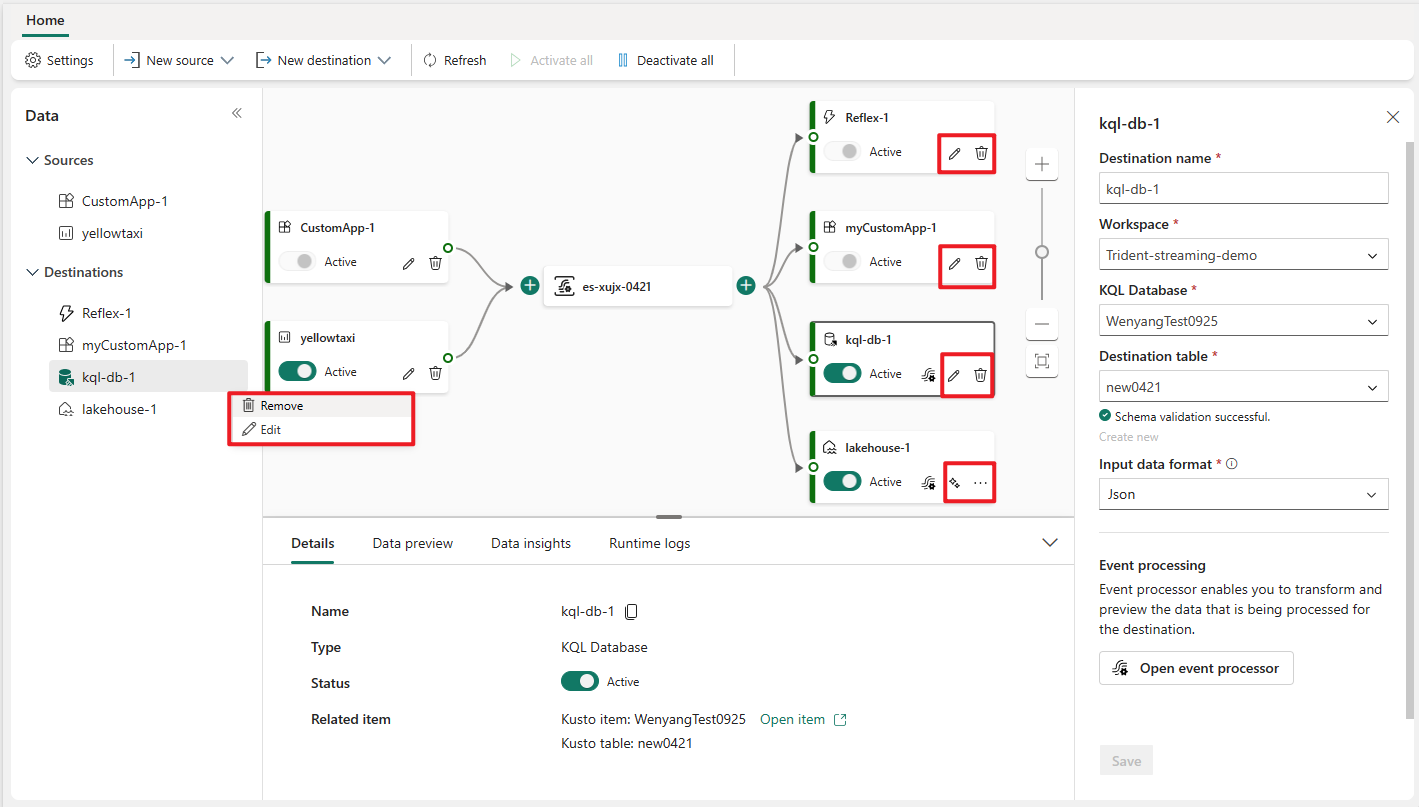

管理目的地

編輯/移除:您可以透過瀏覽窗格或畫布編輯或移除 eventstream 目的地。

當您選取 [ 編輯] 時,編輯窗格會在主編輯器右側開啟。 您可以視需要修改組態,包括透過事件處理器編輯器的事件轉換邏輯。

相關內容

若要瞭解如何將其他目的地新增至事件數據流,請參閱下列文章:

意見反應

即將登場:在 2024 年,我們將逐步淘汰 GitHub 問題作為內容的意見反應機制,並將它取代為新的意見反應系統。 如需詳細資訊,請參閱:https://aka.ms/ContentUserFeedback。

提交並檢視相關的意見反應

![[新增目的地] 下拉式列表的螢幕快照,其中已醒目提示 Lakehouse。](media/add-destination-lakehouse/add-destination.png)

![[編輯] 模式中串流和 Lakehouse 目的地的螢幕快照,其中已醒目提示 [發佈] 按鈕。](media/add-destination-lakehouse/edit-mode.png)

![[實時檢視] 中 Lakehouse 目的地和數據表優化按鈕的螢幕快照。](media/add-destination-lakehouse/live-view.png)