適用於:SQL Server 2019 (15.x)

Important

MICROSOFT SQL Server 2019 巨量數據叢集已淘汰。 SQL Server 2019 巨量數據叢集的支援已於 2025 年 2 月 28 日結束。 如需詳細資訊,請參閱 Microsoft SQL Server 平臺上的公告部落格文章和巨量數據選項。

本教學課程示範如何在 SQL Server 2019 巨量數據叢集的 Azure Data Studio 中載入和執行筆記本。 這可讓數據科學家和數據工程師對叢集執行 Python、R 或 Scala 程式代碼。

Tip

如果您想要的話,您可以下載並執行本教學課程中命令的腳本。 如需指示,請參閱 GitHub 上的 Spark 範例 。

Prerequisites

-

巨量資料工具

- kubectl

- Azure Data Studio

- SQL Server 2019 擴充功能

- 將範例數據載入巨量數據叢集

下載範例筆記本檔案

使用下列指示,將範例筆記本檔案 spark-sql.ipynb 載入 Azure Data Studio。

開啟 bash 命令提示字元 (Linux) 或 Windows PowerShell。

流覽至您要下載範例筆記本檔案的目錄。

執行下列 curl 命令,從 GitHub 下載筆記本檔案:

curl https://raw.githubusercontent.com/Microsoft/sql-server-samples/master/samples/features/sql-big-data-cluster/spark/data-loading/transform-csv-files.ipynb -o transform-csv-files.ipynb

開啟筆記本

下列步驟示範如何在 Azure Data Studio 中開啟筆記本檔案:

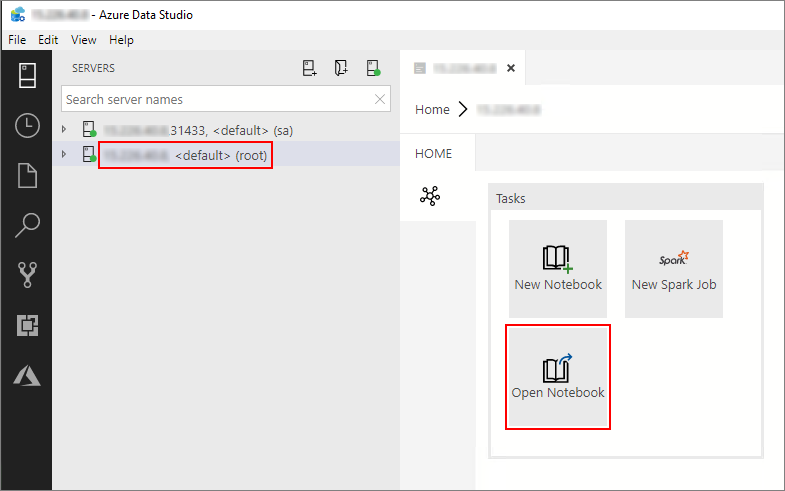

在 Azure Data Studio 中,連線到大數據叢集的主要實例。 如需詳細資訊,請參閱 連線到巨量數據叢集。

在 [ 伺服器 ] 視窗中,按兩下 HDFS/Spark 閘道器連接。 然後選取 [開啟筆記本]。

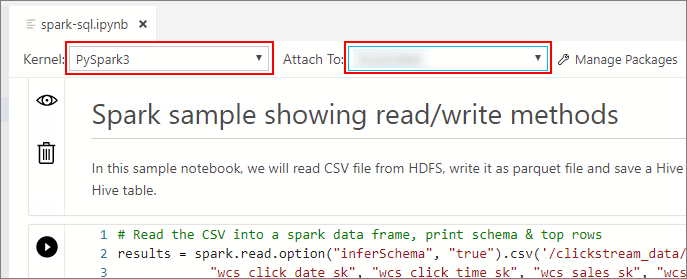

等候 [核心] 和目標內容 ([附加至] ) 填入。 將 核心 設定為 PySpark3,並將 [附加] 設定為巨量數據叢集端點的 IP 位址。

Important

在 Azure Data Studio 中,所有 Spark 筆記本類型(Scala Spark、PySpark 和 SparkR)通常會在第一個數據格執行時定義一些重要的 Spark 會話相關變數。 這些變數包括: spark、 sc和 sqlContext。 將邏輯從筆記本中複製以供批次提交時(例如,複製到要使用的 azdata bdc spark batch create Python 檔案中),請確定您據此定義變數。

執行筆記本的儲存格

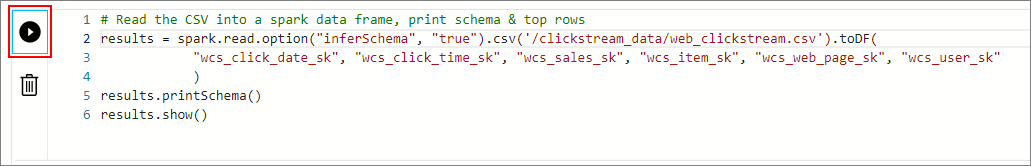

您可以按儲存格左邊的播放按鈕來執行每個筆記本儲存格。 程式碼執行完畢之後,結果將顯示在筆記本中。

依序執行範例筆記本中的每個儲存格。 如需搭配 SQL Server 巨量數據叢集使用筆記本的詳細資訊,請參閱下列資源:

Next steps

深入了解筆記本: