開發音訊型聊天應用程式

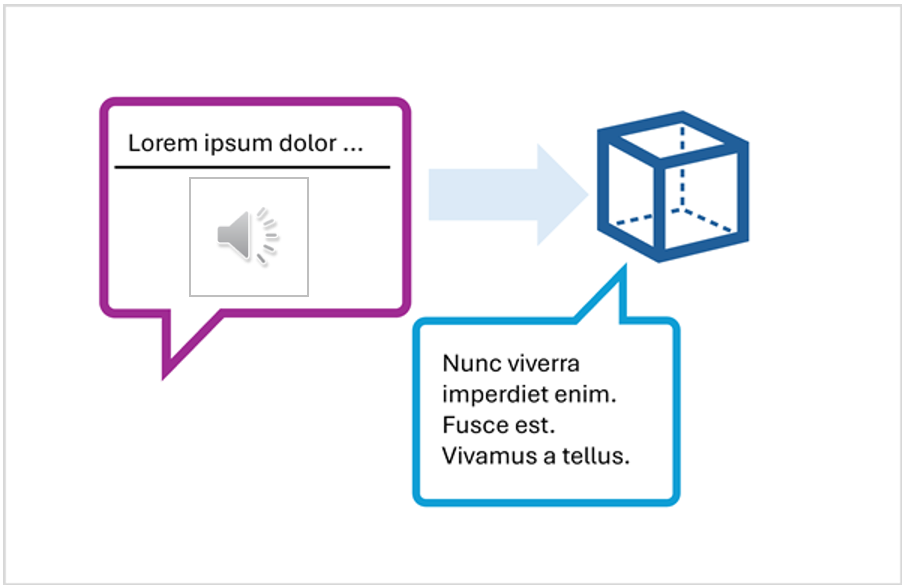

若要開發使用多模式模型參與音訊型聊天的用戶端應用程式,您可以使用用於文字型聊天的相同基本技術。 您需要連線至部署模型的端點,並使用該端點將訊息組成的提示提交至模型並處理回應。

主要差異在於音訊型聊天的提示包含含有 文字內容項目和 音訊內容項目的多部分使用者訊息。

包含多部分使用者訊息之提示的 JSON 表示如下所示:

{

"messages": [

{ "role": "system", "content": "You are a helpful assistant." },

{ "role": "user", "content": [

{

"type": "text",

"text": "Transcribe this audio:"

},

{

"type": "audio_url",

"audio_url": {

"url": "https://....."

}

}

] }

]

}

音訊內容項目可以是:

- 網站中音訊檔案的 URL。

- 二進位音訊數據

使用二進位數據提交本機音訊檔案時, audio_url 內容會以數據 URL 格式採用base64編碼值的形式:

{

"type": "audio_url",

"audio_url": {

"url": "data:audio/mp3;base64,<binary_audio_data>"

}

}

視模型類型及部署位置而定,您可以使用 Microsoft Azure AI 模型推斷或 OpenAI API 來提交音頻型提示。 這些程式庫也提供特定語言的 SDK,以抽象化底層的 REST API。

在本課程模組中的後續練習中,您可以使用適用於 Azure AI 模型推斷 API 的 Python 或 .NET SDK 和 OpenAI API 來開發已啟用音訊的聊天應用程式。