Windows Server 故障轉移叢集支援多種儲存架構模式,為叢集角色提供高可用性與韌性。 本文涵蓋了包括 SAN、NAS、超融合、拆分儲存空間直通(Storage Spaces Direct)及混合拓撲等儲存架構。

此處涵蓋的儲存架構反映了運算與儲存元件的擴展方式,以及叢集共享卷(CSV)或儲存空間直通(Storage Spaces Direct,S2D)的使用方式。 本文並未描述所有可能的儲存架構配置或罕見的邊緣情況。

架構比較

| Architecture | 儲存位置 | 縮放特性 |

|---|---|---|

| SAN 或 NAS 記憶體 | 外部共享儲存裝置(SAN、NAS 或 SMB 3.0 檔案分享)由運算叢集透過網路存取。 | 運算與儲存可獨立擴展(新增運算節點但不增加儲存;儲存成長依廠商而定)。 |

| Hyperconverged | 每個叢集節點的本地磁碟由 S2D 集結;資料在節點間複製;CSV 以均勻的方式呈現儲存空間。 | 對稱縮放——每個節點同時增加計算和儲存;叢集支援最多達到 S2D 所記錄的節點數量。 |

| 與 SAN 儲存空間的超融合 | 同一叢集內的本地 S2D 池(ReFS CSVs)和外部 SAN 磁碟區 (NTFS CSVs),磁碟組則保持獨立。 | 雙重擴展:新增節點(計算+S2D儲存)或獨立擴展SAN。 |

| 分類式儲存空間直接存取 | 獨立的運算叢集透過網路存取由獨立的 S2D 儲存叢集提供的儲存。 | 運算與儲存可獨立擴展(僅新增運算或僅儲存叢集節點)。 |

| 混合架構支援 | 同一運算叢集會結合分散的 SAN/NAS 儲存與基於 S2D 的儲存。 | 彈性——根據工作負載混合獨立與對稱的擴展策略。 |

所有架構都依賴於概覽中描述的叢集能力(如定額、健康監控、故障轉移)。 CSV 使用細節(元資料同步、重定向 I/O 可於 CSV 概覽中取得)。 關於 SAN 與 NAS 的考量(多徑、隔離),請參見叢集硬體需求。 Scale-Out 檔案伺服器的主動語意在概述中都有介紹。

SAN 或 NAS 記憶體

拆分的 SAN 或 NAS 儲存(包括 SMB 3.0 共享)會將儲存放在獨立的結構上。 叢集節點透過網路存取儲存空間。 計算與儲存可以獨立地擴展。

拆分的 SAN 或 NAS 模型的主要特徵包括:

支援虛擬機、Scale-Out 檔案伺服器資料、SQL Server(SMB 上的)及其他叢集應用程式的故障轉移。

SAN 或 NAS 平台提供儲存可用性與韌性。 使用多路徑 I/O 或網卡分組來消除單點故障(參見 硬體需求)。

SMB 共享可從 SMB 多通道與 SMB Direct 中受益,提升吞吐量與韌性。

獨立擴展:新增運算(CPU/RAM)而不儲存,或僅擴充儲存空間。

叢集最多支援 64 個節點。

在部署或擴充由 SAN 或 NAS 支援的故障轉移叢集前,請先檢視以下規劃考量:

擴展與效能則依廠商而定。 請參考你的平台指引。

保持韌體和驅動程式對區塊協定(光纖通道、iSCSI)保持一致。 確保中小企業的網路冗餘。

將儲存流量與用戶端及管理路徑隔離,以減少爭用。

規劃網路路徑的可用性與冗餘,以匹配儲存平台的韌性。

套用檔案共享 ACL,讓只有叢集節點能存取共享資源。

當儲存生命週期或成長與運算不同,或集中式共享儲存必須服務多個叢集時,選擇此模式。 記憶體叢集調整是廠商特定的。 請連絡您的廠商,以了解其所提供的儲存解決方案如何可以擴展。

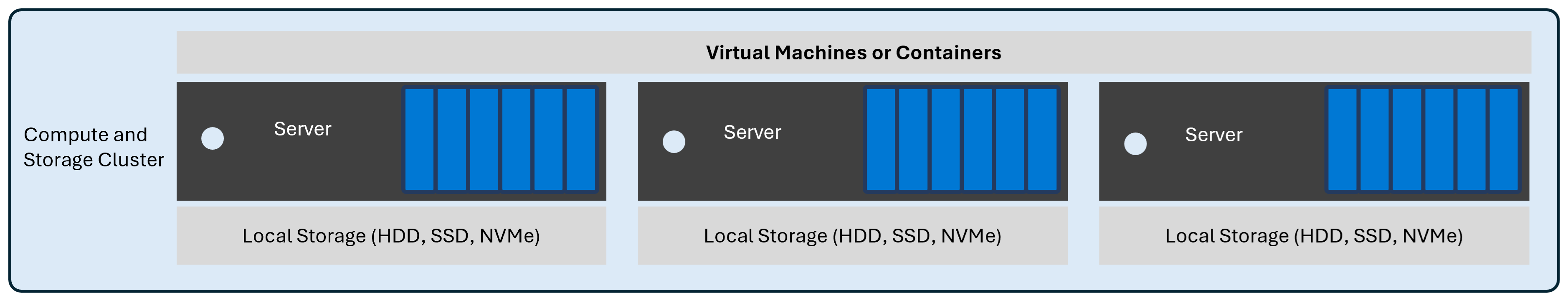

Hyperconverged

在此超融合配置中,Storage Spaces Direct 將每個叢集節點的本地硬碟池化為共享儲存池,將磁碟區呈現為叢集共享卷(CSV),並在叢集節點間複製資料以提升韌性。 隨著叢集節點的增加,運算(CPU 和 RAM)和儲存容量會一起成長。

超收斂模型的主要特徵:

支援叢集工作負載,如虛擬機、Scale-Out 檔案伺服器應用資料、SQL Server 資料庫(SMB 與 CSV 上)以及容器化應用程式。

叢集故障轉移允許虛擬機及其他叢集角色在叢集內任一節點移動或重啟。

本地 NVMe、SSD 與 HDD 裝置會被合併,磁碟區則以 CSV 格式公開,以統一命名空間。

資料韌性使用鏡像、奇偶校驗或巢狀韌性,並將資料複製到其他節點。 欲了解更多關於Storage Space Direct 容錯的資訊,請參見 容錯與儲存效率。

對稱縮放,意即每個新增節點同時貢獻運算與儲存。

叢集支援使用 Storage Spaces Direct 的 1 到 16 個節點。

低延遲的東西向網路架構,並配置 RDMA(RoCE 或 iWARP)以提升吞吐量並降低 CPU 負擔。

部署或擴展超融合叢集前的規劃考量:

保持韌體和驅動程式版本在不同儲存卡和硬碟間保持一致。

驗證網路設定(QoS、RDMA 優先權及流量控制),以避免擁塞並確保延遲可預測。

根據已發表的指引,調整快取與容量等級(NVMe、SSD 和 HDD)的大小,以維持效能建議的比率。

預留重建容量,讓叢集能安全容忍硬碟或節點故障,避免接近 100% 的使用率。

主動監控硬碟、機箱與複製功能的健康狀況。

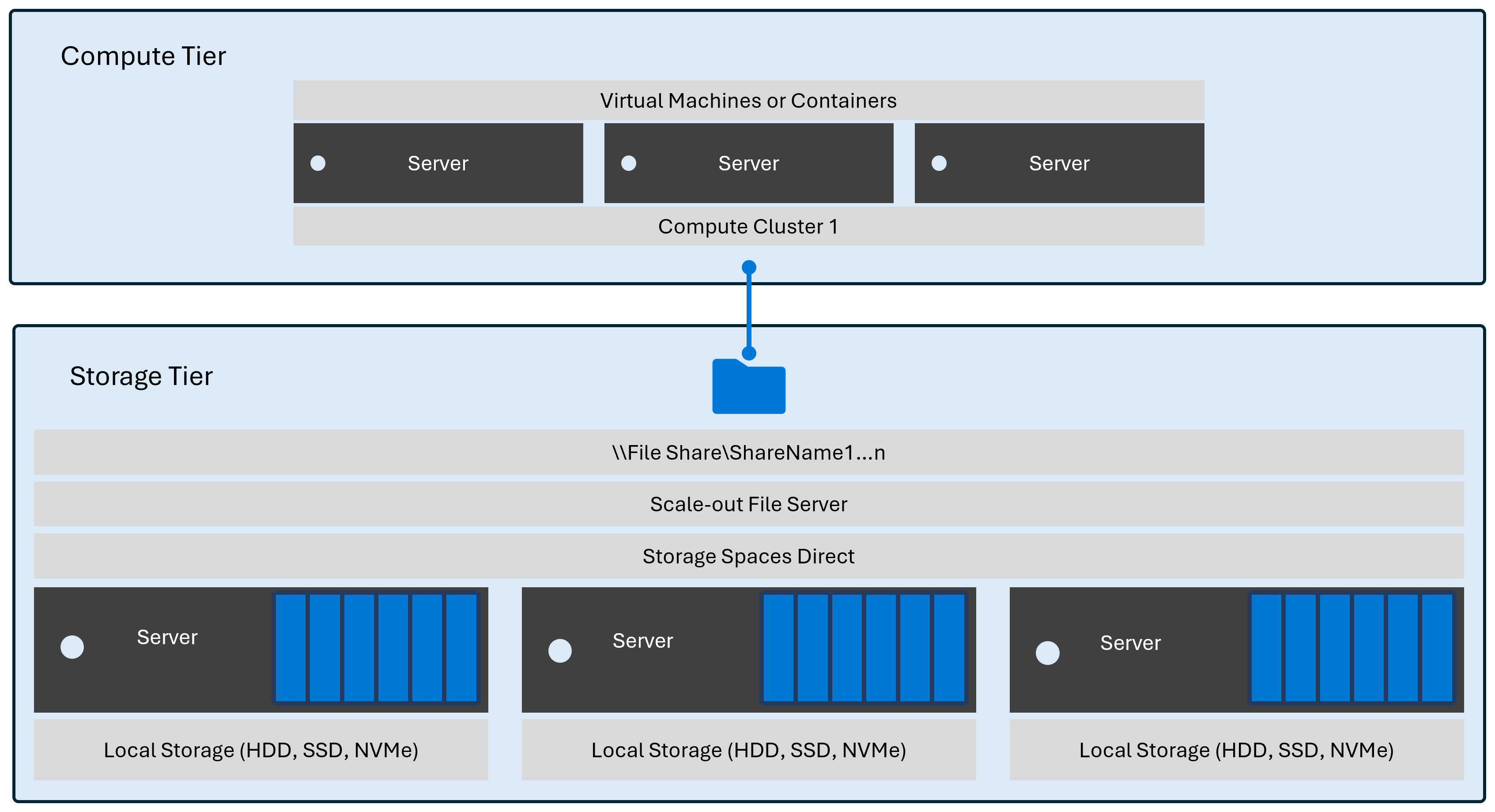

分類式儲存空間直接存取

非整合的 Storage Spaces Direct 將運算與儲存分離成獨立的叢集。 運算叢集(運行虛擬機、Scale-Out 檔案伺服器角色、SQL Server 資料庫或容器化應用程式等工作負載)會存取由獨立的 Storage Spaces Direct 叢集透過 SMB 3.0 提供的儲存空間。

分散儲存空間直接架構的主要特徵:

獨立擴展:僅新增運算節點以增加 CPU 與 RAM 資源,或僅增加儲存節點以提升容量與效能。 成長率可能會有分歧。

透過 SMB 或 CSV 支援的共享,支援與超融合模型相同的叢集工作負載。

儲存叢集使用鏡像、奇偶校驗或巢狀韌性,資料會被複製到其他節點。 欲了解更多關於 Storage Space Direct 的容錯性資訊,請參閱 容錯性與儲存效率。

維護隔離:你可以分別修補或重啟儲存節點,與運算節點分開。

多個運算叢集可以使用同一個儲存叢集中的資源配額(需考慮容量與效能規劃)。

運算叢集支援 1 至 64 個節點。

儲存叢集支援 1 到 16 個節點。

需要叢集間可靠的低延遲東西向網路(可選RDMA)以達到可預測的效能。

部署或擴充分散儲存空間 Direct 前的規劃考量:

在儲存節點間調整韌體、驅動程式和作業系統更新頻率。 避免使用混合驅動版本。

驗證網路設定(QoS、RDMA 優先權及流量控制),以避免擁塞並確保延遲可預測。

預測成長差異(CPU、RAM、容量與IOPS),並設定獨立擴展各叢集的門檻。

應用最低權限存取權。 限制計算叢集與儲存叢集間的管理存取,並使用檔案共享 ACL 限制對所需叢集節點的存取。

主動監控儲存叢集中的磁碟機、機箱和複本健康狀況,避免獨立運算受到儲存可用性的影響。

下圖展示了一個分解部署,包含一個運算叢集和一個儲存叢集。

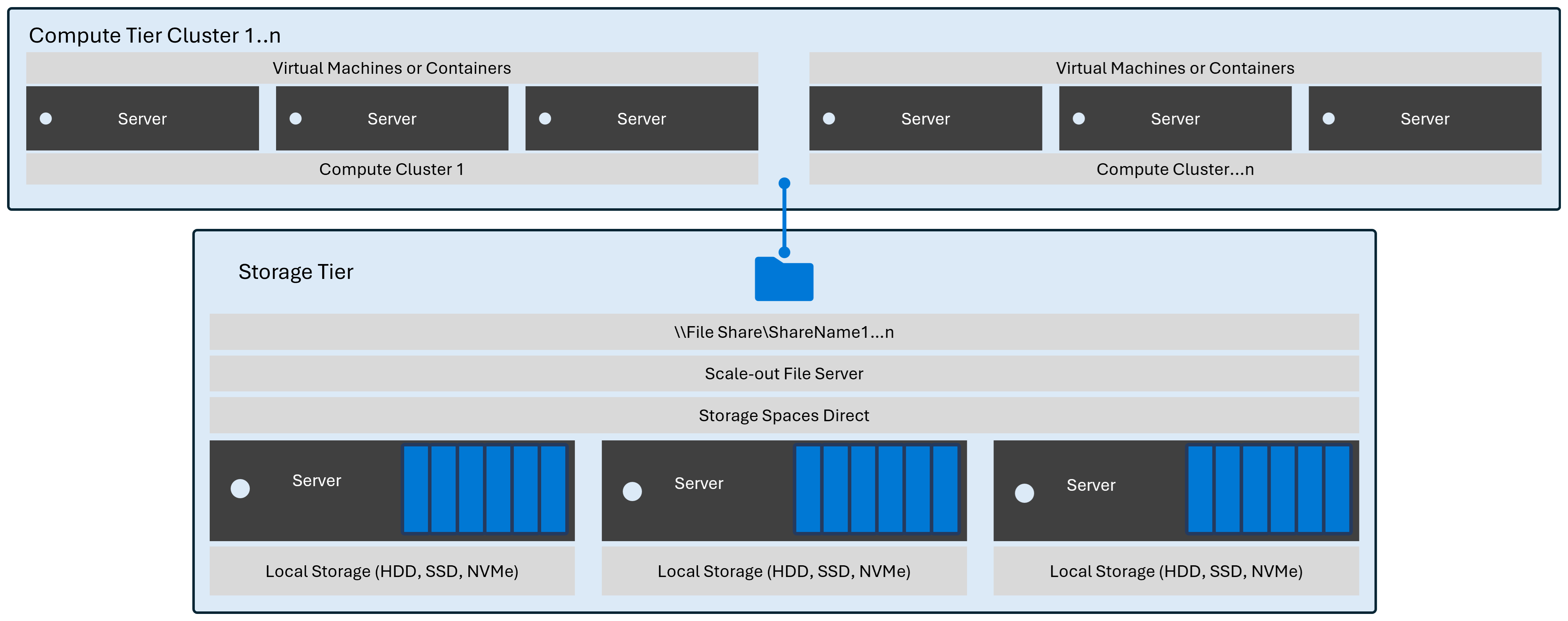

當你新增更多運算資源時,你可以選擇新增節點到現有運算叢集,或新增一個叢集。 下圖顯示當您將新叢集新增至該叢集而不新增更多記憶體時,簡單部署會發生什麼情況。

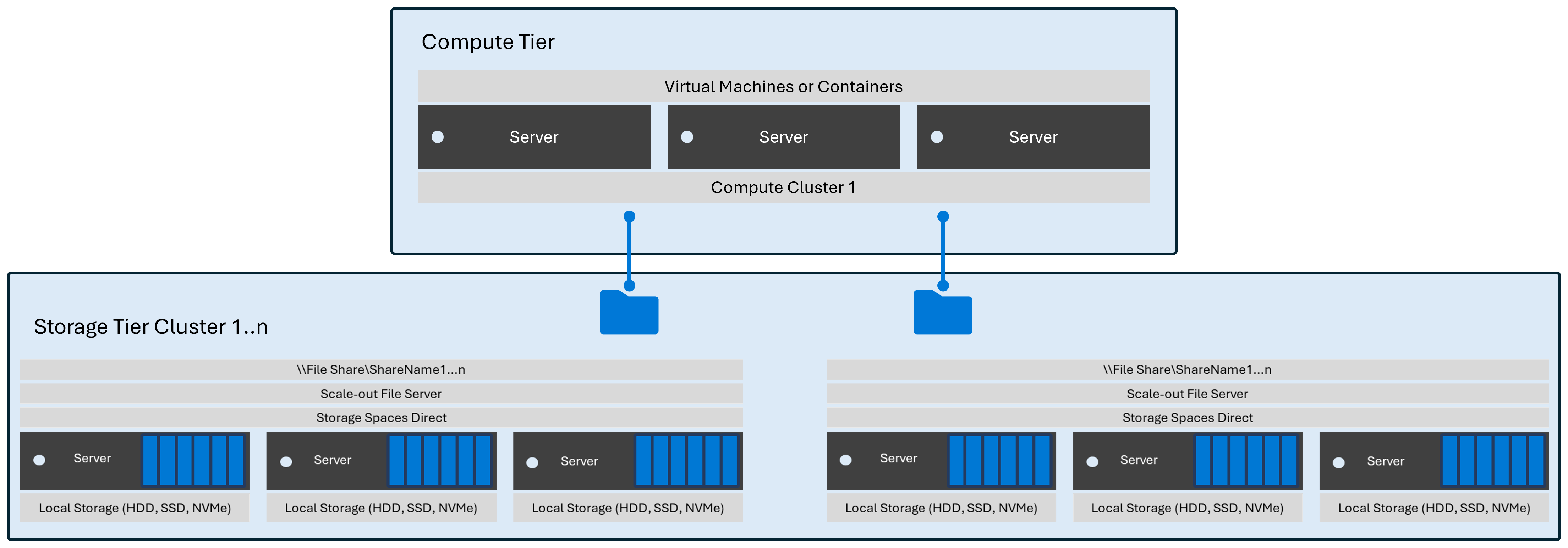

當您為裝載資料新增更多記憶體資源而不需要新增更多計算資源時,您可以將新的節點新增至現有的記憶體叢集或新增叢集。 下圖顯示簡單部署的樣貌,當您新增叢集而不需添加 CPU 或 RAM 等計算資源時的狀況。

與 SAN 儲存空間的超融合

從 Windows Server 2022 開始,你可以將超融合的 Storage Spaces Direct 與外部 SAN 儲存裝置合併在同一個故障轉移叢集中。 此架構結合了超融合的 Storage Spaces Direct 叢集(本地磁碟被池化並暴露為 ReFS 支援的 CSV 檔案)與外部 SAN 儲存,並以 NTFS 支援的 CSV 形式呈現給同一叢集。 這兩個儲存源共存但彼此分離。

超融合加 SAN 模型的主要特徵:

共存:S2D CSV 和 SAN CSV 協同運作於同一個容錯叢集之中。

嚴格分離:SAN 磁碟絕不能加入 Storage Spaces Direct 池,且需獨立管理。

格式要求:

在轉換成叢集共享卷之前,先將 SAN 磁碟區格式化為 NTFS。

將 Storage Spaces Direct 磁碟區格式化為 ReFS,然後再轉換成叢集共享磁碟區。

支援的 SAN 連接包括光纖通道、iSCSI 及 iSCSI Target。

工作負載配置彈性:將延遲敏感或 ReFS 優化的工作負載(如大型 VHDX 集合或容器層)放置於 S2D 卷上。 將需要特定 NTFS 功能或現有 SAN 管理工具的工作負載放在 SAN 卷上。

獨立擴充容量:新增超融合節點(增加運算與儲存)或擴充 SAN 容量(僅增加儲存空間),而不影響彼此。

故障領域保持區別:S2D 透過韌性集處理硬碟與節點故障。 SAN 透過自身的控制器、結構架構或多徑設計來處理可用性。

Storage Spaces Direct 叢集支援 1 至 16 個節點。

部署或擴充結合超融合與 SAN 架構前的規劃考量:

SAN 的擴展與效能依廠商而定——由諮詢平台提供指引。

不要嘗試將 SAN 提供的磁碟加入 S2D 儲存池。

維持兩個儲存子系統(S2D 轉接器和 SAN HBA/NIC)韌體和驅動程式版本一致。

建立工作量分配指引(例如高流失率或去量適宜性),並記錄使用哪種 CSV 類型。

分別監控容量趨勢:S2D 池利用率與 SAN 陣列利用率,以預測升級。

協調備份與災難復原策略;SAN 快照與基於 S2D 的卷備份可能遵循不同的排程與工具。

驗證效能隔離;重度的 SAN I/O 不應該會阻塞東西向的 S2D 複製流量。

你需要規劃 SAN 和網路路徑的可用性與冗餘,以配合每個儲存平台的可用性。

混合架構支援

Hyper-V 支援合併相同計算叢集中的下列架構:

具有分類式儲存空間直接存取的 Hyper-V

使用 SAN 的解構式 Hyper-V

使用 NAS 分類式 Hyper-V

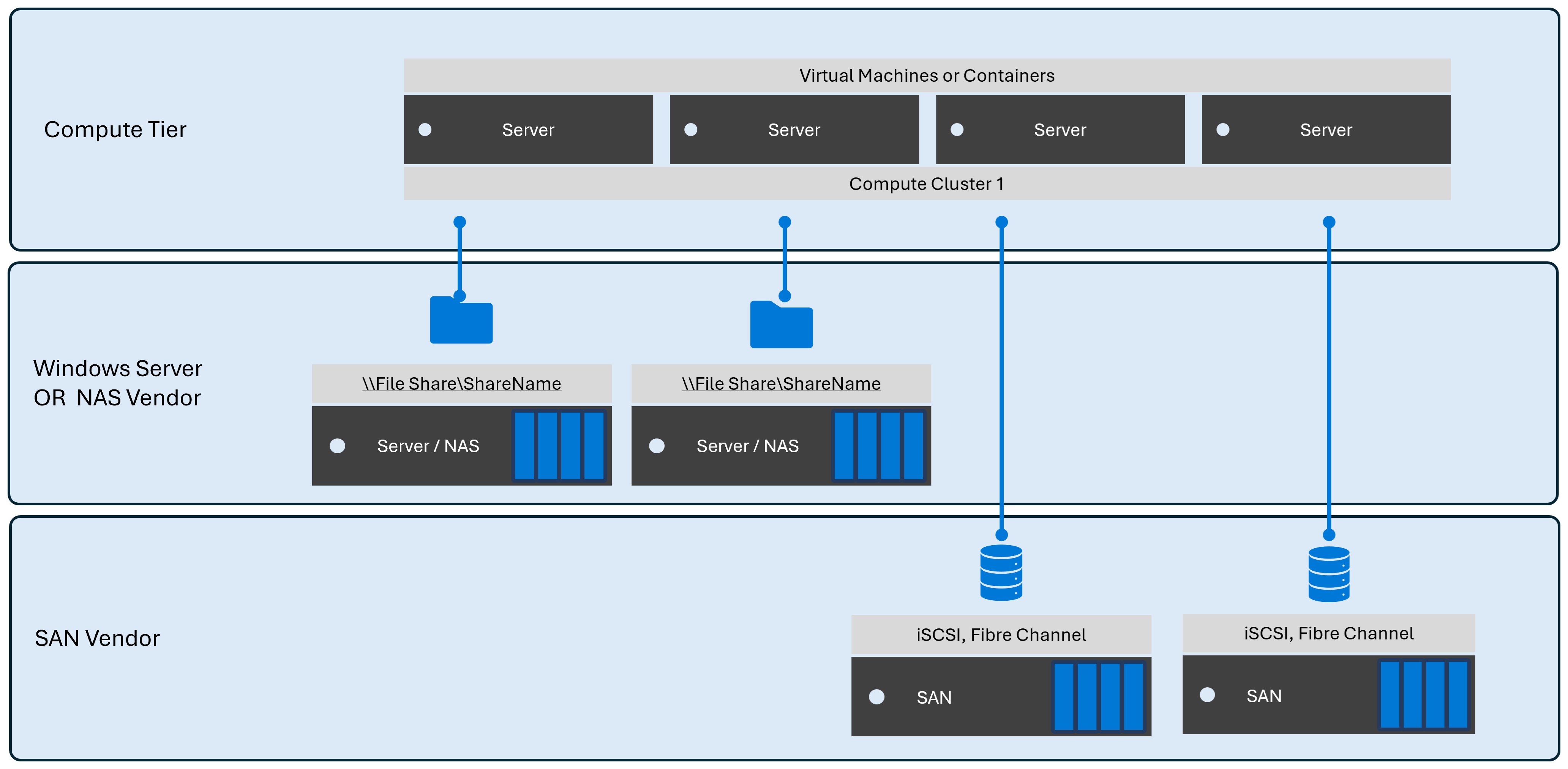

下圖顯示一個部署範例,其中的計算叢集包含了分離式SAN和NAS儲存的混合使用。

網路儲存協定

Windows Server 支援下列網路檔案記憶體通訊協定:

透過 QUIC

SMB 透過 RDMA SMB

Windows Server 也支援下列網路區塊儲存通訊協定:

iSCSI

光纖通道

InfiniBand

備註

最終取決於配置細節是否支援這些協定。 例如,使用 Hyper-V 虛擬交換器的部署不支援 InfiniBand。 不過,當裝置未繫結至虛擬交換器時,他們可以支援 InfiniBand 裝置。

Microsoft也提供內建的軟體型 iSCSI 啟動器,用於網路區塊存儲。

您也可以針對 Windows Server 目錄中任何可用的裝置使用儲存裝置廠商用戶端。