إشعار

يتطلب الوصول إلى هذه الصفحة تخويلاً. يمكنك محاولة تسجيل الدخول أو تغيير الدلائل.

يتطلب الوصول إلى هذه الصفحة تخويلاً. يمكنك محاولة تغيير الدلائل.

يمكنك التفاعل مع ملفات مساحة العمل المخزنة في Azure Databricks برمجيا. وهذا يمكن مهام مثل:

- تخزين ملفات البيانات الصغيرة جنبا إلى جنب مع دفاتر الملاحظات والرمز.

- كتابة ملفات السجل إلى الدلائل التي تمت مزامنتها مع Git.

- استيراد الوحدات النمطية باستخدام المسارات النسبية.

- إنشاء ملف مواصفات بيئة أو تعديله.

- كتابة الإخراج من دفاتر الملاحظات.

- كتابة الإخراج من تنفيذ المكتبات مثل Tensorboard.

يمكنك إنشاء ملفات مساحة العمل وتحريرها وحذفها برمجيا في Databricks Runtime 11.3 LTS وما فوق.

إشعار

لتعطيل الكتابة إلى ملفات مساحة العمل، قم بتعيين متغير WSFS_ENABLE_WRITE_SUPPORT=falseبيئة نظام المجموعة . لمزيد من المعلومات، راجع متغيرات البيئة.

إشعار

في Databricks Runtime 14.0 والإصدارات الأحدث، الدليل الافتراضي للعمل الحالي (CWD) للتعليمات البرمجية المنفذة محليا هو الدليل الذي يحتوي على دفتر الملاحظات أو البرنامج النصي قيد التشغيل. هذا تغيير في السلوك من Databricks Runtime 13.3 LTS وما يلي. راجع ما هو دليل العمل الحالي الافتراضي؟.

قراءة مواقع الملفات

استخدم أوامر shell لقراءة مواقع الملفات، على سبيل المثال، في مستودع أو في نظام الملفات المحلي.

لتحديد موقع الملفات، أدخل ما يلي:

%sh ls

- الملفات ليست في مستودع: يقوم الأمر بإرجاع نظام

/databricks/driverالملفات . - الملفات في مستودع: يقوم الأمر بإرجاع مستودع ظاهري مثل

/Workspace/Repos/name@domain.com/public_repo_2/repos_file_system.

قراءة ملفات مساحة عمل البيانات

يمكنك قراءة ملفات البيانات الصغيرة برمجيا مثل .csv أو .json ملفات من التعليمات البرمجية في دفاتر الملاحظات. يستخدم المثال التالي Pandas للاستعلام عن الملفات المخزنة في /data دليل نسبة إلى جذر مستودع المشروع:

import pandas as pd

df = pd.read_csv("./data/winequality-red.csv")

df

يمكنك استخدام Spark لقراءة ملفات البيانات. يجب تزويد Spark بمسار مؤهل بالكامل.

- تستخدم ملفات مساحة العمل في مجلدات Git المسار

file:/Workspace/Repos/<user-folder>/<repo-name>/path/to/file. - تستخدم ملفات مساحة العمل في دليلك الشخصي المسار:

file:/Workspace/Users/<user-folder>/path/to/file.

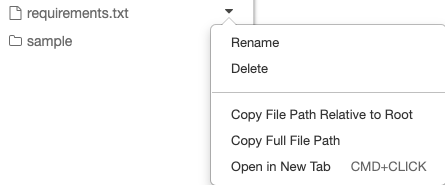

يمكنك نسخ المسار المطلق أو النسبي إلى ملف من القائمة المنسدلة بجوار الملف:

يوضح المثال أدناه استخدام {os.getcwd()} للحصول على المسار الكامل.

import os

spark.read.format("csv").load(f"file:{os.getcwd()}/my_data.csv")

لمعرفة المزيد حول الملفات على Azure Databricks، راجع العمل مع الملفات على Azure Databricks.

إنشاء الملفات والدلائل وتحديثها وحذفها برمجيا

في Databricks Runtime 11.3 LTS وما فوق، يمكنك معالجة ملفات مساحة العمل مباشرة في Azure Databricks. تستخدم الأمثلة التالية حزم ووظائف Python القياسية لإنشاء الملفات والدلائل ومعالجتها.

# Create a new directory

os.mkdir('dir1')

# Create a new file and write to it

with open('dir1/new_file.txt', "w") as f:

f.write("new content")

# Append to a file

with open('dir1/new_file.txt', "a") as f:

f.write(" continued")

# Delete a file

os.remove('dir1/new_file.txt')

# Delete a directory

os.rmdir('dir1')