Transformación de datos desde un origen de ODP de SAP mediante el conector CDC de SAP en Azure Data Factory o Azure Synapse Analytics

SE APLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

En este artículo se describe cómo usar el flujo de datos de asignación para transformar datos desde un origen de ODP de SAP mediante el conector CDC de SAP. Para obtener más información, lea el artículo de introducción para Azure Data Factory o Azure Synapse Analytics. Para obtener una introducción a la transformación de datos con Azure Data Factory y Azure Synapse Analytics, lea flujo de datos de asignación o consulte el tutorial sobre flujo de datos de asignación.

Sugerencia

Para obtener información sobre la compatibilidad general con el escenario de integración de datos de SAP, consulte el informe técnico sobre la integración de datos de SAP mediante Azure Data Factory que contiene una introducción detallada con comparaciones y una guía sobre cada conector de SAP.

Funcionalidades admitidas

Este conector CDC de SAP es compatible con las siguientes funcionalidades:

| Funcionalidades admitidas | IR |

|---|---|

| Flujo de datos de asignación (origen/-) | ①, ② |

① Azure Integration Runtime ② Entorno de ejecución de integración autohospedado

Este conector CDC de SAP usa el marco ODP de SAP para extraer datos de sistemas de origen de SAP. Para obtener una introducción a la arquitectura de la solución, lea Introducción y arquitectura a la captura de datos modificados (CDC) de SAP en nuestro centro de conocimiento de SAP.

El marco ODP de SAP se encuentra en todos los sistemas basados en SAP NetWeaver actualizados, incluidos SAP ECC, SAP S/4HANA, SAP BW, SAP BW/4HANA, SAP LT Replication Server (SLT). Para conocer los requisitos previos y las versiones mínimas necesarias, consulte Requisitos previos y configuración.

El conector CDC de SAP admite la autenticación básica o las comunicaciones de red segura (SNC), si SNC está configurado. Para obtener más información sobre SNC, consulte Introducción a las integraciones de SAP SNC para RFC: blog de SAP.

Limitaciones actuales

Estas son las limitaciones actuales del conector CDC de SAP en Data Factory:

- No puede restablecer ni eliminar las suscripciones ODQ en Data Factory (para ello, use la transacción ODQMON en el sistema SAP conectado).

- No puede usar jerarquías de SAP con la solución.

Requisitos previos

Para usar este conector CDC de SAP, consulte Requisitos previos y configuración del conector CDC de SAP.

Introducción

Para realizar la actividad de copia con una canalización, puede usar una de los siguientes herramientas o SDK:

- La herramienta Copiar datos

- Azure Portal

- El SDK de .NET

- El SDK de Python

- Azure PowerShell

- API REST

- La plantilla de Azure Resource Manager

Crear un servicio vinculado para el conector CDC de SAP mediante la interfaz de usuario

Siga los pasos descritos en Preparación del servicio vinculado CDC de SAP para crear un servicio vinculado para el conector CDC de SAP en la interfaz de usuario de Azure Portal.

Propiedades del conjunto de datos

Para preparar un conjunto de datos CDC de SAP, siga Preparación del conjunto de datos de origen CDC de SAP.

Transformar datos con el conector CDC de SAP

La fuente de cambios de ODP de SAP sin procesar es difícil de interpretar y actualizarla correctamente a un receptor puede ser un desafío. Por ejemplo, los atributos técnicos asociados a cada fila (como ODQ_CHANGEMODE) deberán ser entendidos para aplicar los cambios al receptor correctamente. Además, una extracción de datos modificados de ODP podría contener varios cambios en la misma clave (por ejemplo: el mismo pedido de venta). Por lo tanto, es importante respetar el orden de los cambios, al mismo tiempo que se optimiza el rendimiento mediante su procesamiento en paralelo. Además, la administración de una fuente de captura de datos modificados también requerirá realizar un seguimiento del estado como, por ejemplo, para proporcionar mecanismos integrados para la recuperación de errores. Los flujos de datos de asignación de la factoría de datos de Azure se encargan de todos estos aspectos. Por lo tanto, la conectividad CDC de SAP forma parte de la experiencia de flujo de datos de asignación. Esto permitirá a los usuarios concentrarse en la lógica de transformación necesaria sin tener que molestarse con los detalles técnicos de la extracción de datos.

Para empezar, crea una canalización con un flujo de datos de asignación.

A continuación, especifique una carpeta de almacenamiento provisional y un servicio vinculado de almacenamiento provisional en Azure Data Lake Gen2, que sirve como almacenamiento intermedio para los datos extraídos de SAP.

Nota

- El servicio vinculado de almacenamiento provisional no puede usar un entorno de ejecución de integración autohospedado.

- La carpeta de almacenamiento provisional debe considerarse un almacenamiento interno del conector SAP CDC. En optimizaciones futuras del runtime de SAP CDC, los detalles de implementación, como el formato de archivo usado para los datos de almacenamiento provisional, podrían cambiar. Por lo tanto, se recomienda no usar la carpeta de almacenamiento provisional para otros fines, por ejemplo, como origen para otras actividades de copia o flujos de datos de asignación.

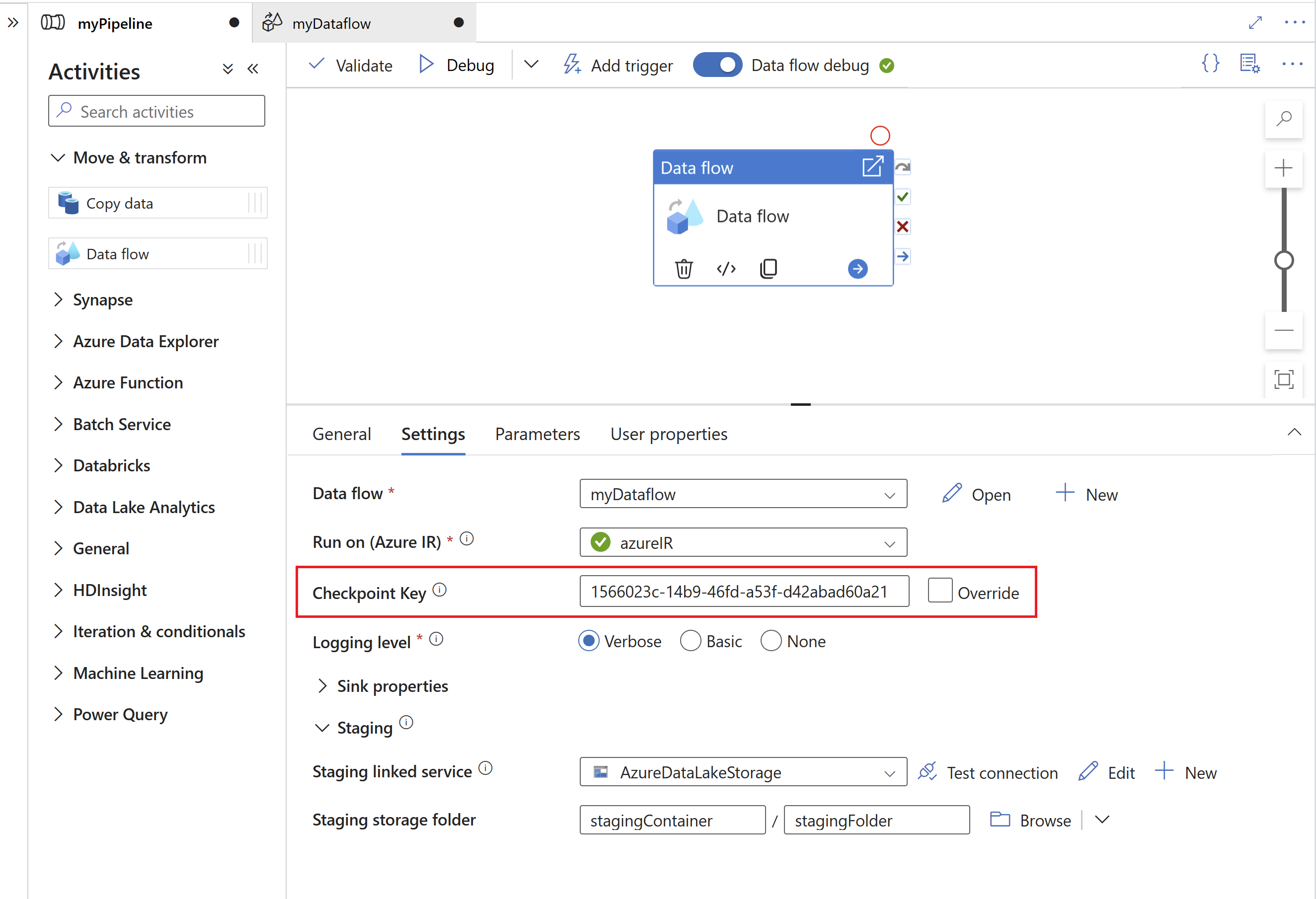

El runtime de CDC de SAP usa la clave de punto de comprobación para almacenar información de estado sobre el proceso de captura de datos modificados. Por ejemplo, permite que los flujos de datos de asignación CDC de SAP se recuperen automáticamente de situaciones de error o sepan si ya se ha establecido un proceso de captura de datos modificados para un flujo de datos determinado. Por lo tanto, es importante usar una clave de punto de comprobación única para cada origen. De lo contrario, la información de estado de un origen será sobrescrita por otro origen.

Nota

- Para evitar conflictos, se genera un identificador único como clave de punto de comprobación de forma predeterminada.

- Al usar parámetros para aprovechar el mismo flujo de datos para múltiples orígenes, asegúrese de parametrizar la clave de punto de comprobación con valores únicos por origen.

- La propiedad Clave de punto de comprobación no se muestra si el modo de ejecución dentro del origen CDC de SAP está establecido en Completo en cada ejecución (consulte la sección siguiente), ya que en este caso no se establece ningún proceso de captura de datos modificados.

Claves de punto de control con parámetros

Las claves de punto de control son necesarias para administrar el estado de los procesos de captura de datos modificados. Para una administración eficaz, puede parametrizar la clave de punto de control para permitir conexiones a orígenes diferentes. Aquí se muestra cómo puede implementar una clave de punto de control con parámetros:

Cree un parámetro global para almacenar la clave de punto de control en el nivel de canalización para garantizar la coherencia entre las ejecuciones:

"parameters": { "checkpointKey": { "type": "string", "defaultValue": "YourStaticCheckpointKey" } }Establezca mediante programación la clave de punto de control para invocar la canalización con el valor deseado cada vez que se ejecute. Este es un ejemplo de una llamada REST mediante la clave de punto de control con parámetros:

PUT https://management.azure.com/subscriptions/{subscriptionId}/resourceGroups/{resourceGroupName}/providers/Microsoft.DataFactory/factories/{factoryName}/pipelines/{pipelineName}?api-version=2018-06-01 Content-Type: application/json { "properties": { "activities": [ // Your activities here ], "parameters": { "checkpointKey": { "type": "String", "defaultValue": "YourStaticCheckpointKey" } } } }

Para obtener información más detallada, consulte Temas avanzados para el conector CDC de SAP.

Propiedades de Asignación de instancias de Data Flow

Para crear un flujo de datos de asignación mediante el conector CDC de SAP como origen, complete los pasos siguientes:

En ADF Studio, vaya a la sección Flujos de datos del centro Autor, seleccione el botón ... para abrir el menú desplegable Acciones de flujo de datos y seleccione el elemento Nuevo flujo de datos. Active el modo de depuración mediante el botón Depuración del flujo de datos en la barra superior del lienzo del flujo de datos.

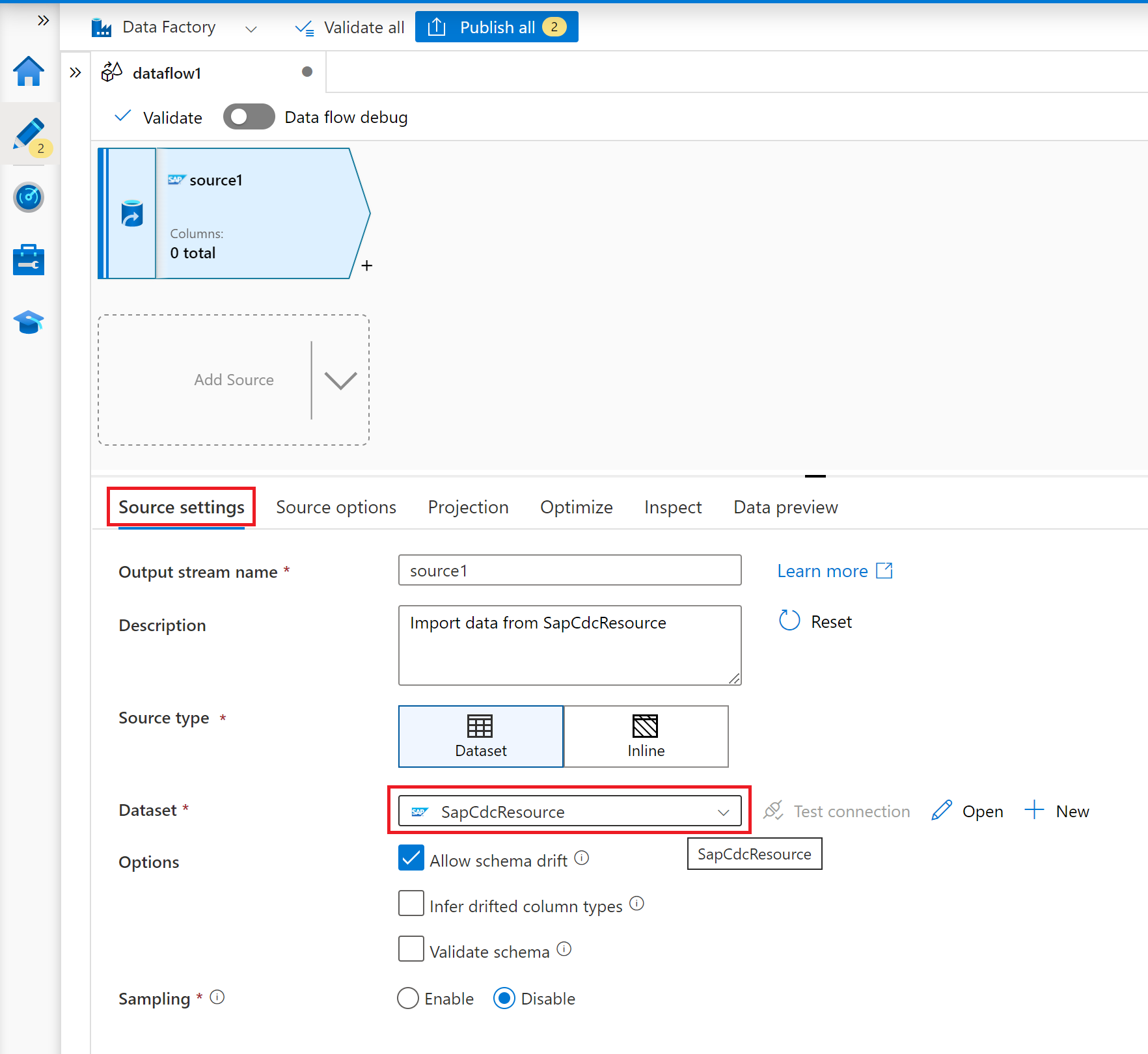

En el editor de flujo de datos de asignación, seleccione Agregar origen.

En la pestaña Configuración de origen, seleccione un conjunto de datos CDC de SAP preparado o seleccione el botón Nuevo para crear uno nuevo. Como alternativa, también puede seleccionar Alineado en la propiedad Tipo de origen y continuar sin definir un conjunto de datos explícito.

En la pestaña Opciones de origen, seleccione la opción Completo en cada ejecución si desea cargar instantáneas completas en cada ejecución del flujo de datos de asignación. Seleccione Completo en la primera ejecución y, a continuación, incremental si desea suscribirse a una fuente de cambios desde el sistema de origen de SAP, incluida una instantánea de datos completa inicial. En este caso, la primera ejecución de la canalización realiza una inicialización delta, lo que significa que crea una suscripción delta de ODP en el sistema de origen y devuelve una instantánea de datos completa actual. Las ejecuciones de canalización posteriores solo devuelven cambios incrementales desde la ejecución anterior. La opción solo cambios incrementales crea una suscripción delta de ODP sin devolver una instantánea de datos completa inicial en la primera ejecución. De nuevo, las ejecuciones posteriores devuelven cambios incrementales solo desde la ejecución anterior. Para ambas opciones de carga incremental es necesario especificar las claves del objeto de origen ODP en la propiedad Columnas de clave.

Para las pestañas Proyección, Optimizar e Inspeccionar, consulte el flujo de datos de asignación.

Optimización del rendimiento de cargas completas o iniciales con particiones de origen

Si el Modo de ejecución está establecido en Completo en cada ejecución o Completo en la primera ejecución y, después, incremental, la pestaña Optimizar ofrece una selección y un tipo de partición denominado Origen. Esta opción permite especificar varias condiciones de partición (es decir, filtrar) para fragmentar un conjunto de datos de origen grande en varias partes más pequeñas. Para cada partición, el conector CDC de SAP desencadena un proceso de extracción independiente en el sistema de origen de SAP.

Si las particiones tienen el mismo tamaño, la creación de particiones de origen puede aumentar linealmente el rendimiento de la extracción de datos. Para lograr estas mejoras de rendimiento, se necesitan recursos suficientes en el sistema de origen de SAP, la máquina virtual que hospeda el entorno de ejecución de integración autohospedado y Azure Integration Runtime.