Nota

L'accés a aquesta pàgina requereix autorització. Pots provar d'iniciar sessió o canviar de directori.

L'accés a aquesta pàgina requereix autorització. Pots provar de canviar directoris.

En esta página se explica cómo usar pruebas comparativas para evaluar la precisión del espacio de Genie.

Información general

Las pruebas comparativas le permiten crear un conjunto de preguntas de prueba que puede ejecutar para evaluar la precisión general de la respuesta de Genie. Un conjunto bien diseñado de pruebas comparativas que cubren las preguntas más frecuentes del usuario ayuda a evaluar la precisión del espacio de Genie a medida que lo refina. Cada espacio de Genie puede contener hasta 500 preguntas comparativas.

Las preguntas comparativas se ejecutan como nuevas conversaciones. No llevan el mismo contexto que una conversación de Genie en subproceso. Cada pregunta se procesa como una nueva consulta, mediante las instrucciones definidas en el espacio, incluidas las funciones SQL y SQL de ejemplo proporcionadas.

Adición de preguntas comparativas

Las preguntas comparativas deben reflejar diferentes formas de expresar las preguntas comunes que hacen los usuarios. Puede usarlos para comprobar la respuesta de Genie a las variaciones en expresiones de preguntas o formatos de pregunta diferentes.

Al crear una pregunta de prueba comparativa, puede incluir opcionalmente una consulta SQL cuyo conjunto de resultados sea la respuesta correcta. Durante las ejecuciones comparativas, la precisión se evalúa comparando el conjunto de resultados de la consulta SQL con el generado por Genie. También puede usar las funciones SQL del catálogo de Unity como respuestas estándar gold para pruebas comparativas.

Para agregar una pregunta comparativa:

Cerca de la parte superior del espacio de Genie, haga clic en Pruebas comparativas.

Haga clic en Agregar prueba comparativa.

En el campo Pregunta, escriba una pregunta de prueba comparativa que se va a probar.

(Opcional) Proporcione una consulta SQL que responda a la pregunta. Puede escribir su propia consulta escribiendo en el campo de texto SQL Answer, incluidas las funciones SQL del Unity Catalog. Como alternativa, haga clic en Generar SQL para que Genie escriba la consulta SQL automáticamente. Use una instrucción SQL que responda con precisión a la pregunta especificada.

Nota

Este paso es recomendado. Solo las preguntas que incluyen esta instrucción SQL de ejemplo se pueden evaluar automáticamente para obtener precisión. Las preguntas que no incluyan una respuesta SQL requieren que se puntúe una revisión manual. Si usa el botón Generar SQL , revise la instrucción para asegurarse de que responde con precisión a la pregunta.

(Opcional) Haga clic en Ejecutar para ejecutar la consulta y ver los resultados.

Cuando haya terminado de editarlo, haga clic en Agregar prueba comparativa.

Para actualizar una pregunta después de guardarla, haga clic en el icono de lápiz

para abrir el cuadro de diálogo Actualizar pregunta.

para abrir el cuadro de diálogo Actualizar pregunta.

Uso de pruebas comparativas para probar expresiones de preguntas alternativas

Al evaluar la precisión del espacio de Genie, es importante estructurar las pruebas para reflejar escenarios realistas. Los usuarios pueden formular la misma pregunta de maneras diferentes. Databricks recomienda agregar varias expresiones de la misma pregunta y usar el mismo ejemplo de SQL en las pruebas comparativas para evaluar completamente la precisión. La mayoría de los espacios de Genie deben incluir entre dos y cuatro expresiones de la misma pregunta.

Ejecución de preguntas comparativas

Los usuarios con al menos permisos CAN EDIT en un espacio de Genie pueden ejecutar una evaluación comparativa en cualquier momento. Puede ejecutar todas las preguntas comparativas o seleccionar un subconjunto de preguntas que se van a probar.

Para cada pregunta, Genie interpreta la entrada, genera SQL y devuelve resultados. A continuación, los resultados y SQL generados se comparan con la respuesta SQL definida en la pregunta de prueba comparativa.

Para ejecutar todas las preguntas comparativas:

- Cerca de la parte superior del espacio de Genie, haga clic en Pruebas comparativas.

- Haga clic en Ejecutar pruebas comparativas para iniciar la ejecución de pruebas.

Para ejecutar un subconjunto de preguntas comparativas:

- Cerca de la parte superior del espacio de Genie, haga clic en Pruebas comparativas.

- Active las casillas situadas junto a las preguntas que desea probar.

- Haga clic en Ejecutar selección para iniciar la prueba en las preguntas seleccionadas.

También puede seleccionar un subconjunto de preguntas de un resultado de prueba comparativa anterior y volver a ejecutar esas preguntas específicas para probar las mejoras.

Las benchmarks continúan ejecutándose cuando navega fuera de la página. Puede comprobar los resultados en la pestaña Evaluación cuando se complete la ejecución.

Interpretación de las clasificaciones

Los criterios siguientes determinan cómo se clasifican las respuestas de Genie:

| Condición | Rating |

|---|---|

| Genie genera SQL que coincide exactamente con la respuesta SQL proporcionada. | Bien |

| Genie genera un conjunto de resultados que coincide exactamente con el conjunto de resultados generado por la respuesta SQL | Bien |

| Genie genera un conjunto de resultados con los mismos datos que la respuesta SQL , pero ordenado de forma diferente | Bien |

| Genie genera un conjunto de resultados con valores numéricos que redondean a los mismos 4 dígitos significativos que la respuesta SQL | Bien |

| Genie genera SQL que genera un conjunto de resultados vacío o devuelve un error. | Malo |

| Genie genera un conjunto de resultados que incluye columnas adicionales en comparación con el conjunto de resultados generado por la respuesta SQL. | Malo |

| Genie genera un único resultado de celda diferente del resultado de una sola celda generado por la respuesta SQL. | Malo |

Revisión manual necesaria: las respuestas se marcan con esta etiqueta cuando Genie no puede evaluar la exactitud o cuando los resultados de la consulta generados por Genie no contienen una coincidencia exacta con los resultados de la respuesta SQL proporcionada. Las preguntas comparativas que no incluyan una respuesta SQL deben revisarse manualmente.

Acceso a las evaluaciones de pruebas comparativas

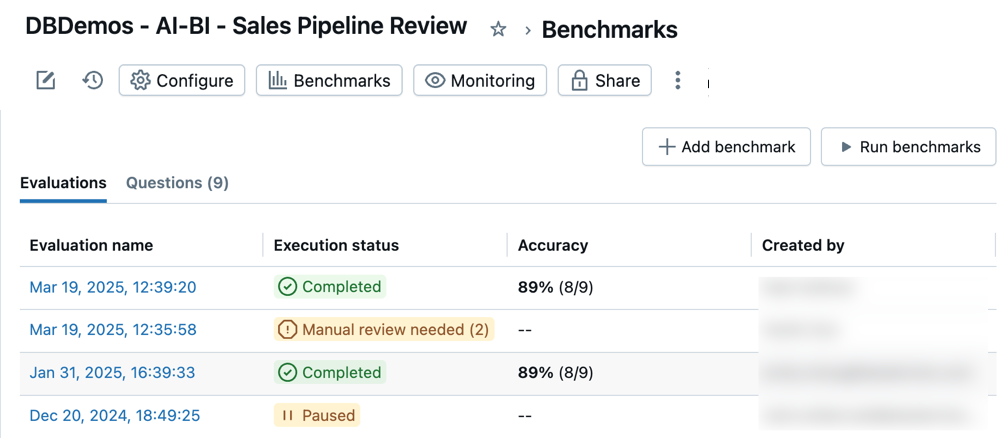

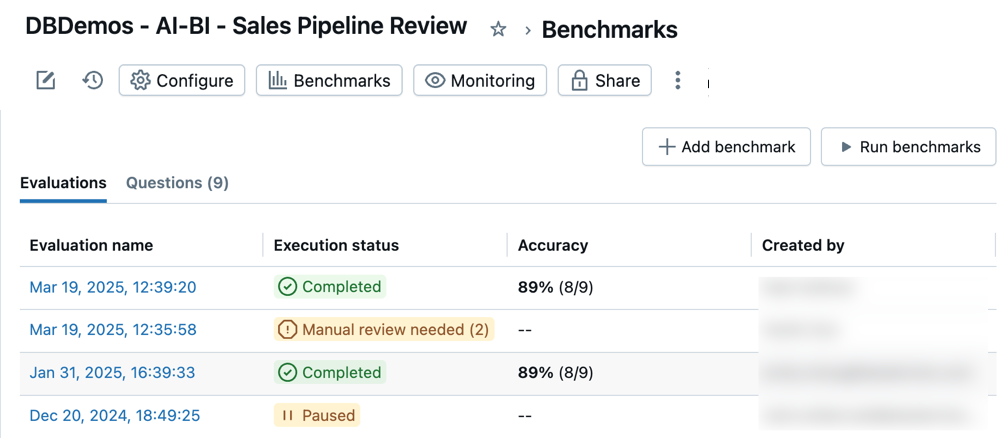

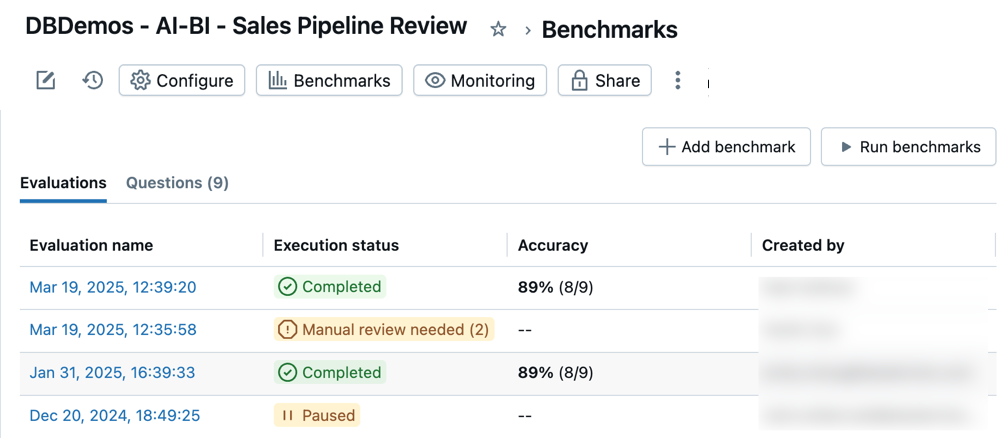

Puede acceder a todas las evaluaciones comparativas para realizar un seguimiento de la precisión en el espacio de Genie a lo largo del tiempo. Al abrir las pruebas comparativas de un espacio, aparece una lista con marcas de tiempo de ejecuciones de evaluación en la pestaña Evaluaciones . Si no se encuentra ninguna ejecución de evaluación, consulte Incorporación de preguntas de pruebas comparativas o Preguntas de pruebas comparativas de ejecución.

En la pestaña Evaluaciones, se muestra un resumen de las evaluaciones y su rendimiento mostrado en las siguientes categorías:

Nombre de evaluación: marca de tiempo que indica cuándo se produjo una ejecución de evaluación. Haga clic en la marca de tiempo para ver los detalles de esa evaluación. Estado de ejecución: indica si la evaluación se ha completado, pausado o incorrecto. Si una ejecución de evaluación incluye preguntas comparativas que no tienen respuestas SQL predefinidas, se marca para su revisión en esta columna. Precisión: una evaluación numérica de la precisión en todas las preguntas comparativas. En el caso de las ejecuciones de evaluación que requieren una revisión manual, solo aparece una medida de precisión después de que se hayan revisado esas preguntas. Creada por: indica el nombre del usuario que ejecutó la evaluación.

Revisión de evaluaciones individuales

Puede revisar las evaluaciones individuales para obtener una visión detallada de cada respuesta. Puede editar la evaluación de cualquier pregunta y actualizar los elementos que necesiten revisión manual.

Para revisar evaluaciones individuales:

Cerca de la parte superior del espacio de Genie, haga clic en Pruebas comparativas.

Haga clic en la marca de tiempo de cualquier evaluación de la columna Nombre de evaluación para abrir una vista detallada de esa ejecución de prueba.

Use la lista de preguntas en el lado izquierdo de la pantalla para ver una vista detallada de cada pregunta.

Revise y compare la respuesta de salida del modelo con la respuesta de la verdad básica.

En el caso de los resultados clasificados como incorrectos, aparece una explicación que describe por qué el resultado se ha clasificado como Incorrecto. Esto le ayuda a comprender las diferencias específicas entre la salida generada y la verdad básica esperada.

Nota

Los resultados de estas respuestas aparecen en los detalles de evaluación durante una semana. Después de una semana, los resultados ya no son visibles. La instrucción SQL generada y la instrucción SQL de ejemplo permanecen.

Haga clic en Actualizar verdad de base para guardar la respuesta como la nueva verdad de base para esta pregunta. Esto es útil si no existe ninguna verdad básica, o si la respuesta es mejor o más precisa que la declaración de la verdad fundamental existente.

Haga clic en la etiqueta

para editar la evaluación.

para editar la evaluación.Marque cada resultado como Bueno o Malo para obtener una puntuación precisa para esta evaluación.