Přírůstkové kopírování nových a změněných souborů na základě funkce LastModifiedDate pomocí nástroje Pro kopírování dat

PLATÍ PRO: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

V tomto kurzu vytvoříte datovou továrnu pomocí webu Azure Portal. Pak použijete nástroj pro kopírování dat k vytvoření kanálu, který přírůstkově kopíruje nové a změněné soubory, pouze ze služby Azure Blob Storage do služby Azure Blob Storage. Používá LastModifiedDate k určení souborů, které se mají kopírovat.

Po dokončení kroků zde služba Azure Data Factory prohledá všechny soubory ve zdrojovém úložišti, použije filtr souborů podle LastModifiedDatea zkopíruje do cílového úložiště pouze soubory, které jsou nové nebo byly od poslední doby aktualizovány. Mějte na paměti, že pokud Data Factory prohledá velký počet souborů, měli byste stále očekávat dlouhé doby trvání. Kontrola souborů je časově náročná, i když se sníží množství zkopírovaných dat.

Poznámka:

Pokud se službou Data Factory teprve začínáte, přečtěte si téma Úvod do Azure Data Factory.

V tomto kurzu dokončíte tyto úlohy:

- Vytvoření datové továrny

- Vytvoření kanálu pomocí nástroje pro kopírování dat

- Monitorování spuštění aktivit a kanálu

Požadavky

- Předplatné Azure: Pokud ještě nemáte předplatné Azure, vytvořte si bezplatný účet před tím, než začnete.

- Účet služby Azure Storage: Úložiště objektů blob použijte pro úložiště dat zdroje a jímky. Pokud nemáte účet Azure Storage, postupujte podle pokynů v tématu Vytvoření účtu úložiště.

Vytvoření dvou kontejnerů v úložišti objektů blob

Připravte si úložiště objektů blob pro kurz provedením těchto kroků:

Vytvořte kontejner pojmenovaný zdroj. K provedení této úlohy můžete použít různé nástroje, například Průzkumník služby Azure Storage.

Vytvořte kontejner s názvem cíl.

Vytvoření datové továrny

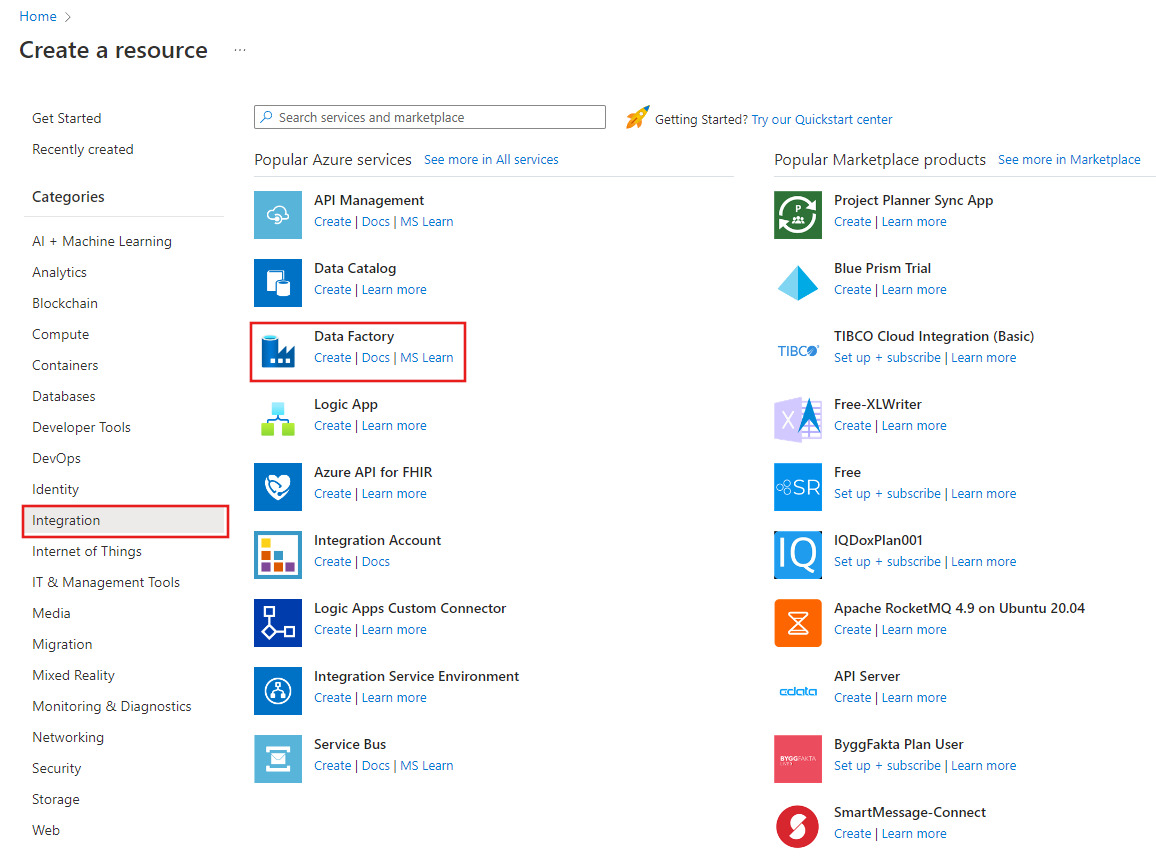

V levém podokně vyberte Vytvořit prostředek. Vyberte Integration>Data Factory:

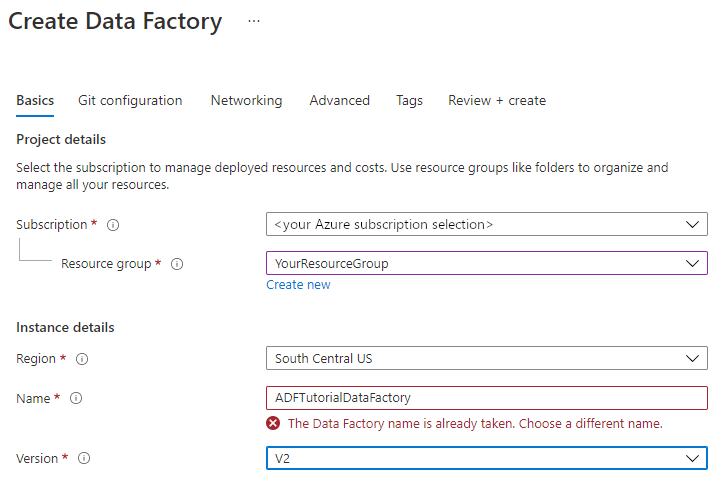

Na stránce Nová datová továrna v části Název zadejte ADFTutorialDataFactory.

Název datové továrny musí být globálně jedinečný. Může se zobrazit tato chybová zpráva:

Pokud se zobrazí chybová zpráva týkající se hodnoty názvu, zadejte jiný název datové továrny. Použijte například název vaše_jménoADFTutorialDataFactory. Pravidla pojmenování artefaktů služby Data Factory najdete v tématu Data Factory – pravidla pojmenování.

V části Předplatné vyberte předplatné Azure, ve kterém vytvoříte novou datovou továrnu.

V části Skupina prostředků proveďte jeden z těchto kroků:

Vyberte Použít existující a pak v seznamu vyberte existující skupinu prostředků.

Vyberte Vytvořit nový a zadejte název skupiny prostředků.

Informace o skupinách prostředků najdete v tématu Použití skupin prostředků ke správě prostředků Azure.

Jako Verzi vyberte V2.

V části Umístění vyberte umístění datové továrny. V seznamu se zobrazí jenom podporovaná umístění. Úložiště dat (například Azure Storage a Azure SQL Database) a výpočty (například Azure HDInsight), které vaše datová továrna používá, můžou být v jiných umístěních a oblastech.

Vyberte Vytvořit.

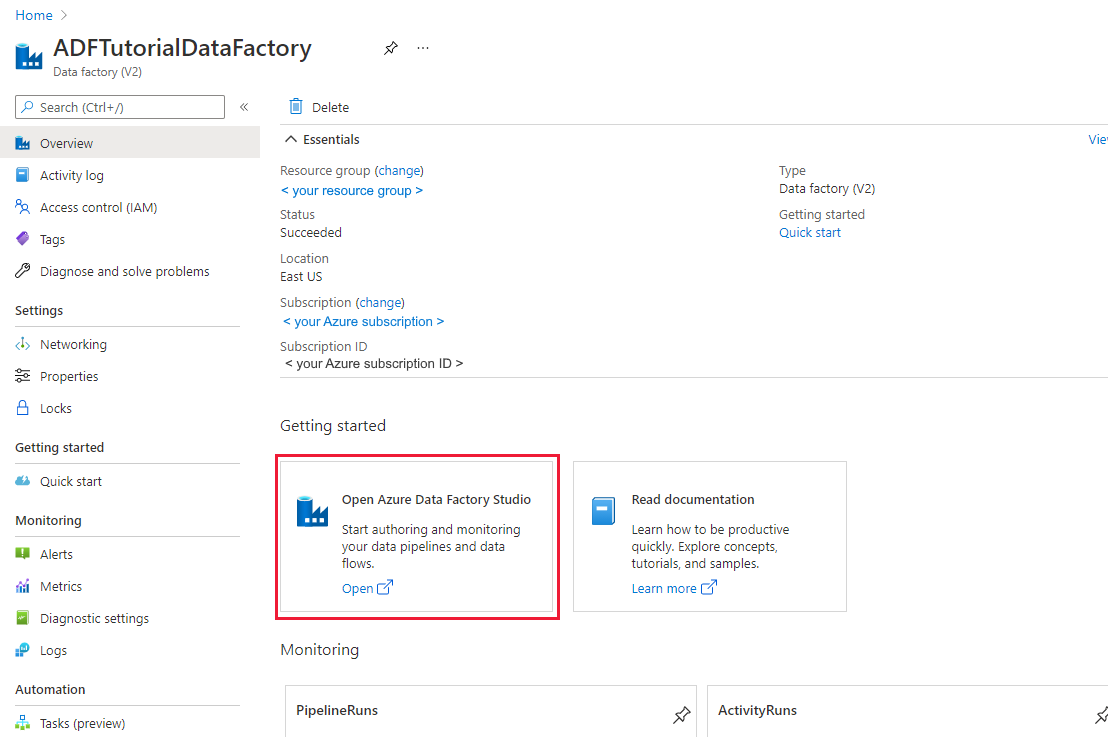

Po vytvoření datové továrny se zobrazí domovská stránka datové továrny.

Pokud chcete otevřít uživatelské rozhraní (UI) azure Data Factory na samostatné kartě, vyberte Otevřít na dlaždici Otevřít Azure Data Factory Studio :

Vytvoření kanálu pomocí nástroje pro kopírování dat

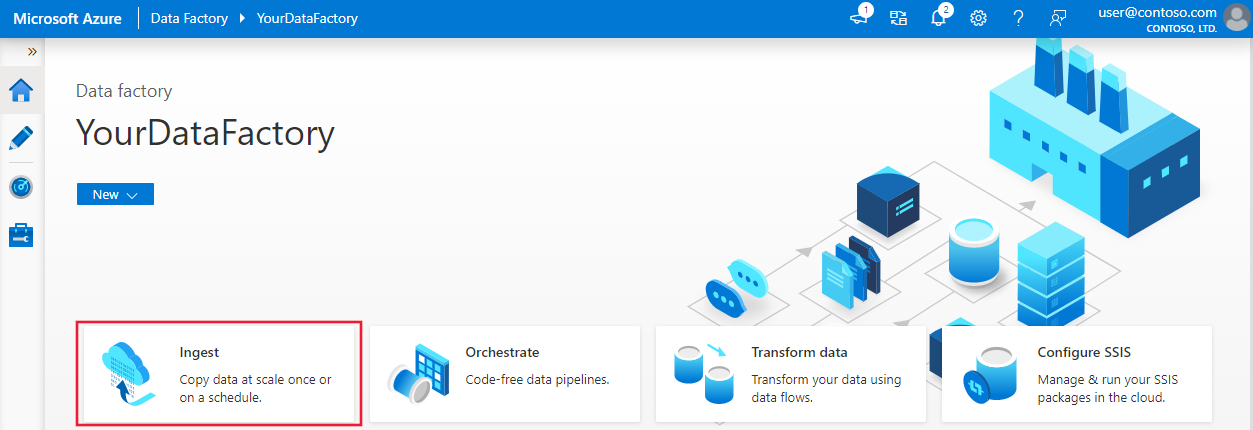

Na domovské stránce služby Azure Data Factory vyberte dlaždici Ingestování a otevřete nástroj Pro kopírování dat:

Na stránce Vlastnosti proveďte následující kroky:

V části Typ úkolu vyberte Předdefinovaný úkol kopírování.

V části Tempo úkolu nebo plán úkolu vyberte Přeskakující okno.

V části Opakování zadejte 15 minut.

Vyberte Další.

Na stránce Zdrojové úložiště dat proveďte následující kroky:

Pokud chcete přidat připojení, vyberte + Nové připojení .

V galerii vyberte Azure Blob Storage a pak vyberte Pokračovat:

Na stránce Nové připojení (Azure Blob Storage) vyberte své předplatné Azure ze seznamu předplatných Azure a ze seznamu názvů účtů úložiště svůj účet úložiště. Otestujte připojení a pak vyberte Vytvořit.

V bloku Připojení ion vyberte nově vytvořené připojení.

V části Soubor nebo složka vyberte Procházet a zvolte zdrojovásložka a pak vyberte OK.

V části Chování při načítání souboru vyberte Přírůstkové načtení: LastModifiedDate a zvolte Binární kopie.

Vyberte Další.

Na stránce Cílové úložiště dat proveďte následující kroky:

Vyberte připojení AzureBlobStorage, které jste vytvořili. Jedná se o stejný účet úložiště jako zdrojové úložiště dat.

V části Cesta ke složce vyhledejte a vyberte cílovou složku a pak vyberte OK.

Vyberte Další.

Na stránce Nastavení v části Název úlohy zadejte DeltaCopyFromBlobPipeline a pak vyberte Další. Data Factory vytvoří kanál se zadaným názvem úlohy.

Na stránce Souhrn zkontrolujte nastavení a pak vyberte Další.

Na stránce Nasazení vyberte Monitorovat a začněte monitorovat kanál (úlohu).

Všimněte si, že je vlevo automaticky vybraná karta Monitorování. Aplikace se přepne na kartu Monitorování . Zobrazí se stav kanálu. Seznam můžete aktualizovat kliknutím na Aktualizovat. Výběrem odkazu v části Název kanálu zobrazte podrobnosti o spuštění aktivity nebo znovu spusťte kanál.

Kanál má jenom jednu aktivitu (aktivitu kopírování), takže uvidíte jenom jednu položku. Podrobnosti o operaci kopírování získáte tak, že na stránce Spuštění aktivity vyberete odkaz Podrobnosti (ikona brýle) ve sloupci Název aktivity. Podrobnosti o vlastnostech najdete v aktivita Copy přehledu.

Vzhledem k tomu, že ve zdrojovém kontejneru v účtu úložiště blob nejsou žádné soubory, neuvidíte v účtu žádné soubory zkopírované do cílového kontejneru:

Vytvořte prázdný textový soubor a pojmenujte ho file1.txt. Nahrajte tento textový soubor do zdrojového kontejneru ve vašem účtu úložiště. K provádění těchto úloh můžete použít různé nástroje, jako je Průzkumník služby Azure Storage.

Pokud se chcete vrátit do zobrazení spuštění kanálu, vyberte v nabídce Popis cesty na stránce Spuštění aktivit odkaz Všechny spuštění kanálu a počkejte, až se stejný kanál automaticky aktivuje.

Po dokončení druhého spuštění kanálu postupujte podle stejných kroků, které jsme zmínili dříve, a zkontrolujte podrobnosti o spuštění aktivity.

Uvidíte, že se jeden soubor (file1.txt) zkopíroval ze zdrojového kontejneru do cílového kontejneru vašeho účtu blob storage:

Vytvořte další prázdný textový soubor a pojmenujte ho file2.txt. Nahrajte tento textový soubor do zdrojového kontejneru v účtu úložiště objektů blob.

Opakujte kroky 11 a 12 pro druhý textový soubor. Uvidíte, že se během tohoto spuštění kanálu zkopíroval jenom nový soubor (file2.txt) ze zdrojového kontejneru do cílového kontejneru vašeho účtu úložiště.

Pomocí Průzkumník služby Azure Storage můžete také ověřit, že se soubory zkopírovaly jenom v jednom souboru:

Související obsah

V následujícím kurzu se dozvíte, jak transformovat data pomocí clusteru Apache Spark v Azure:

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro