Transformace dat spuštěním aktivity Pythonu v Azure Databricks

PLATÍ PRO:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

Aktivita Pythonu Azure Databricks v kanálu spouští soubor Pythonu v clusteru Azure Databricks. Tento článek vychází z článku o aktivitách transformace dat, který představuje obecný přehled transformace dat a podporovaných transformačních aktivit. Azure Databricks je spravovaná platforma pro spouštění Apache Sparku.

Jedenáctiminutové představení a ukázku této funkce najdete v tomto videu:

Přidání aktivity Pythonu pro Azure Databricks do kanálu pomocí uživatelského rozhraní

Pokud chcete v kanálu použít aktivitu Pythonu pro Azure Databricks, proveďte následující kroky:

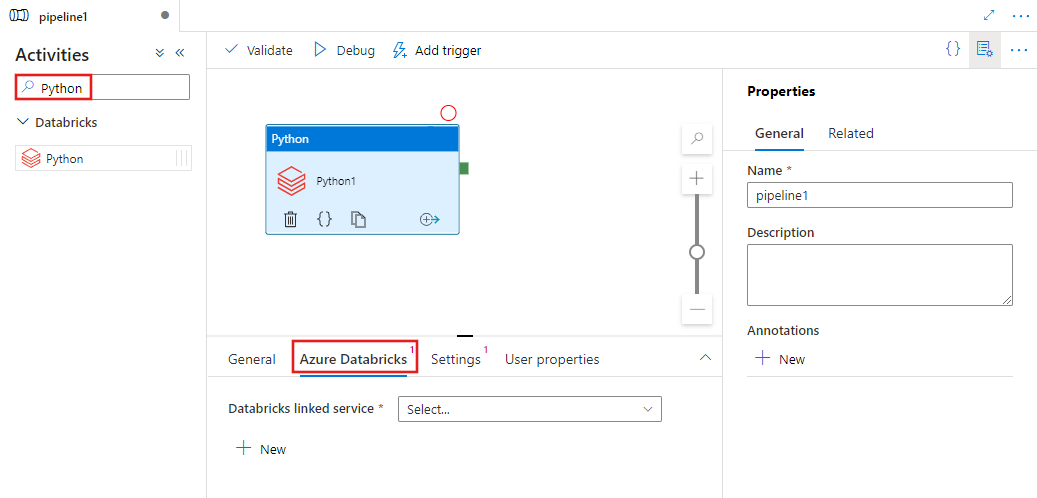

Vyhledejte Python v podokně Aktivity kanálu a přetáhněte aktivitu Pythonu na plátno kanálu.

Vyberte novou aktivitu Pythonu na plátně, pokud ještě není vybraná.

Výběrem karty Azure Databricks vyberte nebo vytvořte novou propojenou službu Azure Databricks, která spustí aktivitu Pythonu.

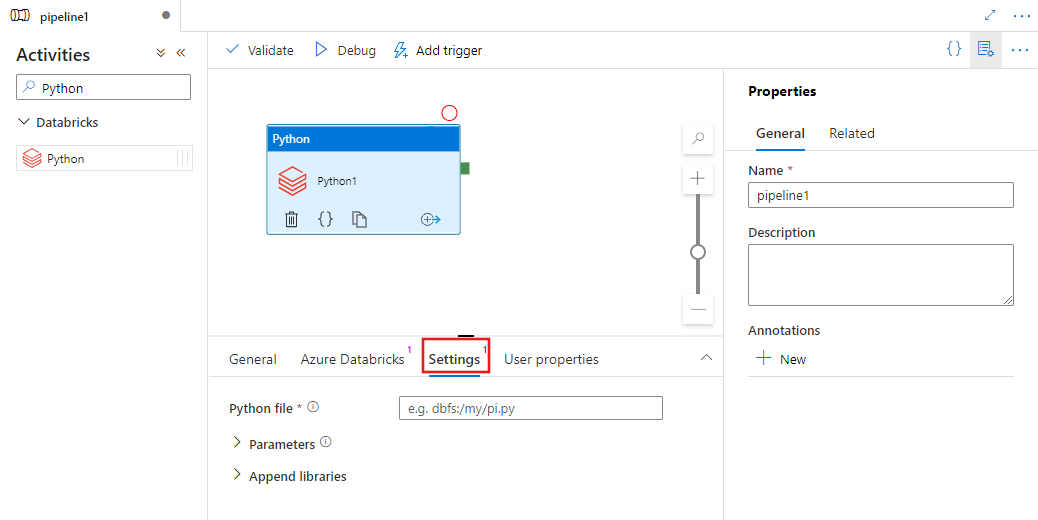

Vyberte kartu Nastavení a zadejte cestu v rámci Azure Databricks k souboru Pythonu, který se má spustit, volitelné parametry, které se mají předat, a všechny další knihovny, které se mají nainstalovat do clusteru, aby se úloha spustila.

Definice aktivity Pythonu v Databricks

Tady je ukázková definice JSON aktivity Pythonu databricks:

{

"activity": {

"name": "MyActivity",

"description": "MyActivity description",

"type": "DatabricksSparkPython",

"linkedServiceName": {

"referenceName": "MyDatabricksLinkedService",

"type": "LinkedServiceReference"

},

"typeProperties": {

"pythonFile": "dbfs:/docs/pi.py",

"parameters": [

"10"

],

"libraries": [

{

"pypi": {

"package": "tensorflow"

}

}

]

}

}

}

Vlastnosti aktivity Pythonu pro Databricks

Následující tabulka popisuje vlastnosti JSON použité v definici JSON:

| Vlastnost | Popis | Povinní účastníci |

|---|---|---|

| name | Název aktivity v kanálu | Ano |

| description | Text popisující, co aktivita dělá. | No |

| type | Pro aktivitu Pythonu databricks je typ aktivity DatabricksSparkPython. | Ano |

| linkedServiceName | Název propojené služby Databricks, na které se aktivita Pythonu spouští. Další informace o této propojené službě najdete v článku o propojených službách Compute. | Ano |

| pythonFile | Identifikátor URI souboru Pythonu, který se má spustit. Podporují se pouze cesty DBFS. | Ano |

| parametry | Parametry příkazového řádku, které se předají do souboru Pythonu. Toto je pole řetězců. | No |

| knihovny | Seznam knihoven, které se mají nainstalovat do clusteru, který spustí úlohu. Může to být pole řetězce, objektu <.> | No |

Podporované knihovny pro aktivity Databricks

Ve výše uvedené definici aktivity Databricks zadáte tyto typy knihoven: jar, egg, maven, pypi, cran.

{

"libraries": [

{

"jar": "dbfs:/mnt/libraries/library.jar"

},

{

"egg": "dbfs:/mnt/libraries/library.egg"

},

{

"maven": {

"coordinates": "org.jsoup:jsoup:1.7.2",

"exclusions": [ "slf4j:slf4j" ]

}

},

{

"pypi": {

"package": "simplejson",

"repo": "http://my-pypi-mirror.com"

}

},

{

"cran": {

"package": "ada",

"repo": "https://cran.us.r-project.org"

}

}

]

}

Další podrobnosti najdete v dokumentaci k Databricks pro typy knihoven.

Jak nahrát knihovnu v Databricks

Můžete použít uživatelské rozhraní pracovního prostoru:

Použití uživatelského rozhraní pracovního prostoru Databricks

K získání cesty dbfs knihovny přidané pomocí uživatelského rozhraní můžete použít Rozhraní příkazového řádku Databricks.

Knihovny Jar se obvykle ukládají v souboru dbfs:/FileStore/jars při používání uživatelského rozhraní. Seznam všech prostřednictvím rozhraní příkazového řádku: databricks fs ls dbfs:/FileStore/job-jars

Nebo můžete použít rozhraní příkazového řádku Databricks:

Postupujte podle pokynů ke kopírování knihovny pomocí rozhraní příkazového řádku Databricks.

Použití rozhraní příkazového řádku Databricks (kroky instalace)

Například zkopírování souboru JAR do dbfs:

dbfs cp SparkPi-assembly-0.1.jar dbfs:/docs/sparkpi.jar

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro