Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Důležité

Tato funkce je v beta verzi. Správci účtu můžou řídit přístup k této funkci ze stránky Previews .

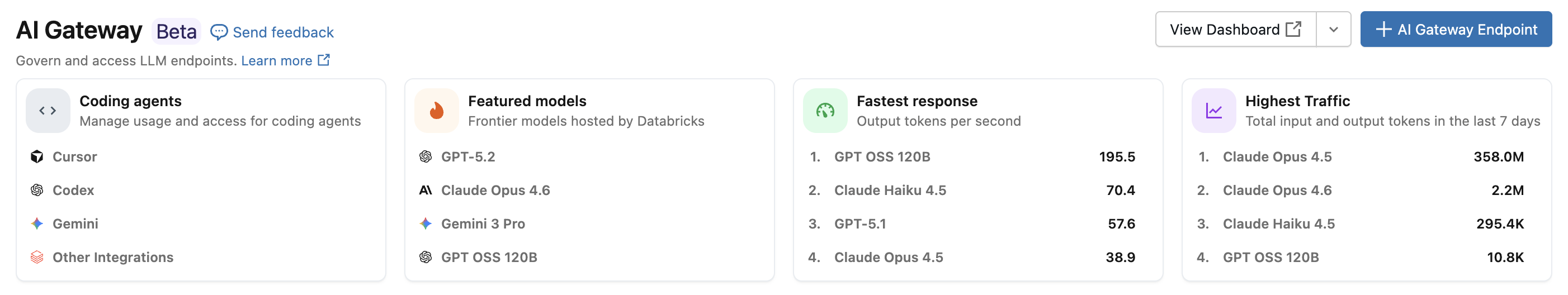

Díky integraci agenta kódování Azure Databricks můžete spravovat přístup a využití pro kódovací agenty, jako jsou Cursor, Gemini CLI, Codex CLI a Claude Code. Postaveno na AI Gateway, poskytuje limity rychlosti, sledování využití a inferenční tabulky pro vaše nástroje pro kódování.

Features

- Přístup: Přímý přístup k různým nástrojům a modelům kódování, a to vše na jedné faktuře.

- Pozorovatelnost: Jeden jednotný řídicí panel pro sledování využití, výdajů a metrik napříč všemi nástroji pro psaní kódu.

- Jednotné zásady správného řízení: Správci můžou spravovat oprávnění modelu a omezení rychlosti přímo prostřednictvím služby AI Gateway.

Požadavky

- Pro váš účet je povolená verze Preview služby AI Gateway (beta verze).

- Pracovní prostor Azure Databricks v regionu podporovaném funkcí AI Gateway (Beta).

- Služba Unity Catalog je pro váš pracovní prostor povolená. Podívejte se na Povolení pracovního prostoru pro Unity Catalog.

Podporovaní agenti

Podporují se následující agenti kódování:

Nastavení

Cursor

Konfigurace kurzoru pro použití koncových bodů brány AI:

Krok 1: Konfigurace základní adresy URL a klíče rozhraní API

Otevřete Cursor a přejděte do Nastavení>Nastavení kurzoru>Modely>Klíče rozhraní API.

Povolte přepsat základní adresu URL OpenAI a zadejte adresu URL:

https://<ai-gateway-url>/cursor/v1Nahraďte

<ai-gateway-url>adresou URL koncového bodu brány AI.Vložte osobní přístupový token Azure Databricks do pole Klíč rozhraní API OpenAI .

Krok 2: Přidání vlastních modelů

- V nastavení kurzoru klikněte na + Přidat vlastní model .

- Přidejte název koncového bodu služby AI Gateway a povolte přepínač.

Poznámka:

V současné době se podporují pouze koncové body základního modelu vytvořené službou Azure Databricks.

Krok 3: Testování integrace

- Otevřete režim Ptejte se v

Cmd+Lsystému (macOS) neboCtrl+L(Windows/Linux) a vyberte svůj model. - Odeslat zprávu. Všechny požadavky se teď směrují přes Azure Databricks.

Codex CLI

Krok 1: Nastavení proměnné prostředí DATABRICKS_TOKEN

export DATABRICKS_TOKEN=<databricks_pat_token>

Krok 2: Konfigurace klienta Codex

Vytvořte nebo upravte konfigurační soubor Codex na adrese ~/.codex/config.toml:

profile = "default"

[profiles.default]

model_provider = "proxy"

model = "databricks-gpt-5-2"

[model_providers.proxy]

name = "Databricks Proxy"

base_url = "https://<ai-gateway-url>/openai/v1"

env_key = "DATABRICKS_TOKEN"

wire_api = "responses"

Nahraďte <ai-gateway-url> adresou URL koncového bodu brány AI.

Rozhraní příkazového řádku Gemini

Krok 1: Instalace nejnovější verze Rozhraní příkazového řádku Gemini

npm install -g @google/gemini-cli@nightly

Krok 2: Konfigurace proměnných prostředí

Vytvořte soubor ~/.gemini/.env a přidejte následující konfiguraci. Další podrobnosti najdete v dokumentaci k ověřování rozhraní příkazového řádku Gemini .

GEMINI_MODEL=databricks-gemini-2-5-flash

GOOGLE_GEMINI_BASE_URL=https://<ai-gateway-url>/gemini

GEMINI_API_KEY_AUTH_MECHANISM="bearer"

GEMINI_API_KEY=<databricks_pat_token>

Nahraďte <ai-gateway-url> adresou URL koncového bodu brány AI a <databricks_pat_token> osobním přístupovým tokenem.

Claude Code

Krok 1: Konfigurace klienta Clauda Code

Přidejte následující konfiguraci do ~/.claude/settings.json. Další podrobnosti najdete v dokumentaci k nastavení Clauda Code .

{

"env": {

"ANTHROPIC_MODEL": "databricks-claude-opus-4-6",

"ANTHROPIC_BASE_URL": "https://<ai-gateway-url>/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<databricks_pat_token>",

"ANTHROPIC_CUSTOM_HEADERS": "x-databricks-use-coding-agent-mode: true",

"CLAUDE_CODE_DISABLE_EXPERIMENTAL_BETAS": "1"

}

}

Nahraďte <ai-gateway-url> adresou URL koncového bodu brány AI a <databricks_pat_token> osobním přístupovým tokenem.

Krok 2 (volitelné): Nastavení shromažďování metrik OpenTelemetry

Podrobnosti najdete v tématu Nastavení shromažďování dat OpenTelemetry ohledně exportu metrik a protokolů z Claude Code do tabulek Delta spravovaných katalogem Unity.

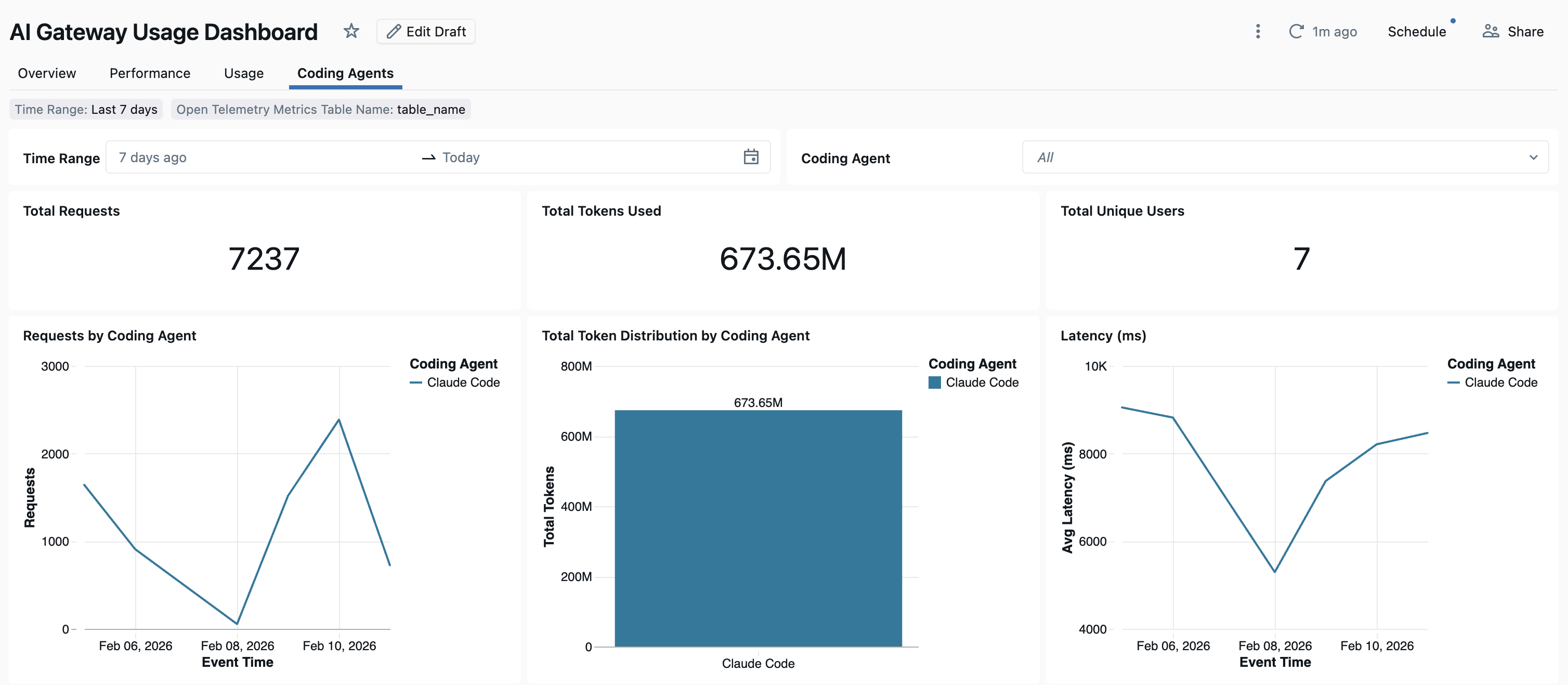

Dashboard

Jakmile je využití agenta kódování sledováno prostřednictvím AI Gateway, můžete své metriky zobrazit a monitorovat na předpřipraveném řídicím panelu.

Pokud chcete získat přístup k řídicímu panelu, na stránce Brány AI vyberte Zobrazit řídicí panel . Tím se vytvoří předem nakonfigurovaný dashboard s grafy pro využití nástrojů při kódování.

Nastavení shromažďování dat OpenTelemetry

Azure Databricks podporuje export metrik OpenTelemetry a protokolů z platformy Claude Code do tabulek Delta spravovaných v katalogu Unity. Všechny metriky jsou data časových řad exportovaná pomocí standardního protokolu metrik OpenTelemetry a protokoly jsou exportovány pomocí protokolu protokolů OpenTelemetry. Dostupné metriky a události najdete v tématu Monitorování využití Kódu Claudu.

Požadavky

- Funkce OpenTelemetry v Azure Databricks Preview je povolená. Podívejte se na Správa náhledů Azure Databricks.

Krok 1: Vytvoření tabulek OpenTelemetry v katalogu Unity

Vytvořte tabulky spravované službou Unity Catalog předem nakonfigurované pomocí metrik OpenTelemetry a schémat protokolů.

Tabulka metrik

CREATE TABLE <catalog>.<schema>.<table_prefix>_otel_metrics (

name STRING,

description STRING,

unit STRING,

metric_type STRING,

gauge STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

value: DOUBLE,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT

>,

sum STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

value: DOUBLE,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT,

aggregation_temporality: STRING,

is_monotonic: BOOLEAN

>,

histogram STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

bucket_counts: ARRAY<LONG>,

explicit_bounds: ARRAY<DOUBLE>,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT,

min: DOUBLE,

max: DOUBLE,

aggregation_temporality: STRING

>,

exponential_histogram STRUCT<

attributes: MAP<STRING, STRING>,

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

scale: INT,

zero_count: LONG,

positive_bucket: STRUCT<

offset: INT,

bucket_counts: ARRAY<LONG>

>,

negative_bucket: STRUCT<

offset: INT,

bucket_counts: ARRAY<LONG>

>,

flags: INT,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

min: DOUBLE,

max: DOUBLE,

zero_threshold: DOUBLE,

aggregation_temporality: STRING

>,

summary STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

quantile_values: ARRAY<STRUCT<

quantile: DOUBLE,

value: DOUBLE

>>,

attributes: MAP<STRING, STRING>,

flags: INT

>,

metadata MAP<STRING, STRING>,

resource STRUCT<

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

resource_schema_url STRING,

instrumentation_scope STRUCT<

name: STRING,

version: STRING,

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

metric_schema_url STRING

) USING DELTA

TBLPROPERTIES (

'otel.schemaVersion' = 'v1'

)

Tabulka protokolů

CREATE TABLE <catalog>.<schema>.<table_prefix>_otel_logs (

event_name STRING,

trace_id STRING,

span_id STRING,

time_unix_nano LONG,

observed_time_unix_nano LONG,

severity_number STRING,

severity_text STRING,

body STRING,

attributes MAP<STRING, STRING>,

dropped_attributes_count INT,

flags INT,

resource STRUCT<

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

resource_schema_url STRING,

instrumentation_scope STRUCT<

name: STRING,

version: STRING,

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

log_schema_url STRING

) USING DELTA

TBLPROPERTIES (

'otel.schemaVersion' = 'v1'

)

Krok 2: Aktualizace souboru nastavení Claude Code

Přidejte následující proměnné prostředí do bloku env ve svém souboru ~/.claude/settings.json pro povolení exportu metrik a protokolů:

{

"env": {

"CLAUDE_CODE_ENABLE_TELEMETRY": "1",

"OTEL_METRICS_EXPORTER": "otlp",

"OTEL_EXPORTER_OTLP_METRICS_PROTOCOL": "http/protobuf",

"OTEL_EXPORTER_OTLP_METRICS_ENDPOINT": "https://<workspace-url>/api/2.0/otel/v1/metrics",

"OTEL_EXPORTER_OTLP_METRICS_HEADERS": "content-type=application/x-protobuf,Authorization=Bearer <databricks_pat_token>,X-Databricks-UC-Table-Name=<catalog>.<schema>.<table_prefix>_otel_metrics",

"OTEL_METRIC_EXPORT_INTERVAL": "10000",

"OTEL_LOGS_EXPORTER": "otlp",

"OTEL_EXPORTER_OTLP_LOGS_PROTOCOL": "http/protobuf",

"OTEL_EXPORTER_OTLP_LOGS_ENDPOINT": "https://<workspace-url>/api/2.0/otel/v1/logs",

"OTEL_EXPORTER_OTLP_LOGS_HEADERS": "content-type=application/x-protobuf,Authorization=Bearer <databricks_pat_token>,X-Databricks-UC-Table-Name=<catalog>.<schema>.<table_prefix>_otel_logs",

"OTEL_LOGS_EXPORT_INTERVAL": "5000"

}

}

Nahraďte následující položky:

-

<workspace-url>s URL adresou pracovního prostoru Azure Databricks. -

<databricks_pat_token>s vaším osobním přístupovým tokenem. -

<catalog>.<schema>.<table_prefix>s předponou katalogu, schématu a tabulky použitou při vytváření tabulek OpenTelemetry.

Poznámka:

Výchozí OTEL_METRIC_EXPORT_INTERVAL hodnota je 6 0000 ms (60 sekund). Výše uvedený příklad ho nastaví na 1 0000 ms (10 sekund). Výchozí OTEL_LOGS_EXPORT_INTERVAL hodnota je 5000 ms (5 sekund).

Krok 3: Spuštění Kódu Clauda

claude

Vaše data by se měla rozšířit do tabulek katalogu Unity do 5 minut.