GlusterFS na virtuálních počítačích Azure s Red Hat Enterprise Linuxem pro SAP NetWeaver

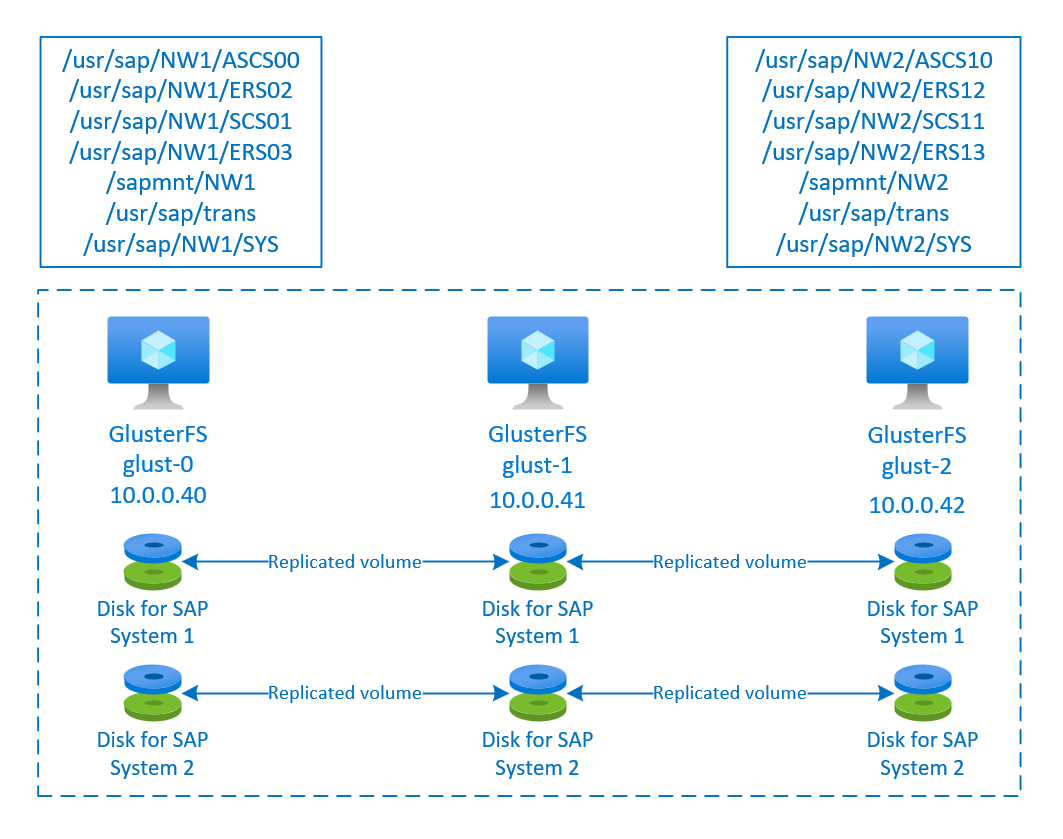

Tento článek popisuje, jak nasadit virtuální počítače, nakonfigurovat virtuální počítače a nainstalovat cluster GlusterFS, který lze použít k ukládání sdílených dat systému SAP s vysokou dostupností. Tato příručka popisuje, jak nastavit GlusterFS, které používají dva systémy SAP, NW1 a NW2. Názvy prostředků (například virtuálních počítačů, virtuálních sítí) v příkladu předpokládají, že jste použili šablonu souborového serveru SAP s předponou prostředku.

Mějte na paměti, že jak je uvedeno v úložišti Red Hat Gluster Storage Life Cycle Red Hat Gluster Storage, dosáhne konce životnosti na konci roku 2024. Konfigurace bude podporována pro SAP v Azure, dokud nedosáhne konce životnosti. GlusterFS by se nemělo používat pro nová nasazení. Doporučujeme nasadit sdílené adresáře SAP v systému souborů NFS na svazcích Azure Files nebo Azure NetApp Files, jak je uvedeno v ha pro SAP NW na RHEL s NFS ve službě Soubory Azure nebo HA pro SAP NW v RHEL s Azure NetApp Files.

Nejprve si přečtěte následující poznámky a dokumenty SAP.

SAP Note 1928533, který má:

- Seznam velikostí virtuálních počítačů Azure podporovaných pro nasazení softwaru SAP

- Důležité informace o kapacitě pro velikosti virtuálních počítačů Azure

- Podporované kombinace softwaru SAP a operačního systému (OS) a databází

- Požadovaná verze jádra SAP pro Windows a Linux v Microsoft Azure

SAP Note 2015553 uvádí požadavky pro nasazení softwaru SAP s podporou SAP v Azure.

SAP Note 2002167 doporučuje nastavení operačního systému pro Red Hat Enterprise Linux.

SAP Note 2009879 obsahuje pokyny PRO SAP HANA pro Red Hat Enterprise Linux

SAP Note 2178632 obsahuje podrobné informace o všech metrikách monitorování hlášených pro SAP v Azure.

SAP Note 2191498 má požadovanou verzi agenta hostitele SAP pro Linux v Azure.

SAP Note 2243692 obsahuje informace o licencování SAP v Linuxu v Azure.

SAP Note 1999351 obsahuje další informace o řešení potíží pro rozšíření rozšířeného monitorování Azure pro SAP.

Wikiweb komunity SAP obsahuje všechny požadované poznámky SAP pro Linux.

Plánování a implementace virtuálních počítačů Azure pro SAP v Linuxu

Nasazení služby Azure Virtual Machines pro SAP v Linuxu (tento článek)

Obecná dokumentace k RHEL

Dokumentace ke službě Azure Specific RHEL:

Přehled

K dosažení vysoké dostupnosti vyžaduje SAP NetWeaver sdílené úložiště. GlusterFS je nakonfigurovaný v samostatném clusteru a může ho používat několik systémů SAP.

Nastavení glusterFS

V tomto příkladu byly prostředky nasazeny ručně prostřednictvím webu Azure Portal.

Ruční nasazení Linuxu přes Azure Portal

Tento dokument předpokládá, že jste už nasadili skupinu prostředků, virtuální síť Azure a podsíť.

Nasaďte virtuální počítače pro GlusterFS. Zvolte vhodný obrázek RHEL, který je podporován pro úložiště Gluster. Virtuální počítač můžete nasadit v libovolné z možností dostupnosti – škálovací sada, zóna dostupnosti nebo skupina dostupnosti.

Konfigurace glusterFS

Následující položky mají předponu [A] – platí pro všechny uzly, [1] – platí pouze pro uzel 1, [2] – platí pouze pro uzel 2, [3] – platí pouze pro uzel 3.

[A] Nastavení překladu názvů hostitelů

Můžete použít server DNS nebo upravit /etc/hosts na všech uzlech. Tento příklad ukazuje, jak používat soubor /etc/hosts. Nahraďte IP adresu a název hostitele v následujících příkazech.

sudo vi /etc/hostsDo /etc/hosts vložte následující řádky. Změňte IP adresu a název hostitele tak, aby odpovídaly vašemu prostředí.

# IP addresses of the Gluster nodes 10.0.0.40 glust-0 10.0.0.41 glust-1 10.0.0.42 glust-2[A] Zaregistrovat

Zaregistrujte virtuální počítače a připojte ho k fondu, který obsahuje úložiště pro RHEL 7 a GlusterFS.

sudo subscription-manager register sudo subscription-manager attach --pool=<pool id>[A] Povolení úložišť GlusterFS

Pokud chcete nainstalovat požadované balíčky, povolte následující úložiště.

sudo subscription-manager repos --disable "*" sudo subscription-manager repos --enable=rhel-7-server-rpms sudo subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpms[A] Instalace balíčků GlusterFS

Nainstalujte tyto balíčky na všechny uzly GlusterFS.

sudo yum -y install redhat-storage-serverPo instalaci restartujte uzly.

[A] Úprava brány firewall

Přidejte pravidla brány firewall, která povolí klientský provoz do uzlů GlusterFS.

# list the available zones firewall-cmd --get-active-zones sudo firewall-cmd --zone=public --add-service=glusterfs --permanent sudo firewall-cmd --zone=public --add-service=glusterfs[A] Povolení a spuštění služby GlusterFS

Spusťte službu GlusterFS na všech uzlech.

sudo systemctl start glusterd sudo systemctl enable glusterd[1] Vytvoření gluserFS

Spuštěním následujících příkazů vytvořte cluster GlusterFS.

sudo gluster peer probe glust-1 sudo gluster peer probe glust-2 # Check gluster peer status sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Accepted peer request (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Accepted peer request (Connected)[2] Stav testovacího partnerského vztahu

Otestování stavu partnerského uzlu na druhém uzlu

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Peer in Cluster (Connected)[3] Stav testovacího partnerského vztahu

Otestování stavu partnerského uzlu na třetím uzlu

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Peer in Cluster (Connected)[A] Vytvoření LVM

V tomto příkladu se glusterFS používá pro dva systémy SAP, NW1 a NW2. K vytvoření konfigurací LVM pro tyto systémy SAP použijte následující příkazy.

Použití těchto příkazů pro NW1

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun0 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW1 /dev/disk/azure/scsi1/lun0 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW1/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW1/trans sudo lvcreate -l 10%FREE -n rhgs-NW1/sys sudo lvcreate -l 50%FREE -n rhgs-NW1/ascs sudo lvcreate -l 100%FREE -n rhgs-NW1/aers sudo lvscan sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/aers sudo mkdir -p /rhs/NW1/sapmnt sudo mkdir -p /rhs/NW1/trans sudo mkdir -p /rhs/NW1/sys sudo mkdir -p /rhs/NW1/ascs sudo mkdir -p /rhs/NW1/aers sudo chattr +i /rhs/NW1/sapmnt sudo chattr +i /rhs/NW1/trans sudo chattr +i /rhs/NW1/sys sudo chattr +i /rhs/NW1/ascs sudo chattr +i /rhs/NW1/aers echo -e "/dev/rhgs-NW1/sapmnt\t/rhs/NW1/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/trans\t/rhs/NW1/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/sys\t/rhs/NW1/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/ascs\t/rhs/NW1/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/aers\t/rhs/NW1/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -aPoužití těchto příkazů pro NW2

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun1 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW2 /dev/disk/azure/scsi1/lun1 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW2/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW2/trans sudo lvcreate -l 10%FREE -n rhgs-NW2/sys sudo lvcreate -l 50%FREE -n rhgs-NW2/ascs sudo lvcreate -l 100%FREE -n rhgs-NW2/aers sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/aers sudo mkdir -p /rhs/NW2/sapmnt sudo mkdir -p /rhs/NW2/trans sudo mkdir -p /rhs/NW2/sys sudo mkdir -p /rhs/NW2/ascs sudo mkdir -p /rhs/NW2/aers sudo chattr +i /rhs/NW2/sapmnt sudo chattr +i /rhs/NW2/trans sudo chattr +i /rhs/NW2/sys sudo chattr +i /rhs/NW2/ascs sudo chattr +i /rhs/NW2/aers sudo lvscan echo -e "/dev/rhgs-NW2/sapmnt\t/rhs/NW2/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/trans\t/rhs/NW2/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/sys\t/rhs/NW2/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/ascs\t/rhs/NW2/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/aers\t/rhs/NW2/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -a[1] Vytvoření distribuovaného svazku

Pomocí následujících příkazů vytvořte svazek GlusterFS pro NW1 a spusťte ho.

sudo gluster vol create NW1-sapmnt replica 3 glust-0:/rhs/NW1/sapmnt glust-1:/rhs/NW1/sapmnt glust-2:/rhs/NW1/sapmnt force sudo gluster vol create NW1-trans replica 3 glust-0:/rhs/NW1/trans glust-1:/rhs/NW1/trans glust-2:/rhs/NW1/trans force sudo gluster vol create NW1-sys replica 3 glust-0:/rhs/NW1/sys glust-1:/rhs/NW1/sys glust-2:/rhs/NW1/sys force sudo gluster vol create NW1-ascs replica 3 glust-0:/rhs/NW1/ascs glust-1:/rhs/NW1/ascs glust-2:/rhs/NW1/ascs force sudo gluster vol create NW1-aers replica 3 glust-0:/rhs/NW1/aers glust-1:/rhs/NW1/aers glust-2:/rhs/NW1/aers force sudo gluster volume start NW1-sapmnt sudo gluster volume start NW1-trans sudo gluster volume start NW1-sys sudo gluster volume start NW1-ascs sudo gluster volume start NW1-aersPomocí následujících příkazů vytvořte svazek GlusterFS pro NW2 a spusťte ho.

sudo gluster vol create NW2-sapmnt replica 3 glust-0:/rhs/NW2/sapmnt glust-1:/rhs/NW2/sapmnt glust-2:/rhs/NW2/sapmnt force sudo gluster vol create NW2-trans replica 3 glust-0:/rhs/NW2/trans glust-1:/rhs/NW2/trans glust-2:/rhs/NW2/trans force sudo gluster vol create NW2-sys replica 3 glust-0:/rhs/NW2/sys glust-1:/rhs/NW2/sys glust-2:/rhs/NW2/sys force sudo gluster vol create NW2-ascs replica 3 glust-0:/rhs/NW2/ascs glust-1:/rhs/NW2/ascs glust-2:/rhs/NW2/ascs force sudo gluster vol create NW2-aers replica 3 glust-0:/rhs/NW2/aers glust-1:/rhs/NW2/aers glust-2:/rhs/NW2/aers force sudo gluster volume start NW2-sapmnt sudo gluster volume start NW2-trans sudo gluster volume start NW2-sys sudo gluster volume start NW2-ascs sudo gluster volume start NW2-aers

Další kroky

- Instalace SAP ASCS a databáze

- Plánování a implementace virtuálních počítačů Azure pro SAP

- Nasazení virtuálních počítačů Azure pro SAP

- Nasazení DBMS pro Azure Virtual Machines pro SAP

- Informace o vytvoření vysoké dostupnosti a plánování zotavení po havárii SAP HANA v Azure (velké instance) najdete v tématu Vysoká dostupnost a zotavení po havárii SAP HANA v Azure.

- Informace o vytvoření vysoké dostupnosti a plánování zotavení po havárii SAP HANA na virtuálních počítačích Azure najdete v tématu Vysoká dostupnost SAP HANA na virtuálních počítačích Azure.