Vytváření a správa definic úloh Apache Sparku v editoru Visual Studio Code

Rozšíření Editoru Visual Studio (VS) Code pro Synapse plně podporuje operace definice úlohy Sparku v prostředcích infrastruktury (vytvoření, aktualizace, čtení a odstranění). Po vytvoření definice úlohy Sparku můžete nahrát další odkazované knihovny, odeslat žádost o spuštění definice úlohy Sparku a zkontrolovat historii spuštění.

Vytvoření definice úlohy Sparku

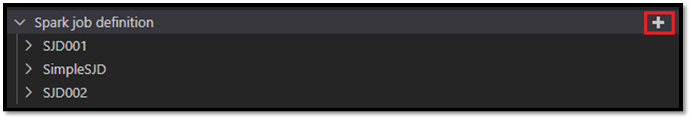

Vytvoření nové definice úlohy Sparku:

V Průzkumníku VS Code vyberte možnost Vytvořit definici úlohy Sparku.

Zadejte počáteční povinná pole: název, odkazovaný na jezero a výchozí jezero.

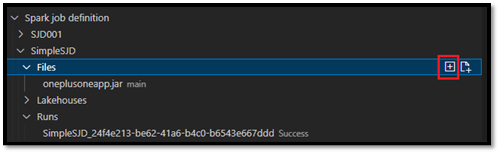

Požadavek zpracuje a název nově vytvořené definice úlohy Sparku se zobrazí v kořenovém uzlu Definice úlohy Sparku v Průzkumníku VS Code. Pod uzlem názvu definice úlohy Sparku se zobrazí tři pod uzly:

- Soubory: Seznam hlavního definičního souboru a dalších odkazovaných knihoven. Z tohoto seznamu můžete nahrát nové soubory.

- Lakehouse: Seznam všech objektů lakehouse, na které odkazuje tato definice úlohy Sparku. Výchozí jezero je označené v seznamu a můžete k němu přistupovat přes relativní cestu

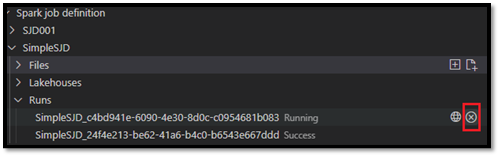

Files/…, Tables/…. - Spuštění: Seznam historie spuštění této definice úlohy Spark a stav úlohy každého spuštění.

Nahrání hlavního definičního souboru do odkazované knihovny

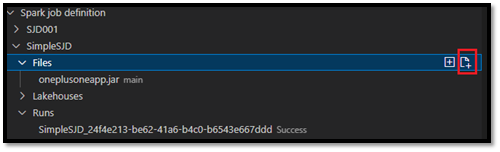

Pokud chcete nahrát nebo přepsat hlavní definiční soubor, vyberte možnost Přidat hlavní soubor .

Pokud chcete nahrát soubor knihovny, na který odkazuje hlavní definiční soubor, vyberte možnost Přidat soubor knihovny.

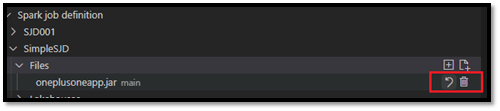

Po nahrání souboru ho můžete přepsat kliknutím na možnost Aktualizovat soubor a nahráním nového souboru nebo můžete soubor odstranit pomocí možnosti Odstranit .

Odeslání žádosti o spuštění

Odeslání žádosti o spuštění definice úlohy Sparku z editoru VS Code:

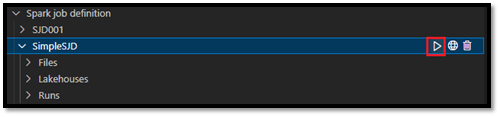

V možnostech napravo od názvu definice úlohy Spark, kterou chcete spustit, vyberte možnost Spustit úlohu Sparku.

Po odeslání žádosti se v uzlu Spuštění v seznamu Průzkumníků zobrazí nová aplikace Apache Spark. Spuštěnou úlohu můžete zrušit výběrem možnosti Zrušit úlohu Sparku.

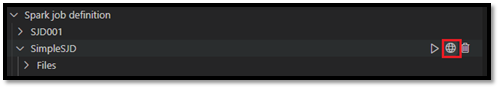

Otevření definice úlohy Spark na portálu Fabric

Stránku pro vytváření definic úloh Sparku můžete otevřít na portálu Fabric výběrem možnosti Otevřít v prohlížeči .

Můžete také vybrat Možnost Otevřít v prohlížeči vedle dokončeného spuštění a zobrazit stránku monitorování podrobností daného spuštění.

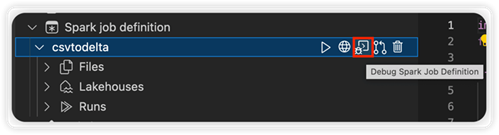

Ladění zdrojového kódu definice úlohy Sparku (Python)

Pokud je definice úlohy Sparku vytvořená pomocí PySpark (Python), můžete stáhnout .py skript hlavního definičního souboru a odkazovaného souboru a ladit zdrojový skript ve VS Code.

Pokud chcete stáhnout zdrojový kód, vyberte možnost Ladit definici úlohy Sparku napravo od definice úlohy Sparku.

Po dokončení stahování se složka zdrojového kódu automaticky otevře.

Po zobrazení výzvy vyberte možnost Důvěřovat autorům. (Tato možnost se zobrazí jenom při prvním otevření složky. Pokud tuto možnost nevyberete, nemůžete ladit ani spustit zdrojový skript. Další informace najdete v tématu Zabezpečení důvěryhodnosti pracovního prostoru editoru Visual Studio Code.)

Pokud jste si zdrojový kód stáhli dříve, zobrazí se výzva k potvrzení, že chcete přepsat místní verzi novým stažením.

Poznámka:

V kořenové složce zdrojového skriptu systém vytvoří podsložku s názvem conf. V této složce soubor s názvem lighter-config.json obsahuje některá systémová metadata potřebná ke vzdálenému spuštění. Neprovádejte v něm žádné změny.

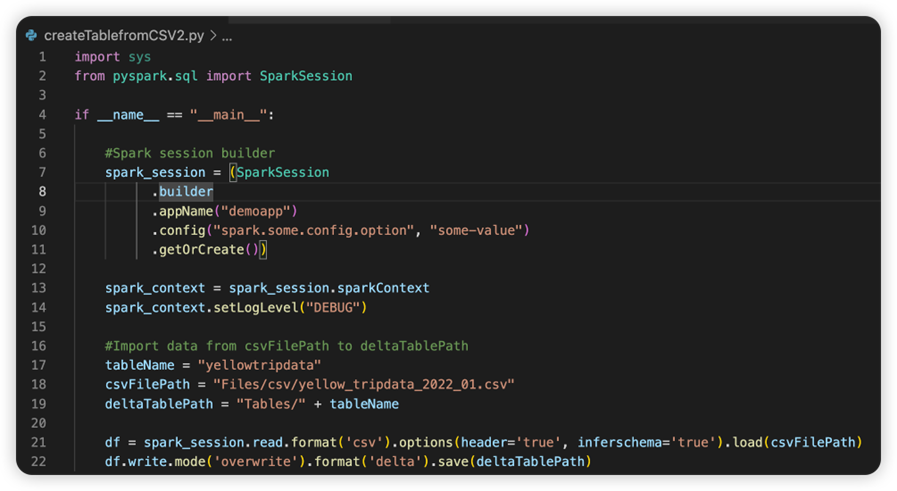

Soubor s názvem sparkconf.py obsahuje fragment kódu, který je potřeba přidat k nastavení objektu SparkConf . Pokud chcete povolit vzdálené ladění, ujistěte se, že je objekt SparkConf správně nastavený. Následující obrázek ukazuje původní verzi zdrojového kódu.

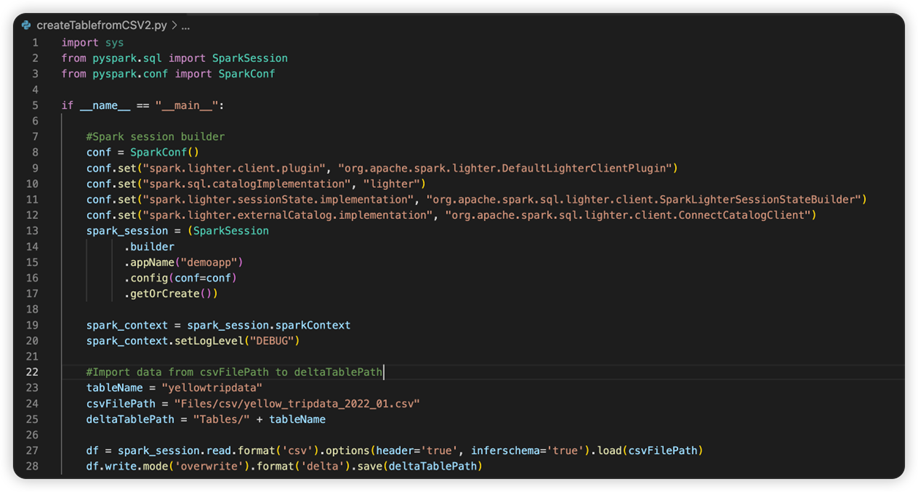

Další obrázek je aktualizovaný zdrojový kód po zkopírování a vložení fragmentu.

Po aktualizaci zdrojového kódu potřebným kódem musíte vybrat správný interpret Pythonu. Ujistěte se, že jste ho vybrali z prostředí Synapse-spark-kernel conda.

Úprava vlastností definice úlohy Sparku

Můžete upravit vlastnosti podrobností definic úloh Sparku, například argumenty příkazového řádku.

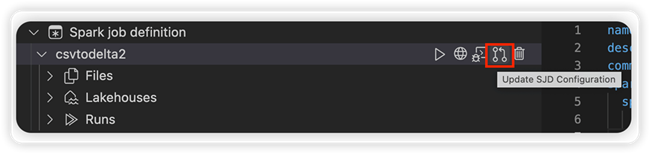

Výběrem možnosti Aktualizovat konfiguraci SJD otevřete soubor settings.yml. Existující vlastnosti naplní obsah tohoto souboru.

Aktualizujte a uložte soubor .yml.

Výběrem možnosti Publikovat vlastnost SJD v pravém horním rohu synchronizujte změnu zpět do vzdáleného pracovního prostoru.

Související obsah

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro