Čtení a zápis dat pomocí Pandas v Microsoft Fabric

Poznámkové bloky Microsoft Fabric podporují bezproblémovou interakci s daty Lakehouse pomocí Pandas, nejoblíbenější knihovny Pythonu pro zkoumání a zpracování dat. V poznámkovém bloku můžete rychle číst data z prostředků Lakehouse a zapisovat je zpět do různých formátů souborů. Tato příručka obsahuje ukázky kódu, které vám pomůžou začít pracovat ve vlastním poznámkovém bloku.

Požadavky

Získejte předplatné Microsoft Fabric. Nebo si zaregistrujte bezplatnou zkušební verzi Microsoft Fabricu.

Přihlaste se k Microsoft Fabric.

Pomocí přepínače prostředí na levé straně domovské stránky přepněte na prostředí Synapse Datová Věda.

Načtení dat Lakehouse do poznámkového bloku

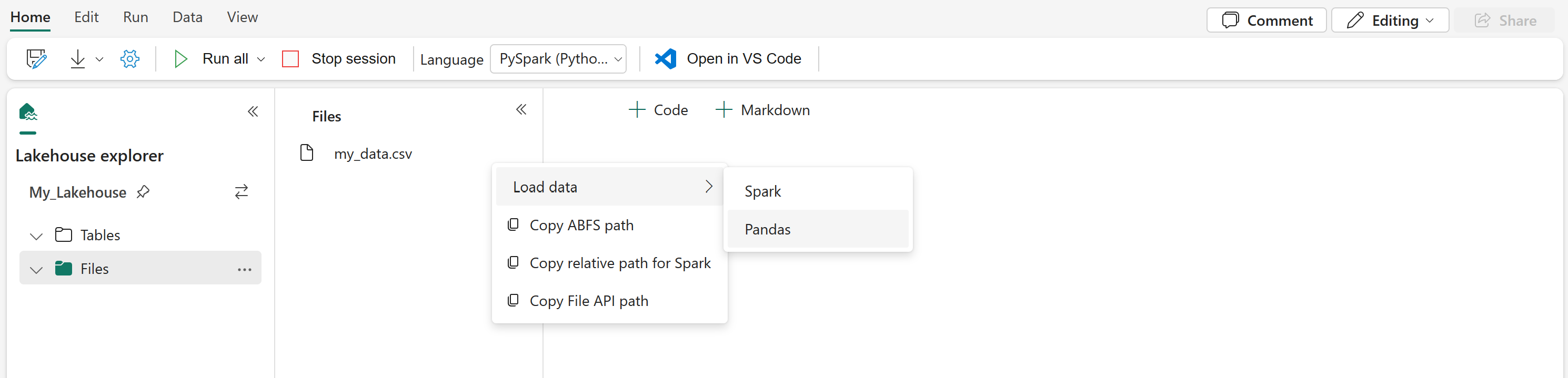

Po připojení lakehouse k poznámkovému bloku Microsoft Fabric můžete zkoumat uložená data bez opuštění stránky a číst je do poznámkového bloku, a to vše pomocí několika kroků. Výběr libovolného souboru Lakehouse zobrazí možnosti načtení dat do sparku nebo datového rámce Pandas. Můžete také zkopírovat úplnou cestu ABFS souboru nebo popisnou relativní cestu.

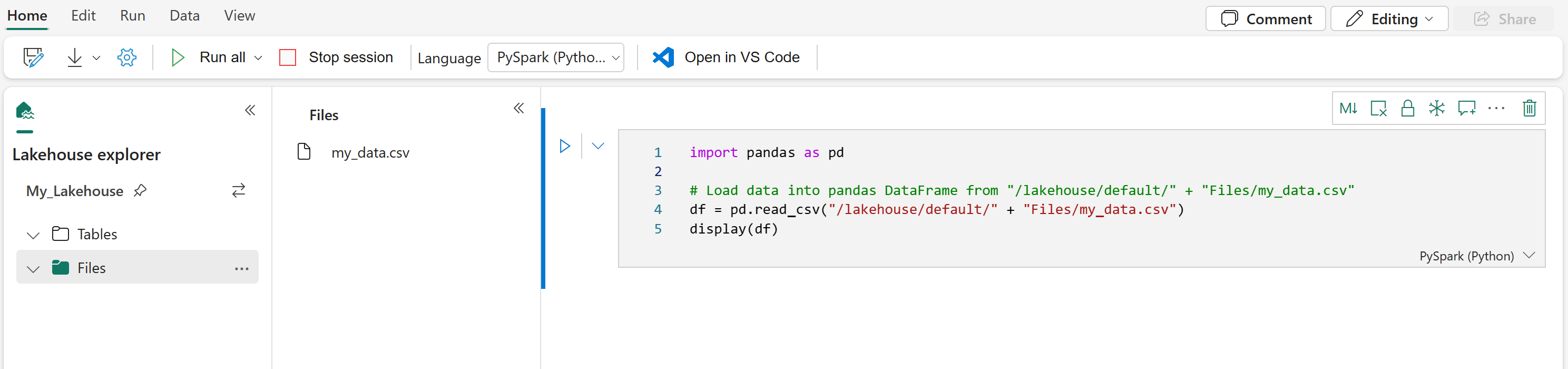

Výběr jedné z výzev "Načíst data" vygeneruje buňku kódu, která tento soubor načte do datového rámce v poznámkovém bloku.

Převod datového rámce Sparku na datový rámec Pandas

Tento příkaz ukazuje, jak převést datový rámec Sparku na datový rámec Pandas:

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

Čtení a zápis různých formátů souborů

Tyto ukázky kódu popisují operace Pandas pro čtení a zápis různých formátů souborů.

Poznámka:

V těchto ukázkách kódu je nutné nahradit cesty k souborům. Pandas podporuje jak relativní cesty, tak i úplné cesty ABFS. Cesty některého typu lze načíst a zkopírovat z rozhraní podle předchozího kroku.

Čtení dat ze souboru CSV

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

Zápis dat jako souboru CSV

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Čtení dat ze souboru Parquet

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

Zápis dat jako souboru Parquet

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Čtení dat z excelového souboru

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Zápis dat jako excelového souboru

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

Čtení dat ze souboru JSON

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

Zápis dat jako souboru JSON

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

Související obsah

- Vyčištění a příprava dat pomocí služby Data Wrangler

- Zahájení trénování modelů ML

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro