Poznámka

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

platí pro:SQL Server

SSIS Integration Runtime ve službě Azure Data Factory

Sql Server Integration Services (SSIS) Feature Pack pro Azure je rozšíření, které poskytuje komponenty uvedené na této stránce pro připojení ke službám Azure, přenos dat mezi Azure a místními zdroji dat a zpracování dat uložených v Azure.

- Pro SQL Server 2022 – Balíček funkčních rozšíření Microsoft SQL Server 2022 Integration Services pro Azure

- Pro SQL Server 2019 – Microsoft SQL Server 2019 Integration Services Feature Pack pro Azure

- Pro SQL Server 2017 – Balíček funkcí Microsoft SQL Server 2017 Integration Services pro Azure

- Pro SQL Server 2016 – Microsoft SQL Server 2016 Integration Services balíček funkcí pro Azure

- Pro SQL Server 2014 – Microsoft SQL Server 2014 Integration Services Feature Pack pro Azure

- Pro SQL Server 2012 – Microsoft SQL Server 2012 Integration Services Feature Pack pro Azure

Stránky pro stahování obsahují také informace o požadavcích. Před instalací sady Azure Feature Pack na server se ujistěte, že jste nainstalovali SQL Server, nebo součásti v sadě Feature Pack nemusí být při nasazování balíčků do databáze katalogu služby SSIS na serveru SSISDB k dispozici.

Komponenty v sadě Feature Pack

Správci připojení

Úkoly

Komponenty datového toku

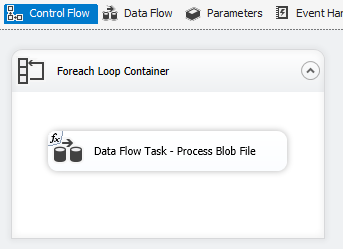

Výčty souborů pro Azure Blob, Azure Data Lake Store a Data Lake Storage Gen2. Viz Kontejner smyčky typu Foreach

Použití protokolu TLS 1.2

Verze PROTOKOLU TLS používaná sadou Azure Feature Pack se řídí systémovým nastavením rozhraní .NET Framework.

Pokud chcete použít protokol TLS 1.2, přidejte REG_DWORD hodnotu s názvem SchUseStrongCrypto s daty 1 pod následujícími dvěma klíči registru.

HKEY_LOCAL_MACHINE\SOFTWARE\WOW6432Node\Microsoft\.NETFramework\v4.0.30319HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\.NETFramework\v4.0.30319

Závislost na Javě

K používání formátů souborů ORC/Parquet s konektory pro Azure Data Lake Store/Flexible File je vyžadována Java.

Architektura (32bitová/64bitová verze) sestavení Java by měla odpovídat architektuře modulu runtime SSIS, který se má použít.

Otestovali jsme následující buildy Java.

Nastavení sady OpenJDK od Zulu

- Stáhněte a extrahujte instalační balíček ZIP.

- Z příkazového řádku spusťte

sysdm.cplpříkaz . - Na kartě Upřesnit vyberte Proměnné prostředí.

- V části Systémové proměnné vyberte Nový.

- Zadejte

JAVA_HOMEpro název proměnné. - Vyberte Procházet adresář, přejděte do extrahované složky a vyberte

jrepodsložku. Pak vyberte OK a hodnota Proměnné se vyplní automaticky. - Výběrem možnosti OK zavřete dialogové okno Nová systémová proměnná .

- Výběrem možnosti OK zavřete dialogové okno Proměnné prostředí .

- Kliknutím na tlačítko OK zavřete dialogové okno Vlastnosti systému .

Návod

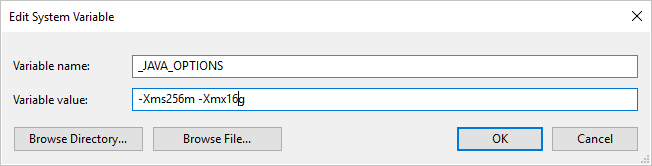

Pokud používáte formát Parquet a zobrazí se chyba s textem "Při vyvolání Java došlo k chybě, zpráva: java.lang.OutOfMemoryError: Java heap space", můžete přidat proměnnou prostředí _JAVA_OPTIONS, která upraví minimální/maximální velikost haldy pro JVM.

Příklad: nastavte proměnnou _JAVA_OPTIONS s hodnotou -Xms256m -Xmx16g. Příznak Xms určuje počáteční fond přidělení paměti pro virtuální počítač Java (JVM), zatímco Xmx určuje maximální fond přidělení paměti. To znamená, že prostředí JVM se spustí s Xms množstvím paměti a bude moct používat maximální Xmx velikost paměti. Výchozí hodnoty jsou minimální 64 MB a maximální 1G.

Nastavení openJDK Zulu v prostředí Azure-SSIS Integration Runtime

To by se mělo provést prostřednictvím rozhraní vlastní instalace pro Azure-SSIS Integration Runtime.

Předpokládejme, že zulu8.33.0.1-jdk8.0.192-win_x64.zip se používá.

Kontejner blob je možné uspořádat následujícím způsobem.

main.cmd

install_openjdk.ps1

zulu8.33.0.1-jdk8.0.192-win_x64.zip

Jako vstupní bod main.cmd aktivuje spuštění skriptu install_openjdk.ps1 PowerShellu, který následně extrahuje zulu8.33.0.1-jdk8.0.192-win_x64.zip a nastaví JAVA_HOME odpovídajícím způsobem.

main.cmd

powershell.exe -file install_openjdk.ps1

Návod

Pokud používáte formát Parquet a zobrazí se chyba s oznámením "K chybě došlo při spuštění java, zpráva: java.lang.OutOfMemoryError: java heap space", můžete přidat příkaz v main.cmd pro úpravu minimální/maximální velikosti haldy pro JVM. Příklad:

setx /M _JAVA_OPTIONS "-Xms256m -Xmx16g"

Příznak Xms určuje počáteční fond přidělení paměti pro virtuální počítač Java (JVM), zatímco Xmx určuje maximální fond přidělení paměti. To znamená, že prostředí JVM se spustí s Xms množstvím paměti a bude moct používat maximální Xmx velikost paměti. Výchozí hodnoty jsou minimální 64 MB a maximální 1G.

install_openjdk.ps1

Expand-Archive zulu8.33.0.1-jdk8.0.192-win_x64.zip -DestinationPath C:\

[Environment]::SetEnvironmentVariable("JAVA_HOME", "C:\zulu8.33.0.1-jdk8.0.192-win_x64\jre", "Machine")

Nastavení prostředí Java SE Runtime pro Oracle

- Stáhněte a spusťte instalační program exe.

- Dokončete instalaci podle pokynů instalačního programu.

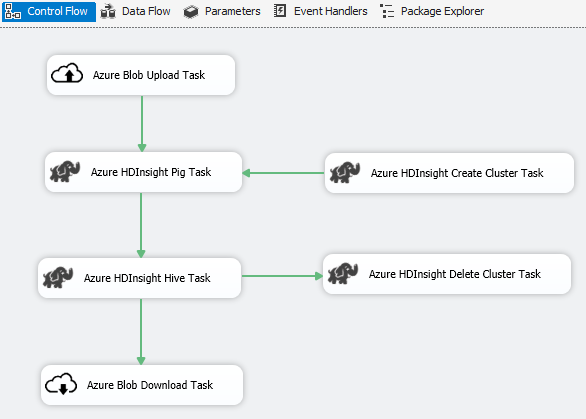

Scénář: Zpracování velkých objemů dat

Pomocí konektoru Azure proveďte následující práci se zpracováním velkých objemů dat:

Pomocí úlohy nahrání objektů blob v Azure nahrajte vstupní data do služby Azure Blob Storage.

K vytvoření clusteru Azure HDInsight použijte úlohu vytvoření clusteru Azure HDInsight. Tento krok je volitelný, pokud chcete použít vlastní cluster.

Pomocí úkolu Azure HDInsight Hive nebo Azure HDInsight Pig můžete spustit úlohu Pig nebo Hive v clusteru Azure HDInsight.

Pomocí úlohy odstranění clusteru Azure HDInsight odstraňte cluster HDInsight po použití, pokud jste v kroku 2 vytvořili cluster HDInsight na vyžádání.

Použijte úlohu stahování blobů Azure HDInsight ke stažení výstupních dat Pig/Hive ze služby Azure Blob Storage.

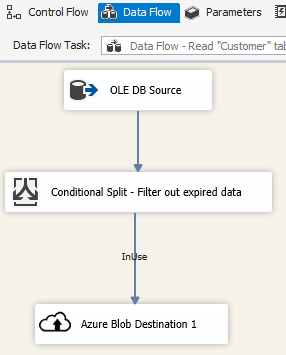

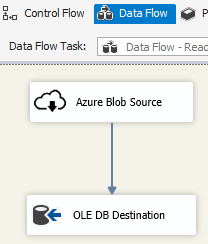

Scénář: Správa dat v cloudu

Pomocí cíle objektů blob Azure v balíčku SSIS můžete zapisovat výstupní data do služby Azure Blob Storage nebo pomocí zdroje objektů blob v Azure číst data ze služby Azure Blob Storage.

Ke zpracování dat v několika souborech objektů blob použijte kontejner smyčky Foreach s enumerátorem objektů blob Azure.

Poznámky k vydání

Verze 1.21.0

Vylepšení

- Upgradovali jsme log4j z verze 1.2.17 na 2.17.1.

Verze 1.20.0

Vylepšení

- Aktualizace cílové verze rozhraní .NET Framework z verze 4.6 na 4.7.2

- Přejmenovali jsme "Azure SQL DW Upload Task" na "Azure Synapse Analytics Task".

Opravy chyb

- Při přístupu ke službě Azure Blob Storage a počítači, na kterém běží SSIS, je v jiném než en-US místním nastavení, spuštění balíčku selže s chybovou zprávou "Řetězec není rozpoznán jako platná hodnota DateTime."

- Pro Správce připojení ke službě Azure Storage se vyžaduje tajný klíč (a nepoužívá se) i v případě, že se k ověření používá spravovaná identita služby Data Factory.

Verze 1.19.0

Vylepšení

- Přidání podpory ověřování pomocí sdíleného přístupového podpisu do Správce připojení služby Azure Storage

Verze 1.18.0

Vylepšení

- Pro úlohu Flexibilní soubor jsou tři vylepšení: (1) podpora zástupných znaků pro operace kopírování/odstranění je přidána; (2) uživatel může povolit nebo zakázat rekurzivní vyhledávání operace odstranění; a (3) název souboru cílové operace kopírování může být prázdný, aby se zachoval název zdrojového souboru.

Verze 1.17.0

Toto je verze opravy hotfix vydaná pouze pro SQL Server 2019.

Opravy chyb

- Při spouštění v sadě Visual Studio 2019 a cílení na SQL Server 2019 může Flexibilní úloha souboru/Zdroje/Cíle selhat s chybovou zprávou

Attempted to access an element as a type incompatible with the array.. - Při spouštění v sadě Visual Studio 2019 a cílení na SQL Server 2019 může flexibilní zdroj souborů nebo cíl pomocí formátu ORC/Parquet selhat s chybovou zprávou

Microsoft.DataTransfer.Common.Shared.HybridDeliveryException: An unknown error occurred. JNI.JavaExceptionCheckException.

Verze 1.16.0

Opravy chyb

- V některých případech výstupy spuštění balíčku hlásí "Chyba: Nelze načíst soubor nebo sestavení 'Newtonsoft.Json, Version=11.0.0.0, Culture=neutral, PublicKeyToken=30ad4fe6b2a6aeed' nebo jednu z jeho závislostí."

Verze 1.15.0

Vylepšení

- Přidejte operaci odstranění složky nebo souboru do flexibilní úlohy souboru

- Přidání funkce převodu externího/výstupního datového typu ve zdroji flexibilního souboru

Opravy chyb

- V některých případech nefunguje testovací připojení pro Data Lake Storage Gen2 s chybovou zprávou "Pokusili jste se o přístup k prvku jako typu nekompatibilní s polem"

- Obnovení podpory emulátoru služby Azure Storage