Slutscenarie for Lakehouse: oversigt og arkitektur

Microsoft Fabric er en alt i en-analyseløsning til virksomheder, der dækker alt fra dataflytning til datavidenskab, analyse i realtid og business intelligence. Det tilbyder en omfattende pakke af tjenester, herunder data lake, data engineering og dataintegration, alt sammen på ét sted. Du kan få flere oplysninger under Hvad er Microsoft Fabric?

I dette selvstudium gennemgås et scenarie fra ende til anden fra dataanskaffelse til dataforbrug. Det hjælper dig med at opbygge en grundlæggende forståelse af Fabric, herunder de forskellige oplevelser, og hvordan de integreres, samt de professionelle og borgerudviklende oplevelser, der følger med arbejdet på denne platform. Dette selvstudium er ikke beregnet til at være en referencearkitektur, en udtømmende liste over funktioner og funktionalitet eller en anbefaling af specifikke bedste fremgangsmåder.

Lakehouse-scenarie fra ende til anden

Organisationer har traditionelt bygget moderne data warehouses til deres transaktions- og strukturerede dataanalysebehov. Og data lakehouses til big data (halv/ustruktureret) dataanalysebehov. Disse to systemer kørte parallelt, hvilket skabte siloer, duplikering af data og øgede samlede ejeromkostninger.

Fabric med sin samling af datalager og standardisering på Delta Lake-formatet giver dig mulighed for at eliminere siloer, fjerne duplikering af data og drastisk reducere de samlede ejeromkostninger.

Med den fleksibilitet, der tilbydes af Fabric, kan du implementere enten lakehouse- eller data warehouse-arkitekturer eller kombinere dem sammen for at få det bedste ud af begge dele med enkel implementering. I dette selvstudium skal du tage et eksempel på en detailhandelsorganisation og bygge dens lakehouse fra start til slut. Den bruger medaljonsarkitekturen , hvor bronzelaget har rådata, sølvlaget har de validerede og deduplikerede data, og guldlaget har meget raffinerede data. Du kan bruge den samme fremgangsmåde til at implementere et lakehouse for enhver organisation fra en hvilken som helst branche.

I dette selvstudium forklares det, hvordan en udvikler hos den fiktive virksomhed Wide World Importers fra detaildomænet fuldfører følgende trin:

Log på din Power BI-konto, og tilmeld dig den gratis prøveversion af Microsoft Fabric. Hvis du ikke har en Power BI-licens, tilmelde dig en gratis Fabric-licens og derefter kan du starte Fabric-prøveversionen.

Byg og implementer et end-to-end-lakehouse for din organisation:

- Opret et Fabric-arbejdsområde.

- Opret et lakehouse.

- Indfødning af data, transformér data, og indlæs dem i lakehouse. Du kan også udforske OneLake, én kopi af dine data på tværs af lakehouse-tilstand og SQL Analytics-slutpunktstilstand.

- Opret forbindelse til dit lakehouse ved hjælp af SQL Analytics-slutpunktet, og opret en Power BI-rapport ved hjælp af DirectLake til at analysere salgsdata på tværs af forskellige dimensioner.

- Du kan eventuelt organisere og planlægge dataindtagelses- og transformationsflow med en pipeline.

Ryd op i ressourcer ved at slette arbejdsområdet og andre elementer.

Arkitektur

På følgende billede vises lakehouse-arkitekturen fra ende til anden. De involverede komponenter er beskrevet på følgende liste.

Datakilder: Fabric gør det hurtigt og nemt at oprette forbindelse til Azure Data Services samt andre cloudbaserede platforme og datakilder i det lokale miljø til strømlinet dataindtagelse.

Indtagelse: Du kan hurtigt oprette indsigt til din organisation ved hjælp af mere end 200 oprindelige connectors. Disse connectors er integreret i Fabric-pipelinen og bruger den brugervenlige træk og slip-datatransformation med dataflow. Med genvejsfunktionen i Fabric kan du desuden oprette forbindelse til eksisterende data uden at skulle kopiere eller flytte dem.

Transformér og gem: Fabric standardiserer delta lake-formatet. Det betyder, at alle Fabric-programmerne kan få adgang til og manipulere det samme datasæt, der er gemt i OneLake, uden at duplikere data. Dette lagersystem giver fleksibiliteten til at bygge lakehouses ved hjælp af en medaljonsarkitektur eller et datanet, afhængigt af dit organisatoriske krav. Du kan vælge mellem en oplevelse med lav kode eller ingen kode i forbindelse med datatransformation ved hjælp af enten pipelines/dataflow eller notesbog/Spark for at få en kode første oplevelse.

Forbrug: Power BI kan bruge data fra Lakehouse til rapportering og visualisering. Hver Lakehouse har et indbygget TDS-slutpunkt, der kaldes SQL Analytics-slutpunktet , så det er nemt at oprette forbindelse til og forespørge om data i Lakehouse-tabellerne fra andre rapporteringsværktøjer. SQL Analytics-slutpunktet giver brugerne SQL-forbindelsesfunktionaliteten.

Eksempeldatasæt

I dette selvstudium bruges eksempeldatabasen Wide World Importers (WWI), som du importerer til lakehouse i det næste selvstudium. I forbindelse med lakehouse-scenariet har vi genereret tilstrækkelige data til at udforske skalerings- og ydeevnefunktionerne på Fabric-platformen.

Wide World Importers (WWI) er en engros nyhedsvareimportør og -distributør, der opererer fra San Francisco Bay-området. Som grossist inkluderer WWI's kunder hovedsageligt virksomheder, der videresælger til enkeltpersoner. WWI sælger til detailkunder på tværs af USA herunder specialbutikker, supermarkeder, databehandlingsbutikker, turistattraktionsbutikker og nogle enkeltpersoner. WWI sælger også til andre grossister via et netværk af agenter, der markedsfører produkterne på WWI's vegne. Hvis du vil vide mere om deres virksomhedsprofil og -drift, skal du se Eksempeldatabaser til Wide World Importers for Microsoft SQL.

Generelt hentes data fra transaktionssystemer eller line of business-programmer til et lakehouse. Men af hensyn til enkelheden i dette selvstudium bruger vi den dimensionelle model, der leveres af WWI, som vores oprindelige datakilde. Vi bruger dem som kilde til at indtage dataene i et lakehouse og transformere dem gennem forskellige faser (Bronze, Silver og Gold) i en medaljonsarkitektur.

Datamodel

Mens WWI-dimensionelle model indeholder mange faktatabeller, bruger vi faktatabellen Salg og dens korrelerede dimensioner til dette selvstudium. I følgende eksempel illustreres WWI-datamodellen:

Data- og transformationsflow

Som beskrevet tidligere bruger vi eksempeldataene fra WWI-eksempeldata (Wide World Importers) til at bygge dette end-to-end lakehouse. I denne implementering gemmes eksempeldataene på en Azure Data Storage-konto i Parquet-filformatet for alle tabellerne. Men i scenarier i den virkelige verden stammer data typisk fra forskellige kilder og i forskellige formater.

På følgende billede vises kilden, destinationen og datatransformationen:

Datakilde: Kildedataene er i parquetfilformat og i en ikke-partitioneret struktur. Den gemmes i en mappe for hver tabel. I dette selvstudium konfigurerer vi en pipeline til at overføre de komplette historiske data eller engangsdata til lakehouse.

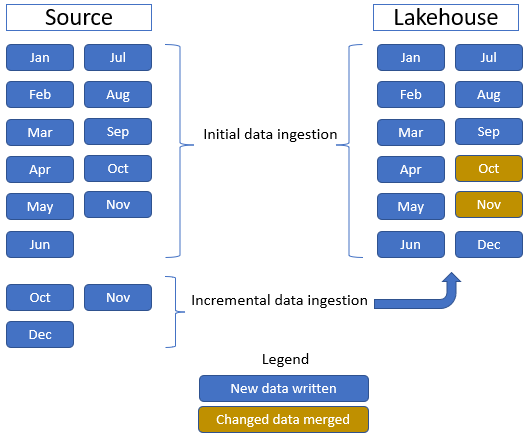

I dette selvstudium bruger vi faktatabellen Salg , som har én overordnet mappe med historiske data for 11 måneder (med én undermappe for hver måned) og en anden mappe, der indeholder trinvise data i tre måneder (én undermappe for hver måned). Under den indledende dataindtagelse indtages 11 måneders data i lakehouse-tabellen. Men når de trinvise data modtages, indeholder de opdaterede data for okt og november, og nye data for dataene for december. Okt og november flettes med de eksisterende data, og de nye data for dec. skrives i lakehouse-tabellen som vist på følgende billede:

Lakehouse: I dette selvstudium opretter du et lakehouse, henter data i filafsnittet i lakehouse og opretter derefter delta lake-tabeller i afsnittet Tabeller i lakehouse.

Transformér: I forbindelse med dataforberedelse og transformation kan du se to forskellige tilgange. Vi demonstrerer brugen af Notesbøger/Spark for brugere, der foretrækker en førstegangsoplevelse og bruger pipelines/dataflow til brugere, der foretrækker en oplevelse med lav kode eller ingen kode.

Forbrug: Hvis du vil demonstrere dataforbrug, kan du se, hvordan du kan bruge directlake-funktionen i Power BI til at oprette rapporter, dashboards og direkte forespørge data fra lakehouse. Derudover demonstrerer vi, hvordan du kan gøre dine data tilgængelige for tredjepartsrapporteringsværktøjer ved hjælp af TDS/SQL-analyseslutpunktet. Dette slutpunkt giver dig mulighed for at oprette forbindelse til lageret og køre SQL-forespørgsler til analyse.