Integrer OneLake med Azure Databricks

I dette scenarie kan du se, hvordan du opretter forbindelse til OneLake via Azure Databricks. Når du har fuldført dette selvstudium, kan du læse og skrive til et Microsoft Fabric lakehouse fra dit Azure Databricks-arbejdsområde.

Forudsætninger

Før du opretter forbindelse, skal du have:

- Et fabric arbejdsområde og lakehouse.

- Et Premium Azure Databricks-arbejdsområde. Kun Premium Azure Databricks-arbejdsområder understøtter passthrough af Microsoft Entra-legitimationsoplysninger, som du skal bruge til dette scenarie.

Konfigurer dit Databricks-arbejdsområde

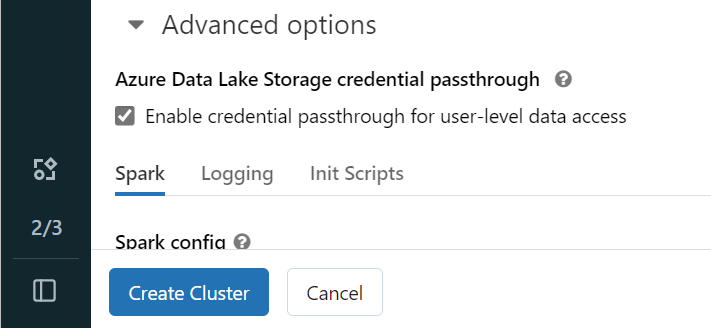

Åbn dit Azure Databricks-arbejdsområde, og vælg Opret>klynge.

Hvis du vil godkende til OneLake med din Microsoft Entra-identitet, skal du aktivere adls-passthrough (Azure Data Lake Storage) på din klynge under Avancerede indstillinger.

Bemærk

Du kan også oprette forbindelse mellem Databricks og OneLake ved hjælp af en tjenesteprincipal. Du kan få flere oplysninger om godkendelse af Azure Databricks ved hjælp af en tjenesteprincipal under Administrer tjenesteprincipaler.

Opret klyngen med dine foretrukne parametre. Du kan få flere oplysninger om oprettelse af en Databricks-klynge under Konfigurer klynger – Azure Databricks.

Åbn en notesbog, og opret forbindelse til den nyoprettede klynge.

Opret din notesbog

Gå til fabric lakehouse, og kopiér stien til Azure Blob Filesystem (ABFS) til dit lakehouse. Du kan finde den i ruden Egenskaber .

Bemærk

Azure Databricks understøtter kun AZURE Blob Filesystem -driveren (ABFS), når der læses og skrives til ADLS Gen2 og OneLake:

abfss://myWorkspace@onelake.dfs.fabric.microsoft.com/.Gem stien til dit lakehouse i din Databricks-notesbog. I dette lakehouse kan du skrive dine behandlede data senere:

oneLakePath = 'abfss://myWorkspace@onelake.dfs.fabric.microsoft.com/myLakehouse.lakehouse/Files/'Indlæs data fra et offentligt Databricks-datasæt i en dataramme. Du kan også læse en fil fra et andet sted i Fabric eller vælge en fil fra en anden ADLS Gen2-konto, du allerede ejer.

yellowTaxiDF = spark.read.format("csv").option("header", "true").option("inferSchema", "true").load("/databricks-datasets/nyctaxi/tripdata/yellow/yellow_tripdata_2019-12.csv.gz")Filtrer, transformér eller forbered dine data. I dette scenarie kan du trimme dit datasæt for at få hurtigere indlæsning, deltage i andre datasæt eller filtrere ned til bestemte resultater.

filteredTaxiDF = yellowTaxiDF.where(yellowTaxiDF.fare_amount<4).where(yellowTaxiDF.passenger_count==4) display(filteredTaxiDF)Skriv din filtrerede dataramme til fabric lakehouse ved hjælp af din OneLake-sti.

filteredTaxiDF.write.format("csv").option("header", "true").mode("overwrite").csv(oneLakePath)Test, at dine data blev skrevet ved at læse den nyligt indlæste fil.

lakehouseRead = spark.read.format('csv').option("header", "true").load(oneLakePath) display(lakehouseRead.limit(10))

Tillykke! Du kan nu læse og skrive data i Fabric ved hjælp af Azure Databricks.