Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

Retrieval Augmented Generation (RAG) i Microsoft Copilot Studio kombinerer sprogmodellernes ræsonnementsmuligheder med pålidelig, organisationsspecifik viden. Det gør det muligt for agenter at producere nøjagtige, kontekstuelle og jordnære svar baseret på virksomhedens indhold i stedet for udelukkende at stole på modelhukommelse.

I denne artikel lærer du, hvordan du:

- Forstå, hvordan RAG forbedrer AI's pålidelighed og jordforbindelse.

- Beskriv, hvordan Copilot Studio henter og syntetiserer viden.

- Identificer de understøttede videnskilder og deres begrænsninger.

- Anerkend governance, compliance og AI-sikkerhedshensyn.

- Anvend RAG-koncepter, når du designer agenter i virksomhedsmiljøer.

Introduktion til RAG

RAG er et designmønster, der forbedrer AI's nøjagtighed ved at kombinere to funktioner:

- Informationssøgning: Søgning i virksomhedens datakilder.

- Tekstgenerering: Syntetisere den hentede information ved brug af en sprogmodel.

Denne tilgang reducerer forkert information, øger tilliden og genererer svar, der er forankret i reelt organisatorisk indhold.

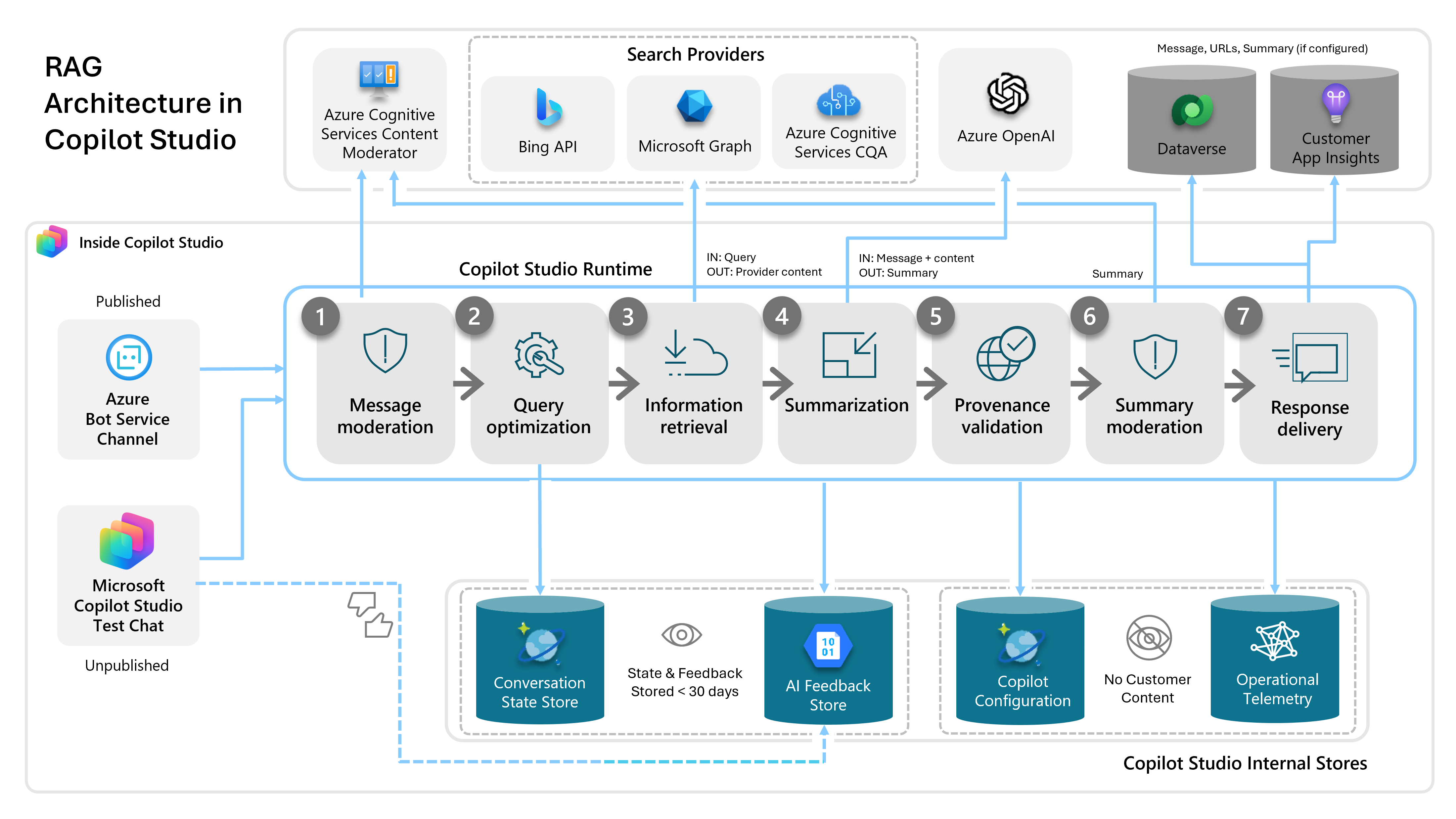

RAG-arkitektur i Copilot Studio

Copilot Studios RAG-pipeline er bygget på Azure AI-tjenester og integrerer tæt med Microsofts grænser for tillid, compliance og sikkerhed.

Kernekomponenter:

- Copilot Studio runtime: Styrer samtalepipelinen

- Forespørgselsoptimeringsmotor: Omskriver og fortolker forespørgsler

- Søgeudbydere: Bing, SharePoint, Graph, Dataverse, Azure AI Search

- Opsummeringsmotor: Skaber jordnære, citerede svar

- Modereringslag: Validerer beskeder og resuméer

- State store: Korttidshukommelse (mindre end 30 dage; ikke brugt til træning)

- Telemetri- og feedback-butikker: Giver indsigt og tilsyn

Hvordan RAG fungerer i Copilot Studio

RAG i Copilot Studio følger en firetrinsproces:

- Omskrivning af forespørgsel

- Indholdssøgning

- Opsummering og responsgenerering

- Validering af sikkerhed og styring

1. Omskrivning af forespørgslen

Copilot Studio optimerer brugerens spørgsmål, før de søger:

- Præciserer betydningen

- Tilføjer kontekstuelle signaler (sidste 10 sving)

- Forbedrer søgeordsmatchning

- Genererer søgevenlige forespørgsler

Denne proces øger udhentningskvaliteten og reducerer irrelevante resultater.

2. Indholdssøgning

Efter at have omskrevet forespørgslen, kører systemet den mod alle de videnskilder, du har sat op. Copilot Studio får de tre bedste resultater fra hver kilde og balancerer relevans med ydeevne. Adfærden for hver videnskilde varierer afhængigt af faktorer som autentificering, indeksering, filformater og lagringsbegrænsninger.

Følgende tabel opsummerer alle understøttede videnskilder samt deres kapaciteter, begrænsninger og autentificeringskrav:

| Videnskilde | Beskrivelse | Godkendelse | Nøglekapaciteter, begrænsninger og begrænsninger |

|---|---|---|---|

| Offentlige data (hjemmesider) | Websites indekseret af Bing | Ingen |

|

| SharePoint / OneDrive | Internt virksomhedsindhold (kun internt) | Microsoft Entra ID delegeret auth |

|

| Uploadede filer | Filer uploadet til Dataverse-lagring | Ingen |

|

| Dataverse-tabeller | Strukturerede forretningsdokumenter (kun interne) | Microsoft Entra ID delegeret auth |

|

| Grafforbindelser | Enterprise-apps indekseret i Microsoft Graph (kun internt) | Microsoft Entra ID delegeret auth |

|

| Realtidsstik | Live data fra systemer som Salesforce, Zendesk, SQL (kun internt) | Brugeren skal være logget ind |

|

| Azure AI Search- | Vektorbaseret semantisk søgning | Konfigureret endpoint |

|

| Brugerdefinerede data | Data leveret gennem API'er, flows eller brugerdefineret logik | Ingen |

|

3. Opsummering og responsgenerering

- AI syntetiserer hentet indhold

- Anvender brugerdefinerede instruktioner for tone, formatering, sikkerhed eller kortfattethed

- Genererer citater til de underliggende data

- Personliggør svar ved at bruge brugerkontekst (som sprog, afdeling eller region)

4. Sikkerhed og validering af governance

Hvert svar gennemgår automatiserede valideringslag:

- Moderering af skadelige, ondsindede, ikke-kompatible eller ophavsretligt beskyttede svar

- Validering af jordforbindelse og fjernelse af forkerte oplysninger

Ingen kundedata træner sprogmodeller.

Vigtige overvejelser ved brug af RAG

RAG fungerer bedst til faktuelle spørgsmål og svar, ikke til dybdegående dokumentanalyse.

RAG er ideelt til:

- Besvarelse af spørgsmål fra vidensbaser

- Opsummering af politikker, FAQ'er og proceduremæssigt indhold

- Hentning af specifikke fakta fra filer eller interne systemer

RAG er ikke beregnet til:

- Fuld dokumentsammenligning

- Evaluering af politikoverholdelse

- Kompleks ræsonnement over lange, ustrukturerede dokumenter

Generativ AI-sikkerhed og overholdelsesovervejelser

Generative AI-funktioner i Microsoft Copilot Studio er designet til at levere kraftfulde samtale- og ræsonnementsfunktioner, samtidig med at der opretholdes stærke sikkerheds-, privatlivs- og compliance-kontroller.

Fundamentmodeller og hosting

- Copilot Studio bygger på fundamentmodeller, som OpenAI træner.

- Copilot Studio bruger en af de nyeste OpenAI-modeller til generative svar.

- Modellerne kører udelukkende på interne Azure AI Foundry-tjenester, tilpasset Microsoft Services Trust-grænsen.

- Al modelbrug følger Microsoft Responsible AI-principper og -politikker.

Brugerdefinerede instruktioner

Skabere kan levere brugerdefinerede instruktioner til at forme modeladfærd, påvirke tone eller tilføje formateringsregler. Disse instruktioner hjælper med at tilpasse de generative svar til organisationens behov, samtidig med at sikkerhedsfiltre og overholdelseskontroller respekteres.

Datalagring og -behandling

- Datalagring og -behandling i Copilot Studio kan flytte data på tværs af regionale grænser, når lokal modelhosting ikke er tilgængelig.

- Når denne dataflytning ikke er tilladt, kan administratorer bruge miljøindstillinger til at deaktivere specifikke funktioner som Azure-sprogmodeller eller Bing Search.

- Copilot Studio indsamler eller bruger ikke nogen kundedata til at træne sprogmodeller.

Operationel datahåndtering

- Under driften gemmer systemet midlertidigt samtaler i en sikret, Microsoft-drevet butik.

- Autoriseret Microsoft-personales adgang er begrænset gennem Secure Access Workstations (SAWs) med Just-In-Time (JIT)-kontroller.

- Organisationer kan yderligere kontrollere adgangen via Customer Lockbox, hvilket kræver eksplicit godkendelse, før Microsoft-supportingeniører kan se data.

Fejlfinding af telemetri

- Generative AI-funktioner genererer ekstra fejlfindingsdata, men kun for skaberinitierede handlinger i Testpanelet, specifikt når producenten giver tommelfinger op eller ned til et svar.

- Der logges ingen ekstra kundedata uden for denne eksplicitte feedback-loop.

Overvågning af misbrug og sikkerhed

Da flere sikkerhedslag allerede beskytter generative AI-funktioner, deaktiverer Copilot Studios generative AI overvågning af Azure AI-misbrug for at undgå yderligere logning af kundedata.