Generering af billede

Notat

Se fanen Tekst og billeder for flere detaljer!

Den samme multimodale modelarkitektur, der gør det muligt for AI at skabe naturlige sprogsvar på visuelt input, kan også bruges til at gøre det muligt at skabe billeder som svar på prompter på naturligt sprog. Ved at identificere de visuelle træk, der er forbundet med sprog, kan en billedsyntesemodel tage en beskrivelse af et ønsket billede eller en video og generere den.

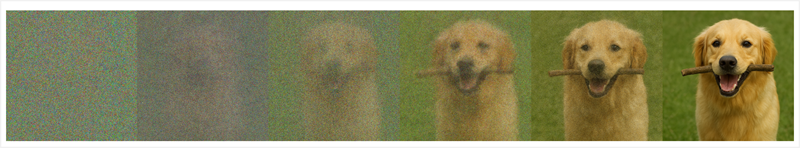

De fleste moderne billedgenereringsmodeller bruger en teknik kaldet diffusion, hvor en prompt bruges til at identificere et sæt relaterede visuelle funktioner, der kan kombineres for at skabe et billede. Billedet oprettes derefter iterativt, startende med et tilfældigt sæt pixelværdier og fjerner "støj" for at skabe struktur. Efter hver gentagelse evaluerer modellen billedet indtil videre for at sammenligne det med prompten, indtil et endeligt billede, der viser den ønskede scene, produceres.

For eksempel kan prompten "En hund bærer en pind i munden" resultere i en diffusionsproces med følgende iterationer:

Nogle modeller kan anvende en lignende proces til at generere video. Videogenereringsprocessen bruger den samme teknik til at identificere visuelle træk, der er forbundet med sprogtokens, men tager også højde for faktorer som objekters fysiske adfærd i den virkelige verden (såsom at sikre, at en hund går med fødderne på jorden) og den tidsmæssige progression (så videoen skildrer en logisk sekvens af aktivitet).