Bereitstellen eines Custom Speech-Modells

In diesem Artikel erfahren Sie, wie Sie einen Endpunkt für ein Custom Speech-Modell bereitstellen. Mit Ausnahme der Batchtranskription müssen Sie einen benutzerdefinierten Endpunkt bereitstellen, um ein Custom Speech-Modell zu verwenden.

Tipp

Ein gehosteter Bereitstellungsendpunkt ist nicht erforderlich, um Custom Speech mit der Batchtranskriptions-API zu verwenden. Sie können Ressourcen sparen, wenn das Custom Speech-Modell nur für die Batchtranskription verwendet wird. Weitere Informationen finden Sie unter Preise für den Speech-Dienst.

Sie können einen Endpunkt für ein Basis- oder benutzerdefiniertes Modell bereitstellen und den Endpunkt später aktualisieren, um ein besser trainiertes Modell zu verwenden.

Hinweis

Endpunkte, die von F0-Speech-Ressourcen verwendet werden, werden nach sieben Tagen gelöscht.

Hinzufügen eines Bereitstellungsendpunkts

Führen Sie die folgenden Schritte aus, um einen benutzerdefinierten Endpunkt zu erstellen:

Melden Sie sich in Speech Studio an.

Wählen Sie Custom Speech> Projektname >Modelle bereitstellen aus.

Wenn das Ihr erster Endpunkt ist, werden Sie feststellen, dass in der Tabelle keine Endpunkte aufgeführt sind. Nachdem Sie einen Endpunkt erstellt haben, verwenden Sie diese Seite zum Nachverfolgen der einzelnen bereitgestellten Endpunkte.

Wählen Sie Modell bereitstellen aus, um den neuen Endpunkt-Assistenten zu starten.

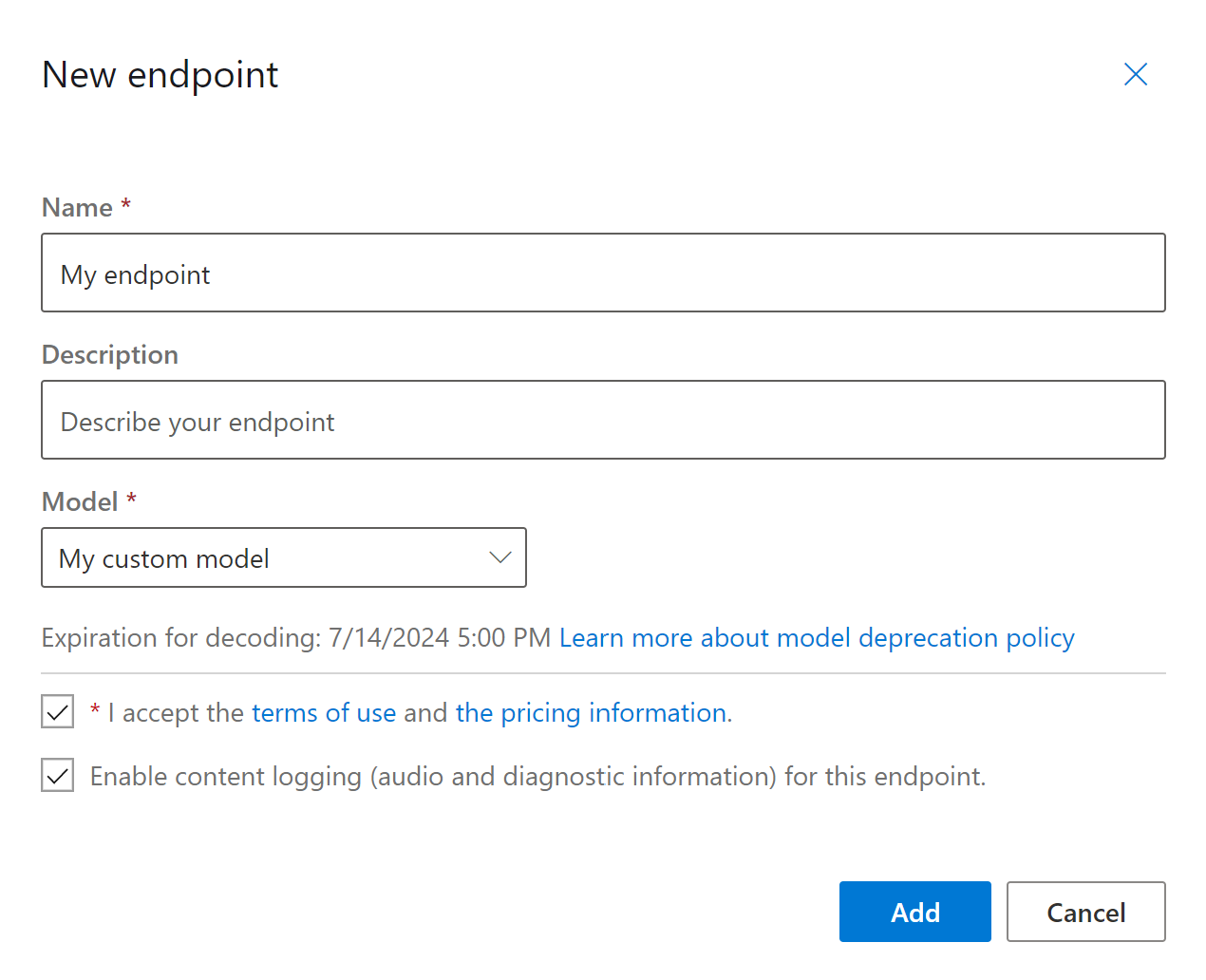

Geben Sie auf der Seite Neuer Endpunkt einen Namen und eine Beschreibung für Ihren benutzerdefinierten Endpunkt ein.

Wählen Sie das benutzerdefinierte Modell aus, das Sie dem Endpunkt zuordnen möchten.

Optional können Sie das Kontrollkästchen markieren, um die Audio- und Diagnose-Protokollierung des Datenverkehrs des Endpunkts zu aktivieren.

Wählen Sie Hinzufügen aus, um den Endpunkt zu speichern und bereitzustellen.

Auf der Hauptseite von Bereitstellen von Modellen werden Details zum neuen Endpunkt in einer Tabelle angezeigt, z. B. Name, Beschreibung, Status und Ablaufdatum. Es kann bis zu 30 Minuten dauern, bis ein neuer Endpunkt mit Ihren benutzerdefinierten Modellen instanziiert wurde. Sobald sich der Bereitstellungsstatus in Erfolgreich ändert, kann der Endpunkt verwendet werden.

Wichtig

Notieren Sie sich das Ablaufdatum des Modells. Dies ist das letzte Datum, an dem Sie Ihr benutzerdefiniertes Modell für die Spracherkennung verwenden können. Weitere Informationen finden Sie unter Modell- und Endpunktlebenszyklus.

Klicken Sie auf den Link des Endpunkts, um spezifische Informationen zu Ihrem Endpunkt anzuzeigen (z. B. Endpunktschlüssel, Endpunkt-URL und Beispielcode).

Verwenden Sie den Befehl spx csr endpoint create, um einen Endpunkt zu erstellen und ein Modell bereitzustellen. Erstellen Sie die Anforderungsparameter gemäß den folgenden Anweisungen:

- Legen Sie den

project-Parameter auf die ID eines vorhandenen Projekts fest. Dies wird empfohlen, damit Sie das Modell auch in Speech Studio anzeigen und verwalten können. Sie können mit dem Befehlspx csr project listverfügbare Projekte abrufen. - Legen Sie den erforderlichen

model-Parameter auf die ID des Modells fest, das Sie am Endpunkt bereitstellen möchten. - Legen Sie den erforderlichen

language-Parameter fest. Das Gebietsschema des Endpunkts muss mit dem Gebietsschema des Modells übereinstimmen. Das Gebietsschema können Sie später nicht mehr ändern. Der Parameterlanguageder Speech-Befehlszeilenschnittstelle entspricht derlocale-Eigenschaft in der JSON-Anforderung und -Antwort. - Legen Sie den erforderlichen

name-Parameter fest. Dieser Name wird in Speech Studio angezeigt. Der Parameternameder Speech-Befehlszeilenschnittstelle entspricht derdisplayName-Eigenschaft in der JSON-Anforderung und -Antwort. - Optional können Sie den

logging-Parameter festlegen. Setzen Sie diesen aufenabled, um die Audio- und Diagnose-Protokollierung des Datenverkehrs des Endpunkts zu aktivieren. Der Standardwert istfalse.

Hier ist ein beispielhafter Befehl der Speech-Befehlszeilenschnittstelle, um einen Endpunkt zu erstellen und ein Modell bereitzustellen:

spx csr endpoint create --api-version v3.2 --project YourProjectId --model YourModelId --name "My Endpoint" --description "My Endpoint Description" --language "en-US"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:29:36Z",

"status": "NotStarted",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Die oberste self-Eigenschaft im Antworttext ist der URI des Endpunkts. Verwenden Sie diesen URI, um Details zum Projekt, Modell und Protokoll des Endpunkts abzurufen. Sie verwenden diesen URI auch, um den Endpunkt zu aktualisieren.

Führen Sie den folgenden Befehl aus, um Hilfe für die Speech-Befehlszeilenschnittstelle mit Endpunkten zu erhalten:

spx help csr endpoint

Zum Erstellen eines Endpunkts und zum Bereitstellen eines Modells verwenden Sie den Vorgang Endpoints_Create der Spracherkennungs-REST-API. Erstellen Sie den Anforderungstext gemäß den folgenden Anweisungen:

- Legen Sie die

project-Eigenschaft auf den URI eines vorhandenen Projekts fest. Dies wird empfohlen, damit Sie das Modell auch in Speech Studio anzeigen und verwalten können. Sie können eine Projects_List-Anforderung zum Abrufen verfügbarer Projekte ausführen. - Legen Sie die erforderliche

model-Eigenschaft auf den URI des Modells fest, das Sie am Endpunkt bereitstellen möchten. - Legen Sie die erforderliche

locale-Eigenschaft fest. Das Gebietsschema des Endpunkts muss mit dem Gebietsschema des Modells übereinstimmen. Das Gebietsschema können Sie später nicht mehr ändern. - Legen Sie die erforderliche

displayName-Eigenschaft fest. Dieser Name wird in Speech Studio angezeigt. - Optional können Sie innerhalb von

propertiesdieloggingEnabled-Eigenschaft festlegen. Setzen Sie diese auftrue, um die Audio- und Diagnose-Protokollierung des Datenverkehrs des Endpunkts zu aktivieren. Der Standardwert istfalse.

Erstellen Sie eine HTTP POST-Anforderung mithilfe des URI, wie im folgenden Beispiel mit Endpoints_Create gezeigt. Ersetzen Sie YourSubscriptionKey durch Ihren Speech-Ressourcenschlüssel, ersetzen Sie YourServiceRegion durch die Region der Speech-Ressource, und legen Sie die Anforderungstexteigenschaften wie zuvor beschrieben fest.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"displayName": "My Endpoint",

"description": "My Endpoint Description",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"locale": "en-US",

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:29:36Z",

"status": "NotStarted",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Die oberste self-Eigenschaft im Antworttext ist der URI des Endpunkts. Verwenden Sie diesen URI, um Details zu Projekt, Modell und Protokollen des Endpunkts abzurufen. Sie verwenden diesen URI auch, um einen Endpunkt zu aktualisieren oder zu löschen.

Ändern des Modells und erneutes Bereitstellen des Endpunkts

Ein Endpunkt kann so aktualisiert werden, dass er ein anderes Modell verwendet, das von derselben Speech-Ressource erstellt wurde. Wie bereits erwähnt, müssen Sie das Modell des Endpunkts aktualisieren, bevor das Modell abläuft.

So verwenden Sie ein neues Modell und stellen den benutzerdefinierten Endpunkt erneut bereit:

- Melden Sie sich in Speech Studio an.

- Wählen Sie Custom Speech> Projektname >Modelle bereitstellen aus.

- Wählen Sie den Link zu einem Endpunkt nach dem Namen aus, und wählen Sie dann Modell ändern aus.

- Wählen Sie das neue Modell aus, das der Endpunkt verwenden soll.

- Klicken Sie auf Fertig, um den Endpunkt zu speichern und erneut bereitzustellen.

Verwenden Sie den Befehl spx csr model update, um den benutzerdefinierten Endpunkt mit einem neuen Modell erneut bereitzustellen. Erstellen Sie die Anforderungsparameter gemäß den folgenden Anweisungen:

- Legen Sie den erforderlichen

endpoint-Parameter auf die ID des Endpunkts fest, den Sie bereitstellen möchten. - Legen Sie den erforderlichen

model-Parameter auf die ID des Modells fest, das Sie am Endpunkt bereitstellen möchten.

Hier ist ein beispielhafter Befehl der Speech-Befehlszeilenschnittstelle, der den benutzerdefinierten Endpunkt mit einem neuen Modell erneut bereitstellt:

spx csr endpoint update --api-version v3.2 --endpoint YourEndpointId --model YourModelId

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Führen Sie den folgenden Befehl aus, um Hilfe für die Speech-Befehlszeilenschnittstelle mit Endpunkten zu erhalten:

spx help csr endpoint

Verwenden Sie zum erneuten Bereitstellen des benutzerdefinierten Endpunkts mit einem neuen Modell den Vorgang Endpoints_Update der Spracherkennungs-REST-API. Erstellen Sie den Anforderungstext gemäß den folgenden Anweisungen:

- Legen Sie die

model-Eigenschaft auf den URI des Modells fest, das Sie am Endpunkt bereitstellen möchten.

Erstellen Sie eine HTTP PATCH-Anforderung mithilfe des URI, wie im folgenden Beispiel gezeigt. Ersetzen Sie YourSubscriptionKey durch den Schlüssel Ihrer Speech-Ressource, YourServiceRegion durch die Region Ihrer Speech-Ressource, YourEndpointId durch die ID Ihres Endpunktes, und legen Sie die Anforderungstexteigenschaften wie zuvor beschrieben fest.

curl -v -X PATCH -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Die erneute Bereitstellung kann einige Minuten in Anspruch nehmen. In der Zwischenzeit verwendet Ihr Endpunkt das vorherige Modell, ohne dass eine Dienstunterbrechung auftritt.

Anzeigen von Protokolldaten

Protokollierungsdaten sind für den Export verfügbar, wenn Sie sie beim Erstellen des Endpunkts konfiguriert haben.

So laden Sie die Endpunktprotokolle herunter:

- Melden Sie sich in Speech Studio an.

- Wählen Sie Custom Speech> Ihr Projektname >Modelle bereitstellen aus.

- Wählen Sie den Link nach dem Namen des Endpunkts aus.

- Wählen Sie unter Inhaltsprotokollierung die Option Protokoll herunterladen aus.

Zum Abrufen von Protokollen für einen Endpunkt verwenden Sie den Befehl spx csr endpoint list. Erstellen Sie die Anforderungsparameter gemäß den folgenden Anweisungen:

- Legen Sie den erforderlichen

endpoint-Parameter auf die ID des Endpunkts fest, für den Sie Protokolle abrufen wollen.

Hier ist ein beispielhafter Befehl der Speech-Befehlszeilenschnittstelle, der Protokolle für einen Endpunkt abruft:

spx csr endpoint list --api-version v3.2 --endpoint YourEndpointId

Der Speicherort jeder Protokolldatei wird mit weiteren Details im Antworttext zurückgegeben.

Zum Abrufen von Protokollen für einen Endpunkt beginnen Sie mit dem Vorgang Endpoints_Get der Spracherkennungs-REST-API.

Erstellen Sie eine HTTP GET-Anforderung mithilfe des URI, wie im folgenden Beispiel gezeigt. Ersetzen Sie in YourEndpointIddurch die ID Ihres Endpunkts, YourSubscriptionKey durch den Schlüssel Ihrer Speech-Ressource und YourServiceRegion durch die Region Ihrer Speech-Ressource.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Erstellen Sie eine HTTP-GET-Anforderung mithilfe des „logs“-URI aus dem vorherigen Antworttext. Ersetzen Sie in YourEndpointIddurch die ID Ihres Endpunkts, YourSubscriptionKey durch den Schlüssel Ihrer Speech-Ressource und YourServiceRegion durch die Region Ihrer Speech-Ressource.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId/files/logs" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Der Speicherort jeder Protokolldatei wird mit weiteren Details im Antworttext zurückgegeben.

Protokolldaten stehen 30 Tage lang im Microsoft-Speicher zur Verfügung. Danach werden sie entfernt. Falls Ihr eigenes Speicherkonto mit dem Azure KI Services-Abonnement verknüpft ist, werden die Protokolldaten nicht automatisch gelöscht.