Was ist ein Sprachassistent?

Durch die Verwendung von Sprach-Assistenten mit dem Speech-Dienst können Entwickler natürliche Konversationsschnittstellen für ihre Anwendungen und Umgebungen erstellen, die der menschlichen Sprache nahekommen. Die Funktion für den Sprach-Assistentendienst ermöglicht die schnelle, zuverlässige Interaktion zwischen einem Gerät und einer Assistentenimplementierung.

Auswählen einer Assistenten-Lösung

Im ersten Schritt beim Erstellen eines Sprach-Assistenten entscheiden Sie, was er tun soll. Der Speech-Dienst verfügt über mehrere Lösungen für die Entwicklung von Assistenten-Interaktionen, die sich gegenseitig ergänzen. Möglicherweise möchten Sie, dass Ihre Anwendung eine offene Unterhaltung mit Ausdrücken wie „Ich muss nach Seattle gehen“ oder „Welche Art von Pizza kann ich bestellen?“ unterstützt. Um Flexibilität und Vielseitigkeit zu gewährleisten können Sie einem Bot Funktionen für Voice-In- und Voice-Out hinzufügen, indem Sie Azure KI Bot Service mit dem Direct Line Speech-Kanal verwenden.

Falls Sie noch nicht genau wissen, wie Ihr Assistent eingesetzt werden soll, empfehlen wir die Verwendung von Direct Line Speech. Hiermit erhalten Sie eine Integration mit umfassenden Tools und Erstellungshilfen, z. B. die Lösung „Virtueller Assistent“ und die Unternehmensvorlage sowie den QnA Maker-Dienst, um häufig verwendete Muster zu nutzen und zu erweitern und Ihre vorhandenen Wissensquellen zu verwenden.

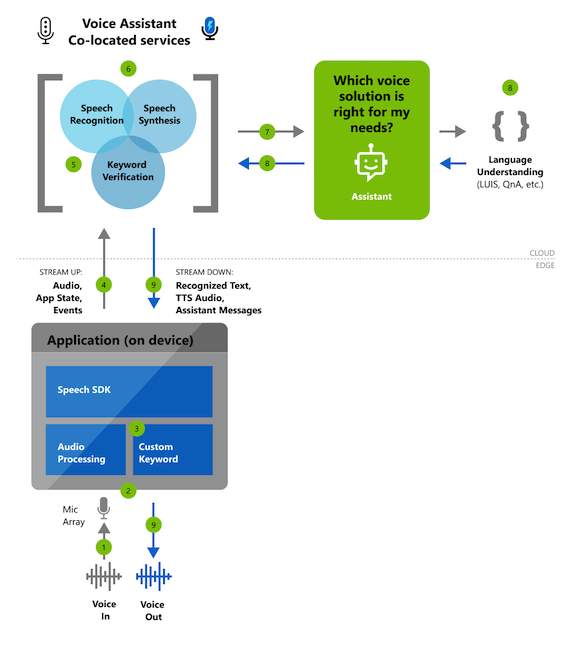

Referenzarchitektur zum Erstellen eines Sprach-Assistenten mithilfe des Speech SDK

Wichtige Funktionen

Sowohl bei Nutzung von Direct Line Speech als auch einer anderen Lösung zum Erstellen Ihrer Assistenten-Interaktionen können Sie auf umfassende Anpassungsfunktionen zurückgreifen, mit denen Sie Ihren Assistenten an Ihre Wünsche in Bezug auf Marke, Produkt und Persönlichkeit anpassen können.

| Category | Features |

|---|---|

| Benutzerdefiniertes Schlüsselwort | Benutzer können Konversationen mit Assistenten mithilfe eines benutzerdefinierten Schlüsselworts wie „Hey Contoso“ beginnen. Eine App führt dies mit einer benutzerdefinierten Schlüsselwort-Engine im Speech SDK durch, das Sie unter Erste Schritte mit dem benutzerdefinierten Schlüsselwort konfigurieren können. Sprach-Assistenten können eine dienstseitige Schlüsselwortüberprüfung nutzen, um die Genauigkeit der Schlüsselwortaktivierung zu verbessern (statt diesen Vorgang nur über das Gerät durchzuführen). |

| Spracherkennung | Sprach-Assistenten wandeln mithilfe der Spracherkennung des Speech-Diensts Audiodaten in Echtzeit in erkannten Text um. Dieser Text ist während der Transkription sowohl für Ihre Assistentenimplementierung als auch für Ihre Clientanwendung verfügbar. |

| Sprachsynthese | Textantworten von Ihrem Assistenten werden mithilfe der Sprachsynthese des Speech-Diensts synthetisiert. Diese Synthese wird dann Ihrer Clientanwendung als Audiostream zur Verfügung gestellt. Mit Microsoft haben Sie die Möglichkeit, eine eigene benutzerdefinierte, hochwertige neuronale TTS-Stimme (Text-to-Speech, Sprachsynthese) zu erstellen, die Ihrer Marke Persönlichkeit verleiht. |

Erste Schritte mit Sprach-Assistenten

Wir bieten den folgenden Schnellstartartikel, mit dem Sie Code in weniger als 10 Minuten ausführen können: Schnellstart: Erstellen eines benutzerdefinierten Sprachassistenten mithilfe von Direct Line Speech

Beispielcode und Tutorials

Beispielcode für die Erstellung eines Sprachassistenten ist auf GitHub verfügbar. Die Beispiele decken die Clientanwendung für die Verbindung mit Ihrem Assistenten in mehreren gängigen Programmiersprachen ab.

- Beispiele für Sprachassistenten auf GitHub

- Tutorial: Aktivieren der Sprachsteuerung eines Assistenten, der mithilfe von Azure KI Bot Service mit dem C# Speech-SDK erstellt wurde

Anpassung

Sprach-Assistenten, die Sie mit dem Speech-Dienst erstellen, können eine Vielzahl von Anpassungsoptionen verwenden.

Hinweis

Anpassungsoptionen variieren je nach Sprache und Gebietsschema. Erfahren Sie mehr über unterstützte Sprachen.