Einführung in das Erstellen von generativen KI-Lösungen für Entwickler

Generative KI, aktiviert durch Large Language Models (LLMs), eröffnet spannende neue Möglichkeiten für Softwareentwickler und Organisationen. Dienste wie Azure OpenAI demokratisieren die KI-Entwicklung, indem einfach zu verwendende APIs angeboten werden, sodass Entwickler beliebiger Qualifikationsebenen erweiterte KI-Funktionen in ihre Anwendungen integrieren können, ohne spezielle Kenntnisse zu benötigen oder Organisationen in Hardware investieren müssen.

Als Anwendungsentwickler können Sie schwer verstehen, welche Rolle Sie spielen können und wo Sie hineinpassen. Vielleicht fragen Sie sich beispielsweise, auf welcher Ebene im "KI-Stapel" Ihre Lernschwerpunkte liegen sollen? Oder Sie fragen sich vielleicht, was Sie mit den vorhandenen Technologien bauen können?

Um diese Fragen zu beantworten, ist es wichtig, dass Sie zunächst ein mentales Modell entwickeln, das ordnet, wie alle neuen Terminologie und Technologien in das, was Sie bereits verstehen, passen. Durch die Entwicklung eines mentalen Modells können Sie generative KI-Features in Ihren Anwendungen entwerfen und erstellen. Zu diesem Zweck ist der Zweck dieser Artikelreihe, Ihnen zu zeigen, wie Ihre aktuelle Softwareentwicklungserfahrung auf generative KI angewendet wird. Die Artikel enthalten auch einen Levelsatz zu Schlüsselwörtern und Konzepten, während Sie mit der Entwicklung Ihrer ersten generativen KI-Lösungen beginnen.

Was wollen Unternehmen mit generativen KI erreichen?

Um zu verstehen, wie Ihre aktuelle Softwareentwicklungserfahrung auf generative KI angewendet wird, ist es wichtig, zunächst zu verstehen, wie Unternehmen davon profitieren möchten.

Unternehmen sehen generative KI als Mittel zur Verbesserung des Kundeneinsatzes, zur Steigerung der betrieblichen Effizienz und zur Verbesserung der Problemlösung und Kreativität. Die Integration von generativen KI in bestehende Systeme eröffnet Unternehmen die Möglichkeit, ihre Softwareökosysteme zu verbessern. Sie kann herkömmliche Softwarefunktionen mit erweiterten KI-Funktionen ergänzen, z. B. personalisierte Empfehlungen für Benutzer oder einen intelligenten Agenten, der organisations- oder produktspezifische Fragen beantworten kann.

Hier sind einige häufige Szenarien, in denen generative KI Unternehmen helfen kann:

- Inhaltsgenerierung

- Generieren Sie Text, Code, Bilder und Sound. Dies könnte für Marketing, Vertrieb, IT, interne Kommunikation und vieles mehr hilfreich sein.

- Verarbeitung natürlicher Sprachen

- Verfassen oder Verbessern der Unternehmenskommunikation durch Vorschläge oder vollständige Generierung von Nachrichten.

- "Mit Ihren Daten chatten" oder mit anderen Worten, damit ein Benutzer Fragen in einer Chaterfahrung unter Verwendung von In Datenbanken oder in Dokumenten gespeicherten Daten als Grundlage für Antworten stellen kann.

- Zusammenfassung, Organisation und Vereinfachung großer Inhalte, um den Inhalt barrierefreier zu gestalten.

- "Semantische Suche" oder vielmehr, sodass Benutzer dokumente und Daten durchsuchen können, ohne genaue Stichwortüberstimmungen zu verwenden.

- Übersetzen der Sprache, um die Reichweite und Barrierefreiheit von Inhalten zu erhöhen.

- Datenanalyse

- Analysieren Sie Märkte, und identifizieren Sie Trends in Daten.

- Modellieren Sie Szenarien, die Unternehmen dabei helfen sollen, mögliche Änderungen oder Herausforderungen in jedem Bereich des Unternehmens zu planen.

- Analysieren Sie Code, um Verbesserungen vorzuschlagen, Fehler zu beheben und Dokumentationen zu generieren.

Wie Sie sehen können, haben Softwareentwickler die Möglichkeit, ihre Auswirkungen erheblich zu steigern, indem sie generative KI-Anwendungen und -Funktionen in die Software integrieren, auf die ihre Organisationen angewiesen sind.

Wie erstellen Sie diese Arten von Anwendungen?

Während das Large Language Model (LLM) die schwere Hebehebung durchführt, erstellen Sie Systeme, die die Ergebnisse integrieren, koordinieren und überwachen. Während es viel zu lernen gibt, können Sie die Fähigkeiten anwenden, die Sie bereits kennen:

- Aufrufen von APIs mit REST, JSON oder sprachspezifischen Software Development Kits (SDKs)

- Orchestrieren von Aufrufen von APIs und Ausführen von Geschäftslogik

- Speichern in und Abrufen aus Datenspeichern

- Integrieren von Eingaben und Ergebnissen in die Benutzeroberfläche

- Erstellen von APIs, die über LLMs aufgerufen werden können

Auf diese Weise baut die Entwicklung von generativen KI-Lösungen auf Ihren vorhandenen Fähigkeiten auf.

Welche Tools und Dienste sind verfügbar?

Microsoft investiert in die Entwicklung von Tools, Diensten, APIs, Beispielen und Lernressourcen, um Ihnen bei der Entwicklung ihrer generativen KI-Entwicklung zu helfen. Jeder hebt einige wichtige Bedenken oder Verantwortung hervor, die zum Erstellen einer generativen KI-Lösung erforderlich sind. Um einen bestimmten Dienst, eine API oder Ressource effektiv zu nutzen, stellt die Herausforderung sicher, dass Sie:

- Verstehen Sie die typischen Funktionen, Rollen und Verantwortlichkeiten in einer bestimmten Art von generativen KI-Feature? Wenn wir beispielsweise ausführlich in konzeptuellen Artikeln diskutieren, die retrieval-Augmented Generation (RAG)-basierte Chatsysteme beschreiben, gibt es viele architektonische Verantwortlichkeiten im System. Es ist wichtig, dass Sie die Problemdomäne und Einschränkungen intime verstehen, bevor Sie ein System entwerfen, das das Problem behebt.

- Verstehen Sie die APIs, Dienste und Tools für eine bestimmte Funktion, Rolle oder Verantwortung? Nachdem Sie nun die Problemdomäne und Einschränkungen verstanden haben, können Sie diesen Aspekt des Systems selbst mit benutzerdefiniertem Code erstellen oder vorhandene Low-Code/No-Code-Tools verwenden oder APIs für vorhandene Dienste aufrufen.

- Grundlegendes zu den Optionen, einschließlich codeorientierter lösungen und no-code/low-code. Sie könnten alles selbst aufbauen, aber ist das eine effiziente Nutzung Ihrer Zeit und Fähigkeiten? Je nach Ihren Anforderungen können Sie in der Regel eine Kombination aus Technologien und Ansätzen (Code, Code, Code, Low-Code, Tools) zusammenfügen.

Der Punkt hier ist, dass es keine einzige richtige Möglichkeit gibt, generative KI-Features in Ihre Anwendungen zu erstellen. Es gibt viele Tools und Ansätze. Es ist wichtig, die Trade-Offs zu bewerten.

Beginnen Sie mit einem Fokus auf der Anwendungsschicht

Sie müssen nicht alles über generative KI verstehen, um loszulegen und produktiv zu sein. Wie bereits erwähnt, wissen Sie wahrscheinlich bereits genug, da Sie APIs verwenden und vorhandene Fähigkeiten anwenden können.

Beispielsweise müssen Sie ihre eigene LLM nicht von Grund auf neu trainieren. Die Schulung eines LLM erfordert Zeit und Ressourcen, die die meisten Unternehmen nicht übernehmen möchten. Stattdessen bauen Sie auf vorhandenen vordefinierten Basismodellen wie GPT-4 auf, indem Sie API-Aufrufe in vorhandene gehostete Dienste wie die Azure OpenAI-API tätigen. Auf diese Weise unterscheidet sich das Hinzufügen von generativen KI-Features zu einer vorhandenen Anwendung nicht von dem Hinzufügen anderer Funktionen basierend auf einem API-Aufruf.

Recherchieren, wie LLMs trainiert werden oder wie sie arbeiten, erfüllen Ihre intellektuelle Neugier, aber wirklich zu verstehen, wie LLMs funktionieren, erfordert ein tiefes Verständnis der Datenwissenschaft und des mathematischen Hintergrunds, um sie zu unterstützen. Dazu können Graduiertenkurse zu Statistiken, Wahrscheinlichkeiten und Informationstheorie gehören.

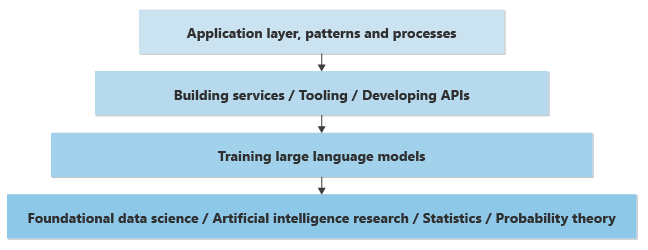

Wenn Sie aus einem Informatik-Hintergrund stammen, können Sie wissen, dass die meisten Anwendungsentwicklung auf einer "höheren Ebene im Stapel" von Forschung und Technologien geschieht. Möglicherweise haben Sie ein gewisses Verständnis für jede Ebene, aber Sie sind wahrscheinlich auf die Anwendungsentwicklungsebene spezialisiert, wobei Sie sich auf eine bestimmte Programmiersprache und Plattform konzentrieren (verfügbare APIs, Tools, Muster usw.).

Das gleiche gilt für das Feld der KI. Sie können die Theorie verstehen und schätzen, die auf LLMs aufbaut, aber Sie konzentrieren sich wahrscheinlich auf die Anwendungsschicht oder helfen, Muster oder Prozesse zu implementieren, um einen generativen KI-Aufwand in Ihrem Unternehmen zu ermöglichen.

Hier ist eine überlastende Darstellung der Wissensschichten, die erforderlich sind, um generative KI-Features in einer neuen oder vorhandenen Anwendung zu implementieren:

Auf der niedrigsten Ebene haben Sie Datenwissenschaftler, die Data Science-Forschung durchführen, um KI basierend auf einem tiefen mathematischen Verständnis von Statistiken, Wahrscheinlichkeitstheorie usw. zu lösen oder zu verbessern. Eine Ebene nach oben, basierend auf der niedrigsten Basisebene, verfügen Sie über Datenwissenschaftler, die theorietische Konzepte in LLMs implementieren, die neuralen Netzwerke aufbauen und die Gewichte und Voreingenommenheiten trainieren, um ein praktisches Softwarestück bereitzustellen, das Eingaben (Eingabeaufforderungen) akzeptieren und Ergebnisse (Fertigstellungen) generieren kann. Der berechnungsbasierte Prozess des Verfassens von Abschlussen auf Der Grundlage von Eingabeaufforderungen wird als Rückschluss bezeichnet. Es gibt diejenigen, die dafür verantwortlich sind, zu implementieren, wie die Neuronen des neuralen Netzwerks das nächste Wort oder Pixel generieren.

Angesichts der zum Trainieren von Modellen erforderlichen Verarbeitungsleistung und dem Generieren von Ergebnissen basierend auf einer Eingabe werden die Modelle häufig trainiert und in großen Rechenzentren gehostet. Es ist möglich, ein Modell auf einem lokalen Computer zu trainieren oder zu hosten, aber die Ergebnisse sind häufig langsam (ohne dedizierte GPU-Grafikkarten, um die zum Generieren von Ergebnissen erforderliche Berechnung zu verarbeiten).

Wenn sie in großen Rechenzentren gehostet werden, wird der programmgesteuerte Zugriff auf diese Modelle über REST-APIs bereitgestellt, und diese werden manchmal von SDKs "umschlossen" und für Anwendungsentwickler zur Benutzerfreundlichkeit zur Verfügung gestellt. Andere Tools können dazu beitragen, die Entwicklererfahrung zu verbessern, die Observability oder andere Dienstprogramme bereitzustellen. Anwendungsentwickler können Aufrufe an diese APIs vornehmen, um Geschäftsfunktionen zu implementieren.

Neben der programmgesteuerten Aufforderung der Modelle gibt es Muster und Prozesse, die Unternehmen dabei helfen, zuverlässige Geschäftsfunktionen basierend auf generativer KI aufzubauen. So entstehen beispielsweise Muster, mit denen Unternehmen sicherstellen können, dass der generierte Text, Code, Bilder und Sound ethischen und Sicherheitsstandards entsprechen, sowie Verpflichtungen für die Privatsphäre der Kundendaten.

In diesem Stapel von Bedenken oder Ebenen, wenn Sie ein Anwendungsentwickler sind, der für das Erstellen von Geschäftsfunktionen verantwortlich ist, ist es möglich, dass Sie über die Anwendungsschicht hinaus in die Entwicklung und Schulung Ihrer eigenen LLM über die Anwendungsschicht hinausschieben. Die Gewinnung dieses Verständnisniveaus erfordert jedoch eine neue Reihe von Fähigkeiten, die oft nur in einem akademischen Umfeld verfügbar sind. Wenn Sie sich nicht dazu verpflichten können, die Kompetenz in Data Science akademisch zu entwickeln, um die "nächste Ebene unten im Stapel" (also zu sprechen) zu erstellen, sollten Sie sich vielleicht auf das Verständnis der Dinge auf der Anwendungsebene konzentrieren wie:

- Grundlegendes zu verfügbaren APIs und SDKs, was verfügbar ist, was die verschiedenen Endpunkte produzieren usw.

- Grundlegendes zu verwandten Tools und Diensten, um Ihnen bei der Erstellung aller Features zu helfen, die für eine produktionsbereite generative KI-Lösung erforderlich sind.

- Verstehen des Prompt Engineering, z. B. wie sie die besten Ergebnisse erzielen können, indem Sie Fragen stellen oder neu erstellen.

- Verstehen, wo Engpässe entstehen und wie eine Lösung skaliert wird. Grundlegendes dazu, was bei der Protokollierung oder beim Abrufen von Telemetrie beteiligt ist, ohne die Datenschutzbedenken des Kunden zu verletzen.

- Grundlegendes zu den Merkmalen der verschiedenen LLMs (ihre Stärken, Anwendungsfälle, was sind die Benchmarks und was messen sie, wichtige Differenzierungen zwischen Anbietern und Modellen, die von jedem Anbieter hergestellt werden usw.), um das richtige Modell für die Bedürfnisse Ihres Unternehmens auszuwählen.

- Verstehen Sie die neuesten Muster, Workflows und Prozesse, die zum Erstellen effektiver und robuster generativer KI-Features in Ihren Anwendungen verwendet werden.

Verfügbare Dienste und Tools von Microsoft

Es gibt low-code- und no-code-generative KI-Tools und -Dienste, die von Microsoft zur Verfügung stehen, um Ihnen beim Erstellen eines Teils oder Ihrer gesamten Lösung zu helfen. Verschiedene Azure-Dienste können wichtige Rollen spielen, die jeweils zur Effizienz, Skalierbarkeit und Robustität der Lösung beitragen:

API- und SDKs für codeorientierte Vorgehensweise

Im Mittelpunkt jeder generativen KI-Lösung steht ein LLM-Modell, und Azure OpenAI bietet Zugriff auf alle features, die in Modellen wie GPT-4 verfügbar sind.

| Produkt | Beschreibung |

|---|---|

| Azure OpenAI | Ein gehosteter Dienst, der Zugriff auf leistungsstarke Sprachmodelle wie GPT-4 bietet. Es gibt mehrere verschiedene APIs, mit denen Sie alle typischen Funktionen eines LLM ausführen können, z. B. Das Erstellen von Einbettungen, das Erstellen einer Chaterfahrung usw. mit vollständigem Zugriff auf Einstellungen und Optimierungen, um die Ergebnisse nach Bedarf anzupassen. |

Ausführungsumgebungen

Da Sie Geschäftslogik, Präsentationslogik oder APIs erstellen, um generative KI in die Anwendungen Ihrer Organisation zu integrieren, müssen Sie diese Logik an einer beliebigen Stelle hosten und ausführen.

| Produkt | Beschreibung |

|---|---|

| Azure-App Dienst (oder eines von mehreren containerbasierten Clouddiensten) | Diese Plattform kann die Webschnittstellen oder APIs hosten, über die Benutzer mit dem RAG-Chat-System interagieren. Es unterstützt schnelle Entwicklung, Bereitstellung und Skalierung von Webanwendungen, wodurch die Verwaltung der Front-End-Komponenten des Systems erleichtert wird. |

| Azure-Funktionen | Verwenden Sie serverlose Compute, um ereignisgesteuerte Aufgaben innerhalb des RAG-Chat-Systems zu verarbeiten. Verwenden Sie sie beispielsweise, um Datenabrufprozesse auszulösen, Benutzerabfragen zu verarbeiten oder Hintergrundaufgaben wie Datensynchronisierung und Bereinigung zu verarbeiten. Es ermöglicht einen modulareren, skalierbareren Ansatz zum Erstellen des Back-End-Systems. |

Low-Code /No-Code

Alternativ können einige der logik, die von der Lösung benötigt wird, schnell erstellt und zuverlässig von Low-Code- oder No-Code-Lösungen gehostet werden.

| Produkt | Beschreibung |

|---|---|

| Azure KI Studio | Azure AI Studio könnte für Schulungen, Tests und Die Bereitstellung von benutzerdefinierten Machine Learning-Modellen verwendet werden, die das RAG-Chat-System verbessern könnten. Verwenden Sie beispielsweise Azure AI Studio, um die Reaktionsgenerierung anzupassen oder die Relevanz der abgerufenen Informationen zu verbessern. |

Vektordatenbank

Bestimmte generative KI-Lösungen erfordern möglicherweise die Speicherung und das Abrufen von Daten, die zur Erweiterung der Generierung verwendet werden (z. B. RAG-basierte Chatsysteme, mit denen Benutzer mit den Daten Ihrer Organisation chatten können). In diesem Anwendungsfall benötigen Sie einen Vektordatenspeicher.

| Produkt | Beschreibung |

|---|---|

| Azure AI Search | Dieser Dienst kann zum effizienten Durchsuchen großer Datasets verwendet werden, um relevante Informationen zu finden, die verwendet werden können, um die von den Sprachmodellen generierten Antworten zu informieren. Es ist nützlich für die Abrufkomponente eines RAG-Systems, sicherzustellen, dass die generierten Antworten so informativ und kontextbezogen wie möglich sind. |

| Cosmos DB | Dieser global verteilte, multimodellbasierte Datenbankdienst könnte die großen Mengen strukturierter und unstrukturierter Daten speichern, auf die das RAG-Chat-System zugreifen muss. Seine schnellen Lese- und Schreibfunktionen machen es ideal für die Bereitstellung von Echtzeitdaten an das Sprachmodell und das Speichern von Benutzerinteraktionen zur weiteren Analyse. |

| Azure Cache for Redis | Dieser vollständig verwaltete Speicher im Arbeitsspeicher könnte zum Zwischenspeichern häufig aufgerufener Informationen verwendet werden, wodurch die Latenz reduziert und die Leistung des RAG-Chat-Systems verbessert wird. Es ist besonders nützlich, Sitzungsdaten, Benutzereinstellungen und allgemeine Abfragen zu speichern. |

| Azure Database for PostgreSQL – Flexibler Server | Dieser verwaltete Datenbankdienst kann Anwendungsdaten speichern, einschließlich Protokollen, Benutzerprofilen und historischen Chatdaten. Seine Flexibilität und Skalierbarkeit unterstützen die dynamischen Anforderungen eines RAG-Chat-Systems, um sicherzustellen, dass Daten konsistent verfügbar und sicher sind. |

Jeder dieser Azure-Dienste trägt zur Erstellung einer umfassenden, skalierbaren und effizienten Architektur für eine generative KI-Lösung bei, sodass Entwickler die besten Cloudfunktionen und KI-Technologien von Azure nutzen können.

Codeorientierte generative KI-Entwicklung mit der Azure OpenAI-API

In diesem Abschnitt konzentrieren wir uns auf die Azure OpenAI-API. Wie bereits erwähnt, greifen Sie programmgesteuert über eine RESTful-Web-API auf DIE LLM-Funktionalität zu. Sie können buchstäblich jede moderne Programmiersprache verwenden, um diese APIs aufzurufen. In vielen Fällen gibt es sprach- oder plattformspezifische SDKs, die als "Wrapper" um die REST-API-Aufrufe arbeiten, um die Erfahrung idiomatischer zu gestalten.

- Azure OpenAI-Clientbibliothek für .NET

- Azuew OpenAI-Clientbibliothek für Java

- Azure OpenAI-Clientbibliothek für JavaScript

- Azure OpenAI-Clientmodul für Go

- Python verfügt über keine Azure-spezifische Clientbibliothek. Sie verwenden das OpenAI Python-Paket und ändern mehrere Optionen.

Wenn eine Sprache oder ein Plattform-SDK nicht verfügbar ist, besteht das Szenario im schlimmsten Fall darin, dass Sie REST-Aufrufe direkt an die Web-API tätigen müssen. Die meisten Entwickler sind jedoch mit dem Aufrufen von Web-APIs vertraut.

Azure OpenAI bietet eine Reihe von APIs, die verschiedene Arten von KI-basierten Aufgaben ermöglichen, sodass Entwickler erweiterte KI-Funktionen in ihre Anwendungen integrieren können. Hier ist eine Übersicht über die wichtigsten APIs, die in OpenAI verfügbar sind:

- API für Chatvervollständigungen: Diese API konzentriert sich auf Szenarien zur Textgenerierung, einschließlich Unterhaltungsfunktionen, wodurch die Erstellung von Chatbots und virtuellen Assistenten ermöglicht wird, die sich an natürlichen, menschlichen Dialogen beteiligen können. Es ist für interaktive Anwendungsfälle optimiert, einschließlich Kundensupport, persönlicher Assistent und interaktiver Lernumgebungen. Es wird jedoch auch für alle Textgenerierungsszenarien verwendet, einschließlich Zusammenfassung, AutoVervollständigen, Schreiben von Dokumenten, Analysieren von Text, Übersetzung usw. Dies ist der Einstiegspunkt für Die Vision-Funktionen, die sich derzeit in der Vorschau befinden (also ein Bild hochladen und Fragen dazu stellen).

- Moderations-API: Diese API wurde entwickelt, um Entwicklern zu helfen, potenziell schädliche Inhalte innerhalb von Text zu identifizieren und herauszufiltern, und stellt ein Tool bereit, um sicherere Benutzerinteraktionen zu gewährleisten, indem sie anstößiges, unsicheres oder anderweitig unangemessenes Material automatisch erkennen.

- Einbettungs-API: Die Einbettungs-API generiert Vektordarstellungen von Texteingaben, konvertieren Wörter, Sätze oder Absätze in hochdimensionale Vektoren. Diese Einbettungen können für semantische Suche, Clustering, Inhaltsähnlichkeitsanalyse und vieles mehr verwendet werden. Er erfasst die zugrunde liegende Bedeutung und semantische Beziehungen im Text.

- Bildgenerierungs-API: Mit dieser API können Sie originale, qualitativ hochwertige Bilder und Grafiken aus Textbeschreibungen generieren. Es basiert auf openAI's DALL· E-Modell, das Bilder erstellen kann, die einer vielzahl von Stilen und Themen entsprechen, basierend auf den empfangenen Eingabeaufforderungen.

- Audio-API: Diese API bietet Zugriff auf das Audiomodell von OpenAI, das für die automatische Spracherkennung entwickelt wurde. Sie kann gesprochene Sprache in Text oder Text in Sprache transkribieren und dabei verschiedene Sprachen und Dialekte unterstützen. Es ist nützlich für Anwendungen, die Sprachbefehle, Audioinhaltetranskription und vieles mehr erfordern.

Während generative KI verwendet werden kann, um mit vielen verschiedenen Medienmodalitäten zu arbeiten, verbringen wir den Rest dieses Artikels, der sich auf textbasierte generative KI-Lösungen konzentriert. Dies umfasst Szenarien wie Chat, Zusammenfassung usw.

So beginnen Sie mit der Entwicklung von Anwendungen mit generativer KI

Softwareentwickler, die mit einer unbekannten Sprache, API oder Technologie noch nicht vertraut sind, beginnen in der Regel mit den Lernprogrammen oder Schulungsmodulen, um kleine Anwendungen zu erstellen. Einige Softwareentwickler bevorzugen einen selbstgeführten Ansatz und erstellen kleine experimentelle Anwendungen. Beide Ansätze sind gültig und nützlich.

Wenn Sie beginnen, ist es am besten, klein zu beginnen, wenig zu versprechen, zu iterieren und Ihr Verständnis und Ihre Fähigkeiten zu entwickeln, da die Entwicklung mit generativen KI einzigartige Herausforderungen darstellt. In der herkömmlichen Softwareentwicklung können Sie sich beispielsweise auf deterministische Ausgabe verlassen – für jeden Satz von Eingaben können Sie jedes Mal genau dieselbe Ausgabe erwarten. Generative ist jedoch nicht deterministisch – Sie erhalten nie die genaue Antwort zweimal für eine bestimmte Eingabeaufforderung, die sich an der Wurzel vieler neuer Herausforderungen befindet. Berücksichtigen Sie bei den ersten Schritten die folgenden Tipps, bevor Sie zu weit kommen:

Tipp Nr. 1: Machen Sie sich klar, was Sie erreichen möchten.

- Erhalten Sie spezifische Informationen zu dem Problem, das Sie lösen möchten: Generative KI kann eine vielzahl von Problemen lösen, aber der Erfolg kommt aus der eindeutigen Definition des spezifischen Problems, das Sie lösen möchten. Versuchen Sie, Text, Bilder, Code oder etwas anderes zu generieren? Je spezifischer Sie sind, desto besser können Sie die KI an Ihre Bedürfnisse anpassen.

- Verstehen Sie Ihre Zielgruppe: Wenn Sie Ihre Zielgruppe kennen, können Sie die Ergebnisse der KI an ihre Erwartungen anpassen, ganz gleich, ob es sich um zufällige Benutzer oder Experten in einem bestimmten Bereich handelt.

Tipp Nr. 2: Spielen Sie die Stärken der LLMs.

- Verstehen Sie die Einschränkungen und Voreingenommenheiten von LLMs: Während LLMs leistungsfähig sind, haben sie Einschränkungen und inhärente Verzerrungen. Wenn Sie die Einschränkungen und Voreingenommenheiten kennen, können Sie sich um sie herum entwerfen oder Gegenmaßnahmen integrieren.

- Verstehen, wo LLMs excel: LLMs excel at tasks like content creation, summaryzation, language translation, and so on. Während ihre Entscheidungsfindungsfunktionen und diskriminativen Funktionen bei jeder neuen Version stärker werden, kann es andere Arten von KI geben, die für Ihr Szenario oder Ihren Anwendungsfall besser geeignet sind. Wählen Sie das richtige Tool für den Auftrag aus.

Tipp Nr. 3: Die besten Ergebnisse beginnen mit guten Eingabeaufforderungen.

- Lernen Sie bewährte Methoden für das Prompt Engineering kennen: Das Erstellen effektiver Eingabeaufforderungen ist eine Kunst. Experimentieren Sie mit verschiedenen Eingabeaufforderungen, um zu sehen, wie sie sich auf die Ausgabe auswirken. Seien Sie prägnant, aber beschreibend.

- Commit für iterative Einschränkung: Häufig liefert die erste Eingabeaufforderung möglicherweise nicht das gewünschte Ergebnis. Es ist ein Prozess der Testversion und des Fehlers. Verwenden Sie die Ausgaben, um Ihre Eingabeaufforderungen weiter zu verfeinern.

Erstellen Ihrer ersten generativen KI-Lösung

Wenn Sie sofort mit dem Erstellen einer generativen KI-Lösung experimentieren möchten, empfehlen wir, einen Blick auf "Erste Schritte mit dem Chat" mit Ihrem eigenen Datenbeispiel für Python zu werfen. Es gibt versionen des Lernprogramms auch in .NET, Java und JavaScript.

Abschließende Überlegungen, die Ihre Entscheidungen im Anwendungsentwurf beeinflussen können

Im Folgenden finden Sie eine kurze Liste der Punkte, die Sie berücksichtigen sollten, und andere Punkte aus diesem Artikel, die sich auf Ihre Entscheidungen im Anwendungsentwurf auswirken:

- Definieren Sie den Problemraum und die Zielgruppe deutlich, um die Funktionen der KI an die Erwartungen der Benutzer anzupassen und die Effektivität der Lösung für den vorgesehenen Anwendungsfall zu optimieren.

- Verwenden Sie Low-Code-/No-Code-Plattformen für schnelle Prototypen und Entwicklung, wenn sie die Anforderungen Ihres Projekts erfüllen und den Kompromiss zwischen Entwicklungsgeschwindigkeit und Anpassbarkeit bewerten. Erkunden Sie die Möglichkeiten von Low-Code- und No-Code-Lösungen für Teile Ihrer Anwendung, um die Entwicklung zu beschleunigen und nicht-technische Teammitgliedern den Beitrag zum Projekt zu ermöglichen.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Tickets als Feedbackmechanismus für Inhalte auslaufen lassen und es durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter: https://aka.ms/ContentUserFeedback.

Einreichen und Feedback anzeigen für