Inhaltsfilterung in Azure KI Studio

Wichtig

Einige der in diesem Artikel beschriebenen Features sind möglicherweise nur in der Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Azure KI Studio beinhaltet ein Inhaltsfiltersystem, das mit Kernmodellen und DALL-E-Bildgenerierungsmodellen zusammenarbeitet.

Wichtig

Das Inhaltsfiltersystem wird nicht auf Eingabeaufforderungen und Vervollständigungen angewendet, die vom Whisper-Modell in Azure OpenAI Service verarbeitet werden. Erfahren Sie mehr über das Whisper-Modell in Azure OpenAI.

Funktionsweise

Dieses Inhaltsfiltersystem wird von Azure KI Inhaltssicherheit unterstützt und funktioniert jetzt, indem sowohl die Prompteingabe als auch die Vervollständigungsausgabe durch ein Ensemble von Klassifizierungsmodellen ausgeführt wird, das darauf abzielt, die Ausgabe schädlicher Inhalte zu erkennen und zu verhindern. Variationen in API-Konfigurationen und Anwendungsentwurf können sich auf Vervollständigungen und somit auf das Filterverhalten auswirken.

Mit Azure OpenAI-Modellbereitstellungen können Sie den Standardinhaltsfilter verwenden oder Ihren eigenen Inhaltsfilter erstellen (weiter unten beschrieben). Der Standardinhaltsfilter ist auch für andere Textmodelle verfügbar, die von Azure KI im Modellkatalog zusammengestellt wurden, aber benutzerdefinierte Inhaltsfilter sind für diese Modelle noch nicht verfügbar. Modelle, die über Models-as-a-Service verfügbar sind, verfügen über standardmäßig aktivierte Inhaltsfilterung und können nicht konfiguriert werden.

Sprachunterstützung

Die Inhaltsfiltermodelle wurden für die folgenden Sprachen trainiert und getestet: Englisch, Deutsch, Japanisch, Spanisch, Französisch, Italienisch, Portugiesisch und Chinesisch. Der Dienst kann jedoch in vielen anderen Sprachen funktionieren, die Qualität kann jedoch variieren. In allen Fällen sollten Sie eigene Tests durchführen, um sicherzustellen, dass es für Ihre Anwendung funktioniert.

Erstellen eines Inhaltsfilters

Für jede Modellbereitstellung in Azure KI Studio können Sie direkt den Standard-Inhaltsfilter verwenden, aber Sie sollten vielleicht mehr Kontrolle haben. So können Sie z. B. einen Filter strenger oder lascher gestalten oder erweiterte Funktionen wie Prompt Shields und die Erkennung von geschütztem Material aktivieren.

Führen Sie folgende Schritte aus, um einen Inhaltsfilter zu erstellen:

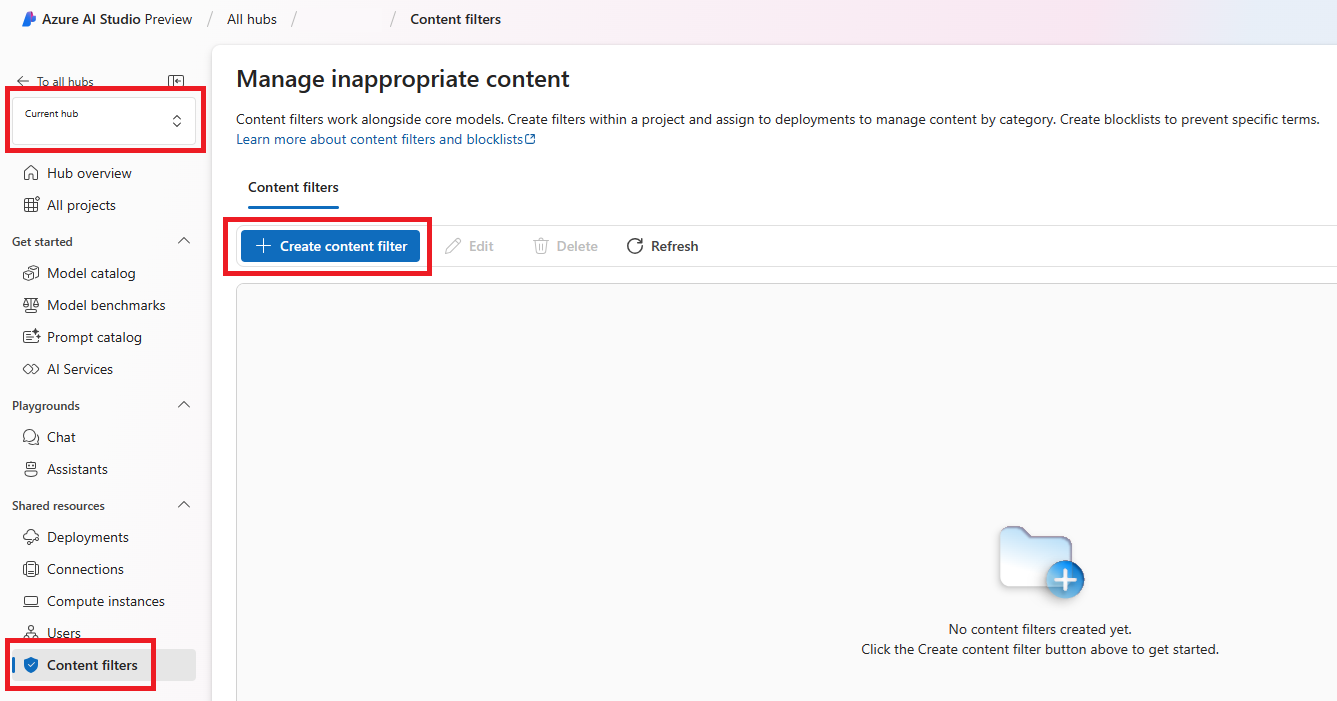

Wechseln Sie zu KI Studio, und navigieren Sie zu Ihrem Hub. Wählen Sie dann auf der linken Navigationsleiste die Registerkarte Inhaltsfilter und dann die Schaltfläche Inhaltsfilter erstellen aus.

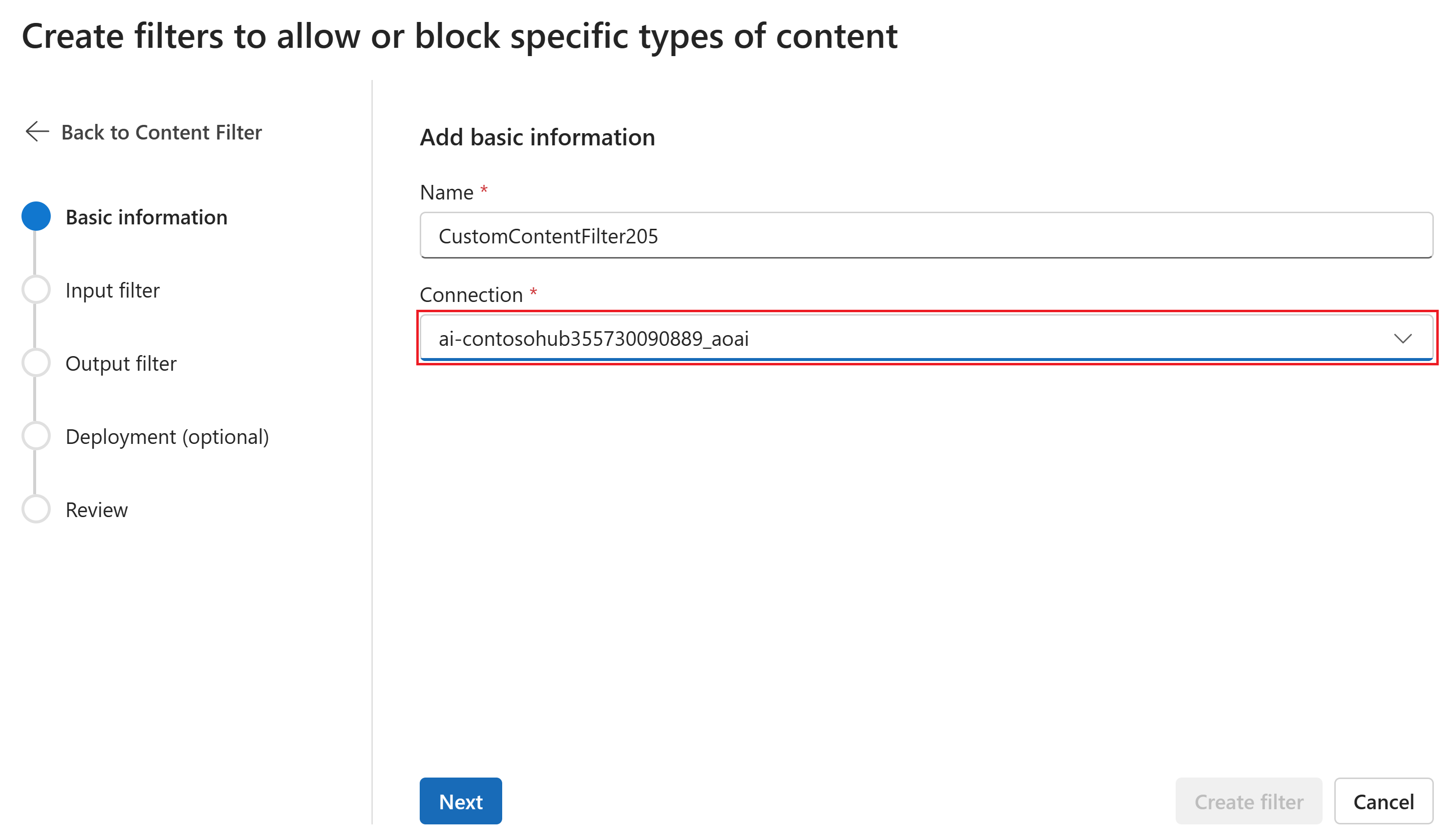

Geben Sie auf der Seite Grundlegende Informationen einen Namen für den Inhaltsfilter ein. Wählen Sie eine Verbindung aus, die dem Inhaltsfilter zugeordnet werden soll. Wählen Sie Weiteraus.

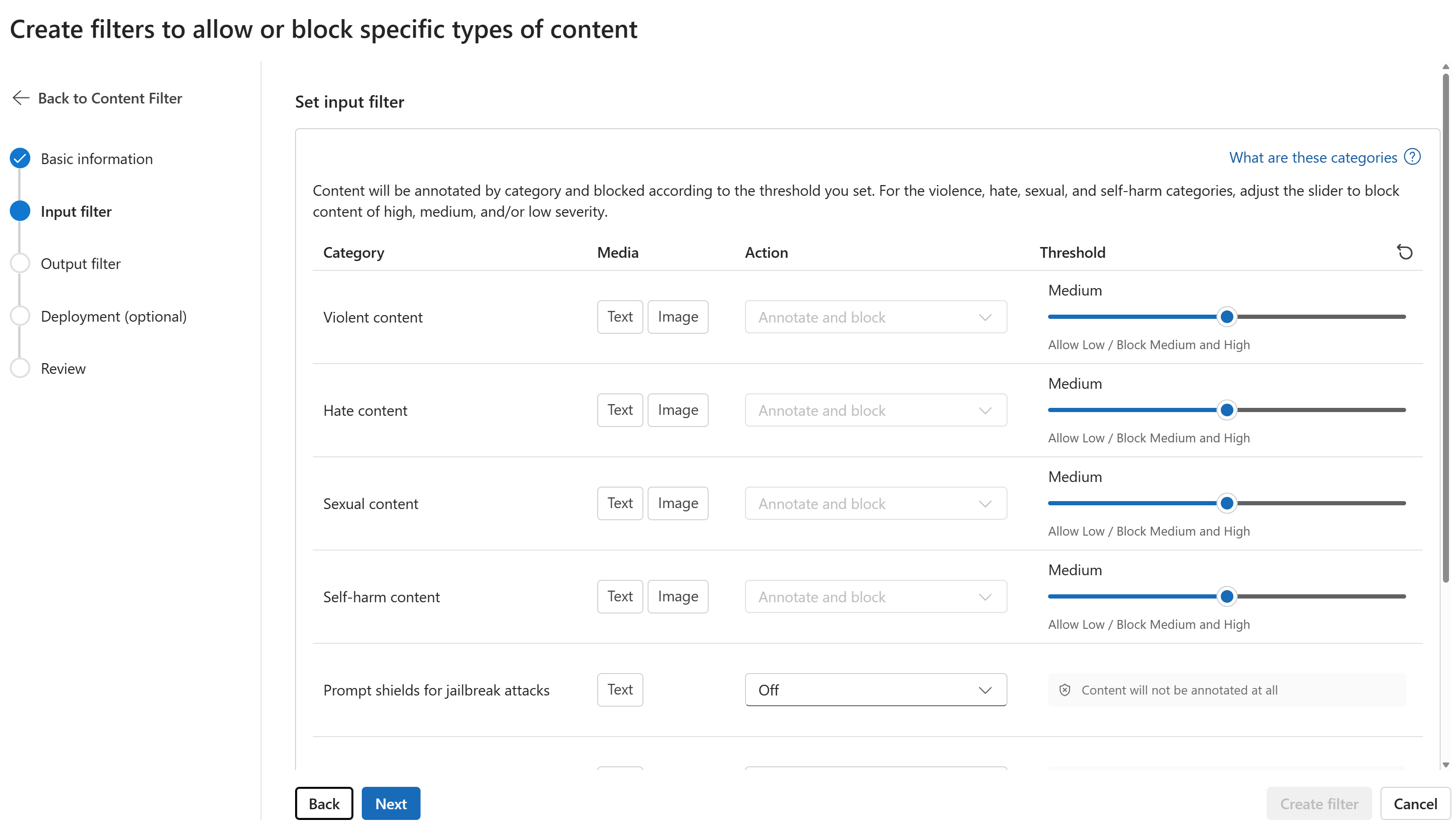

Auf der Seite Eingabefilter können Sie den Filter für den Eingabeprompt festlegen. Legen Sie für jeden Filtertyp die Aktion und den Schwellenwert für den Schweregrad fest. Sie konfigurieren auf dieser Seite sowohl die Standardfilter als auch andere Filter (z. B. Prompt Shields für Jailbreak-Angriffe). Wählen Sie Weiteraus.

Inhalte werden nach Kategorie kommentiert und entsprechend dem von Ihnen festgelegten Schwellenwert blockiert. Passen Sie den Schieberegler der Kategorien für Gewalt, Hass, Sexualität und Selbstverletzung an, um Inhalte mit hohem, mittlerem oder geringem Schweregrad zu blockieren.

Auf der Seite Ausgabefilter können Sie den Ausgabefilter konfigurieren, der auf alle Ausgabeinhalte angewendet wird, die von Ihrem Modell generiert werden. Konfigurieren Sie die einzelnen Filter wie zuvor. Diese Seite bietet auch die Option „Streamingmodus“, mit der Sie Inhalte nahezu in Echtzeit filtern können, während sie vom Modell generiert werden, wodurch die Wartezeit reduziert wird. Wählen Sie anschließend Weiter aus.

Inhalte werden nach den einzelnen Kategorien kommentiert und entsprechend dem Schwellenwert blockiert. Passen Sie bei der Kategorie für gewalttätige Inhalte, Hassinhalte, sexuelle Inhalte und Inhalte mit Bezug auf Selbstverletzung den Schwellenwert an, um schädliche Inhalte mit gleichem oder höherem Schweregrad zu blockieren.

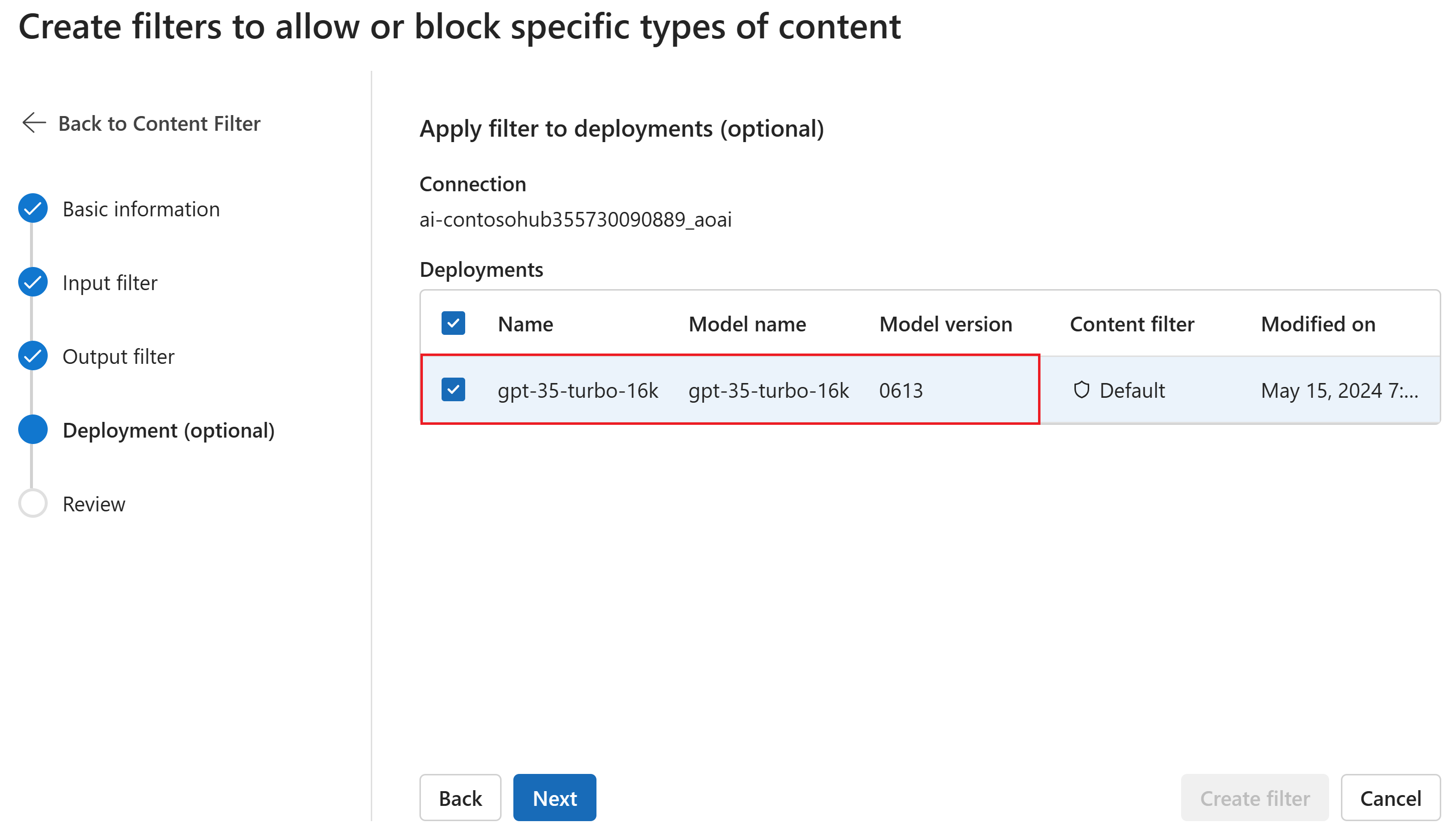

Optional können Sie auf der Seite Bereitstellung den Inhaltsfilter einer Bereitstellung zuordnen. Wenn eine ausgewählte Bereitstellung bereits über einen Filter verfügt, müssen Sie bestätigen, dass Sie ihn ersetzen möchten. Sie können den Inhaltsfilter auch später einer Bereitstellung zuordnen. Klicken Sie auf Erstellen.

Inhaltsfilterkonfigurationen werden auf Hubebene in KI Studio erstellt. In der Azure OpenAI-Dokumentation erfahren Sie mehr über die Konfigurierbarkeit.

Überprüfen Sie auf der Registerkarte Überprüfen Ihre Einstellungen, und wählen Sie dann Filter erstellen aus.

Verwenden einer Blockliste als Filter

Sie können eine Sperrliste entweder als Eingabe- oder Ausgabefilter oder als beides anwenden. Aktivieren Sie die Option Sperrliste auf der Seite Eingabefilter und/oder auf der Seite Ausgabefilter. Wählen Sie eine oder mehrere Sperrlisten aus dem Dropdown-Menü aus oder verwenden Sie die integrierte Sperrliste für Obszönitäten. Sie können mehrere Sperrlisten im selben Filter kombinieren.

Anwenden eines Inhaltsfilters

Der Prozess der Filtererstellung bietet Ihnen die Möglichkeit, den Filter auf die gewünschten Bereitstellungen anzuwenden. Sie können Inhaltsfilter auch jederzeit ändern oder aus Ihren Bereitstellungen entfernen.

Führen Sie die folgenden Schritte aus, um einen Inhaltsfilter auf eine Bereitstellung anzuwenden:

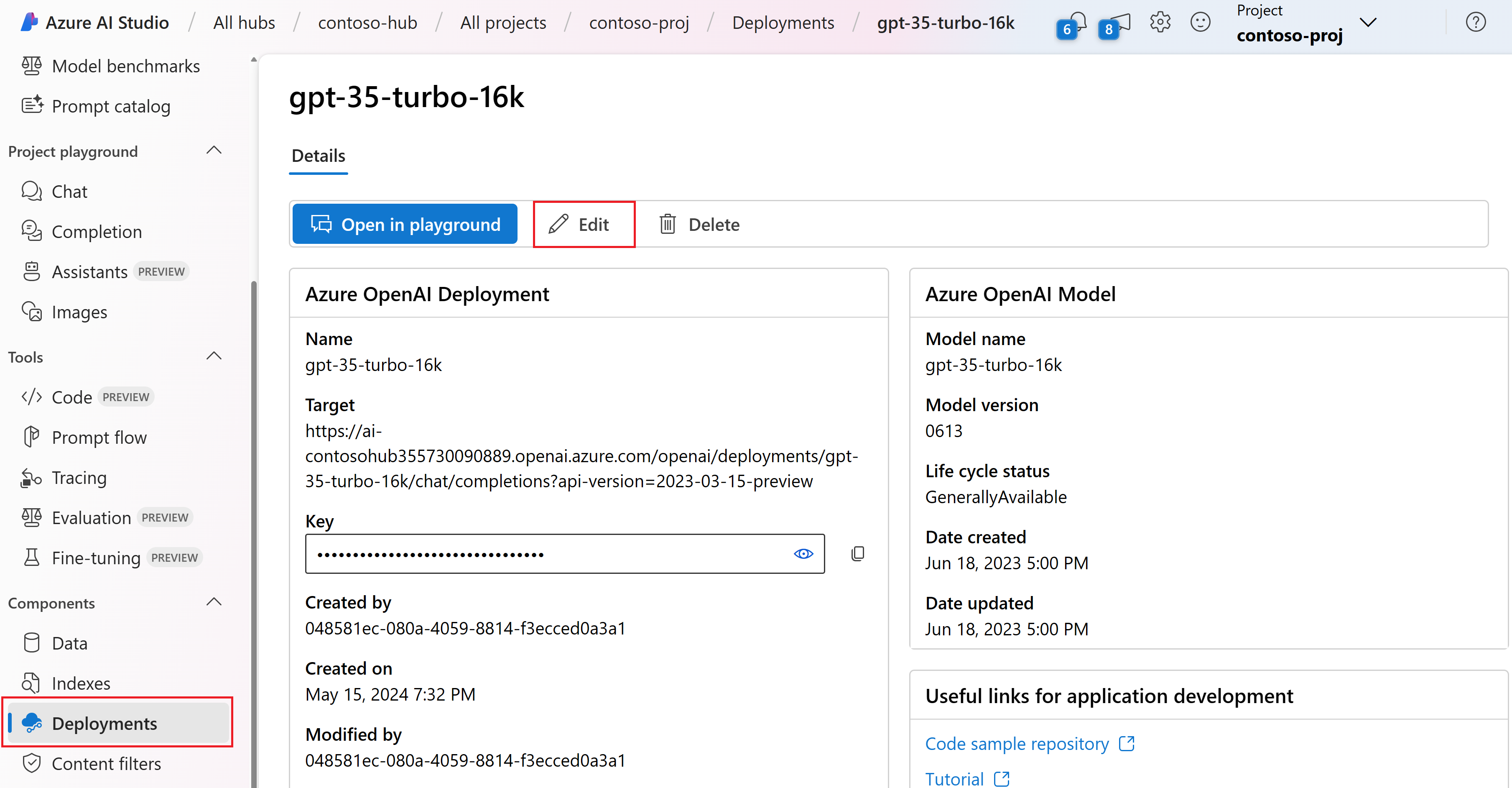

Navigieren Sie zu KI Studio, und wählen Sie ein Projekt aus.

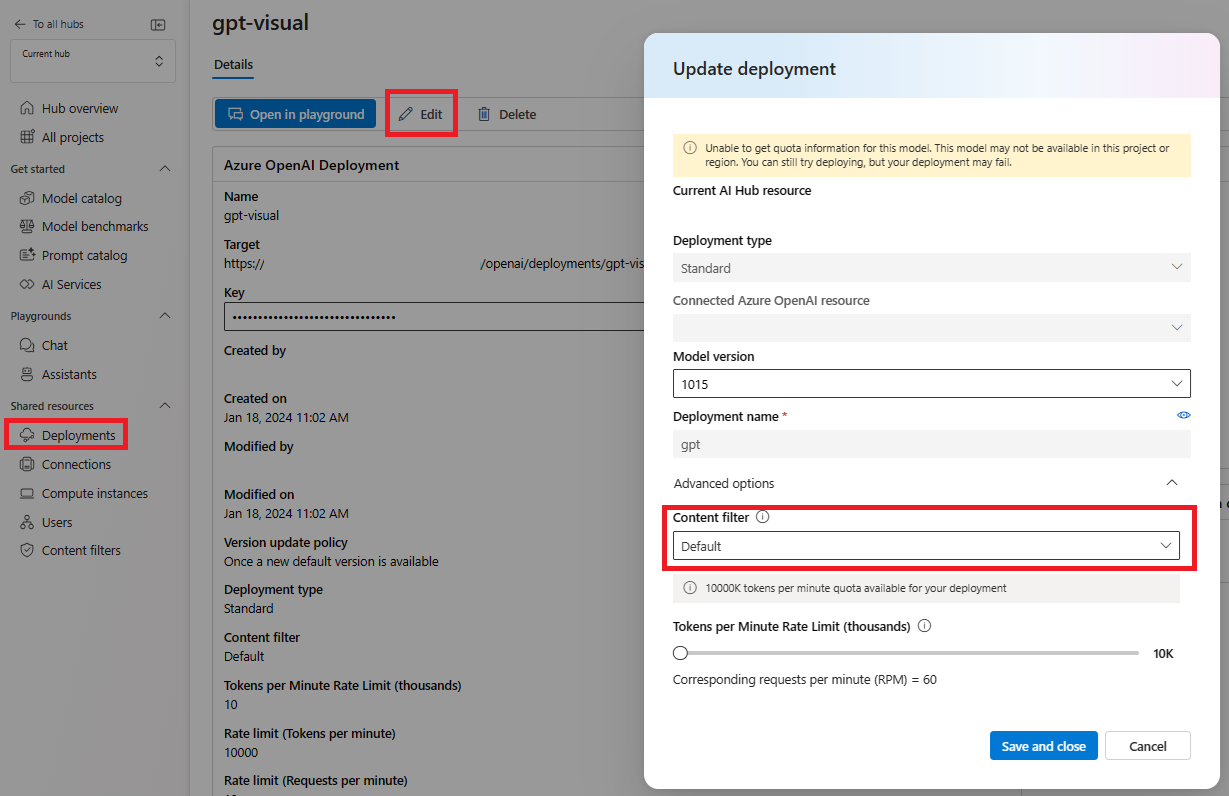

Wählen Sie Bereitstellungen und dann eine Ihrer Bereitstellungen aus. Wählen Sie anschließend Bearbeiten aus.

Wählen Sie im Fenster Bereitstellung aktualisieren den Inhaltsfilter aus, den Sie auf die Bereitstellung anwenden möchten.

Jetzt können Sie zum Playground wechseln, um zu testen, ob der Inhaltsfilter wie erwartet funktioniert.

Kategorien

| Category | BESCHREIBUNG |

|---|---|

| Hass | Die Kategorie „Hass“ beschreibt sprachliche Angriffe oder Verwendungen, die abwertende oder diskriminierende Ausdrücke in Bezug auf eine Person oder eine Identitätsgruppe auf der Grundlage bestimmter differenzierender Merkmale dieser Gruppen enthalten, einschließlich, aber nicht beschränkt auf Rasse, ethnische Zugehörigkeit, Nationalität, Geschlechtsidentität und -ausdruck, sexuelle Orientierung, Religion, Einwanderungsstatus, Fähigkeitsstatus, persönliches Aussehen und Körpergröße. |

| Sexuell | Die Kategorie „Sexuell“ beschreibt Sprache, die sich auf anatomische Organe und Genitalien, romantische Beziehungen, erotisch oder zärtlich dargestellte Akte, körperliche sexuelle Akte – einschließlich solcher Akte, die als Übergriff oder erzwungener sexueller Gewaltakt gegen den eigenen Willen dargestellt werden –, Prostitution, Pornografie und Missbrauch bezieht. |

| Gewalt | Die Kategorie „Gewalt“ beschreibt die Sprache im Zusammenhang mit körperlichen Handlungen, die dazu dienen, jemanden oder etwas zu verletzen, zu beschädigen oder zu töten bzw. die Waffen usw. beschreibt. |

| Selbstverletzung | Die Kategorie „Selbstverletzung“ beschreibt Sprache, die sich auf körperliche Handlungen bezieht und darauf abzielt, den eigenen Körper absichtlich zu verletzen, zu verwunden oder zu schädigen oder sich selbst zu töten. |

Schweregrade

| Category | BESCHREIBUNG |

|---|---|

| Safe | Der Inhalt kann sich auf die Kategorien Gewalt, Selbstbeschädigung, Sexualität oder Hass beziehen, aber es werden Begriffe in allgemeinen, journalistischen, wissenschaftlichen, medizinischen und ähnlichen professionellen Kontexten verwendet, die für die meisten Zielgruppen angemessen sind. |

| Niedrig | Inhalte, die voreingenommene, urteilende oder dogmatische Ansichten zum Ausdruck bringen, umfassen anstößige Verwendung von Sprache, Stereotypisierung, Anwendungsfälle, die eine fiktive Welt erkunden (z. B. Spiele, Literatur) und Darstellungen mit geringer Intensität. |

| Medium | Inhalte, die sich einer beleidigenden, beleidigenden, verhöhnenden, einschüchternden oder erniedrigenden Sprache gegenüber bestimmten Identitätsgruppen bedienen, einschließlich Darstellungen der Suche nach und der Ausführung von schädlichen Anweisungen, Phantasien, Verherrlichung, Förderung von Schaden in mittlerer Intensität. |

| Hoch | Inhalte, die explizite und schwerwiegende schädliche Anweisungen, Handlungen, Schäden oder Missbrauch zeigen; dazu gehören die Befürwortung, Verherrlichung oder Förderung von schwerwiegenden schädlichen Handlungen, extremen oder illegalen Formen der Schädigung, Radikalisierung oder nicht-einvernehmlicher Machtaustausch oder Missbrauch. |

Konfigurierbarkeit (Vorschau)

Die Inhaltsfilterkonfiguration für die GPT-Modellreihe ist standardmäßig so festgelegt, dass alle vier Kategorien schädlicher Inhalte (Hass, Gewalt, Sexualität, Selbstverletzung) mit mittlerem Schweregrad gefiltert werden. Sie gilt sowohl für Prompts (Text, multimodale Texte/Bilder) als auch für Vervollständigungen (Text). Das bedeutet, dass Inhalte, die mit dem Schweregrad „Mittel“ oder „Hoch“ erkannt werden, gefiltert werden, während Inhalte, die mit dem Schweregrad „Niedrig“ erkannt werden, nicht von den Inhaltsfiltern gefiltert werden. Bei DALL-E wird der standardmäßige Schwellenwert für den Schweregrad sowohl für Prompt (Text) als auch für Vervollständigungen (Bilder) auf „Niedrig“, „Mittel“ oder „Hoch“ festgelegt. Daher werden erkannte Inhalte mit dem Schweregrad „Niedrig“, „Mittel“ oder „Hoch“ gefiltert. Das Konfigurierbarkeitsfeature ist in der Vorschau verfügbar und ermöglicht es Kunden, die Einstellungen separat für Eingabeaufforderungen und Vervollständigungen anzupassen, um Inhalte wie in der folgenden Tabelle beschrieben für jede Inhaltskategorie mit unterschiedlichen Schweregraden zu filtern:

| Gefilterter Schweregrad | Konfigurierbar für Eingabeaufforderungen | Konfigurierbar für Vervollständigungen | Beschreibungen |

|---|---|---|---|

| Niedrig, mittel, hoch | Ja | Ja | Strengste Filterkonfiguration. Mit den Schweregraden „Niedrig“, „Mittel“ und „Hoch“ erkannte Inhalte werden gefiltert. |

| Mittel, Hoch | Ja | Ja | Mit dem Schweregrad „Niedrig“ erkannte Inhalte werden nicht gefiltert, Inhalte mit mittlerem und hohem Schweregrad werden gefiltert. |

| Hoch | Ja | Ja | Mit den Schweregraden „Niedrig“ und „Mittel“ erkannte Inhalte werden nicht gefiltert. Nur Inhalte mit hohem Schweregrad werden gefiltert. Genehmigung erforderlich1. |

| Keine Filter | Falls genehmigt1 | Falls genehmigt1 | Unabhängig vom erkannten Schweregrad wird kein Inhalt gefiltert. Genehmigung erforderlich1. |

1 Für Azure OpenAI-Modelle haben diejenigen die vollständige Kontrolle über die Inhaltsfilterung, einschließlich der Konfiguration von Inhaltsfiltern mit nur hohem Schweregrad oder Deaktivierung von Inhaltsfiltern, die für die Filterung von geänderten Inhalten zugelassen wurden. Beantragen von geänderten Inhaltsfiltern über dieses Formular: Azure OpenAI Limited Access Review: Modified Content Filters and Abuse Monitoring (microsoft.com) (Überprüfung des eingeschränkten Zugriffs in Azure OpenAI: Geänderte Inhaltsfilter und Missbrauchsüberwachung [microsoft.com])

Kunden sind dafür verantwortlich, sicherzustellen, dass Anwendungen, die Azure OpenAI integrieren, den Verhaltenskodex einhalten.

Andere Eingabefilter

Sie können auch spezielle Filter für Szenarien mit generativer KI aktivieren:

- Jailbreak-Angriffe sind Benutzer-Prompts, die darauf abzielen, ein Verhalten des generativen KI-Modells zu provozieren, für dessen Vermeidung es trainiert wurde, oder gegen die in der Systemnachricht festgelegten Regeln zu verstoßen.

- Indirekte Angriffe: Indirekte Angriffe, die auch als indirekte Promptangriffe oder domänenübergreifende Prompteinschleusungsangriffe bezeichnet werden, sind ein potenzielles Sicherheitsrisiko, bei dem Dritte böswillige Anweisungen innerhalb von Dokumenten platzieren, auf die das generative KI-System zugreifen und die es verarbeiten kann.

Andere Ausgabefilter

Sie können auch die folgenden speziellen Ausgabefilter aktivieren:

- Geschütztes Material für Text: Geschützter Materialtext beschreibt bekannte Textinhalte (z. B. Liedtexte, Artikel, Rezepte und ausgewählte Webinhalte), die von großen Sprachmodellen ausgegeben werden können.

- Geschütztes Material für Code: Geschützter Materialcode beschreibt Quellcode, der Quellcode aus öffentlichen Repositorys entspricht, der von großen Sprachmodellen ohne ordnungsgemäße Nennung von Quellrepositorys ausgegeben werden kann.

- Quellenübereinstimmung: Die Quellenübereinstimmungserkennungs-API erkennt, ob die Textantworten großer Sprachmodelle (LLMs) von den durch Benutzer bereitgestellten Quellmaterialien gestützt werden.

Nächste Schritte

- Erfahren Sie mehr über die zugrunde liegenden Modelle, auf denen Azure OpenAI basiert.

- Die Azure KI Studio-Inhaltsfilterung wird von Azure KI Inhaltssicherheit unterstützt.

- Erfahren Sie mehr über das Verstehen und Minimieren von Risiken im Zusammenhang mit Ihrer Anwendung: Übersicht über Methoden für verantwortungsvolle KI für Azure OpenAI-Modelle.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Tickets als Feedbackmechanismus für Inhalte auslaufen lassen und es durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter: https://aka.ms/ContentUserFeedback.

Einreichen und Feedback anzeigen für