Anmerkung

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen, dich anzumelden oder die Verzeichnisse zu wechseln.

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen , die Verzeichnisse zu wechseln.

In diesem Artikel wird erläutert, wie Sie die Modellversion und die Einstellungen im Prompt Builder ändern. Die Modellversion und die Einstellungen können sich auf die Leistung und das Verhalten des generativen KI-Modells auswirken.

Modellauswahl

Sie können das Modell ändern, indem Sie oben im Prompt-Builder Modell auswählen. Im Dropdown-Menü können Sie aus den generativen KI-Modellen auswählen, die Antworten auf Ihre benutzerdefinierte Eingabeaufforderung generieren.

Bei der Verwendung von Prompts in Power Apps oder Power Automate wird Promptgenerator-Guthaben in Anspruch genommen, während die Verwendung von Prompts in Microsoft Copilot Studio Copilot-Guthaben verbraucht. Weitere Informationen finden Sie unter Lizenzierung und Promptgenerator-Guthaben.

Überblick

Die folgende Tabelle beschreibt die verschiedenen verfügbaren Modelle.

| GPT-Modell | Lizenzierung | Funktionalitäten | Kateg. |

|---|---|---|---|

| GPT-4.1 mini (Standardmodell) |

Basistarif | Trainiert mit Daten bis Juni 2024. Geben Sie bis zu 128.000 Token ein. | Mini |

| GPT-4.1 | Standardtarif | Trainiert mit Daten bis Juni 2024. Kontext erlaubt bis zu 128.000 Token. | Allgemein |

| GPT-5-Chat | Standardtarif | Trainiert mit Daten bis September 2024. Kontext erlaubt bis zu 128.000 Token. | Allgemein |

| GPT-5-Reasoning | Premiumtarif | Trainiert mit Daten bis September 2024. Kontext erlaubt bis zu 400.000 Token. | Tief |

| GPT-5.2 Chat (Experimentell) | Standardtarif | Kontext erlaubt bis zu 128.000 Token. | Allgemein |

| GPT-5.2-Schlussfolgerung (Experimentelle) | Premiumtarif | Trainiert mit Daten bis Oktober 2024. Kontext erlaubt bis zu 400.000 Token. | Tief |

| Claude Sonett 4.5 (Experimentell) | Standardtarif | Externes Modell von Anthropic. Der Kontext erlaubt bis zu 200.000 Token. | Allgemein |

| Claude Opus 4.1 (Experimentell) | Premiumtarif | Externes Modell von Anthropic. Der Kontext erlaubt bis zu 200.000 Token. | Tief |

GPT-4o mini und GPT-4o werden weiterhin in US Gov-Regionen verwendet. Diese Modelle folgen den Lizenzierungsregeln und bieten Funktionen, die mit GPT-4.1 mini and GPT-4.1 vergleichbar sind.

Die Verfügbarkeit der Modelle variiert je nach Region. Erfahren Sie mehr über die Modellverfügbarkeit in Modellverfügbarkeit nach Region.

Anthropische Modelle werden außerhalb von Microsoft gehostet und unterliegen anthropopischen Bedingungen und Datenverarbeitung. Weitere Informationen über externe Anthropic-Modelle finden Sie unter Externes Modell als primäres KI-Modell auswählen.

Lizenzierung

In Agents, Flows oder Apps, die von Prompts verwendet werden, wird Copilot-Guthaben verbraucht, unabhängig von ihrer Veröffentlichungsphase. Weitere Informationen finden Sie unter Copilot-Guthabenverwaltung.

Wenn du AI-Builder-Credits hast, werden sie prioritär verbraucht, wenn Prompts in Power Apps und Power Automate verwendet werden. Sie werden nicht verbraucht, wenn Prompts in Copilot Studio verwendet werden. Weitere Informationen finden Sie unter AI Builder: Übersicht über die Lizenzierung.

Veröffentlichungsphasen

Modelle weisen unterschiedliche Phasen der Veröffentlichung auf. Sie können neue, hochmoderne Modelle in der Prüfung und Modelle in der Vorschauversion ausprobieren oder ein zuverlässiges, gründlich getestetes, allgemein verfügbares Modell wählen.

| Tag | Beschreibung des Dataflows |

|---|---|

| Experimentell | Wird zum Experimentieren verwendet; nicht für den Produktionseinsatz empfohlen. Vorbehaltlich von Vorschauversionsbedingungen; Einschränkungen hinsichtlich Verfügbarkeit und Qualität möglich. |

| Vorschauversion | Wird letztlich zu einem allgemein verfügbaren Modell; derzeit jedoch nicht für den Produktionseinsatz empfohlen. Vorbehaltlich von Vorschauversionsbedingungen; Einschränkungen hinsichtlich Verfügbarkeit und Qualität möglich. |

| Kein Tag | Allgemein verfügbar. Sie können dieses Modell für den skalierten und produktiven Einsatz verwenden. In den meisten Fällen haben allgemein verfügbare Modelle keine Einschränkungen hinsichtlich Verfügbarkeit und Qualität, bei einigen gibt es jedoch möglicherweise trotzdem noch einige Einschränkungen, z. B. bezüglich der regionalen Verfügbarkeit. Wichtig: Anthropic Claude-Modelle befinden sich in der Prüfungsphase, obwohl sie kein Tag anzeigen. |

| Standard | Das Standardmodell für alle Agents und in der Regel das am besten geeignete allgemein verfügbare Modell. Das Standardmodell wird regelmäßig aktualisiert, wenn neue, fähigere Modelle allgemein verfügbar werden. Agents verwenden auch das Standardmodell als Fallback, wenn ein ausgewähltes Modell deaktiviert wird oder nicht verfügbar ist. |

Modelle in der Prüfung und Modelle in der Vorschauversion können Schwankungen in der Leistung, der Antwortqualität, der Latenz oder dem Nachrichtenverbrauch aufweisen und möglicherweise eine Zeitüberschreitung verursachen oder nicht verfügbar sein. Sie unterliegen den Bedingungen für Vorschauversionen.

Kategorisierung

In der folgenden Tabelle sind die unterschiedlichen Modellkategorien beschrieben.

| Mini | Allgemein | Tief | |

|---|---|---|---|

| Leistung | Gut für die meisten Aufgaben | Überlegenheit bei komplexen Aufgaben | Trainiert für Aufgaben zur Problemlösung |

| Geschwindigkeit | Schnellere Verarbeitung | Kann aufgrund der Komplexität langsamer sein | Langsamer, da er „Reasoning“ durchführt, bevor er antwortet |

| Anwendungsfälle | Zusammenfassung, Informationsaufgaben, Bild- und Dokumentenverarbeitung | Bild- und Dokumentverarbeitung, erweiterte Aufgaben zum Erstellen von Inhalten | Datenanalyse und Reasoning-Aufgaben, Bild- und Dokumentverarbeitung |

Wenn Sie eine kostengünstige Lösung für mittelkomplexe Aufgaben benötigen, über begrenzte Rechenressourcen verfügen oder eine schnellere Verarbeitung benötigen, wählen Sie Mini-Modelle Es ist ideal für Projekte mit Budgetbeschränkungen und Anwendungen wie Kundensupport oder effiziente Codeanalyse.

Wenn Sie es mit hochkomplexen, multimodalen Aufgaben zu tun haben, die eine überragende Leistung und detaillierte Analyse erfordern, wählen Sie Modelle vom Typ Allgemein. Es ist die bessere Wahl für Großprojekte, bei denen Genauigkeit und erweiterte Funktionen entscheidend sind. Ein anderes Szenario, in dem es eine bessere Wahl ist, liegt dann vor, wenn Sie über das Budget und die Rechenressourcen verfügen, um es zu unterstützen. Allgemeine Modelle sind auch für langfristige Projekte vorzuziehen, die im Laufe der Zeit an Komplexität zunehmen könnten.

Für Projekte, die erweiterte Argumentationsfähigkeiten erfordern, eignen sich Deep-Modelle hervorragend. Es eignet sich für Szenarien, die eine ausgefeilte Problemlösung und kritisches Denken erfordern. Deep-Modelle eignen sich perfekt für Umgebungen, in denen nuanciertes Reasoning, komplexe Entscheidungsfindung und detaillierte Analysen wichtig sind.

Wählen Sie zwischen den Modellen basierend auf regionaler Verfügbarkeit, Funktionen, Anwendungsfällen und Kosten aus. Erfahren Sie mehr unter Modellverfügbarkeit nach Region und Preisvergleichstabelle.

Modellverfügbarkeit nach Region

Die folgenden Abschnitte beschreiben die öffentliche und US-staatliche Verfügbarkeit von Modellen nach Regionen.

Öffentliche Verfügbarkeit

In der folgenden Tabelle bedeutet (GA), (Vorschau) oder (Experimentell), dass die Funktion zwar verfügbar ist, aber einen Azure OpenAI-Dienst in einer anderen Region verwendet. Weitere Informationen finden Sie unter Datenverschiebung zwischen Regionen aktivieren.

| Merkmal | Asia | Australien | Canada | Europa | Frankreich | Deutschland | Indien | Japan | Norwegen | Singapur | Südafrika | Südamerika | Korea | Schweden | Schweiz | Vereinigte Arabische Emirate | Vereinigtes Königreich | USA |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4.1 Mini | GA | GA | (GA) | (GA) | (GA) | (GA) | GA | (GA) | (GA) | GA | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | GA | GA |

| GPT-4.1 | GA | GA | (GA) | (GA) | (GA) | (GA) | GA | (GA) | (GA) | GA | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | GA | GA |

| GPT-5-Chat | (GA) | (GA) | (GA) | GA | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | GA |

| GPT-5-Reasoning | (GA) | (GA) | (GA) | GA | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | (GA) | GA |

| GPT-5.2 Chat | - | - | - | - | - | - | - | - | - | - | - | - | - | - | - | - | - | Experimentell |

| GPT-5.2-Argumentation | - | - | - | - | - | - | - | - | - | - | - | - | - | - | - | - | - | Experimentell |

Verfügbarkeit durch US-Regierung

| Merkmal | Government Community Cloud (GCC) | Government Community Cloud – Hoch (GCC High) | Verteidigungsministerium (DoD, Department of Defense) |

|---|---|---|---|

| GPT-4o Mini | GA | GA | - |

| GPT-4o | GA | GA | - |

| GPT-4o verwendet Bilder und Dokumente als Eingabe | - | - | - |

Modellaktualisierung

| Modell | Status | Deaktivierungstermin | Ersatz |

|---|---|---|---|

| GPT-4.1 Mini | Allgemein verfügbar | Noch kein Datum | Nicht zutreffend |

| GPT-4.1 | Allgemein verfügbar | Noch kein Datum | Nicht zutreffend |

| GPT-5-Chat | Allgemein verfügbar | Noch kein Datum | Nicht zutreffend |

| GPT-5-Reasoning | Allgemein verfügbar | Noch kein Datum | Nicht zutreffend |

| GPT-5.2 Chat | Experimentell | Noch kein Datum | Nicht zutreffend |

| GPT-5.2-Argumentation | Experimentell | Noch kein Datum | Nicht zutreffend |

| Claude Sonnet 4.5 | Experimentell | Noch kein Datum | Nicht zutreffend |

| Claude Opus 4.1 | Experimentell | Dezember 2025 | Claude Opus 4.5 |

| Claude Opus 4.5 | Ausstehende Verfügbarkeit | Noch kein Datum | Nicht zutreffend |

| o3 | Zurückgezogen | 4. Dezember 2025 | GPT-5-Reasoning |

| GPT-4o Mini | Zurückgezogen | Juli 2025 | GPT-4.1 Mini |

| GPT-4o | Zurückgezogen | Juli 2025 | GPT-4.1 |

| O1 | Zurückgezogen | Juli 2025 | o3 |

Modelleinstellungen

Du kannst auf das Einstellungsfeld zugreifen, indem du die drei Punkte auswählst (...). >Einstellungen oben im Prompt-Builder. Sie können die folgenden Einstellungen ändern:

- Temperatur: Niedrigere Temperaturen führen zu vorhersehbaren Ergebnissen. Höhere Temperaturen ermöglichen vielfältigere oder kreativere Antworten.

- Datensatz abrufen: Anzahl der Datensätze, die für Ihre Wissensquellen abgerufen wurden.

- Links in die Antwort einfügen: Wenn diese Option ausgewählt ist, enthält die Antwort Linkzitate für die abgerufenen Datensätze.

- Code-Interpreter aktivieren: Wenn ausgewählt, ist der Code-Interpreter aktiviert, um Code zu generieren und auszuführen .

- Inhaltsmoderationsniveau: Das niedrigste Level liefert die meisten Antworten, kann aber schädliche Inhalte enthalten. Das höchste Maß an Inhaltsmoderation wendet einen strengeren Filter an, um schädliche Inhalte zu begrenzen, und liefert weniger Antworten.

Temperatur

Mit dem Schieberegler können Sie die Temperatur des generativen KI-Modells auswählen. Variiert zwischen 0 und 1. Dieser Wert gibt dem GenAI-Modell vor, wie viel Kreativität (1) im Vergleich zur deterministischen Antwort (0) es liefern soll.

Anmerkung

Die Temperatureinstellung ist für das GPT-5-Reasoning-Modell nicht verfügbar. Aus diesem Grund ist der Schieberegler deaktiviert, wenn Sie das GPT-5-Reasoning-Modell auswählen.

Die Temperatur ist ein Parameter, der die Zufälligkeit der vom KI-Modell generierten Ausgabe steuert. Eine niedrigere Temperatur führt zu vorhersehbareren und konservativeren Ergebnissen. Im Vergleich dazu ermöglicht eine höhere Temperatur mehr Kreativität und Vielfalt bei den Reaktionen. Auf diese Weise lässt sich das Gleichgewicht zwischen Zufälligkeit und Determinismus in der Ausgabe des Modells feinabstimmen.

Standardmäßig ist die Temperatur 0, wie in zuvor erstellten Eingabeaufforderungen.

| Temperatur | Funktionalität | Verwenden in |

|---|---|---|

| 0 | Vorhersehbarere und konservativere Ergebnisse. Die Antworten sind konsistenter. |

Eingabeaufforderungen, die eine hohe Genauigkeit und weniger Variabilität erfordern. |

| 1 | Mehr Kreativität und Vielfalt in den Antworten. Vielfältigere und manchmal innovativere Antworten. |

Prompts, die sofort einsatzbereite neue Inhalte erstellen. |

Das Anpassen der Temperatur kann die Ausgabe des Modells beeinflussen, garantiert aber kein bestimmtes Ergebnis. Die Antworten der KI sind von Natur aus probabilistisch und können auch bei derselben Temperatureinstellung variieren.

Inhaltsmoderationsniveau

Der Schieberegler erlaubt es Ihnen, die Moderationsstufe für den Prompt auszuwählen, damit Ihr Prompt mehr Antworten liefern kann. Allerdings könnte die Zunahme der Antworten beeinflussen, ob schädliche Inhalte (Hass und Fairness, Sexual, Gewalt Self-Harm) im Prompt enthalten sind.

Anmerkung

Die Einstellung für Inhaltsmoderation ist nur für verwaltete Modelle verfügbar. Aus diesem Grund ist der Schieberegler deaktiviert, wenn man Anthropic oder Azure AI Foundry Modelle auswählt.

Die Moderationsstufen reichen von Niedrig bis Hoch. Die Standardmoderationsstufe für Prompts ist Moderat.

Eine geringere Moderation erhöht das Risiko schädlicher Inhalte in den Antworten deiner Prompts. Eine höhere Moderation senkt dieses Risiko, könnte aber die Anzahl der Antworten verringern.

| Inhaltsmoderationsniveau | Beschreibung des Dataflows | Vorgeschlagene Verwendung |

|---|---|---|

| Low | Könnte Hass und Fairness, sexuelle, Gewalt- oder Selbstverletzungsinhalte erlauben, die explizite und schwerwiegende schädliche Anweisungen, Handlungen, Schäden oder Missbrauch zeigen. Beinhaltet die Befürwortung, Verherrlichung oder Förderung schwerwiegender schädlicher Handlungen, extremer oder illegaler Formen von Schäden, Radikalisierung oder nicht einvernehmlicher Machtübertragung oder -missbrauch. | Verwendung für Prompts zur Verarbeitung von Daten, die als schädliche Inhalte angesehen werden könnten (zum Beispiel Beschreibungen von Gewalt oder medizinischen Eingriffen). |

| Mäßig | Könnte Hass und Fairness, sexuelle, Gewalt- oder Selbstverletzungsinhalte erlauben, die beleidigende, spöttische, einschüchternde oder erniedrigende Sprache gegenüber bestimmten Identitätsgruppen verwenden. Enthält Darstellungen von der Suche und Ausführung schädlicher Instruktionen, Fantasien, Verherrlichung, Förderung von Schaden mit mittlerer Intensität. | Standardfilterung. Für die meisten Anwendungen geeignet. |

| High | Könnte Hass und Fairness, sexuelle, Gewalt- oder Selbstverletzungsinhalte erlauben, die voreingenommene, wertende oder meinungsstarke Ansichten ausdrücken. Beinhaltet beleidigende Sprachgebrauch, Stereotypisierung, Anwendungsfälle zur Erkundung einer fiktiven Welt (zum Beispiel Gaming, Literatur) und Darstellungen mit niedriger Intensität. | Nutze es, wenn du eine stärkere Filterung brauchst, die restriktiver ist als auf der mittleren Stufe. |

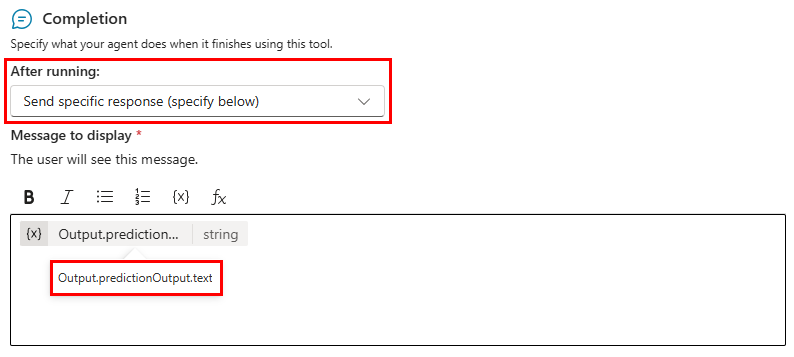

Um die Inhaltsmoderationseinstellung des Agenten beim Verwenden des Prompts in einem Agenten zu überschreiben, stellen Sie im Abschlussbildschirm des Prompt-Tools die Einstellung "Nach dem Ausführen" auf Senden einer spezifischen Antwort (unten angeben). Die anzuzeigende Nachricht sollte die benutzerdefinierte Variable Output.predictionOutput.text enthalten.